1、综述

- 数据挖掘领域大师俞士纶团队新作:最新图自监督学习综述

- 图自监督学习综述:Graph Self-Supervised Learning A Survey

- 图自监督学习(Graph Self-supervised Learning)最新综述+Github代码汇总

- 图自监督学习在腾讯Angel Graph中的实践

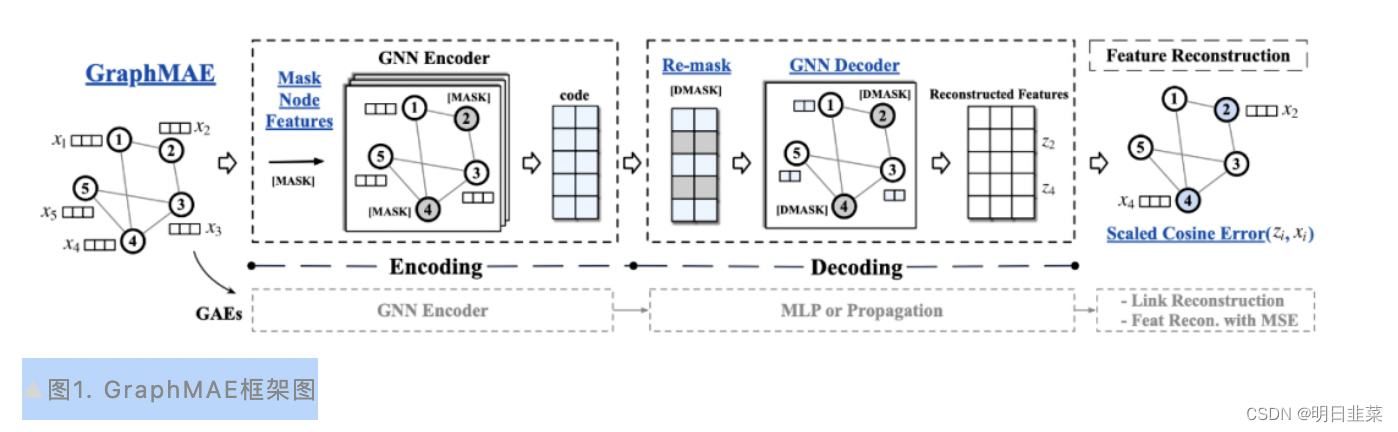

- [KDD’22] GraphMAE: 生成式图自监督学习超越对比学习

- 论文推荐:SIGIR’21 | 用于推荐的自监督图学习SGL

- WWW22 - 无监督图结构学习

前面两个综述是对论文Graph Self-Supervised Learning A Survey的翻译,该论文综述比较全面,重点讲解了生成式和对比式

全文链接:https://arxiv.org/pdf/2103.00111.pdf

2、对比学习基础

3、哪种图自监督效果好?

根据实际情况来决定实践的路径,一般来说实现复杂度如下:

生成式 -> 对比式

一般而言,对比式图自监督效果会比生成式好,但是在比赛和日常实践中,生成式效果也不错,且结构简单,所以建议冷启动时,从生成式入手,然后逐步增加复杂度到对比式;

可以参考的一篇生成式图自监督论文解读和代码如下:

文章介绍了图自监督学习的最新综述,特别提到了生成式和对比式方法。对比学习在内容风控和推荐系统中有应用,而GraphMAE作为生成式方法在KDD22上展示了优秀效果。建议初学者从生成式开始,逐渐过渡到对比式方法。

文章介绍了图自监督学习的最新综述,特别提到了生成式和对比式方法。对比学习在内容风控和推荐系统中有应用,而GraphMAE作为生成式方法在KDD22上展示了优秀效果。建议初学者从生成式开始,逐渐过渡到对比式方法。

1022

1022

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?