国产大模型实践

如何灵活调用国产大模型

在人工智能实践过程中,涉及到如何灵活调用国产大模型,因为网络连接原因,OpenAI在国内难以连接使用,那么在实践中我们通常会使用国产大模型比如Qwen或者智普大模型来代替。

科研云服务器选择(代码中需要用到GPU)

我通常使用AutoDL来运行大模型:

- 付费方式 ,按量计费,可以随时打开关闭服务,价格便宜;

- 可以使用MobaXterm等工具来连接;

- 支持JupyterLab等;

- 可灵活选择服务器配置,灵活选择Pytorch等版本。

ollama+qwen+langchain

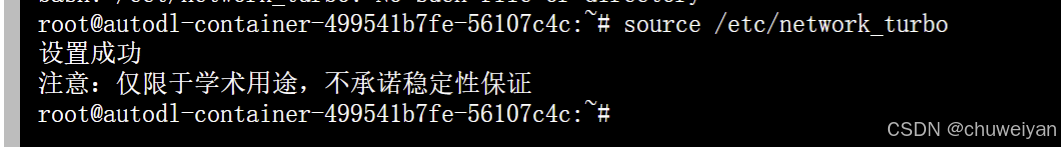

安装Qwen需要5分钟左右,可以使用学术资源加速提升下载速度

source /ect/network_turbo

下载Ollama

curl -fsSL https://ollama.com/install.sh | sh

订阅专栏 解锁全文

订阅专栏 解锁全文

1797

1797

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?