项目场景:

国内深度学习配置环境篇

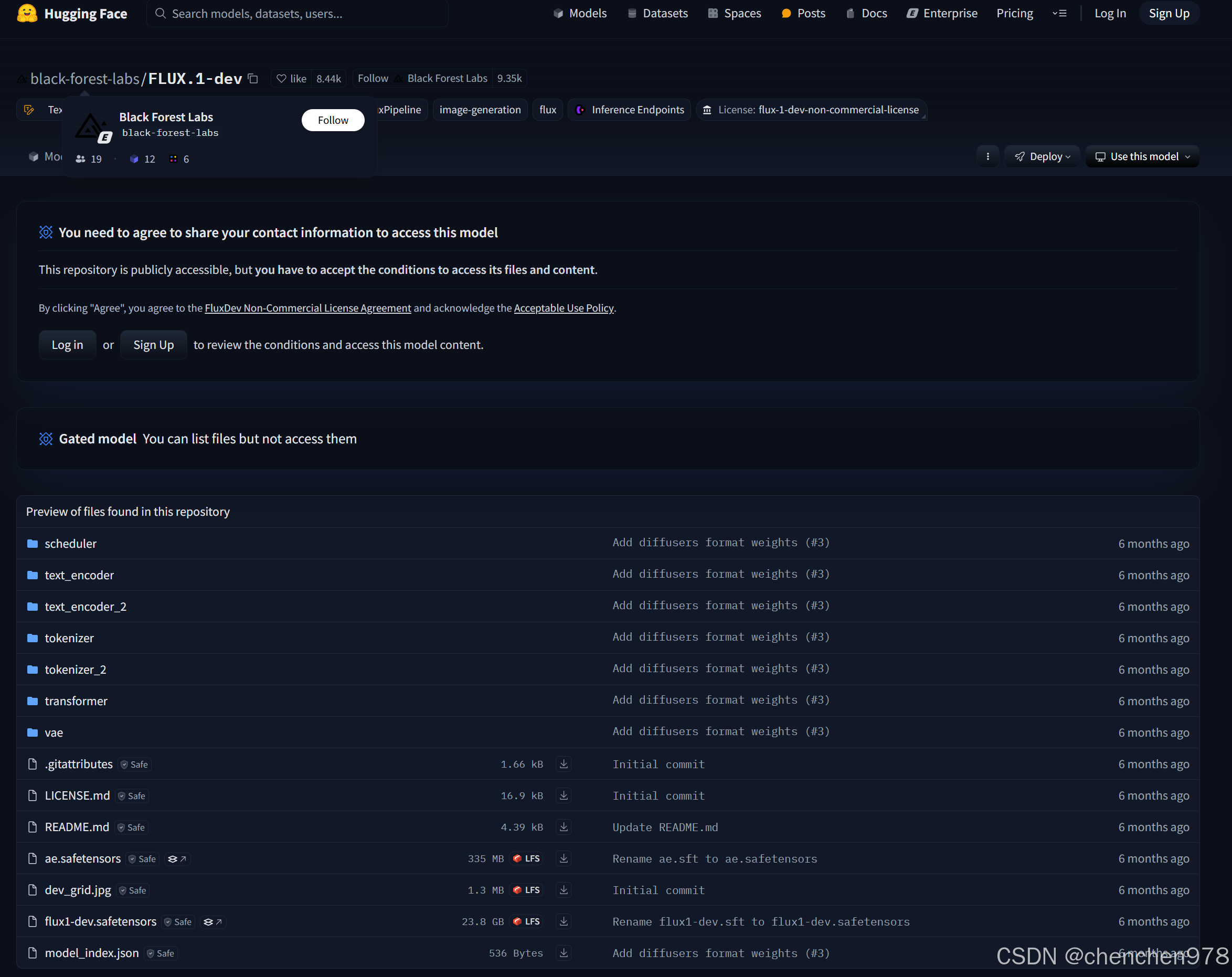

一、hugging face上数据和模型的下载问题

1.手动下载并调用

1.1 模型下载

手动到hugging face网站或者hugging face的镜像网站或者魔塔网站上手动把相关的文件下载下来

官网:https://huggingface.co/

镜像网站:https://hf-mirror.com/

魔塔:https://www.modelscope.cn/

一般来说只要下载.bin或者.safetensors的模型文件,config.json和vocab.json文件,但是不放心就全部下载好了。魔塔有工具可以利用命令行等多种方式全部下载,或者自行手写代码全部下载下来。

1.2 模型调用

在默认情况下,from_pretrained(path)会自动从线上的开源项目里下载文件,下载下来的文件会存放在C:\Users\<用户名>\.cache\huggingface\hub

只要把调用模型的from_pretrained方法内的path改为前面下载模型的路径即可。

参考资料:

https://blog.youkuaiyun.com/ccSnown/article/details/137644853

1.3 数据集下载

同上

1.4 数据集调用

找准路径即可,应该大同小异

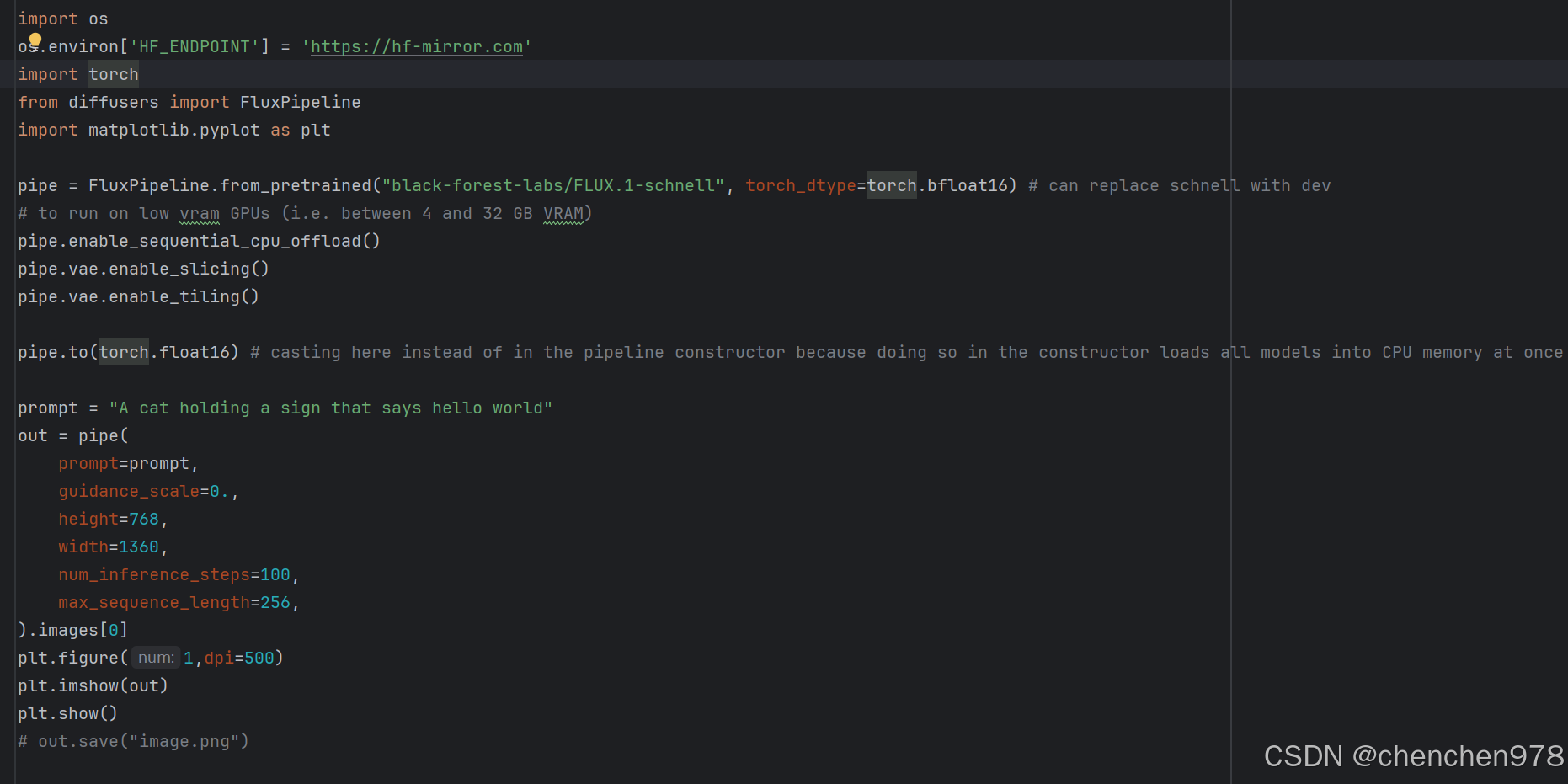

2. hugging face mirror的非侵入式配置

最简单的方法是在运行程序里修改hugging face的路径为镜像路径,

注意,下面代码要加在导入各种hugging face相关库前,否则不起作用。

import os

os.environ['HF_ENDPOINT'] = 'https://hf-mirror.com'

比如

此外有些攻略的命令行或者设置是Linux系统的,注意甄别。这个方法下载时也可能出现中断的问题,重复多次即可。

参考资料

https://blog.youkuaiyun.com/weixin_40959890/article/details/140319652?spm=1001.2014.3001.5506

二、环境配置

经常遇到各种库的版本不匹配问题,但是又不知道去哪里看版本匹配关系,网上找的资料又比较零碎,找一次忘一次,贼浪费时间。对于这个问题,大家有什么好办法吗?

1. 坑爹的xformers版本问题

xformers下载会重新安装对应版本的torch,进而引发torch和cuda不对的问题,需要查找好xformers的版本进行安装,怎么看不知道。

参考下面这个链接,大概就是目前xformers只支持11.8, 12.1, 12.4三个版本的cuda,所以安装时要小心了。

https://github.com/facebookresearch/xformers/issues/1079

2. Triton库在windows不支持,要么直接不管,要么安装别人编译好的文件

https://github.com/Fanghua-Yu/SUPIR/issues/69

https://github.com/Fanghua-Yu/SUPIR/issues/11

3. 更换镜像源

3.1 临时使用

在pip安装命令后直接加上-i参数后再接镜像源的地址

pip install package_name -i https://pypi.tuna.tsinghua.edu.cn/simple

如果是通过requirements.txt这样的方式一起安装全部库

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

其实这样安装会有问题,有些包在镜像源内找不到就会安装失败,还是使用多个源自动检索的方式安装吧

另外,torch的安装是多个文件放一块安装的,参考下面方式,注意镜像地址要指定到cuda版本

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 -f https://mirrors.aliyun.com/pytorch-wheels/cu118

另外要安装最新的版本可以使用下面的命令,不过要注意镜像源是否存在最新的镜像

参考:(https://blog.laiqwq.com/archives/567)

pip3 install torch torchvision torchaudio --index-url https://mirror.nju.edu.cn/pytorch/whl/cu126

还可以手动下载whl文件进行安装,只需要把一般的安装改成下载下来的whl文件地址即可:pip install <file_path>

https://blog.youkuaiyun.com/YY007H/article/details/141962724

一个小插曲:使用清华源安装xformers遇到网络问题,奇怪,明明可以在清华源网站上搜到对应的文件。更换阿里云镜像就好了,清华源不太行,以后优先阿里云的源吧。

接着小插曲:在requirements.txt里使用阿里云源时安装torch时,会只安装cpu版的torch,因为没有显性指示安装cuda版。因此,先按照前面的方式单独装好cuda版的torch在一起装。

ERROR: HTTP error 403 while getting https://pypi.tuna.tsinghua.edu.cn/packages/92/f2/b04f4fb3da97bf16ba8cb06a8a40961aad29317353f5563efb17f0472f82/xformers-0.0.23-cp310-cp310-win_amd64.whl (from https://pypi.tuna.tsinghua.edu.cn/simple/xformers/) (requires-python:>=3.7)

ERROR: Could not install requirement xformers==0.0.23 from https://pypi.tuna.tsinghua.edu.cn/packages/92/f2/b04f4fb3da97bf16ba8cb06a8a40961aad29317353f5563efb17f0472f82/xformers-0.0.23-cp310-cp310-win_amd64.whl because of HTTP error 403 Client Error: Forbidden for url: https://pypi.tuna.tsinghua.edu.cn/packages/92/f2/b04f4fb3da97bf16ba8cb06a8a40961aad29317353f5563efb17f0472f82/xformers-0.0.23-cp310-cp310-win_amd64.whl for URL https://pypi.tuna.tsinghua.edu.cn/packages/92/f2/b04f4fb3da97bf16ba8cb06a8a40961aad29317353f5563efb17f0472f82/xformers-0.0.23-cp310-cp310-win_amd64.whl (from https://pypi.tuna.tsinghua.edu.cn/simple/xformers/) (requires-python:>=3.7)

国内的镜像源地址

https://mirrors.aliyun.com/pypi/simple/

https://pypi.tuna.tsinghua.edu.cn/simple

https://pypi.mirrors.ustc.edu.cn/simple/

https://pypi.doubanio.com/simple/

3.2 永久使用

在C:\Users\用户名\AppData\Roaming\pip目录下新建配置文件pip.ini

内容如下:

[global]

timeout = 6000

index-url = https://pypi.tuna.tsinghua.edu.cn/simple/

extra-index-url =

https://mirrors.aliyun.com/pypi/simple/

https://pypi.org/simple

[install]

trusted-host =

pypi.tuna.tsinghua.edu.cn

mirrors.aliyun.com

pypi.org

然后执行pip命令,会自动依次查找每个源,如果在某个源中找到了需要安装的包,就会下载并安装。如果在所有源中都找不到包,就会提示找不到匹配的包。看上去应该是可行的方案,进行了尝试,但是直接卡住了,原因未明,战术放弃。有时候在国内装个深度学习环境还挺费劲的(泪汪汪,又慢又容易出问题,一装一天就过去了)。

https://blog.youkuaiyun.com/weixin_43941438/article/details/130347798

679

679

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?