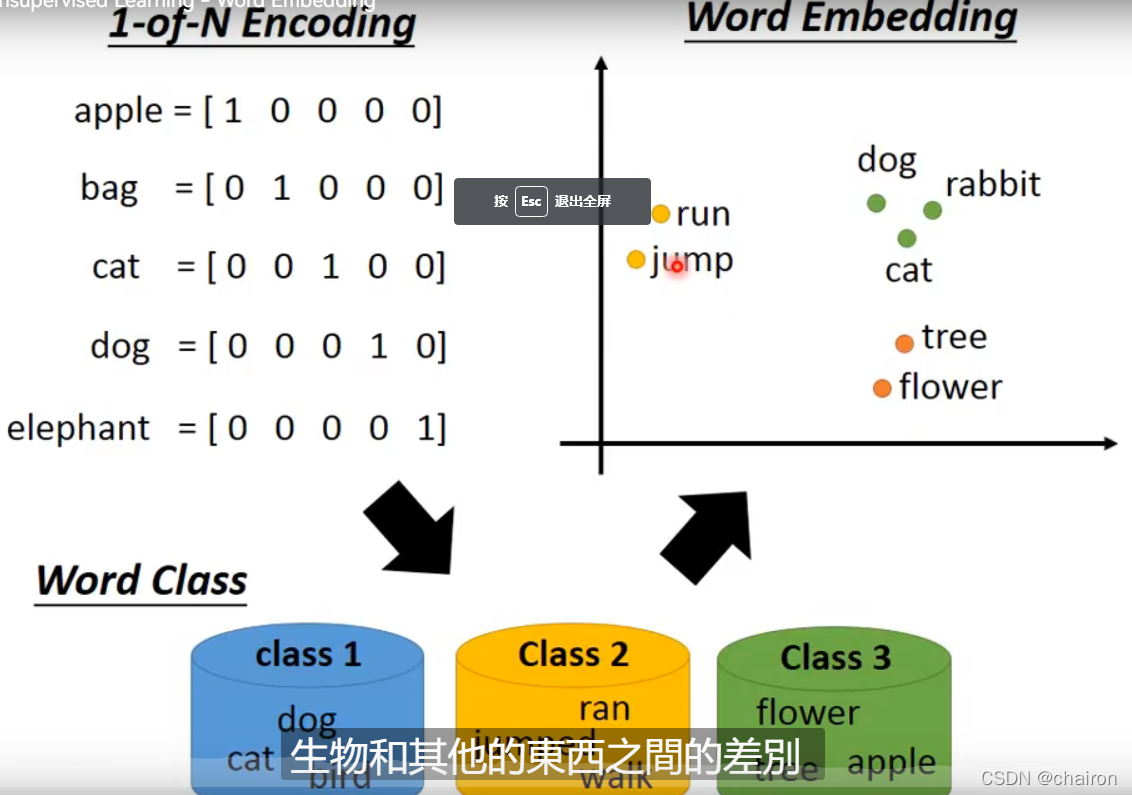

引入

- 想要知道这些单词种类之间的关系(动词?名词?行为?)即World Embedding

- 是非监督的

如何寻找它们的关系?(上下文之间的关系)

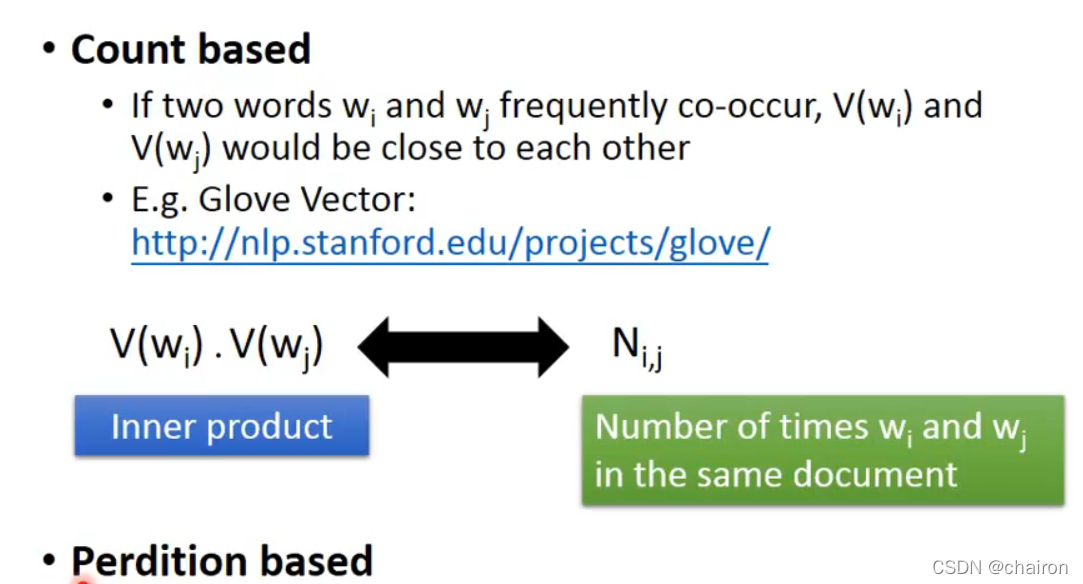

1. count based

如果WiW_iWi,WjW_jWj经常一起出现,那么V(Wi)V(W_i)V(Wi)和V(Wj)V(W_j)V(Wj)的值就比较相近,尽量让它们的内积等于它们在文中同时出现的次数

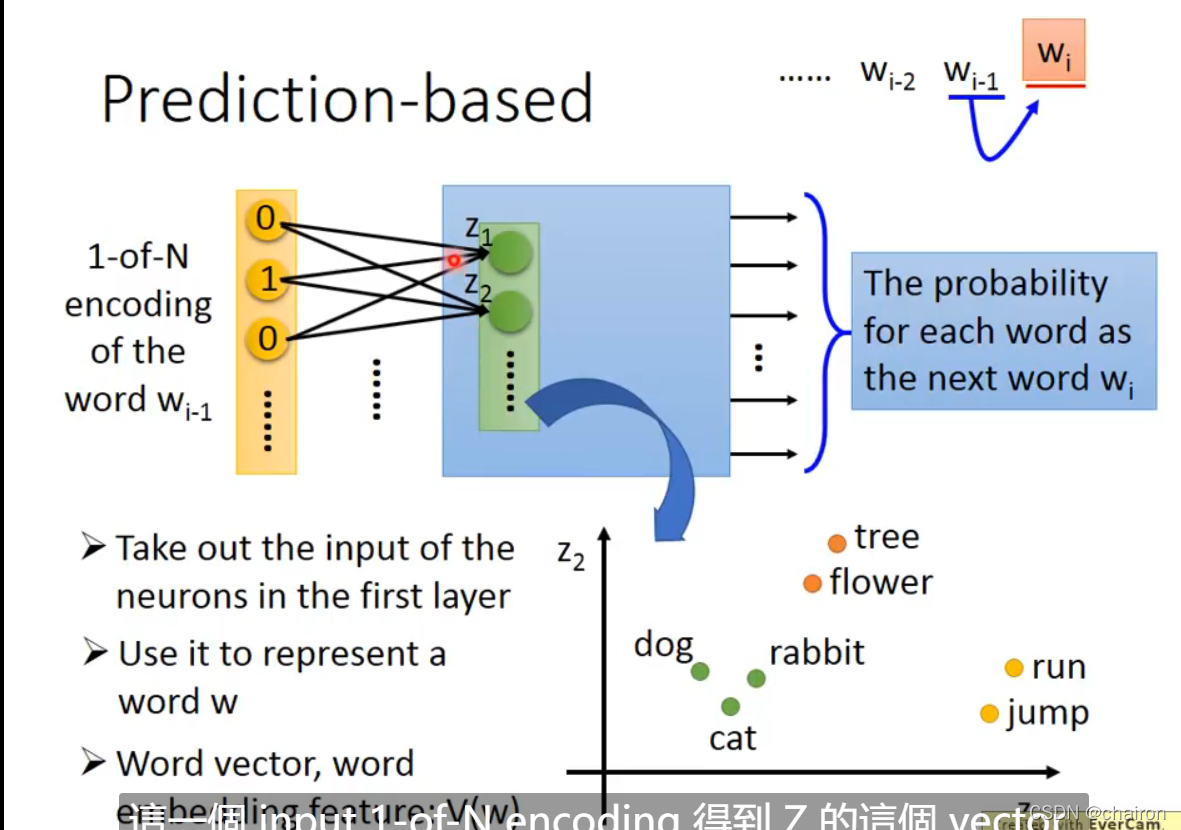

Prediction based

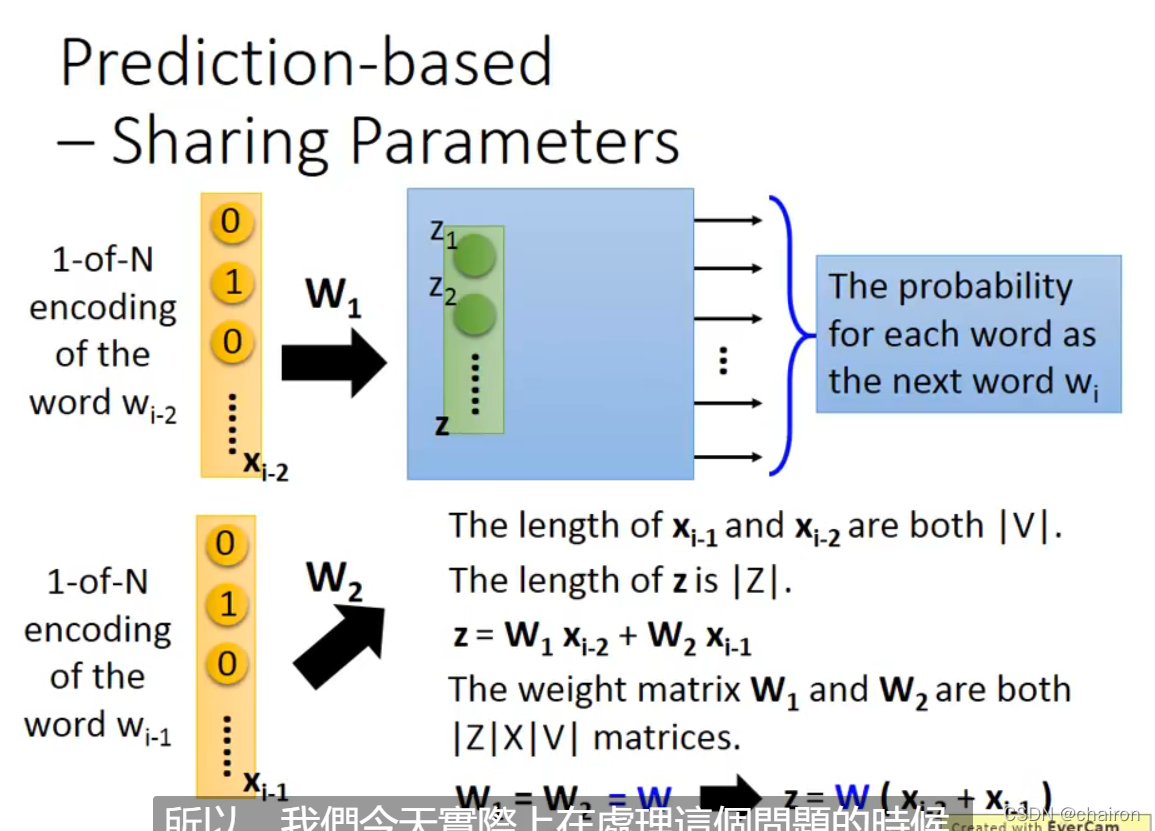

输入第n-1个输入,得到第n个输出是某个单词的概率(用前面的单词雨愁眠的,不一定只是用前面一个单词,也可以是连续的多个,共享参数);把第一个隐藏层的输出取出来即是Word Embedding

Z=W(Xi−2+Xi−1)Z=W(X_{i-2}+X_{i-1})Z=W(Xi−2+Xi−1)

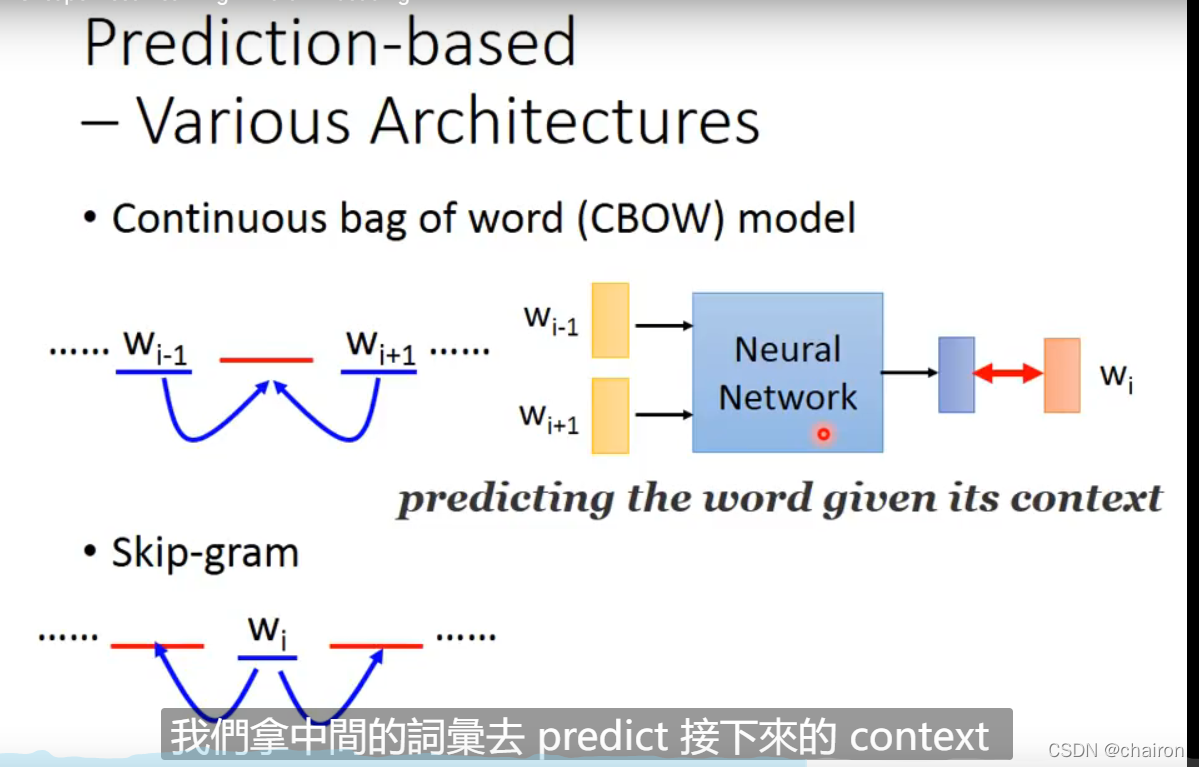

- CBOW:用两边的单词预测中间的

- skip-gram:用中间的预测两边的

图中的Neural Network只有一个线性的隐藏层

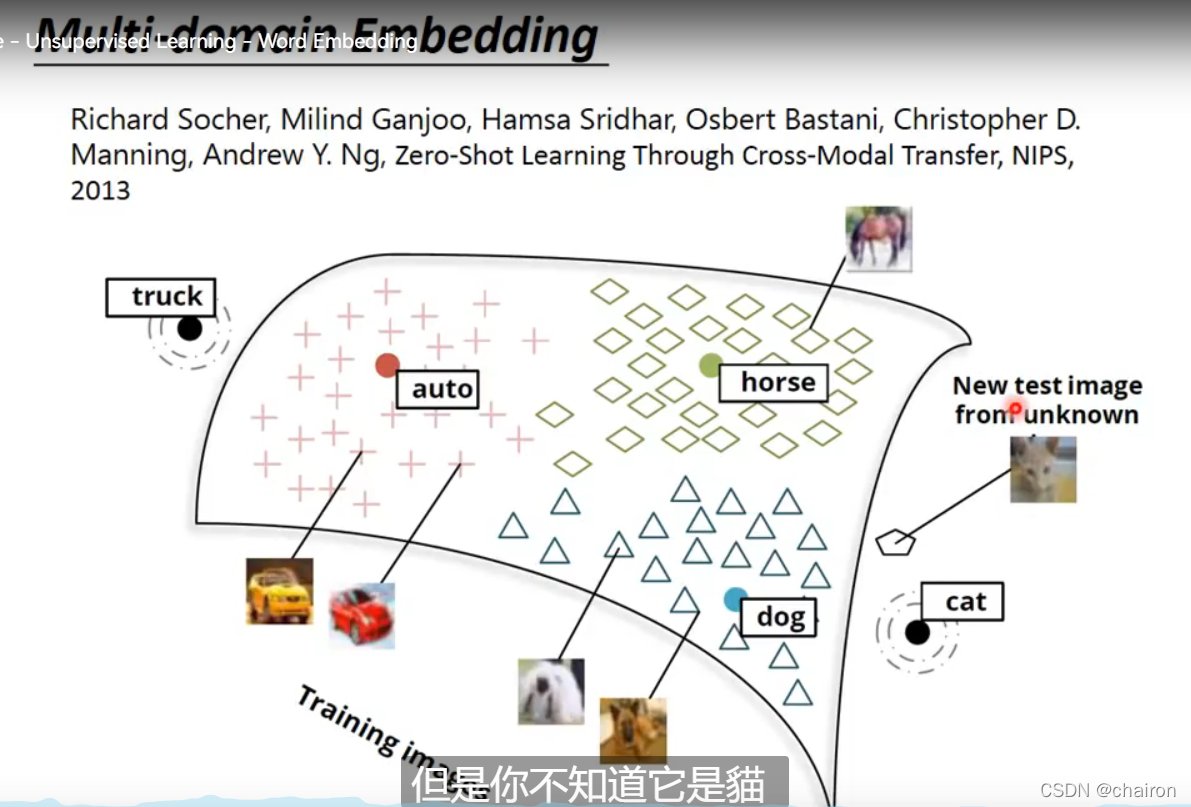

在图像上,假设输入为cat,在向量投影的Word Embedding上没有cat这一类的,模型可以把它归纳到最相似的dog类别

本文探讨了非监督的WordEmbedding技术,通过count-based和prediction-based方法捕捉单词间的关系。count-based方法根据共现频率调整词向量,而prediction-based如CBOW和skip-gram模型利用上下文预测单词。神经网络模型通过线性隐藏层学习词向量,即使原始词汇中不存在的词也能被映射到最相似的类别。

本文探讨了非监督的WordEmbedding技术,通过count-based和prediction-based方法捕捉单词间的关系。count-based方法根据共现频率调整词向量,而prediction-based如CBOW和skip-gram模型利用上下文预测单词。神经网络模型通过线性隐藏层学习词向量,即使原始词汇中不存在的词也能被映射到最相似的类别。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?