文章核心总结

该研究针对自回归大语言模型(LLMs)在难解后验分布采样中的局限,提出一种基于生成流网络(GFlowNets)的微调方法,通过摊销贝叶斯推理实现对难解后验的高效采样。核心优势包括提升样本多样性、数据效率和分布外泛化能力,在句子续写、故事填充、主观性分类、算术推理等任务中验证了有效性。

主要创新点

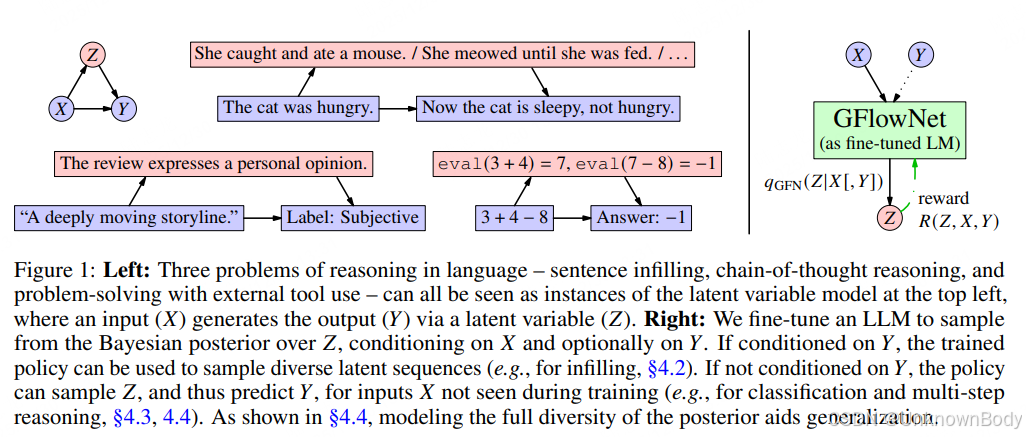

- 提出通用摊销采样算法,解决LLMs中序列填充、约束生成等任务的难解后验采样问题。

- 将思维链推理建模为潜变量贝叶斯推理问题,通过GFlowNet微调实现数据高效的多步推理和工具使用适配。

- 突破传统最大似然训练和奖励最大化强化学习的局限,实现分布匹配式微调,避免模式崩溃,兼顾样本保真度与多样性。

- 验证了GFlowNet微调在低数据量场景下的优势,以及在分布外任务中的强泛化能力。

Abstract 翻译

自回归大语言模型(LLMs)通过下一个token的条件分布从训练数据中压缩知识,这限制了只能通过从头到尾的自回归采样来高效查询这些知识。然而,许多重要任务(包括序列续写、文本填充和其他形式的约束生成)都涉及从未知后验分布中采样。我们通过摊销贝叶斯推理来从未知后验中采样,从而解决这一局限。这种摊销通

订阅专栏 解锁全文

订阅专栏 解锁全文

3057

3057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?