文章核心总结与翻译

一、主要内容

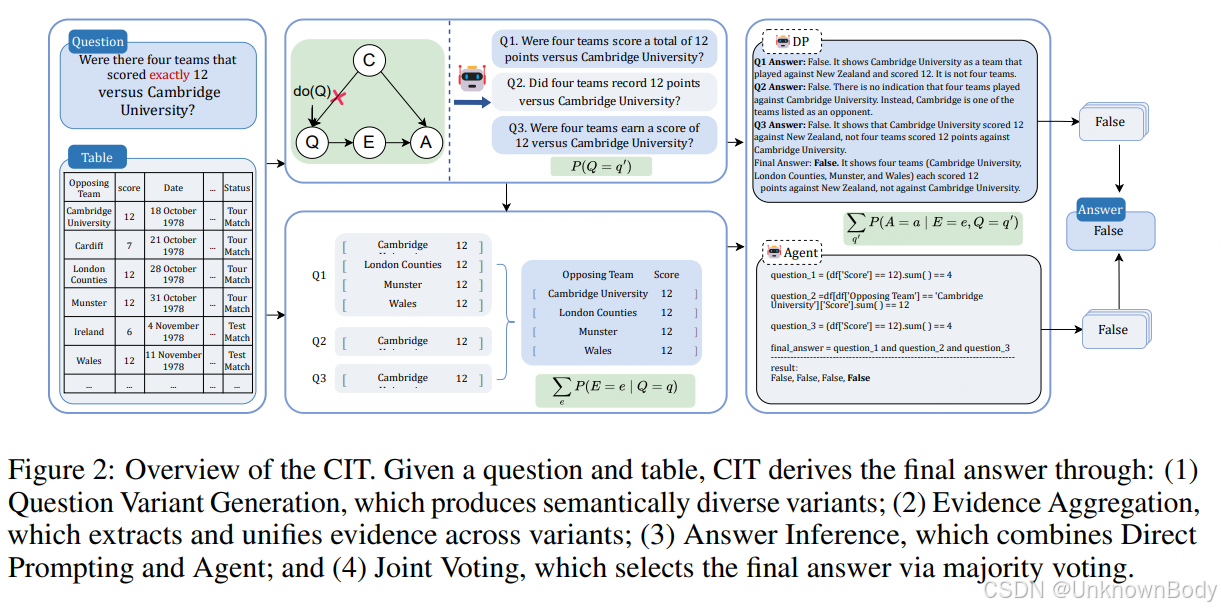

该研究聚焦于表格问答(TableQA)任务中大型语言模型(LLMs)依赖训练语料中token共现模式导致的虚假关联和推理不可靠问题,提出了基于因果干预的框架CIT(Causal Intervention TableQA)。

- 问题背景:现有LLM-based TableQA方法(直接提示DP、智能体Agent范式)虽表现优异,但易受预训练数据中token共现偏差影响(如"exactly"常与"yes"共现导致误判),形成虚假因果路径,缺乏真实推理能力。

- 核心思路:将TableQA建模为结构化因果图,识别token共现模式为潜在混杂因子,采用前门调整(front-door adjustment)消除偏差,无需直接访问混杂因子或模型内部结构。

- 框架构成:

- 问题变体生成:生成语义一致、表面形式不同的问题变体,减少词汇偏差;

- 证据聚合:汇总各变体的相关证据,提升覆盖完整性;

- 答案推理:结合DP(自然语言逐步推理)和Agent(符号化代码执行)两种范式;

- 联合投票:通过多数投票整合两类推理结果,确定最终答案。

订阅专栏 解锁全文

订阅专栏 解锁全文

3937

3937

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?