转载自 https://zhuanlan.zhihu.com/p/352348349

新视角:用图像分类来建模文字识别也可以SOTA

深度学习(Deep Learning)话题下的优秀答主

我们最近做了一个文字识别的工作:CSTR: A Classification Perspective on Scene Text Recognition,简单介绍如下。

当前文字识别有两种建模视角:seq2seq-based和segmentation-based。

seq2seq-based的方法首先将图片encode为特征序列(比如CNN、RNN、Transformer encoder或者它们的组合),然后对特征序列进行decode(比如CTC、RNN、attention based RNN、Transformer decoder等)。

segmentation-based的方法首先定位出字符的位置,然后识别出各个位置的字符,最后将字符组合成字符串。

过去达到SOTA的文字识别方法大部分是seq2seq-based,但是seq2seq-based的方法pipeline复杂(大部分还需要STN模块来对图像进行矫正)。

segmentation-based的方法简洁很多,但是需要字符级别的标注,字符级别的标注成本高昂,在实际生产环境中不太可能使用这样精细的标注方式。

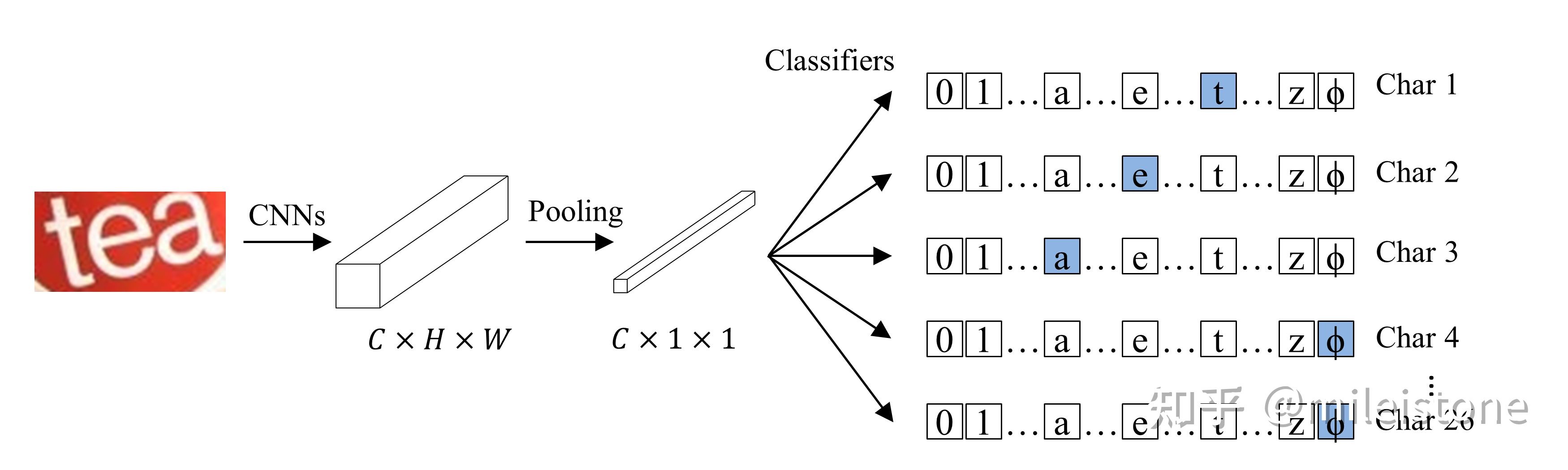

我们提出了一种图像分类的建模视角:classification-based。即将文字识别任务建模为图像分类,整体pipeline比segmentation-based的方法更简单,而且不需要字符级别的标注。classification-based的模型像其他图像分类模型一样容易实现,因为是纯卷积所以训练、推理非常高效。

CSTR模型结构,ϕ为end token

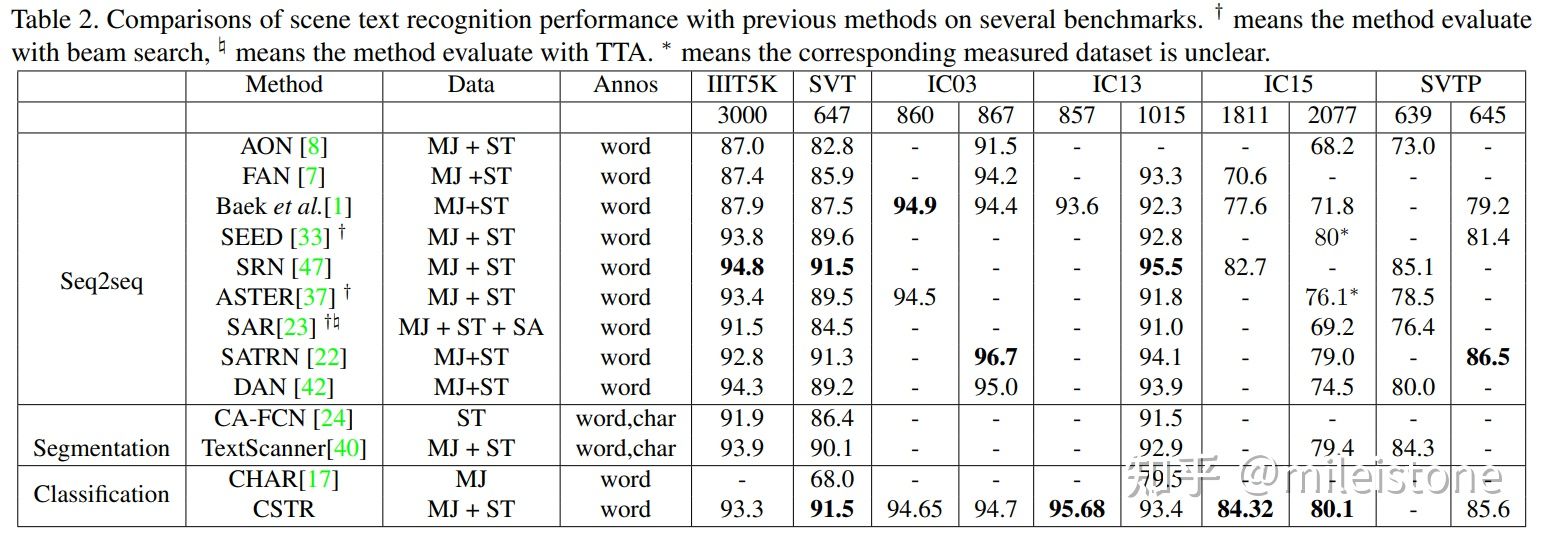

我们的classification-based模型即CSTR,在六个常用的公开数据集上的效果如下表所示。我们的模型没有STN模块,仅仅只有一个图像分类器,训练数据集为常用的两个合成的数据集SynthText (ST)和MJSynth (MJ),仅使用单词级别的标注,测试的时候没用任何TTA,整体效果基本达到SOTA。

CSTR与业界经典模型指标比较

代码将在我们的文字识别工具箱vedastr中开源。

CSTR: A Classification Perspective on Scene Text Recognition

github 代码 : https://github.com/Media-Smart/vedastr

本文介绍了一种新的文字识别方法CSTR,它采用分类视角,无需字符级标注,简化了流程并接近SOTA性能。模型基于CNN和Transformer,仅依赖于单词级标注,展示了在多个公开数据集上的优秀表现。源代码已开源在vedastr工具箱中。

本文介绍了一种新的文字识别方法CSTR,它采用分类视角,无需字符级标注,简化了流程并接近SOTA性能。模型基于CNN和Transformer,仅依赖于单词级标注,展示了在多个公开数据集上的优秀表现。源代码已开源在vedastr工具箱中。

205

205

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?