pythonic-使用Counter进行计数统计

注:本文参考书籍为:《编写高质量代码-改善python程序的91个建议》一书

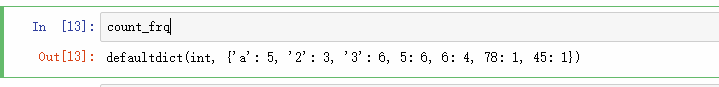

方式一,使用defaultdict方式

### python

from collections import defaultdict

data = ['a','2','3',5,6,78,45,'a','3',5,6,'a','2','3',5,6,'3',5,'a','2','3',5,'a','3',5,6,]

## 创建一个defaultdict

count_frq = defaultdict(int)

for item in data:

count_frq[item] +=1

print(count_frq)

Out:

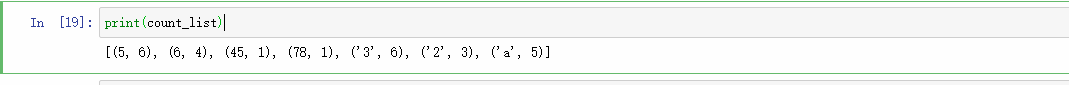

方式二,使用set和list相结合的方式

## pyhton

count_set = set(data)

count_list = []

for item in count_set:

count_list.append((item, data.count(item)))

print(count_list)

Out

本文介绍了Python中使用Counter进行计数统计的三种方式,包括defaultdict、set和list结合以及直接使用Counter。Counter是字典的子类,方便统计离散对象的频率,提供获取前N个高频元素、加减操作等功能。

本文介绍了Python中使用Counter进行计数统计的三种方式,包括defaultdict、set和list结合以及直接使用Counter。Counter是字典的子类,方便统计离散对象的频率,提供获取前N个高频元素、加减操作等功能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

530

530

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?