背景

我们的日常使用大模型,就像是在不同模型间打补丁:“这个模型会看图,但不会讲故事;那个模型能生成视频,但不懂视频在表达什么。” 于是乎,大致像这样,想用图像模型,就得跑去找midjourney;想做视频模型,又得等 Sora;想让模型理解视频剧情,还得靠那些半懂不懂的“视觉语言拼接模型”;想让模型读情绪,甚至还得给它加一堆“情绪标签的模板提示词”。

而就在昨天,我看完百度文心 5.0 的发布会,突然有种久违的感觉:——国产大模型的世界观,好像真的变了。

**文心 5.0 :“都别吵,你们其实是同一种 token” **

发展

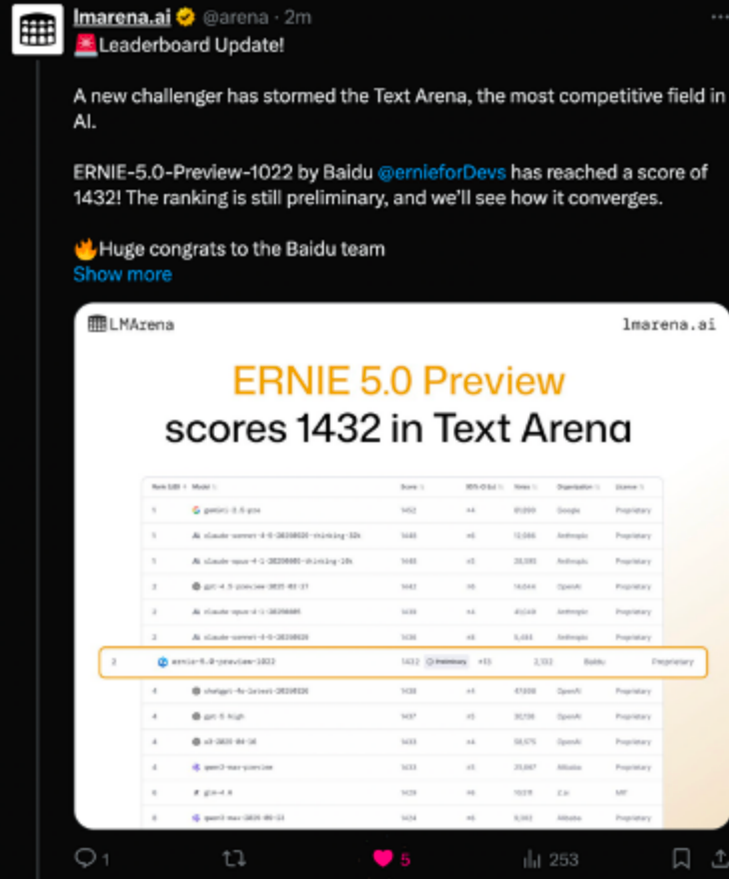

我饶有兴致的去搜了下文心5.0的相关“实力”,原来在 11 月 8 日的 LMArena 更新中,全新的 ERNIE-5.0-Preview-1022 排在文本榜全球并列第二的位置,在国内模型中排名第一,在创意写作、复杂长问题理解、指令遵循等维度都有较明显的优势,整体分数超过了多款国内外的主流模型。

媒体也做了不少实测。11 月 12 日,百度开源了多模态思考模型 ERNIE-4.5-VL-28B-A3B-Thinking,这个模型在 HuggingFace 多模态趋势榜上线 24 小时就升至全球第一。公开基准显示,在多模态理解和复杂推理任务上,其性能在仅 3B 激活参数的情况下已经接近 GPT-5-High 和 Gemini-2.5-Pro。这个模型引入了“图像思考”(Thinking with Images)的方法,使模型能够在图像层面构建更具结构性的推理链路,同时提升场景定位、细节捕捉与指令遵循的稳定性。因此在许多需要多模态统一理解的

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1669

1669

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?