——当生成的自由度被逼到极限,序列世界的两种命运也越分越清

1. 那个“让人意外的推理瓶颈”,把我重新带回到自回归 vs. 离散自回归的世界

我第一次重新认真思考这个问题,是在优化一个文本生成引擎的时候。模型本身够大、数据够好、GPU 够快,可推理速度却死活上不去。我们不断减少上下文长度、改 beam search、改 KV cache 策略,效果都不大,最后问题竟然出在一个我们早已习以为常的细节上:模型在逐 token 输出时“死死地等上一拍”,仿佛一个天才写作者,却必须一秒一秒地按节奏吐字。

自回归模型天然如此——一步生成一步、每步依赖前一步,像呼吸一样顺序展开,看似自然,但对硬件、对序列长度都极不友好。就在我们被困在这个瓶颈时,我重新翻出了之前研究过的 离散自回归模型(Discrete Autoregressive Models)。它们没那么火,但它们反复出现在那些对延迟敏感、对结构稳定性更高的系统中,比如语音编码、视频压缩、token 重参数化模型,甚至新一代多模态模型里的“中间离散瓶颈”。

于是我开始意识到:

自回归模型和离散自回归模型的差别,可能正在被大模型时代重新放大。

2. 自回归模型:像写文章一样生成、像呼吸一样顺序,这是它的力量,也是它的局限

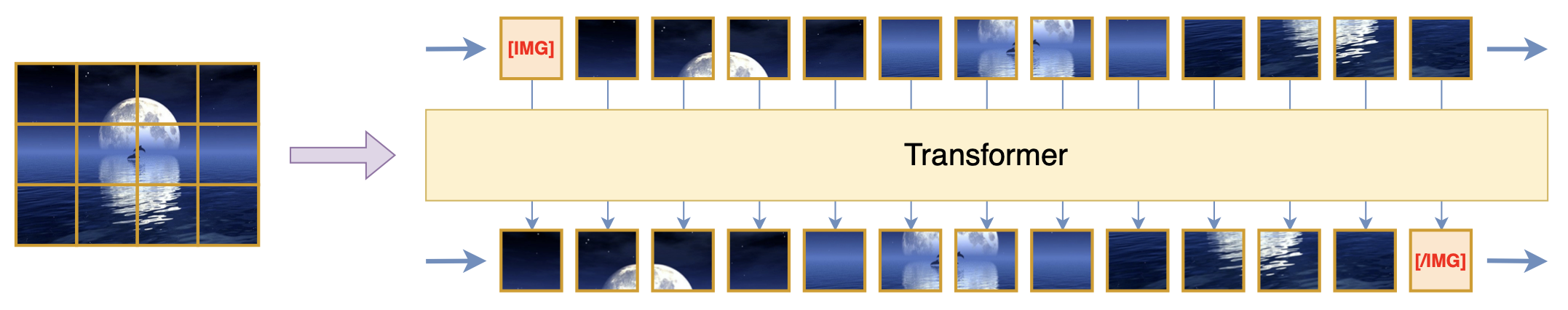

传统的自回归模型(Autoregressive Models)是一种几乎所有 NLP 模型都绕不开的结构。从 GPT 到 LLaMA,再到任何 Transformer 语言模型,它们都是一步步生成:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?