就在今天,一则看似简单的新闻在全球AI行业掀起波澜:

Anthropic 宣布将使用多达 100 万个谷歌 TPU 训练下一代 Claude 模型。

这是AI史上前所未有的算力计划。

100万个TPU,不仅意味着一场计算规模的跨越,也标志着生成式AI的竞争,正在从“算法比拼”进入“算力争霸”的阶段。

这篇文章,我们来拆解三个问题:

-

Anthropic 为什么要用 100万个 TPU?

-

这对谷歌意味着什么?

-

AI 的算力战争,正在往何处去?

一、100万个TPU意味着什么?

1️⃣ 一个天文数字的算力集群

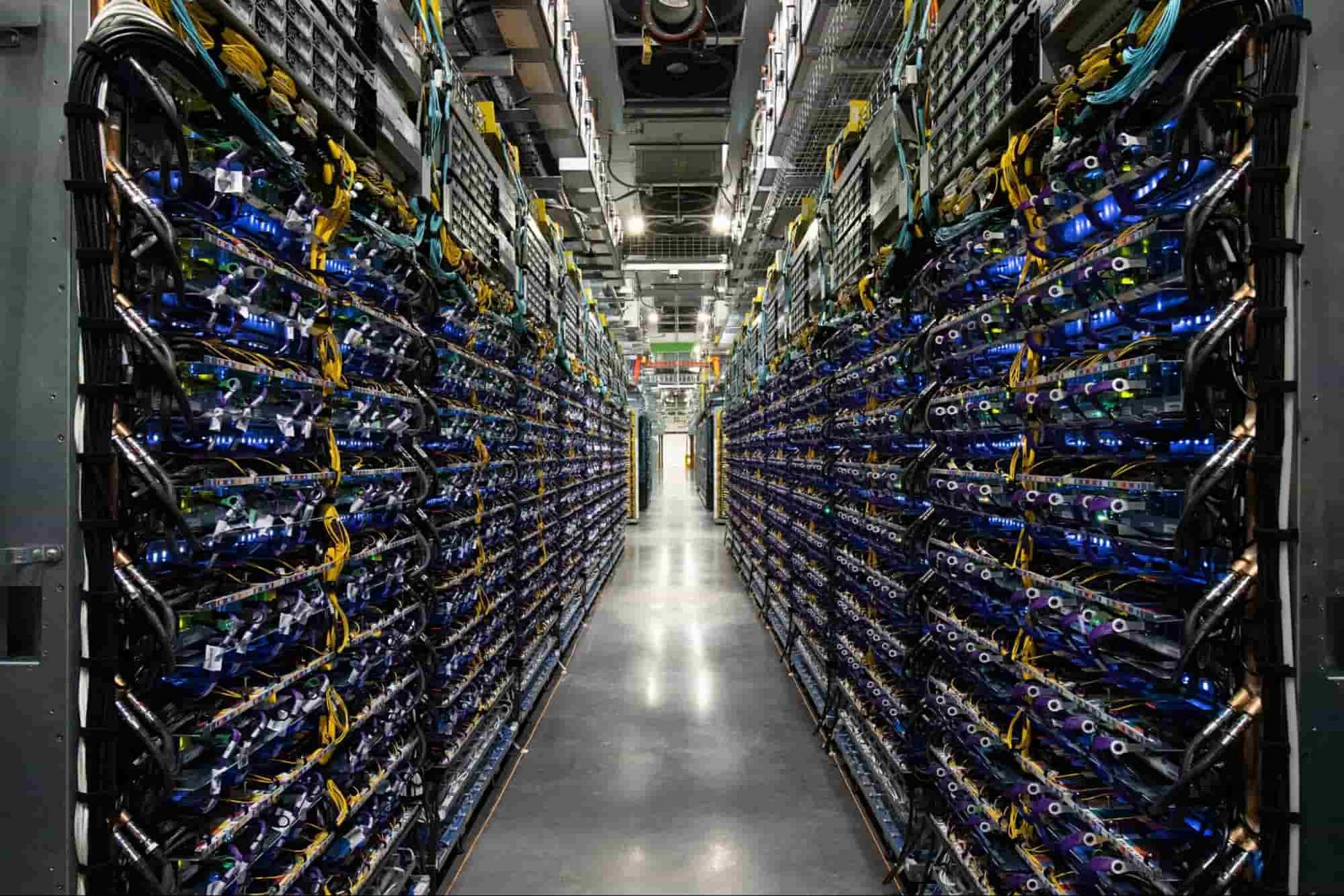

根据 Anthropic 公布的数据,这批 TPU 来自谷歌最新的 TPU v5p 集群,单个 TPU 拥有约 275 TFLOPS 的算力。

换句话说,100万个 TPU 的理论峰值可达:

2.75×10¹⁷ FLOPS —— 即 275 ExaFLOPS!

这是什么概念?

-

比美国橡树岭实验室的超算 Frontier(目前全球第一)还要快 10 倍以上;

-

足以在数周内训练一个超过10万亿参数的语言模型;

-

也是目前任何AI公司都未曾达到的训练规模。

这标志着 Anthropic 正在试图打造一条“Claude 超级算力生产线”,在训练速度、模型规模、推理能力上全面拉升。

2️⃣ 从 GPU 到 TPU 的关键转折

此前,几乎所有大模型厂商(OpenAI、Meta、xAI、Mistral)都使用 NVIDIA GPU 集群进行训练。

而这一次,Anthropic 选择了谷歌的 TPU —— 这不仅是技术选择,更是战略信号:

-

算力多元化:摆脱对 NVIDIA 的供应链依赖。

-

成本优化:TPU 相比同级 GPU 成本更低、能耗更小。

-

系统协同:Anthropic 已经深度部署在 Google Cloud 平台上,与 TPU 生态天然兼容。

一句话:

这不是一次“硬件替换

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1058

1058

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?