在过去五年里,全球 AI 热潮的最大赢家无疑是 NVIDIA。它的 GPU 几乎成为大模型训练的“黄金标准”,从 ChatGPT 到 Gemini,再到国内的通义、文心、深度求索,几乎都离不开 NVIDIA 的 H100、A100、GH200。

然而,当下的趋势正在悄然变化。AI 训练的体量越大,算力的形式就越多样化。Google 的 TPU、亚马逊的 Trainium、华为的昇腾、阿里的含光……新的芯片正在重新划分“算力的版图”。

这篇文章,我们就来深入拆解三个问题:

-

除了 NVIDIA 的 GPU,还有哪些算力芯片选项?

-

大模型厂商如果从 GPU 转向 TPU,这会影响 NVIDIA 的股价吗?

-

谁在下一场算力战争中潜伏,谁又可能被取代?

一、GPU 之外的算力江湖:AI 世界的“百芯大战”

我们常说“GPU 是 AI 的发动机”,但现在的 AI 产业早已不止一种引擎。

事实上,算力芯片已经分化成三大流派:

① 通用计算类(CPU / GPU),② 专用加速类(TPU / NPU / ASIC),③ 可编程与混合架构类(FPGA / DPU / IPU)。

1️⃣ 专用 AI 加速器(ASIC / 定制芯片)

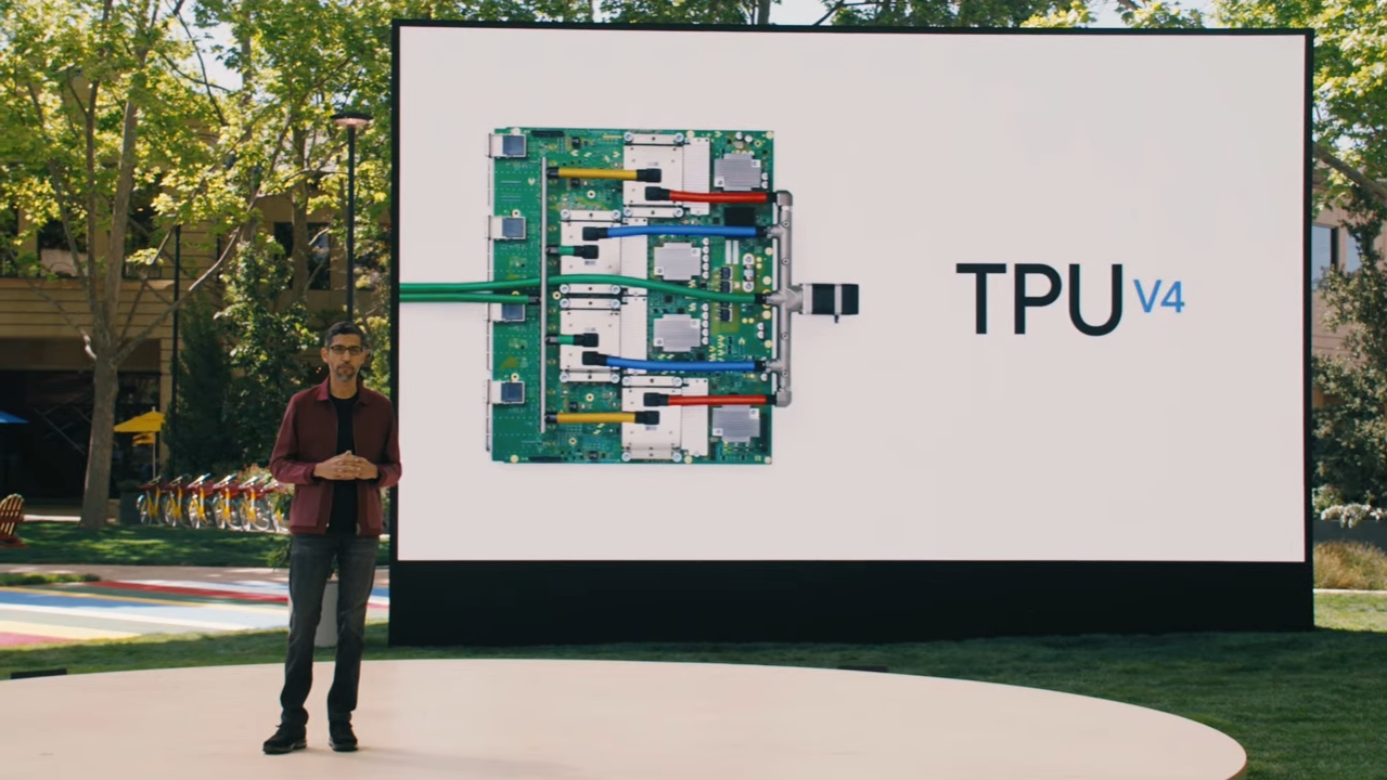

AI 的核心计算是 矩阵乘法与累加,传统 GPU 虽然强大,但通用架构导致效率并非极致。于是,Google 率先推出了 TPU(Tensor Processing Unit) —— 一种完全针对神经网络的定制芯片。

-

TPU 的思路: 用硬件直接映射神经网络中的张量运算,不浪费任何逻辑判断时间。

-

结果: 在同等功耗下,TPU 在 AI 推理任务上能比 GPU 提高数倍性能。

-

市场引用: 据 Trefis 与 Omdia 报告,TPU 已被广泛部署在 Google Cloud、Gemini、PaLM、YouTube 推荐系统等核心业务中,成为全球最成熟的非 GPU 加速器体系之一。

AI算力新格局:芯片多元化发展

AI算力新格局:芯片多元化发展

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4325

4325

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?