Xgboost集成算法与Adaboost算法概述

文章目录

(Ⅰ)Xgboost的基本原理:

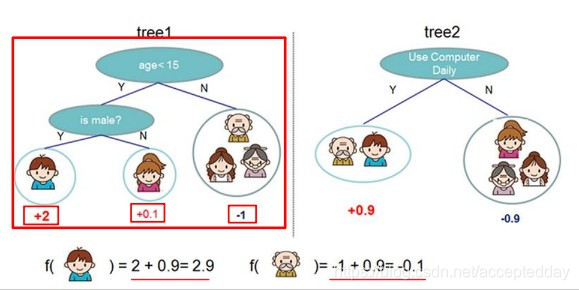

如图:

基本原理:

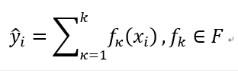

采用集成思想,对目标进行不同基准的容器划分进行权值的相加计算,综合评估。

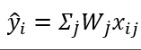

项的权值公式:

i为样本编号,j为叶子编号。

i为样本编号,j为叶子编号。

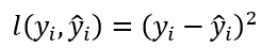

目标函数:

(yi)表示预测值,

(yi)表示预测值, 表示实际值。

表示实际值。

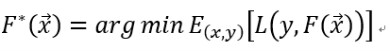

最优解函数:

即:对一棵树的所有项的目标函数值相加求期望,并使得期望函数最小。

采用集成的思想: k为决策树编号。

k为决策树编号。

即:对所有树的 进行累加。

进行累加。

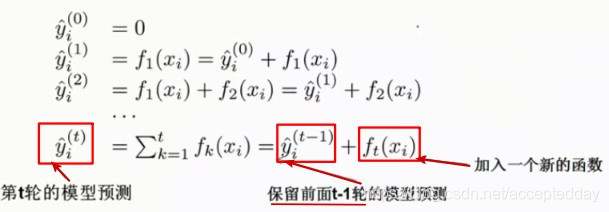

(Ⅱ)集成思想的提升算法–xgboost算法:

t为决策树编号。

t为决策树编号。

即:降低每一次加入的损失函数。

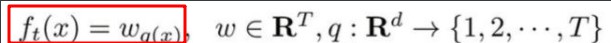

补:

Wq(Xi)为叶子节点中样本权重。

Wq(Xi)为叶子节点中样本权重。

本文深入解析了Xgboost和Adaboost两种集成学习算法,阐述了Xgboost的基本原理,包括其目标函数、正则化项以及优化过程。同时,详细介绍了Adaboost算法的工作流程,从初始化样本权值到训练弱分类器,再到组合强分类器的全过程。

本文深入解析了Xgboost和Adaboost两种集成学习算法,阐述了Xgboost的基本原理,包括其目标函数、正则化项以及优化过程。同时,详细介绍了Adaboost算法的工作流程,从初始化样本权值到训练弱分类器,再到组合强分类器的全过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?