书生大模型全链路开源开放体系由上海人工智能实验室推出,涵盖数据、预训练、微调、评测、部署和应用六大环节,旨在降低大模型研发与应用门槛,推动通用人工智能发展。

一.开源历程

一.开源历程

2023年6月7日,发布浦语系列首个千亿参数模型。

同年7月6日,InternLM-7B模型开源率先免费商用,发布了全链条开源工具体系。

9月20日,InternLM-20B模型开源,开源工具链全线升级。后续开源浦语灵笔模型。

2024年1月17日,开源模型的InternLM2,同月发布InternLM2-Math,这是首个同时支持形式化数学语言及解题过程评价的开源模型。

6月4日,200亿参数版本尽管只是中等规模,但在整体表现上达到了与ChatGPT比肩的水平。

7月4日,InternLM2.5开源。

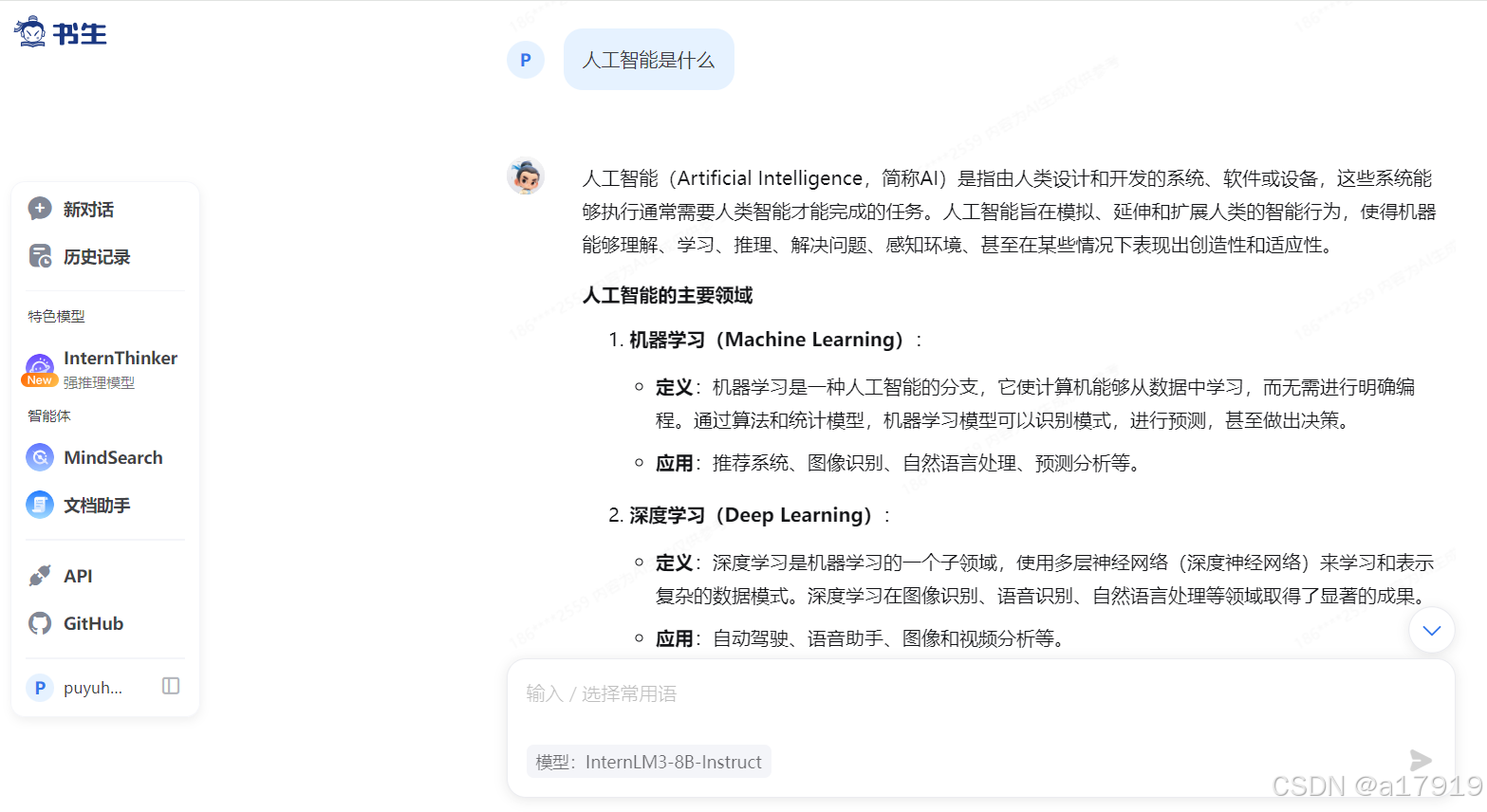

11月25日,上海人工智能实验室向社会用户开放了实验室开发的“书生·浦语”大模型。

二.技术应用与工作

1.技术工作

a.长上下文处理:支持百万Token级文本窗口,精准定位能力突出。

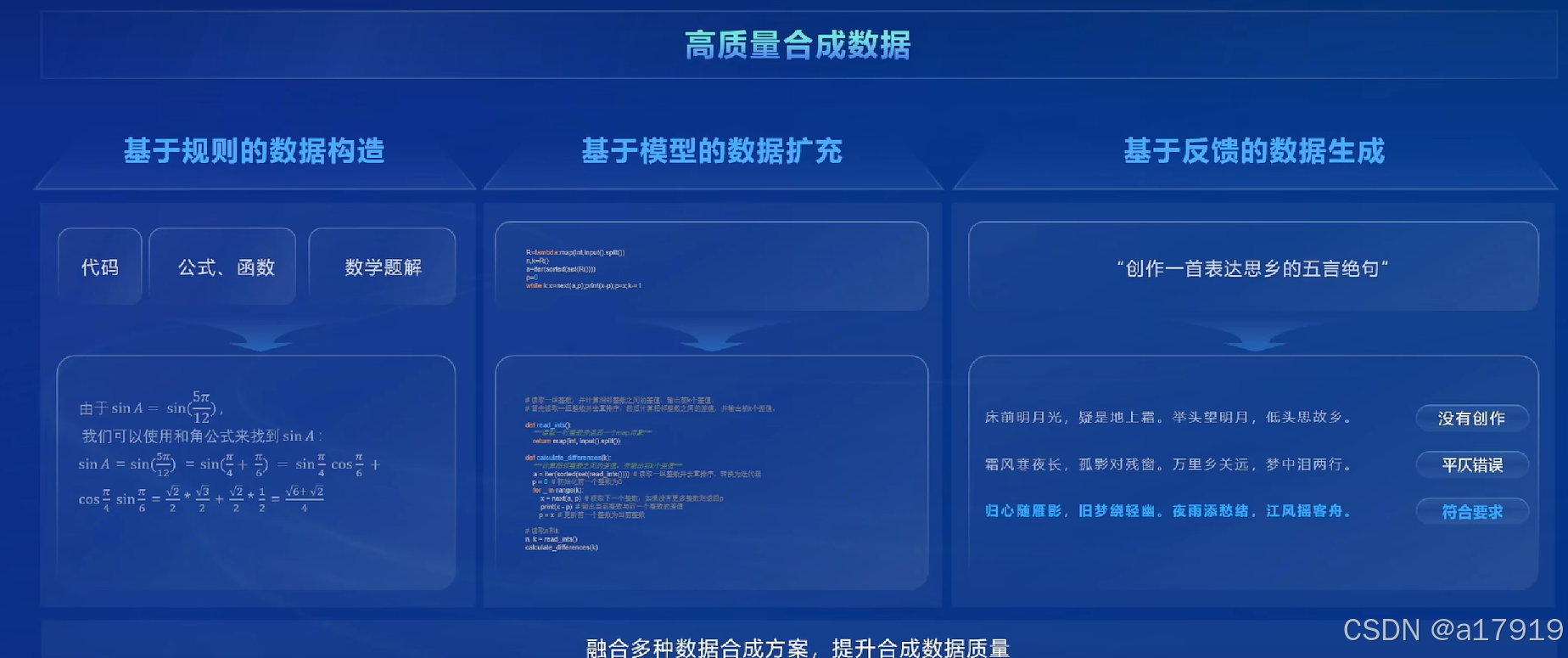

b.数据驱动迭代:基于反馈循环优化数据质量,结合规则构造人工反馈,持续提升模型性能。

c.多模态融合:支持文本、图像、视频等多模态任务。

d.致力于大模型研究与开发工具链的开源组织:为所有 AI 开发者提供高效、易用的开源平台,让最前沿的大模型与算法技术触手可及。

2.典型技术应用

a.InternLM2.5采用更高效的模型结构,拥有更卓越的推理能力,能处理1M超长上下文、互联网搜索与信息整合等复杂任务其,开源了应用场景最广的轻量级7B版本,模型兼顾速度、效率与性能表现。

b.InternLM2-Math拥有有极致数学专项表现的大语言模型,其具备使用Lean语言处理、解答、证明、校验以及增强数学问题的能力,同时,它还能作为奖励模型辅助其他大型语言模型在数学专业能力上的进一步提升。

三.社区动态及小结

1.社区动态

a.开发者支持:提供实战营、挑战赛、算力资源及GitHub完整代码库。加速创新,推动不同领域的应用发展。

b.产学研合作:与高校、企业共建生态,推动技术落地。降低开发门槛,节省时间和成本。促进学术交流,提供研究材料和工具。推动产业应用,加速技术落地

2.体会小结

书生大模型旨在构建一个全链路开源开放体系,涵盖从数据到应用的各个环节,降低大模型的研发门槛,推动通用人工智能(AGI)的普及与发展。未来将在多个领域推动人工智能技术的发展与应用。

书生大模型全链路开源开放体系解析

书生大模型全链路开源开放体系解析

2238

2238

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?