Benchmarking Benchmark Leakage in Large Language Models

https://arxiv.org/abs/2404.18824

Xu等人引入了使用两个简单且可扩展的指标,复杂性和n-gram准确性,来衡量基准模型的预测准确性,以识别潜在的数据泄露。来自:论文翻译:arxiv-2024 Training on the Benchmark Is Not All You Need

在大型语言模型中基准测试泄露的基准测试

文章目录

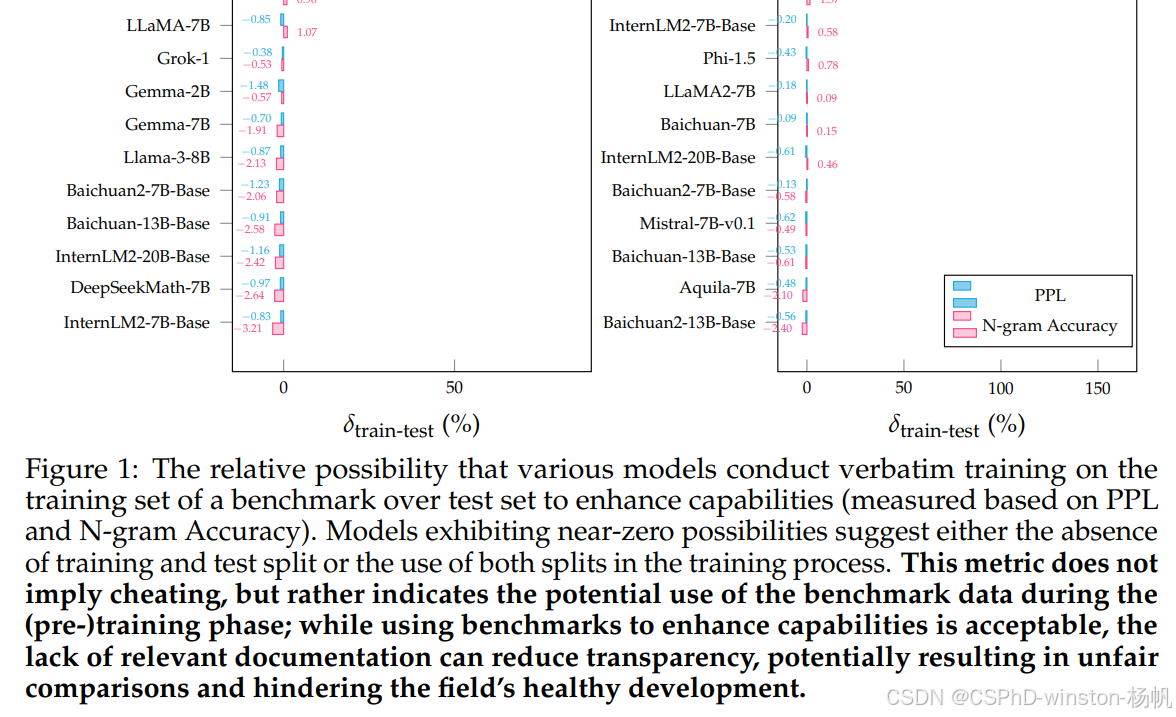

图1:不同模型在基准测试的训练集上进行逐字训练相对于测试集以增强能力(基于PPL和N-gram准确性测量)的相对可能性。表现出接近零可能性的模型表明要么没有训练和测试分割,要么在训练过程中使用了这两个分割。这个指标并不意味着作弊,而是表明在(预)训练阶段可能使用了基准测试数据;虽然使用基准测试来增强能力是可以接受的,但缺乏相关文档可能会降低透明度,可能导致不公平的比较,并阻碍该领域的健康发展。

摘要

随着预训练数据使用的不断扩大,基准数据集泄露现象变得越来越突出,这种情况因大型语言模型(LLMs)训练过程的不透明性以及监督数据的经常未披露的包含而加剧。这个问题扭曲了基准测试的有效性,并促进了可能不公平的比较,阻碍了该领域的健康发展。为了解决这个问题,我们引入了一个利用困惑度和N-gram准确性这两个简单且可扩展的指标来衡量模型在基准测试上的预测精度的检测流程,以识别潜在的数据泄露。通过在数学推理的背景下分析31个LLMs,我们揭示了大量的训练甚至测试集误用的情况,导致可能不公平的比较。这些发现促使我们提出了关于模型文档、基准设置和未来评估的一些建议。值得注意的是,我们提出了“基准透明度卡片”(表19),以鼓励清晰地记

订阅专栏 解锁全文

订阅专栏 解锁全文

1493

1493

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?