基于大模型的ChatGPT横空出世,让AI技术再次成为热门话题。不过,不是所有的公司都需要自己从头训练大模型,就像不是每家饭馆都要自己种菜一样。在大多数情况下,我们更应该关注如何用好现成的大模型来做实际业务。这里分两种情况:真正需要大模型才能存在的应用,比如全新的智能服务,这种情况被称为“智能原生应用”;而更多的时候,我们是把AI当作工具,用它给现有业务升级,这种情况就是常说的“应用型AI”。

大模型就像一个超级大脑,由数不清的“神经元”连接组成。这些数字神经元通过模仿人脑结构来学习思考,所以本质上就是用电脑模拟人脑。就像小朋友学说话需要大量练习一样,大模型也需要“吃”海量数据才能变聪明。

针对目前最热门的语言文字处理、图片生成和音视频处理等应用场景,ChatGPT能像真人一样对话,就是因为有大模型在背后支撑。这种技术突破让很多过去不敢想的应用成为可能,比如智能客服、自动生成报告等,正在改变我们的生活和工作方式。

但要让这个“数字大脑”真正帮人干活,光有强大的理解能力还不够。想象一个数学家去菜市场买菜:他可能算得清菜价,却找不到最新鲜的茼蒿,也不会和摊主讨价还价。这正是当前大模型面临的尴尬——它们擅长思考,却缺乏与现实世界对接的手和脚。从能说会道的聊天机器人,到真正能订机票、查资料、管理智能家居的AI助手,中间还差一座名为模型上下文协议(Model Context Protocol,MCP)的桥梁。

从大模型到大模型应用

我们可以这样理解大模型:它像工厂生产的标准零件一样,经过多次加工就能变成各种工具。这些“零件”之所以通用,是因为它们用海量书籍、网页、对话记录作为教材,自学了人类语言规律。比如我们熟悉的ChatGPT,本质上就是一位超级的语言组装工人。

大模型的核心技术叫Transformer,它相当于两条分工明确的流水线,一条负责理解问题(编码器),另一条负责组织回答(解码器)。现在流行的大模型更侧重于回答生成能力,所以多数采用解码器流水线。

当我们在对话框中输入文字时,这个系统其实在玩高级猜词游戏。它把句子拆解成五万多个文字碎片(比如“人工”和“智能”会被看作两个零件),然后像拼乐高一样,根据过往经验猜测最可能接续的词语。整个过程就像手机输入法的联想功能,只不过背后是经过万亿次训练形成的语言直觉。

大模型的工作原理其实很像人类学造句。我们用网上购物来打个比方:在你输入问题后,系统先把每个字词转换成“条形码”(技术上叫嵌入),就像超市扫码枪识别商品那样。这些数字条形码进入由上万个小计算单元组成的流水线,经过层层筛选加工——有的环节像分拣快递般关注重点信息(注意力计算),有的环节像蒸包子似的层层加工(前馈计算)。最后,系统会给所有可能的接续词语打分(例如logit),就像老师给作文候选词批分数一样。通过特殊公式(比如Softmax)把这些分数转成概率,最终选中最可能接龙的词语。

不过要特别注意,这种“直觉”有时会出错。比如它可能信誓旦旦地说“月亮是奶酪做的”,其实只是在模仿人类的说话模式,并不理解事实。就像鹦鹉学舌,它能流畅对话,但不代表真正明白自己在说什么。

大模型像一个特别会玩成语接龙的学霸,最拿手的就是遣词造句。你给它一段话,它就能根据从海量书籍文章中学来的套路接着往下编出合拍的句子。但这种能力也有天花板——它肚子里的知识永远停留在上学时读过的书本,既查不了最新的天气预报,又不知道你家昨天刚换了WiFi密码。

直接让大模型干活会遇到两个头疼的问题:第一是“消息不灵通”,它无法像查快递那样直接查看数据库中的用户信息,也不知道今天超市鸡蛋打几折;第二是“手无寸铁”,虽然它能说会道,但既不会操作订票系统,又无法帮你调节空调温度。就像让教授去菜场买菜,道理都懂但实际干不来活。

好在工程师找到了两个法宝:检索增强生成(Retrieval Argument Generation,RAG)就像给大模型配了一个随身资料库,需要实时信息时就去翻最新资料;智能体(Agent)则像给它找了一群机器人助手,需要实操时就让这些助手去调取数据库或操作各种工具。这两个法宝配合使用,终于让关在书房里的学者走进了现实世界。

从搜索到运行工具RAG

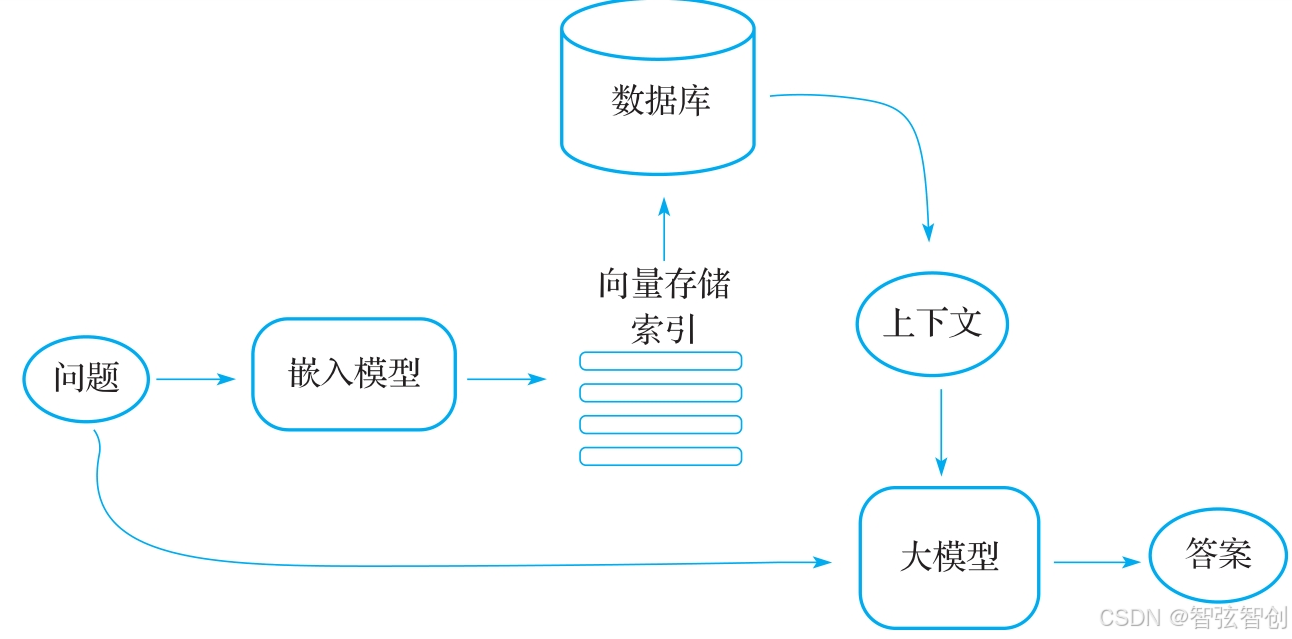

本质上是将搜索与大模型提示相结合的机制。它借助大模型来回应各类查询,同时把搜索算法所获取的信息作为大模型的上下文信息。无论是查询的内容还是检索到的上下文,都会被融入发送至大模型的提示词当中。一个简单的RAG系统架构如图1所示。

结合图1,我们可以这样理解RAG技术:它就像给大模型找了个机灵的资料管理员。想像一个图书管理员在接到读者问题时,会把它转化为关键词(通过嵌入模型),先根据图书目录(向量存储索引)跑遍整个图书馆(数据库)查找相关书籍,再把关键段落(上下文)贴在问题本上,最后才让大模型根据这些资料写答案。

RAG的三个主要技术如下:

切菜备料:把公司文件、产品手册等资料切成小块(像把整颗白菜切成菜叶,技术上称为分块)。

贴条形码:用特殊编码器给每片“菜叶”打上数字标签(类似超市给商品贴价格码,技术上称为嵌入)。

智能货架:把这些带标签的菜叶整齐地码放在虚拟货架上(技术上称为向量索引)。

当用户提问时,系统会把问题也转换成条形码,拿着这个码在货架上快速扫描,抓出最相关的3~5片“菜叶”(技术上称为top-k检索),把菜叶和问题一起喂给大模型:“用这些材料回答问题”。

举一个现实中的例子,比如客服机器人被问“你们新出的手机防水吗?”,RAG系统会立刻从最新产品文档中调出防水等级说明,找出上个月工程师写的测试报告,把这些资料喂给大模型生成回答。不过这套系统也有令人头疼的事,就是找资料太慢,就像在杂货店找调料,货架越乱找得越久。还可能找错资料,可能把冰箱维修手册当成手机说明书,或者资料过期了,使用了三年前的测试报告。就算资料正确,大模型也可能曲解专业术语,不能回复正确的答案。

正是这些挑战,让工程师不断优化检索系统——就像给图书管理员配了智能眼镜一样,既能快速定位书架位置,又能自动识别资料的有效期和可信度。

大模型是个满腹经纶的学者,能写会算,但它有个致命弱点,就是永远被困在书房里。你对它说“帮我订一张明天去上海的机票”,它能写出10种订票攻略,却连鼠标都不会点。这正是当前AI的尴尬:明明满脑子知识,却像个手脚被捆住的人。这时候就需要请出智能体(Agent)技术了。智能体不简单,它左手牵着大模型当智囊,右手握着各种工具当手脚。比如:

听到你说“明早出差要带伞吗?”,它立刻联网查询两地天气预报。

收到“给客户发报价单”的指令,它会自动调取最新产品价目表。

遇到复杂需求,它能像项目经理那样协调多个智能体分工协作。

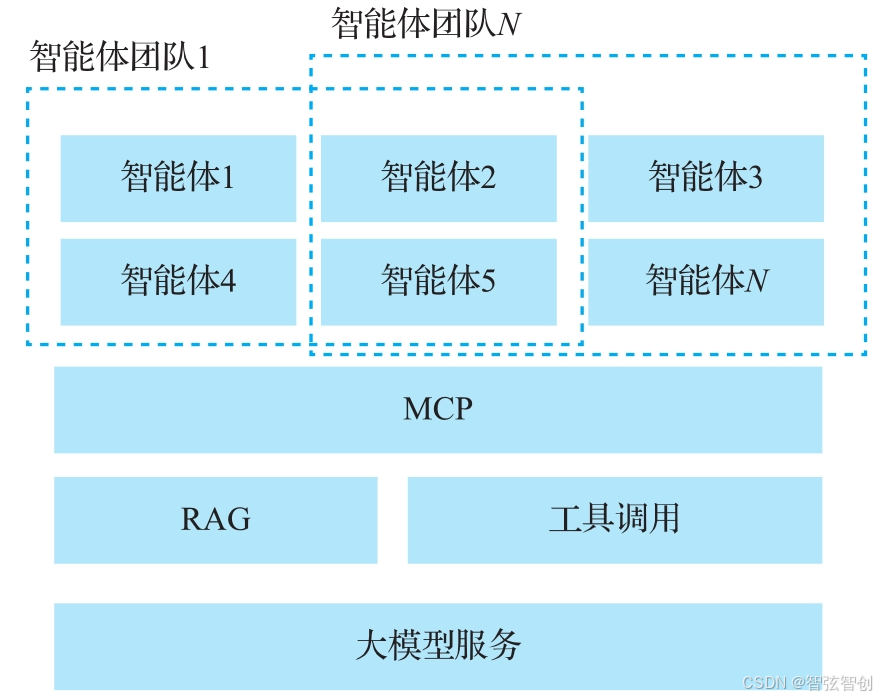

最妙的是,智能体能根据需求变身。开发者在后台给它装不同“技能卡”:有的负责写代码,有的负责检查错误,有的负责向人类确认细节。就像搭积木一样,组合不同功能就能打造出订票专员、数据分析师、智能客服等不同岗位的智能体团队(Multi-Agent技术),如图2所示。

举个例子,当你让AI帮忙策划团建活动时,智能体会先派调研员查询公司预算和员工偏好,再让创意师生成3个方案,最后安排审核员检查每个方案的可行性。整个过程中像有一个看不见的团队在协作,而核心智慧都来自那个在书房里的学者。

当遇到复杂任务时,大模型就像一个经验丰富的建筑师,懂得把装修房子这样的大工程拆成水电、木工、油漆等小工序。不过真正让活干得漂亮的秘诀在于它学会了组建“智能体团队”。

如何更好地支持搜索和使用工具——MCP

现在的大模型就像被关在书房里的学者,虽然满腹经纶,但是接触不到外面的世界。MCP给这个书房开了道门,让大模型能直接拿到最新数据、操作真实工具。

以前企业做网站优化,就像装修餐厅吸引客人一样,要漂亮门面(UI设计)、快速上菜(加载速度)、方便停车(移动适配),但现在AI机器人成了新“食客”:它们不关心装修风格,只想要规范的外卖餐盒;它们不需要精美图片,只要菜品成分表;它们不介意包装简陋,但要求营养数据准确,而且点餐流程越标准化越好。

这就是AI时代的SEO(搜索引擎优化)向LMO(语言模型优化)的转变,好比餐厅既要保持堂食体验,又要专门准备外卖专用通道。

例如,某编程竞赛网站原来需要AI自己搜索网页找选手排名,现在通过MCP接口直接“端出”整理好的榜单:

{

"年度Top程序员":[

{"姓名":"张三","擅长语言":"Python","获奖次数": 5 } ,

{"姓名":"李四","擅长语言":"JaVa","获奖次数": 3 }

]

}

就像给智能体机器人配送预制菜,省去了洗菜切菜的麻烦。企业从此要像培训服务员那样,专门培训如何服务AI“顾客”——既要让人看得舒服,又要让机器读得顺畅。

现在AI应用最关键的是怎么给大模型“喂”数据。就像开饭店既要食材新鲜,又要配送及时,基于MCP的技术系统就是给大模型定制的外卖系统。

原来的RAG好比让大模型自己逛菜市场,要挨个摊位找食材(全网搜资料),自己挑拣清洗(解析网页内容),而且可能买到不新鲜的菜(数据过时)。MCP服务器相当于对接专业食材供应商,配送员(API)按标准化菜盒送货,每盒标明产地日期(结构化数据),随时补送最新鲜货(实时更新),后厨(大模型)也不用停工等进货。

比如一个现实中的场景,我们想对租车服务进行比价,需要打开几个租车网站,手动对比价格和车型,还要担心隐藏的条款。现在智能体通过MCP能够同时联系神州、一嗨、携程的“数据窗口”,秒收各平台真实库存和折扣,结合自己“要SUV、带儿童座椅”的需求,几秒内给出最优方案并代下单。

于是,新商机出现了,就像电梯广告位竞标,租车公司可以付费让自己的报价在AI推荐中置顶。这意味着企业需要专门维护“AI友好型”数据接口,数据准确性成为核心竞争力。智能体不仅帮人干活,还在重塑商业规则。

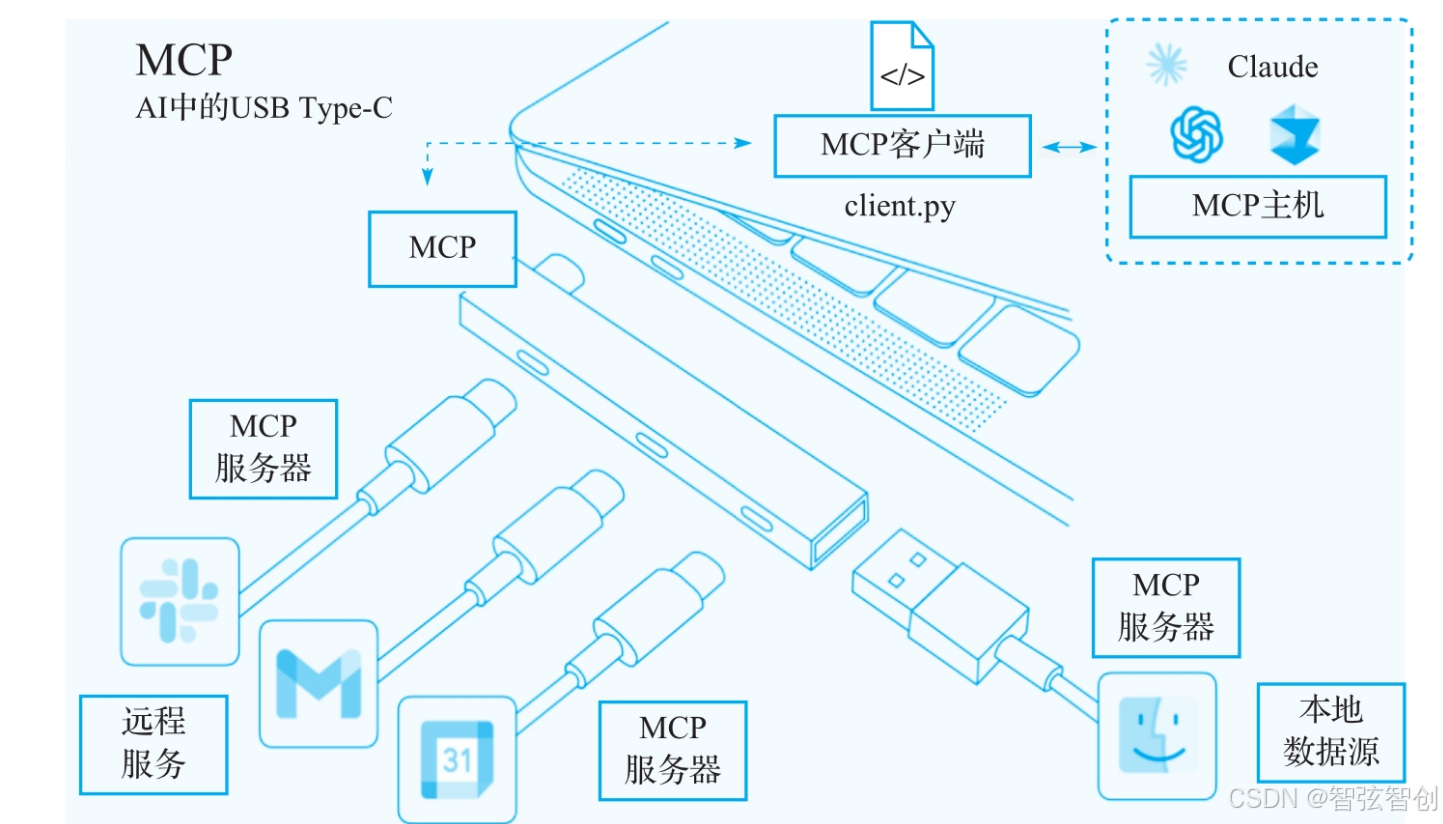

MCP就像给AI世界定制的“通用插座”。它的核心任务很简单——让各种AI应用能像家电插电源一样,轻松连上数据库、企业系统、智能设备这些“电源插座”,如图3所示。好比你出国旅行不用再带转换插头,无论到哪个国家,一个标准接口就能给手机、笔记本电脑、相机同时充电。

这个设计解决了AI开发者的头疼事:过去每对接一个新系统(比如银行数据或工厂传感器),都要重新设计专用接口,就像给每个电器单独制造充电器一样。现在有了MCP,AI应用只需学会“通用插座”的使用方法,就能即插即用地连接:

查天气就像插台灯,拧上气象局的接口就能亮。

分析股票如同接音响,插上交易所的数据源即刻出声。

控制智能家居好比插电风扇,连通协议就能送来凉风。

更关键的是,这个“通用插座”自带安全保险丝和智能电表——数据传输自动加密,权限控制精确到每个操作,还能根据业务需求弹性扩展。就像现代电网既能让手机充电,又能支撑整个工厂运转。MCP服务器让AI从处理简单问答升级到操控真实世界的复杂系统。

我们可以这样理解MCP服务器:它就像给AI手机安装的万能App商店。比如你在微信里装个小程序就能点外卖、打车,AI通过连接不同的MCP服务器,就能解锁查询资料、管控设备等新技能。所有的MCP服务器都用同一套标准指令,AI学会这套标准指令后,查询快递只需说“找顺丰要张三的物流信息”。以前的程序员像手工裁缝,每个接口都要量身定制。现在通过MCP让80%的重复劳动自动化,这让开发者从“流水线工人”变回“发明家”,专注于设计智能机器人的思考方式,而不是整天处理插座不匹配的琐事。

MCP是一个开源协议,是AI模型、开发环境、各种外部数据源和工具之间的桥梁。它的开源特性鼓励创新,允许开发人员扩展其功能,同时通过粒度权限等特性维护安全性。开发人员可以使用MCP构建可重用的、模块化的连接器,使用预构建的MCP服务器,从而创建一个社区驱动的生态系统。

MCP的重要性

MCP提供了一个公共接口,允许任何与MCP兼容的大模型连接到你的数据和工具,简化了AI即插即用服务的开发。与其他可能需要为每个AI模型定制实现的集成方法不同,MCP提供了一种跨不同大模型工作的标准化方法。

为了理解MCP的重要性,让我们将其与传统的AI应用集成进行比较,参见图4。

这种比较突出了MCP的变革潜力。通过使用标准化协议替换定制集成,组织可以显著减少开发时间和维护工作。

如果没有MCP,大模型往往只能局限于其内置的功能和训练数据。通过MCP,大模型可以获得以下能力:

读取文件和数据库。

执行命令。

访问API。

与本地工具交互。

……

所有这些事情都是在用户进行监督并且许可的情况下才发生的,这样一来,大模型既强大又安全。MCP能够把人工智能和现实世界里的行动之间的差距给填补上,让大模型从处理复杂信息的工具变成能完成复杂工作流程的真正帮手。

不管是搭建面向大模型公开服务的应用程序接口(API),还是研究应用程序怎么利用支持MCP的人工智能功能,这个协议都意味着人类和人工智能系统协作方式的重大改变。

对于开发人员和企业来说,现在是开始探索如何将MCP纳入自己的技术栈的时候了。而且,MCP很可能成为事实上的行业标准!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?