选择与评估:构建高效机器学习模型

学习目标

本课程将引导学员了解如何选择合适的机器学习模型,掌握常用的模型评估方法,包括交叉验证、混淆矩阵和ROC曲线。通过本课程的学习,学员将能够独立评估模型性能,选择最佳模型以解决实际问题。

相关知识点

- Scikit-learn模型选择与评估

学习内容

1 Scikit-learn模型选择与评估

1.1 模型选择

在机器学习中,选择合适的模型是至关重要的一步。不同的模型适用于不同类型的数据和问题。例如,线性模型适用于线性可分的数据,而决策树或随机森林则适用于非线性数据。选择模型时,需要考虑以下几个方面:

- 数据特性:数据的分布、特征之间的关系等。

- 问题类型:分类、回归、聚类等。

- 模型复杂度:模型的复杂度与过拟合风险成正比,简单的模型可能无法捕捉数据的复杂模式,而复杂的模型则可能过拟合。

- 计算资源:模型的训练时间和预测时间,以及所需的内存和存储空间。

在Scikit-learn中,可以通过estimator类来选择和训练模型。例如,使用逻辑回归模型进行二分类任务:

%pip install scikit-learn

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

# 加载数据

data = load_iris()

X = data.data[data.target != 2]

y = data.target[data.target != 2]

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 选择模型

model = LogisticRegression()

# 训练模型

model.fit(X_train, y_train)

# 预测

predictions = model.predict(X_test)

#### 1.2 交叉验证

交叉验证是一种评估模型性能的技术,通过将数据集划分为多个子集,多次训练和测试模型,从而获得更稳定和可靠的性能评估。Scikit-learn提供了多种交叉验证方法,如K折交叉验证、留一法等。

**K折交叉验证**

K折交叉验证是最常用的交叉验证方法之一。数据集被划分为K个子集,每次选择一个子集作为测试集,其余子集作为训练集,重复K次,最终取K次评估结果的平均值。

from sklearn.model_selection import cross_val_score

# 使用5折交叉验证评估模型

scores = cross_val_score(model, X, y, cv=5)

# 输出交叉验证得分

print("Cross-validation scores:", scores)

print("Average cross-validation score:", scores.mean())

Cross-validation scores: [1. 1. 1. 1. 1.]

Average cross-validation score: 1.0

1.3 模型评估指标

模型评估指标用于量化模型的性能。不同的问题类型需要不同的评估指标。常见的评估指标包括准确率、精确率、召回率、F1分数、AUC-ROC等。

混淆矩阵

混淆矩阵是分类问题中常用的评估工具,它展示了模型在不同类别上的预测结果。Scikit-learn提供了confusion_matrix函数来计算混淆矩阵。

from sklearn.metrics import confusion_matrix

# 计算混淆矩阵

cm = confusion_matrix(y_test, predictions)

# 输出混淆矩阵

print("Confusion Matrix:")

print(cm)

Confusion Matrix:

[[12 0]

[ 0 8]]

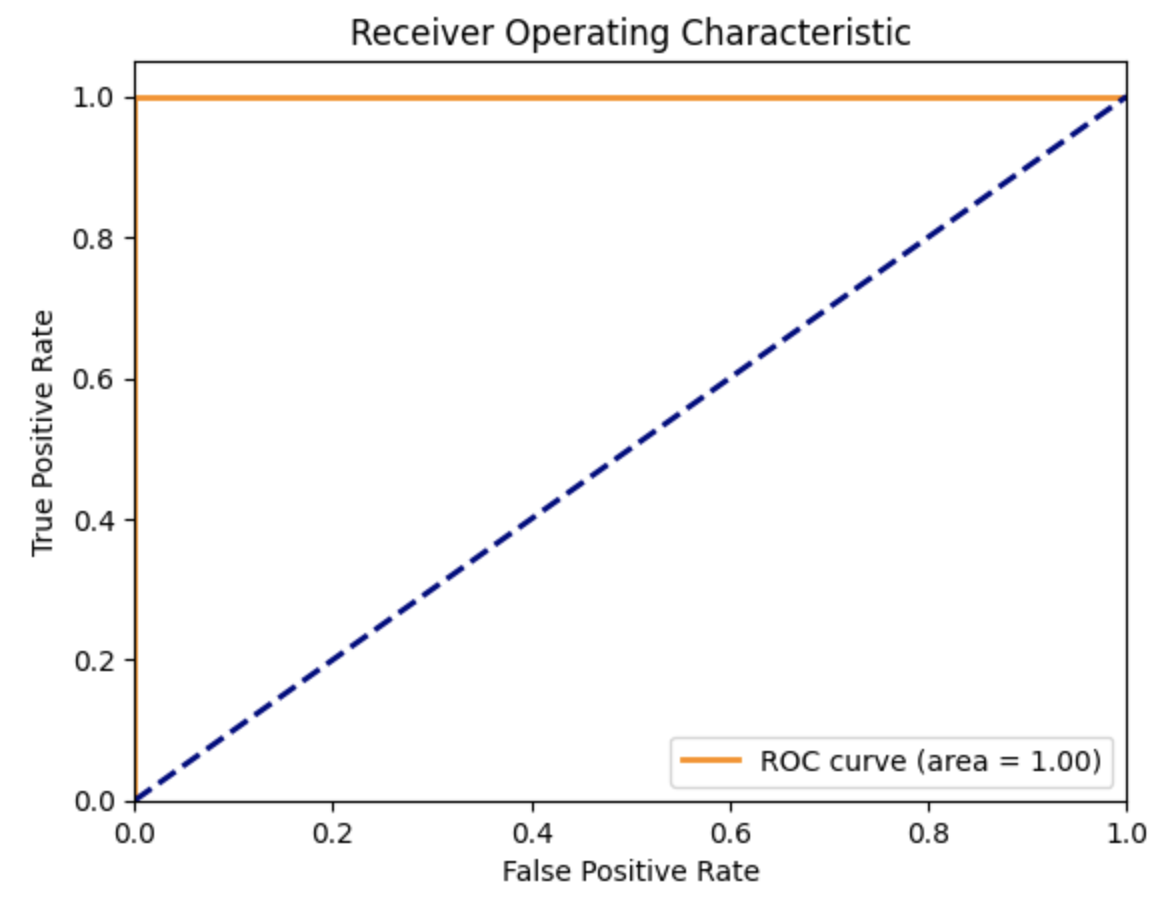

ROC曲线

ROC曲线(Receiver Operating Characteristic Curve)用于评估二分类模型的性能。它通过绘制真正率(True Positive Rate, TPR)与假正率(False Positive Rate, FPR)的关系来展示模型的性能。AUC(Area Under the Curve)值表示ROC曲线下的面积,AUC值越接近1,模型性能越好。

from sklearn.metrics import roc_curve, auc

import matplotlib.pyplot as plt

# 计算ROC曲线

fpr, tpr, thresholds = roc_curve(y_test, model.predict_proba(X_test)[:, 1])

# 计算AUC值

roc_auc = auc(fpr, tpr)

# 绘制ROC曲线

plt.figure()

plt.plot(fpr, tpr, color='darkorange', lw=2, label='ROC curve (area = %0.2f)' % roc_auc)

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

通过本课程的学习,学员将能够熟练掌握模型选择与评估的方法,为实际问题选择合适的模型,并通过多种评估指标来验证模型的性能。

949

949

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?