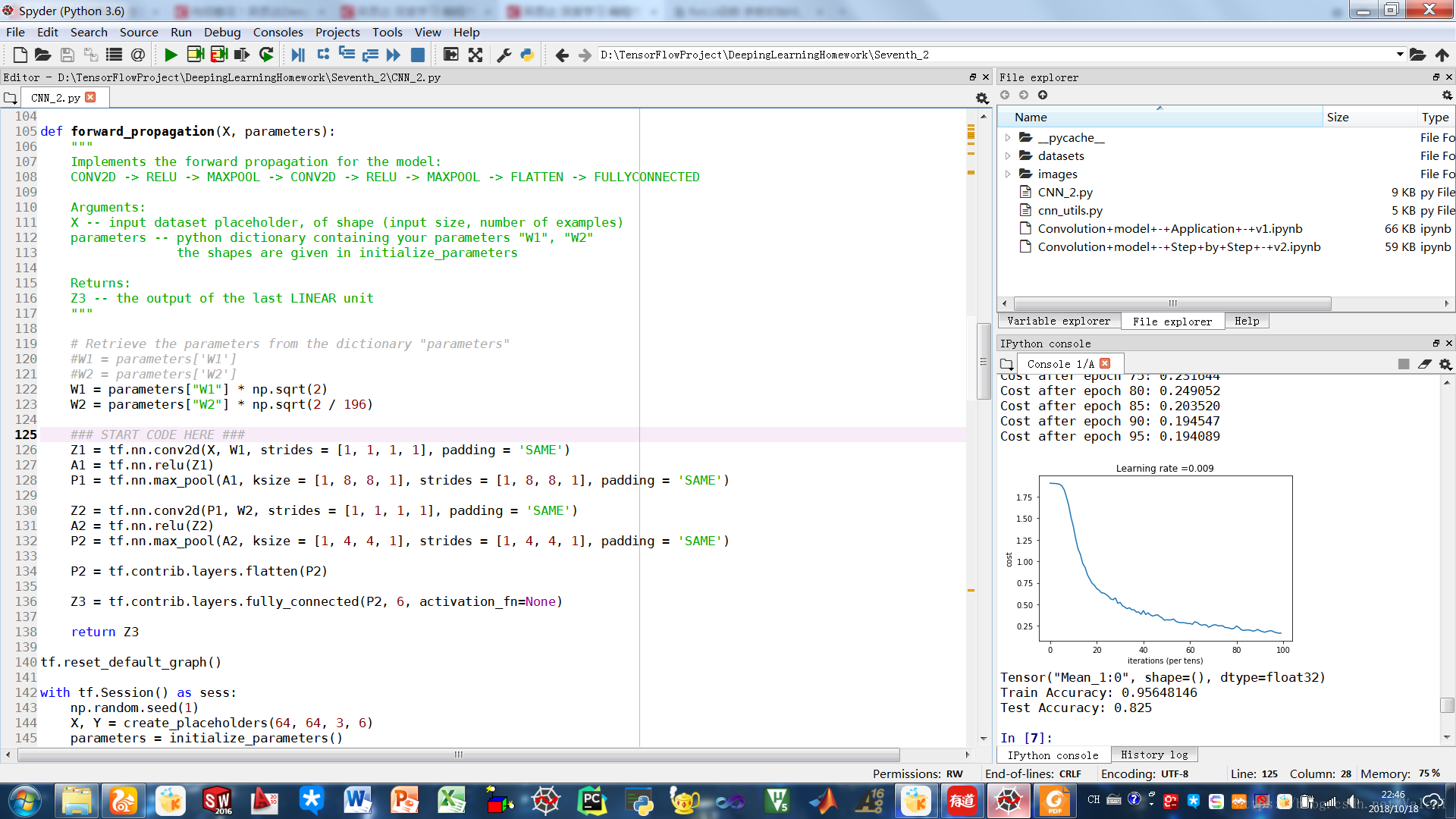

以Ng给出的代码,模型收敛的速度相当缓慢。初始代价1.90左右,迭代100次后代价在1左右,而Ng给出的结果为0.17,具体原因尚不清楚,但是这里提供了一种加快收敛的方法:

卷积层使用的Activation Function为ReLU函数,Ng之前的作业中提到了一种名为He Initialize的方法,可以适用于ReLU函数的参数初始化(泽维尔初始化适用于Sigmoid函数),在这里使用He Initialize:

W1 = parameters["W1"] * np.sqrt(2)

W2 = parameters["W2"] * np.sqrt(2 / 196)

由于第1层没有接受ReLU的输出,因此n0(上一层的维度)设置为1。

参考文献:

[1] Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classificatio., Kaiming He, Xiangyu Zhang, Shaoqing Ren, Jian Sun

本文讨论了Ng提供的代码中模型收敛速度缓慢的问题,并提出通过使用HeInitialize方法和ReLU激活函数来加速卷积神经网络的收敛速度。

本文讨论了Ng提供的代码中模型收敛速度缓慢的问题,并提出通过使用HeInitialize方法和ReLU激活函数来加速卷积神经网络的收敛速度。

846

846