数据库的水平垂直拆分

水平拆分

以某个字段为依据,按照一定规则(例如取模),将一个库(表)上的数据拆分到多个库(表)中,以降低单库(表)大小,达到提升性能的方法

-

特点

-

- 每个库(表)的结构都一样

- 每个库(表)的数据都不一样,没有交集;

- 所有库(表)的并集是全量数据;

垂直拆分

将一个属性较多,一行数据较大的表,将不同的属性拆分到不同的库(表)中,以降低单库(表)大小,达到提升性能的方法

-

特点

-

- 每个库(表)的结构都不一样;

- 每个库(表)的属性至少有一列交集,一般是主键;

- 所有库(表)的并集是全量数据;

-

垂直拆分的依据

-

- 将长度较短,访问频率较高的属性尽量放在一个表里,这个表暂且称为主表

- 将字段较长,访问频率较低的属性尽量放在一个表里,这个表暂且称为扩展表

- 经常一起访问的属性,也可以放在一个表里

读写分离

配置层面的实现

-

设置一个主服务器为写库,设置一个或者多个从服务器为读库,

-

读写一致性的保证

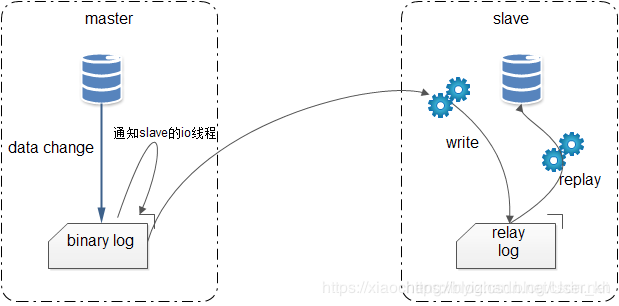

- 主服务器master记录数据库操作日志到Binary log,从服务器开启i/o线程将二进制日志记录的操作同步到ralay log(存在从服务器的缓存中),另外sql线程将ralay log日志记录的操作在从服务器执行

-

读写一致性的设置过程

-

打开主服务器的配置文件,在主服务器中开启Binary Log,在mysqld下面添加

server-id=1 log-bin=master-bin log-bin-index=master-bin.index -

重启mysql服务

service mysql restart -

检查配置效果,进入主数据库并执行

Show master status # 查找到file名,接下来会用到 -

配置从服务器的my.cnf

server-id=2 # 和主服务器的id区分 relay-log-index=slave-relay-bin.index relay-log=slave-relay-bin -

重启从服务器

-

设置两个服务器的关联

-

首先创建一个操作主从同步的数据库用户,切换到主数据库执行

# 这个配置的含义就是创建了一个数据库用户repl,密码是mysql, 在从服务器使用repl这个账号和主服务器连接的时候,就赋予其REPLICATION SLAVE的权限, *.* 表面这个权限是针对主库的所有表的,其中xxx就是从服务器的ip地址。 mysql> create user repl; mysql> GRANT REPLICATION SLAVE ON *.* TO 'repl'@'从xxx.xxx.xxx.xx' IDENTIFIED BY 'mysql'; mysql> flush privileges; -

进入从服务器执行

# 这里面的xxx是主服务器ip,同时配置端口,repl代表访问主数据库的用户,上述步骤执行完毕后执行start slave启动配置: mysql> change master to master_host='主xxx.xxx.xxx.xx',master_port=3306,master_user='repl',master_password='mysql',master_log_file='master-bin.000001',master_log_pos=0; mysql> start slave;- 这个时候就完成了主动同步的操作

-

-

代码层面实现

-

创建用户

在此之前,我们在项目中一般会使用一个数据库用户远程操作数据库(避免直接使用root用户),因此我们需要在主从数据库里面都创建一个用户mysqluser,赋予其增删改查的权限:

mysql> GRANT select,insert,update,delete ON *.* TO 'mysqluser'@'%' IDENTIFIED BY 'mysqlpassword' WITH GRANT OPTION; -

编写jdbc.propreties

#mysql驱动 jdbc.driver=com.mysql.jdbc.Driver #主数据库地址 jdbc.master.url=jdbc:mysql://xxx.xxx.xxx.xx:3306/testsplit?useUnicode=true&characterEncoding=utf8 #从数据库地址 jdbc.slave.url=jdbc:mysql://xxx.xxx.xxx.xx:3306/testsplit?useUnicode=true&characterEncoding=utf8 #数据库账号 jdbc.username=mysqluser jdbc.password=mysqlpassword -

配置数据源

在spring-dao.xml中配置数据源

<?xml version="1.0" encoding="UTF-8"?> <beans xmlns="http://www.springframework.org/schema/beans" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xmlns:context="http://www.springframework.org/schema/context" xsi:schemaLocation="http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans.xsd"> <!-- 配置整合mybatis过程 --> <!-- 1.配置数据库相关参数properties的属性:${url} --> <context:property-placeholder location="classpath:jdbc.properties" /> <!-- 扫描dao包下所有使用注解的类型 --> <context:component-scan base-package="c n.xzchain.testsplit.dao" /> <!-- 2.数据库连接池 --> <bean id="abstractDataSource" abstract="true" class="com.mchange.v2.c3p0.ComboPooledDataSource" destroy-method="close"> <!-- c3p0连接池的私有属性 --> <property name="maxPoolSize" value="30" /> <property name="minPoolSize" value="10" /> <!-- 关闭连接后不自动commit --> <property name="autoCommitOnClose" value="false" /> <!-- 获取连接超时时间 --> <property name="checkoutTimeout" value="10000" /> <!-- 当获取连接失败重试次数 --> <property name="acquireRetryAttempts" value="2" /> </bean> <!--主库配置--> <bean id="master" parent="abstractDataSource"> <!-- 配置连接池属性 --> <property name="driverClass" value="${jdbc.driver}" /> <property name="jdbcUrl" value="${jdbc.master.url}" /> <property name="user" value="${jdbc.username}" /> <property name="password" value="${jdbc.password}" /> </bean> <!--从库配置--> <bean id="slave" parent="abstractDataSource"> <!-- 配置连接池属性 --> <property name="driverClass" value="${jdbc.driver}" /> <property name="jdbcUrl" value="${jdbc.slave.url}" /> <property name="user" value="${jdbc.username}" /> <property name="password" value="${jdbc.password}" /> </bean> <!--配置动态数据源,这里的targetDataSource就是路由数据源所对应的名称--> <bean id="dataSourceSelector" class="cn.xzchain.testsplit.dao.split.DataSourceSelector"> <property name="targetDataSources"> <map> <entry value-ref="master" key="master"></entry> <entry value-ref="slave" key="slave"></entry> </map> </property> </bean> <!--配置数据源懒加载--> <bean id="dataSource" class="org.springframework.jdbc.datasource.LazyConnectionDataSourceProxy"> <property name="targetDataSource"> <ref bean="dataSourceSelector"></ref> </property> </bean> <!-- 3.配置SqlSessionFactory对象 --> <bean id="sqlSessionFactory" class="org.mybatis.spring.SqlSessionFactoryBean"> <!-- 注入数据库连接池 --> <property name="dataSource" ref="dataSource" /> <!-- 配置MyBaties全局配置文件:mybatis-config.xml --> <property name="configLocation" value="classpath:mybatis-config.xml" /> <!-- 扫描entity包 使用别名 --> <property name="typeAliasesPackage" value="cn.xzchain.testsplit.entity" /> <!-- 扫描sql配置文件:mapper需要的xml文件 --> <property name="mapperLocations" value="classpath:mapper/*.xml" /> </bean> <!-- 4.配置扫描Dao接口包,动态实现Dao接口,注入到spring容器中 --> <bean class="org.mybatis.spring.mapper.MapperScannerConfigurer"> <!-- 注入sqlSessionFactory --> <property name="sqlSessionFactoryBeanName" value="sqlSessionFactory" /> <!-- 给出需要扫描Dao接口包 --> <property name="basePackage" value="cn.xzchain.testsplit.dao" /> </bean> </beans>首先读取配置文件jdbc.properties,然后在我们定义了一个基于c3p0连接池的父类“抽象”数据源,然后配置了两个具体的数据源master、slave,继承了abstractDataSource,这里面就配置了数据库连接的具体属性,然后我们配置了动态数据源,他将决定使用哪个具体的数据源,**这里面的关键就是DataSourceSelector,接下来我们会实现这个bean。**下一步设置了数据源的懒加载,保证在数据源加载的时候其他依赖的bean已经加载好了。接着就是常规的配置了,我们的mybatis全局配置文件如下

-

配置mybatis全局配置文件

<?xml version="1.0" encoding="UTF-8" ?> <!DOCTYPE configuration PUBLIC "-//mybatis.org//DTD Config 3.0//EN" "http://mybatis.org/dtd/mybatis-3-config.dtd"> <configuration> <!-- 配置全局属性 --> <settings> <!-- 使用jdbc的getGeneratedKeys获取数据库自增主键值 --> <setting name="useGeneratedKeys" value="true" /> <!-- 使用列别名替换列名 默认:true --> <setting name="useColumnLabel" value="true" /> <!-- 开启驼峰命名转换:Table{create_time} -> Entity{createTime} --> <setting name="mapUnderscoreToCamelCase" value="true" /> <!-- 打印查询语句 --> <setting name="logImpl" value="STDOUT_LOGGING" /> </settings> <plugins> <!-- 拦截器文件,用来判定是读取操作还是写操作,决定走哪个库 --> <plugin interceptor="cn.xzchain.testsplit.dao.split.DateSourceSelectInterceptor"></plugin> </plugins> </configuration>这里面的关键就是DateSourceSelectInterceptor这个拦截器,它会拦截所有的数据库操作,然后分析sql语句判断是“读”操作还是“写”操作,我们接下来就来实现上述的DataSourceSelector和DateSourceSelectInterceptor

-

编写DataSourceSelector

DataSourceSelector就是我们在spring-dao.xml配置的,用于动态配置数据源。

import org.springframework.jdbc.datasource.lookup.AbstractRoutingDataSource; /** * @author lihang * @date 2017/12/6. * @description 继承了AbstractRoutingDataSource,动态选择数据源 */ public class DataSourceSelector extends AbstractRoutingDataSource { @Override protected Object determineCurrentLookupKey() { return DynamicDataSourceHolder.getDataSourceType(); } }我们只要继承AbstractRoutingDataSource并且重写determineCurrentLookupKey()方法就可以动态配置我们的数据源。

编写DynamicDataSourceHolder,代码如下:/** * @author lihang * @date 2017/12/6. * @description */ public class DynamicDataSourceHolder { /**用来存取key,ThreadLocal保证了线程安全*/ private static ThreadLocal<String> contextHolder = new ThreadLocal<String>(); /**主库*/ public static final String DB_MASTER = "master"; /**从库*/ public static final String DB_SLAVE = "slave"; /** * 获取线程的数据源 * @return */ public static String getDataSourceType() { String db = contextHolder.get(); if (db == null){ //如果db为空则默认使用主库(因为主库支持读和写) db = DB_MASTER; } return db; } /** * 设置线程的数据源 * @param s */ public static void setDataSourceType(String s) { contextHolder.set(s); } /** * 清理连接类型 */ public static void clearDataSource(){ contextHolder.remove(); } }这个类决定返回的数据源是master还是slave,这个类的初始化我们就需要借助DateSourceSelectInterceptor了,我们拦截所有的数据库操作请求,通过分析sql语句来判断是读还是写操作,读操作就给DynamicDataSourceHolder设置slave源,写操作就给其设置master源,代码如下:

import org.apache.ibatis.executor.Executor; import org.apache.ibatis.executor.keygen.SelectKeyGenerator; import org.apache.ibatis.mapping.BoundSql; import org.apache.ibatis.mapping.MappedStatement; import org.apache.ibatis.mapping.SqlCommandType; import org.apache.ibatis.plugin.*; import org.apache.ibatis.session.ResultHandler; import org.apache.ibatis.session.RowBounds; import org.springframework.transaction.support.TransactionSynchronizationManager; import java.util.Locale; import java.util.Properties; /** * @author lihang * @date 2017/12/6. * @description 拦截数据库操作,根据sql判断是读还是写,选择不同的数据源 */ @Intercepts({@Signature(type = Executor.class,method = "update",args = {MappedStatement.class,Object.class}), @Signature(type = Executor.class,method = "query",args = {MappedStatement.class,Object.class, RowBounds.class, ResultHandler.class})}) public class DateSourceSelectInterceptor implements Interceptor{ /**正则匹配 insert、delete、update操作*/ private static final String REGEX = ".*insert\\\\u0020.*|.*delete\\\\u0020.*|.*update\\\\u0020.*"; @Override public Object intercept(Invocation invocation) throws Throwable { //判断当前操作是否有事务 boolean synchonizationActive = TransactionSynchronizationManager.isSynchronizationActive(); //获取执行参数 Object[] objects = invocation.getArgs(); MappedStatement ms = (MappedStatement) objects[0]; //默认设置使用主库 String lookupKey = DynamicDataSourceHolder.DB_MASTER;; if (!synchonizationActive){ //读方法 if (ms.getSqlCommandType().equals(SqlCommandType.SELECT)){ //selectKey为自增主键(SELECT LAST_INSERT_ID())方法,使用主库 if (ms.getId().contains(SelectKeyGenerator.SELECT_KEY_SUFFIX)){ lookupKey = DynamicDataSourceHolder.DB_MASTER; }else { BoundSql boundSql = ms.getSqlSource().getBoundSql(objects[1]); String sql = boundSql.getSql().toLowerCase(Locale.CHINA).replace("[\\t\\n\\r]"," "); //如果是insert、delete、update操作 使用主库 if (sql.matches(REGEX)){ lookupKey = DynamicDataSourceHolder.DB_MASTER; }else { //使用从库 lookupKey = DynamicDataSourceHolder.DB_SLAVE; } } } }else { //一般使用事务的都是写操作,直接使用主库 lookupKey = DynamicDataSourceHolder.DB_MASTER; } //设置数据源 DynamicDataSourceHolder.setDataSourceType(lookupKey); return invocation.proceed(); } @Override public Object plugin(Object target) { if (target instanceof Executor){ //如果是Executor(执行增删改查操作),则拦截下来 return Plugin.wrap(target,this); }else { return target; } } @Override public void setProperties(Properties properties) { } } -

总结

最后整理一下整个流程:

1.项目启动后,在依赖的bean加载完成后,我们的数据源通过LazyConnectionDataSourceProxy开始加载,他会引用dataSourceSelector加载数据源。

2.DataSourceSelector会选择一个数据源,我们在代码里设置了默认数据源为master,在初始化的时候我们就默认使用master源。

3.在数据库操作执行时,DateSourceSelectInterceptor拦截器拦截了请求,通过分析sql决定使用哪个数据源,“读操作”使用slave源,“写操作”使用master源。

读写分离带来的延迟问题

-

主从延迟的根本原因是什么

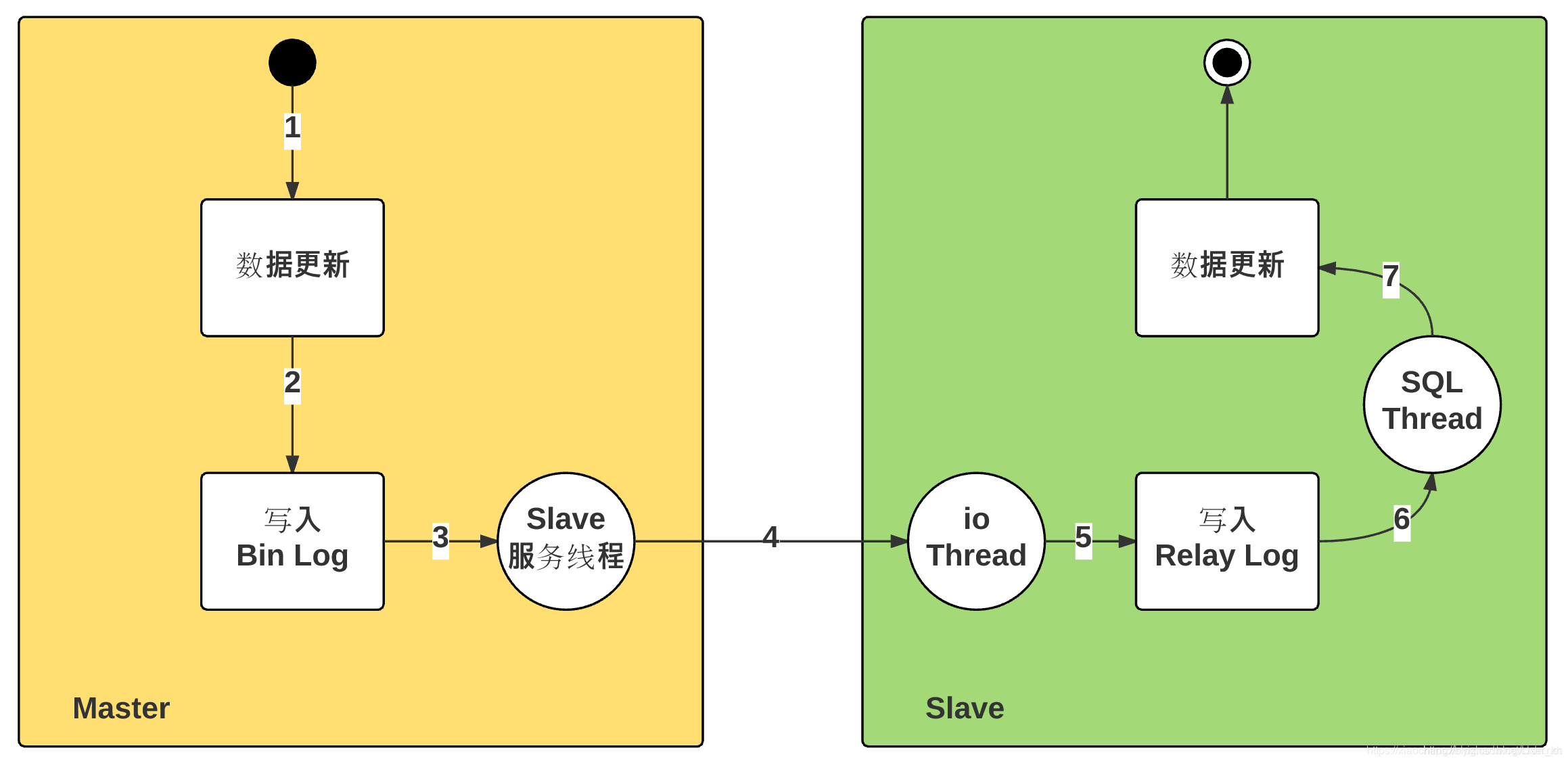

主从延迟的时间:Master成功执行,到Slave执行成功的时间差上述过程:

- 主从延迟:步骤二开始到步骤七执行数据时间

- 步骤二:存储引擎处理,时间极短

- 步骤三:文件更新通知,磁盘读取延迟

- 步骤四:Bin Log文件更新的传输延迟,单线程

- 步骤五:磁盘写入延迟

- 步骤六:文件更新通知,磁盘读取延迟

- 步骤七:sql执行时间时长

通过上述分析,MySQL主从复制是典型的

生产者-消费者模型,整体耗时:分为几类:- 磁盘的读写耗时:步骤三,步骤五,步骤六

- 网络传输耗时:步骤四

- SQL执行耗时:步骤七(在Slave上执行relay log过程)

- 排队耗时:步骤三(在Master上bin log 中排队,生产者-消费者)

-

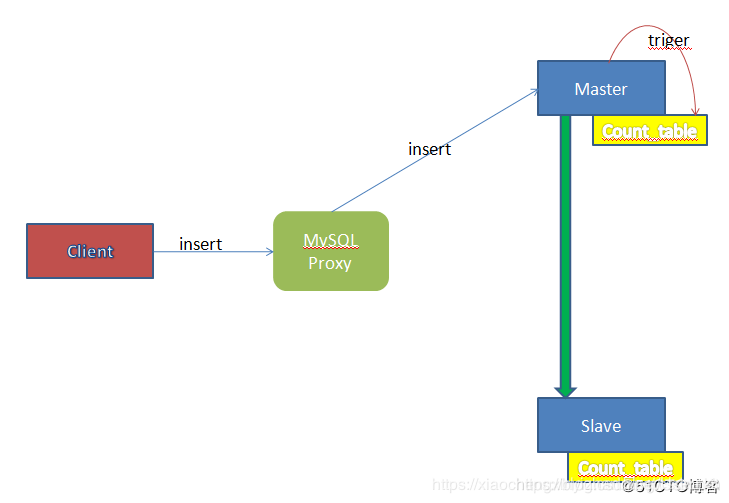

主从延迟的解决办法—探针思想

- 在Master上增加一个自增表,这个表仅有一个字段,当Master接收到任何数据更新的请求时,均会触发这个触发器,该触发器更新自增表的记录

- 由于Count_Table也参与MySQL的主从同步,因此在Master上做的update更新也会同步到Slave中。当Clientt通过Proxy进行数据读取时,Proxy可以先向Master和Slave的Count_Table表发送查询请求,当二者的数据相同时,proxy可以认定Master和Slave的数据状态是一致的,然后把请求打在Slave服务器上,否则就发送到Master中。

- 在Master上增加一个自增表,这个表仅有一个字段,当Master接收到任何数据更新的请求时,均会触发这个触发器,该触发器更新自增表的记录

本文深入探讨了数据库的水平垂直拆分、读写分离的配置与代码实现,包括主从同步、延迟问题及解决方案,适用于高并发场景。

本文深入探讨了数据库的水平垂直拆分、读写分离的配置与代码实现,包括主从同步、延迟问题及解决方案,适用于高并发场景。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?