对于模型微调来说,直接进行微调需要的硬件配置和时间都是相当夸张的,但要想实现风格切换自由,也不是只有模型微调一个方式,LoRA技术可以说很完美的解决了这个难题。无论是二次元画风还是复古胶片质感,都只需要加载小巧的LoRA模型,就能立即解锁意料之外的百变创作可能!

一、LoRA是什么?为什么必学这个技能?

✅ 低秩适应技术:LoRA(Low-Rank Adaptation)通过微调模型参数实现特定风格/人物的生成

✅ 体积优势:相比完整模型(2-7GB),LoRA文件通常只有20-200MB

✅ 灵活组合:可同时加载多个LoRA实现风格叠加

✅ 兼容性强:支持SD1.5/SDXL等多种基础模型

二、准备工作清单

1 本地已安装好 diffusers 环境

如果没有的,下面给出简单步骤,验证安装

1 安装Python环境,创建虚拟环境 (因为要下载的组件比较大,防止污染主环境,建议在虚拟环境进行)

2 激活虚拟环境,添加全局国内镜像加速 (建立使用vscode打开虚拟环境所在目录,会自动加载虚拟环境,避免每次都要手动激活)

$ python -m venv .venv # 根据你的喜好命名虚拟环境,我这是是 .venv

$ pip config set global.index-url https://mirrors.aliyun.com/pypi/simple # 添加国内镜像加速

# 安装依赖pytorch,我硬件没有GPU,安装了cpu版的,硬件OK,去掉后面的参数即可

$ pip install torch torchvision --extra-index-url https://download.pytorch.org/whl/cpu

# 安装 diffusers 库

$ pip install diffusers transformers accelerate

2 基础模型下载

这里需要准备好你的基础大模型,我这里使用的是 Lykon/dreamshaper-8-lcm

https://huggingface.co/Lykon/dreamshaper-8-lcm

你也可以根据你的本地情况加载已下载的模型

3 LoRA模型下载

下载好的 模型文件(.safetensors或.ckpt格式)

推荐平台:

- Civitai(需科学上网)

- LiblibAI(国内可用)

三、LoRA加载

这里直接给出关键代码,我没有使用WebUI是因为我发现本地CPU环境运行时,没有直接Python加载diffusers库高效,自己加个Qt界面,自定义功能也挺好用

这里直接将该软件分享出来给大家吧~

1.stable diffusion安装包

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

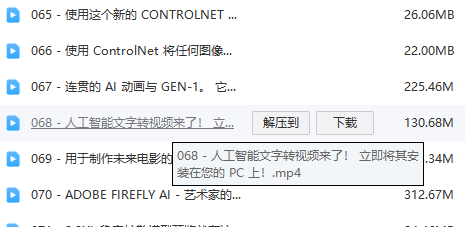

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.SD从0到落地实战演练

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名SD大神的正确特征了。

这份完整版的stable diffusion资料我已经打包好,需要的点击下方插件,即可前往免费领取!

626

626

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?