文章目录

- 一、感知机模型的发明

- 1. 感知机的数学原理

- 2. 应用与扩展

- 二、神经网络的诞生与结构

- 1. 神经网络基本结构

- 2. 神经网络的数学原理

- 3. 常见激活函数

- sigmoid

- tanh

- Relu

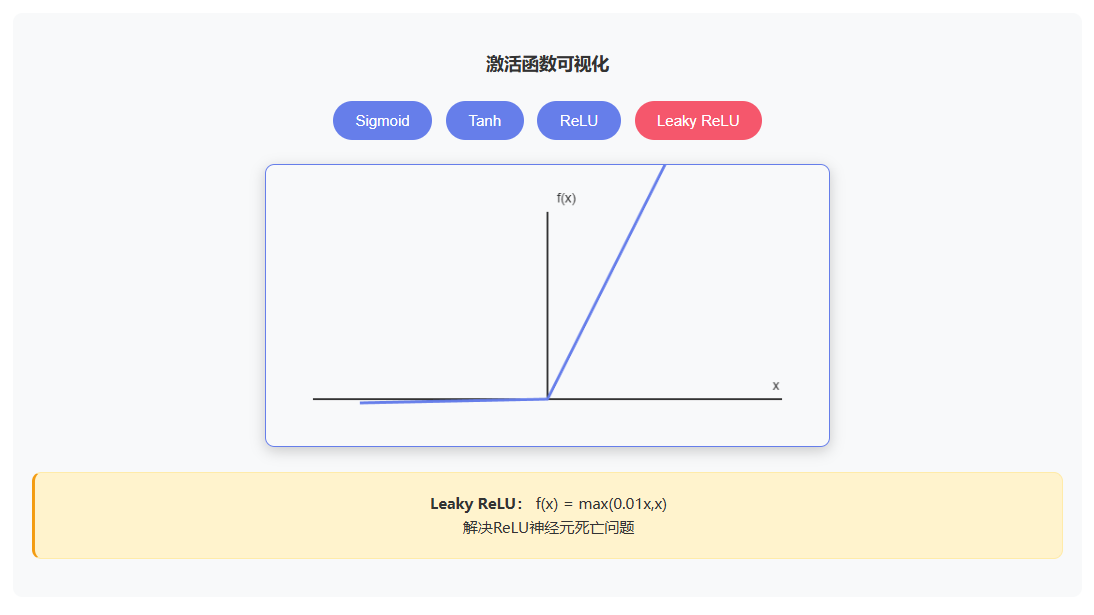

- Leaky Relu

- 4. 神经网络的核心优势

- 三、前向传播与反向传播

- 1. 前向传播

- (1)数学表示

- (2)计算流程

- 2. 反向传播

- (1)激活函数

- (2)梯度计算

- (3)计算流程

- 3. 梯度消失与梯度爆炸

一、感知机模型的发明

感知机是由美国科学家 Frank Rosenblatt 在1957年提出的一种简单的线性二分类模型,是神经网络和支持向量机的基础。

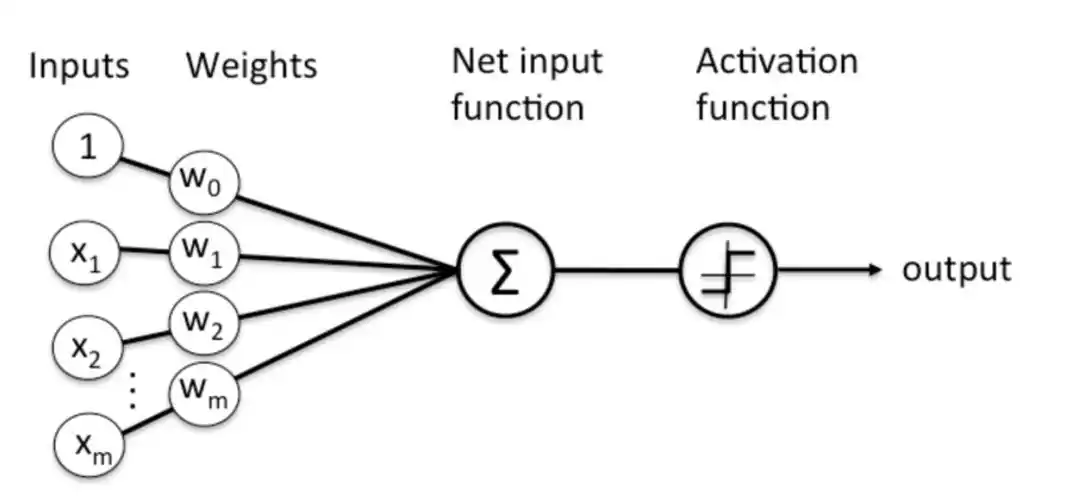

感知机模拟了生物神经元的工作原理:接收多个输入信号,通过权重加权求和后,经过激活函数处理,输出一个二值结果(0 或 1,也可以是 -1 或 1)。

- 感知机的核心特点:

线性分类器,只能处理线性可分的问题

通过梯度下降法更新权重,实现参数学习

是单层神经网络,也是深度学习的基础

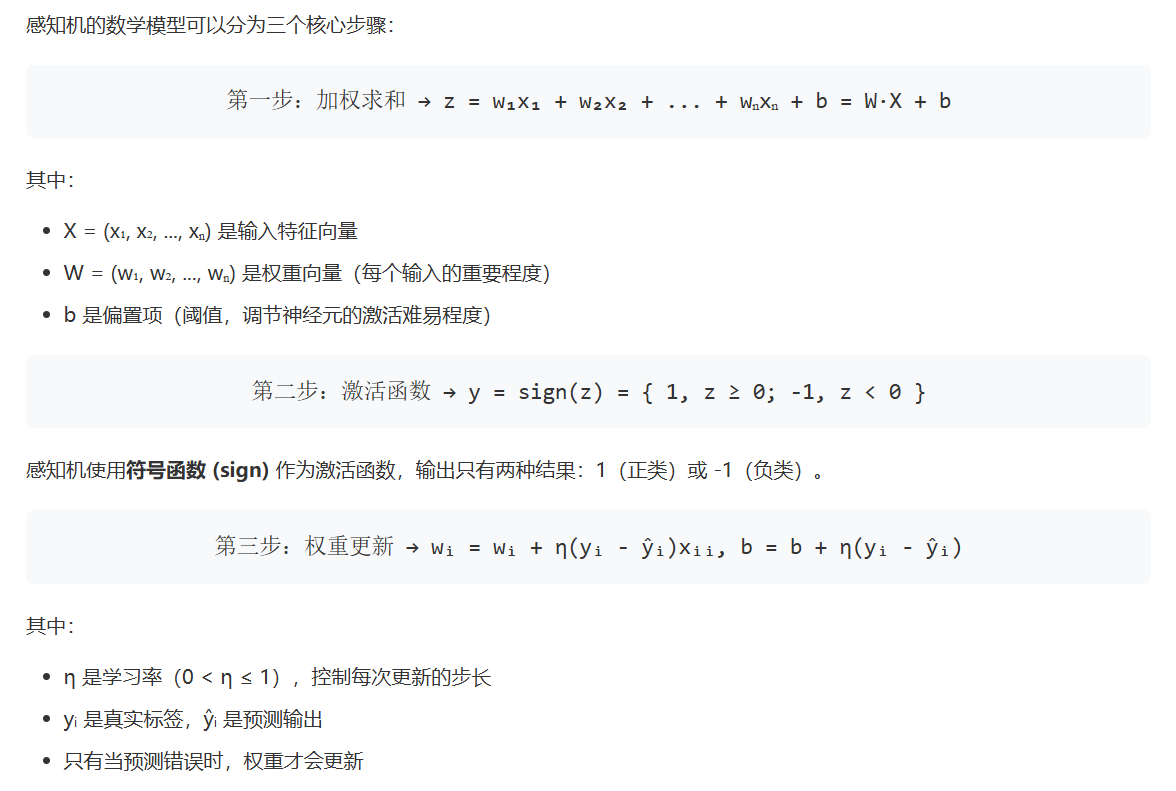

1. 感知机的数学原理

2. 应用与扩展

基础应用:简单的二分类任务(垃圾邮件识别、故障检测、信用评分)

扩展1:多层感知机(MLP)→ 解决非线性问题,构成深度学习的基础

扩展2:卷积神经网络(CNN)→ 在图像识别中保留感知机的加权求和核心

扩展3:感知机收敛定理 → 对于线性可分数据,感知机一定能在有限步内收敛

二、神经网络的诞生与结构

神经网络的诞生是多学科交叉、生物智能模仿、传统算法瓶颈倒逼与实际应用需求牵引的共同结果:

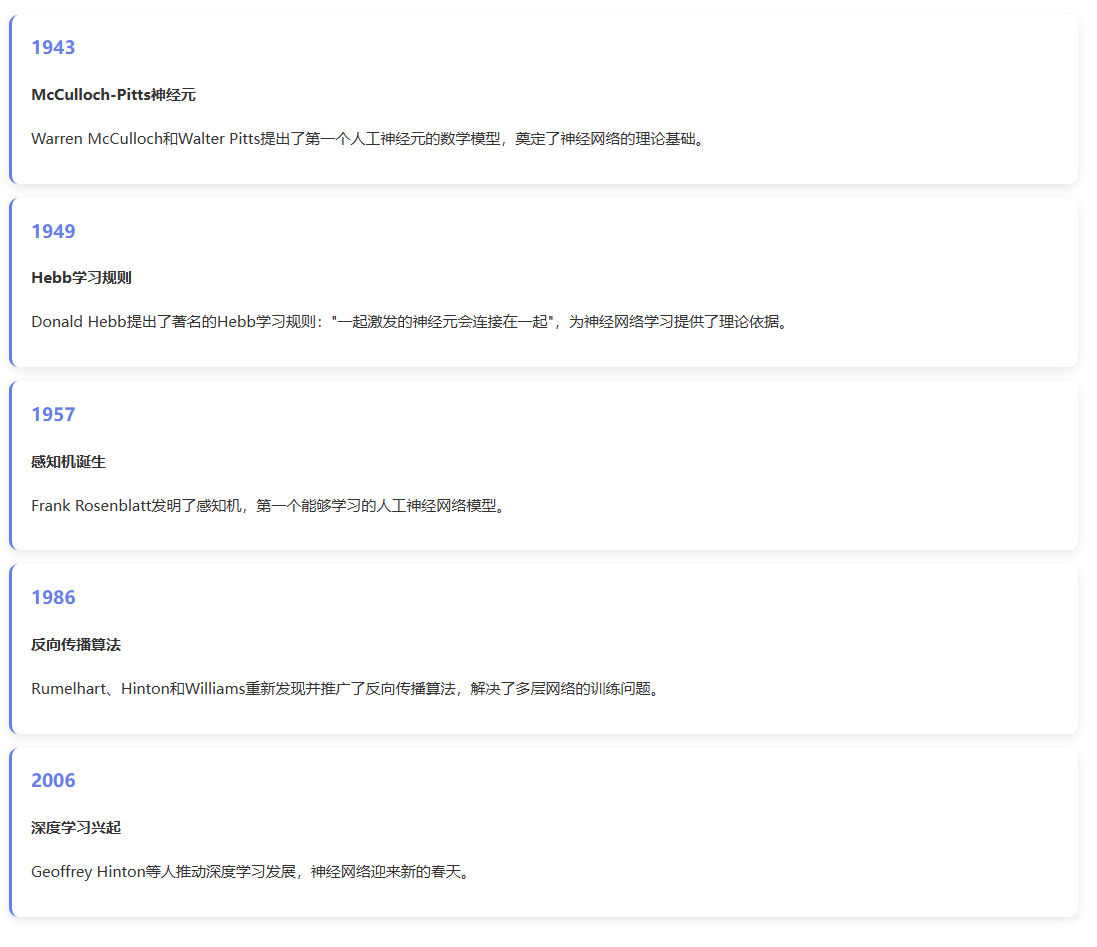

其思想源于对生物神经元工作机制的研究,1943 年 M-P 神经元模型奠定数学基础,1957 年感知机的提出标志着第一代可学习神经网络的诞生;

传统符号主义 AI 和统计模型在非线性、非结构化数据处理上的局限,催生了这种依赖数据自主学习的新范式;

数学、计算机科学与认知科学的融合为其提供了理论与硬件支撑,而军方模式识别、工业自适应控制等实际需求则推动其从实验室走向应用;

本质上,它是人类试图通过模拟神经元连接与数据驱动学习,复刻生物智能、突破传统算法限制的探索成果,后续也历经了感知机局限性引发的低谷与反向传播算法带来的复兴。

- 神经网络的诞生背景:

- 神经网络发展:

- 深度神经网络:

层次更深,可实现端到端的神经网络。

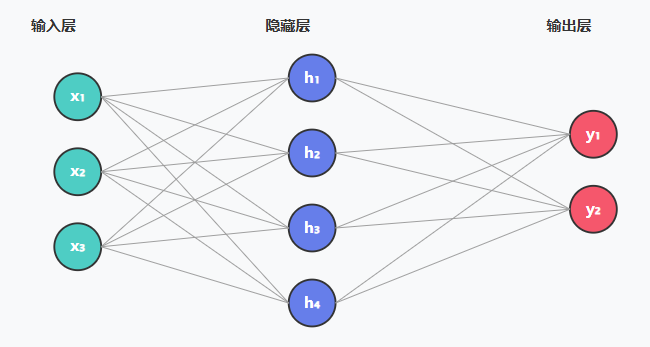

1. 神经网络基本结构

🔍 各层功能详解

输入层:接收外部数据,每个节点代表一个特征

隐藏层:进行特征提取和变换,层数越多学习能力越强

输出层:产生最终结果,节点数取决于任务类型

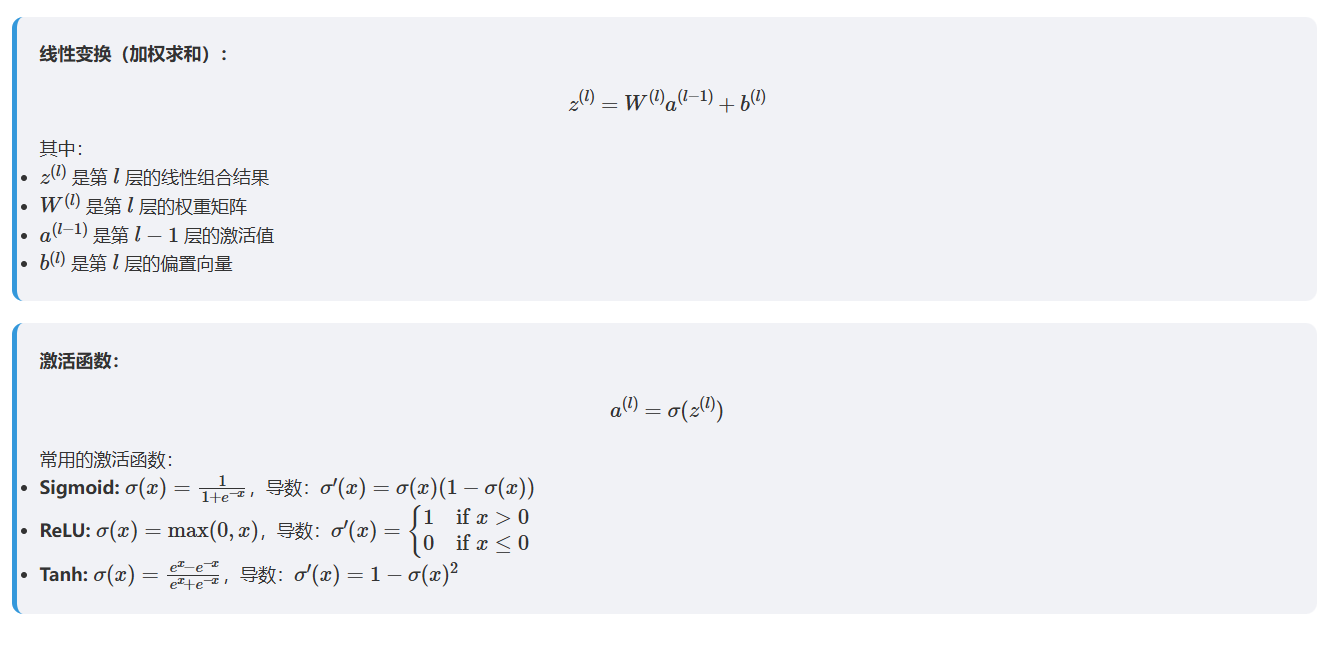

2. 神经网络的数学原理

3. 常见激活函数

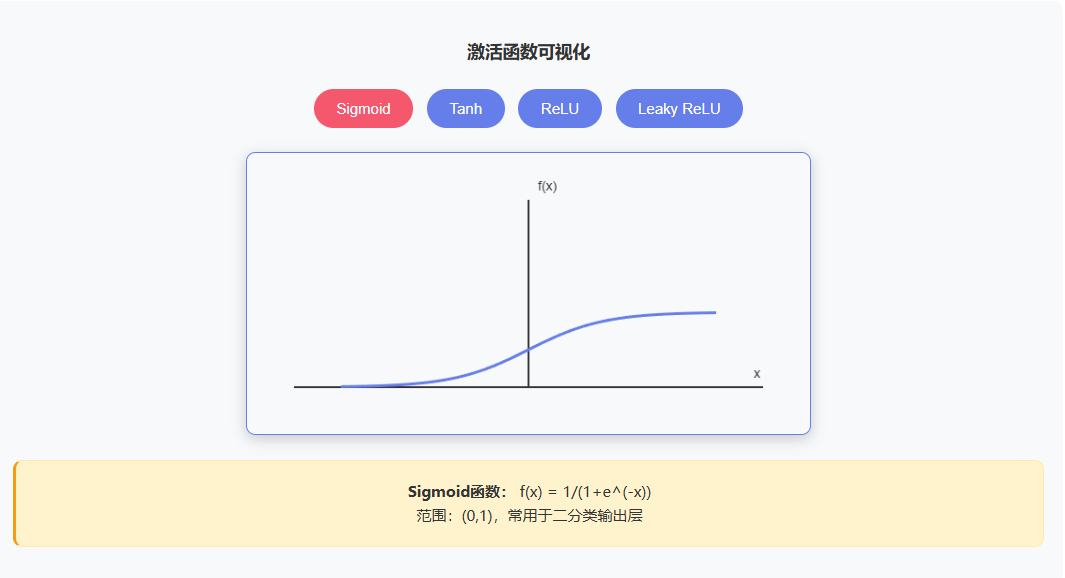

sigmoid

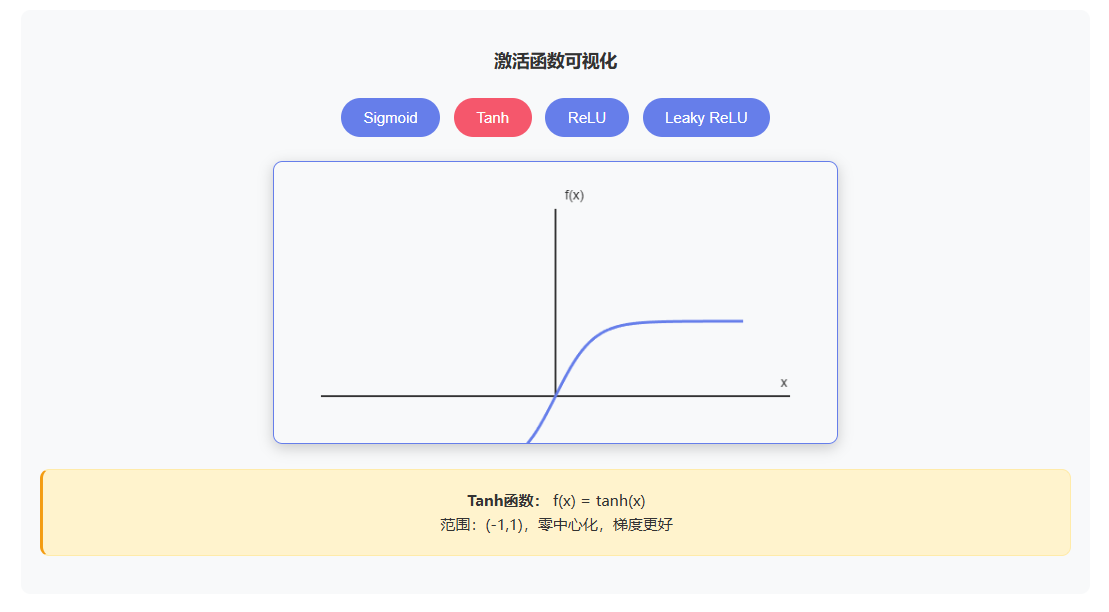

tanh

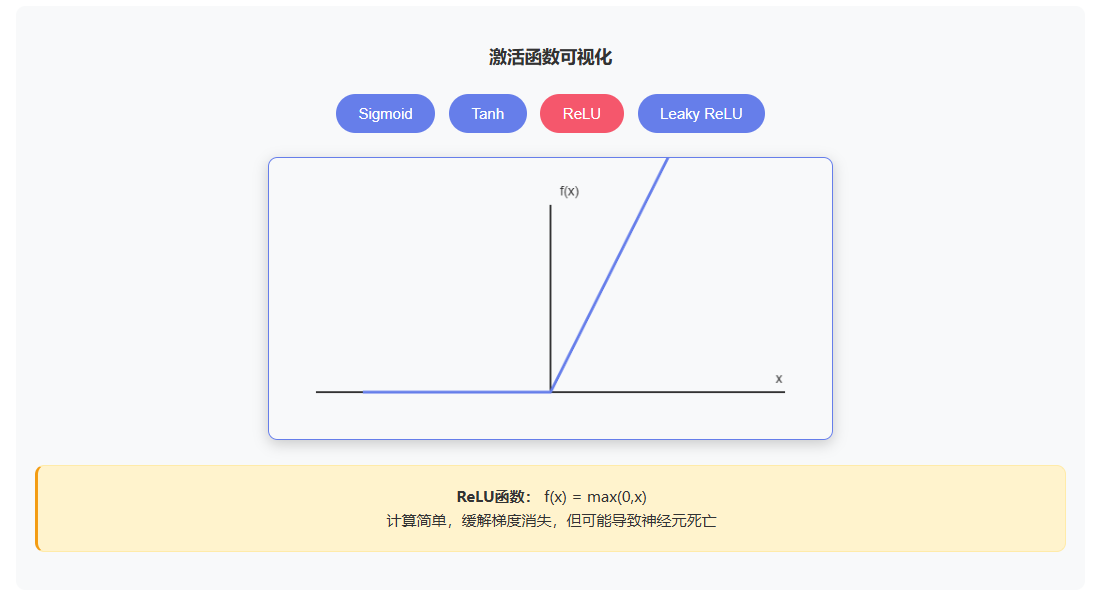

Relu

Leaky Relu

4. 神经网络的核心优势

- 通用逼近能力:理论上可以逼近任何连续函数

- 非线性建模:通过激活函数引入非线性

- 自动特征学习:无需手工设计特征

- 并行计算:天然适合并行处理

- 容错性:部分节点失效不影响整体性能

- 可扩展性:可以通过增加层数和节点提升能力

三、前向传播与反向传播

前向传播与反向传播是神经网络训练过程中相辅相成的两个核心环节:

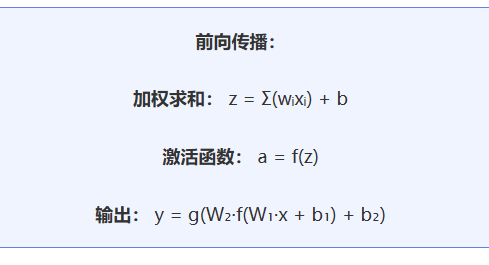

前向传播是将输入数据逐层通过神经网络的权重和激活函数计算,最终输出预测结果的过程,其目的是基于当前网络参数完成 “从输入到输出” 的推理,对比预测值与真实标签得到误差;

反向传播则是从输出层的误差出发,沿着网络层级反向计算每个参数对误差的贡献(梯度),并借助梯度下降法更新权重和偏置,其核心是让网络 “从错误中学习”,不断调整参数以缩小预测误差,最终实现神经网络的优化训练。

简单来说,前向传播负责 “做预测、找误差”,反向传播负责 “算梯度、改参数”,二者循环迭代直至网络收敛。

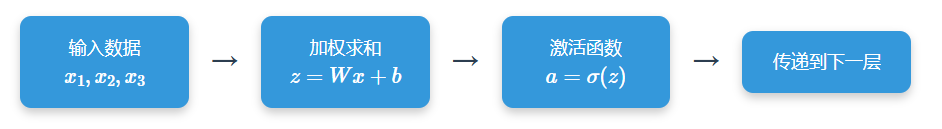

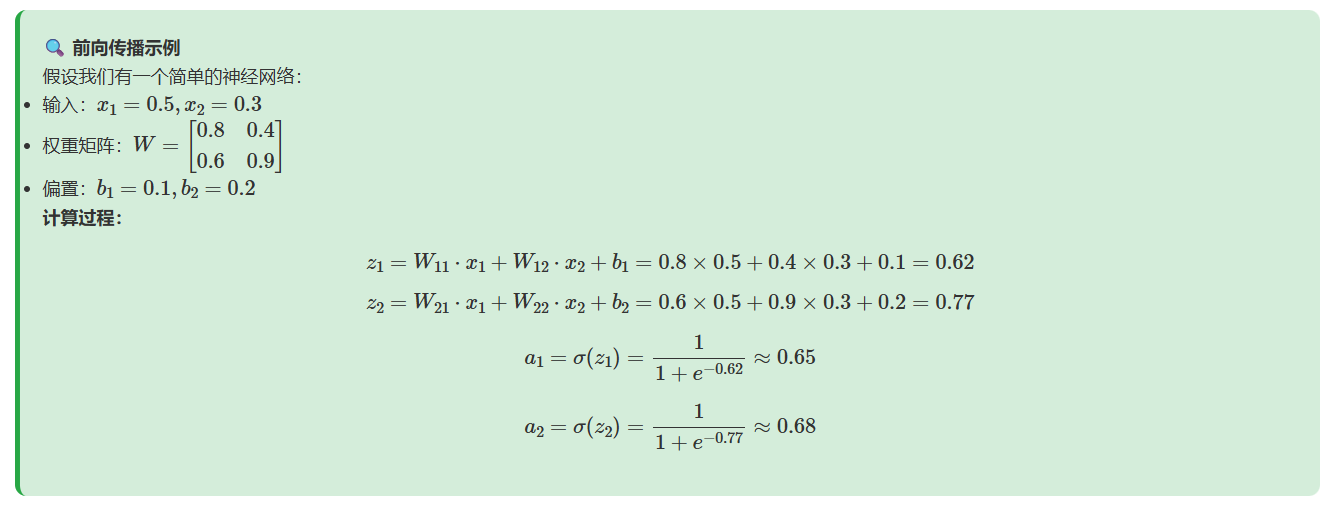

1. 前向传播

前向传播是数据从输入层流向输出层的过程。在这个过程中,每一层的神经元接收前一层的输出,进行加权求和,然后通过激活函数处理,将结果传递给下一层。

(1)数学表示

(2)计算流程

- 示例:

2. 反向传播

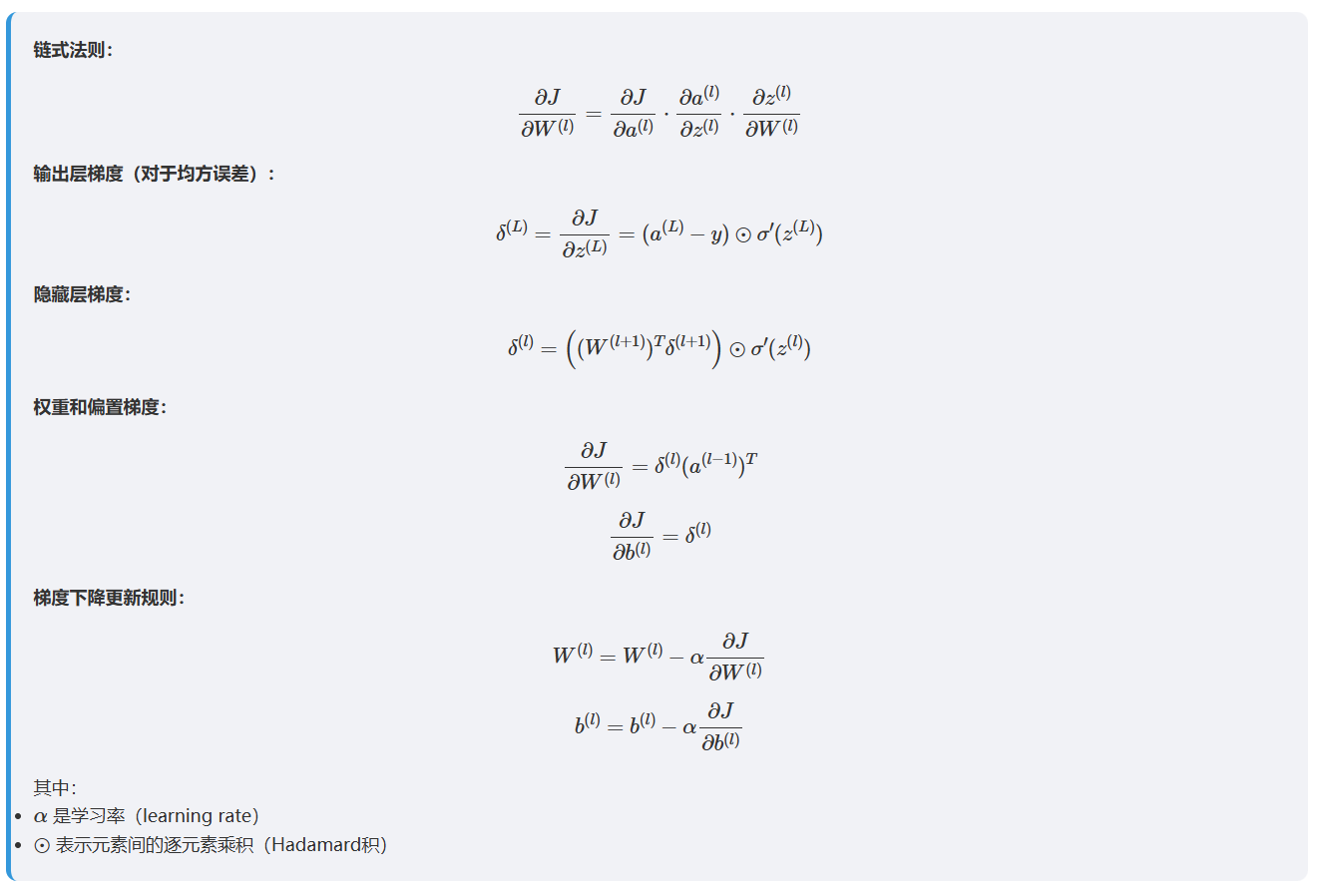

反向传播是通过计算损失函数对网络参数的梯度,然后使用这些梯度来更新权重和偏置的过程。这个过程从输出层开始,逐层向输入层传播错误信号。

(1)激活函数

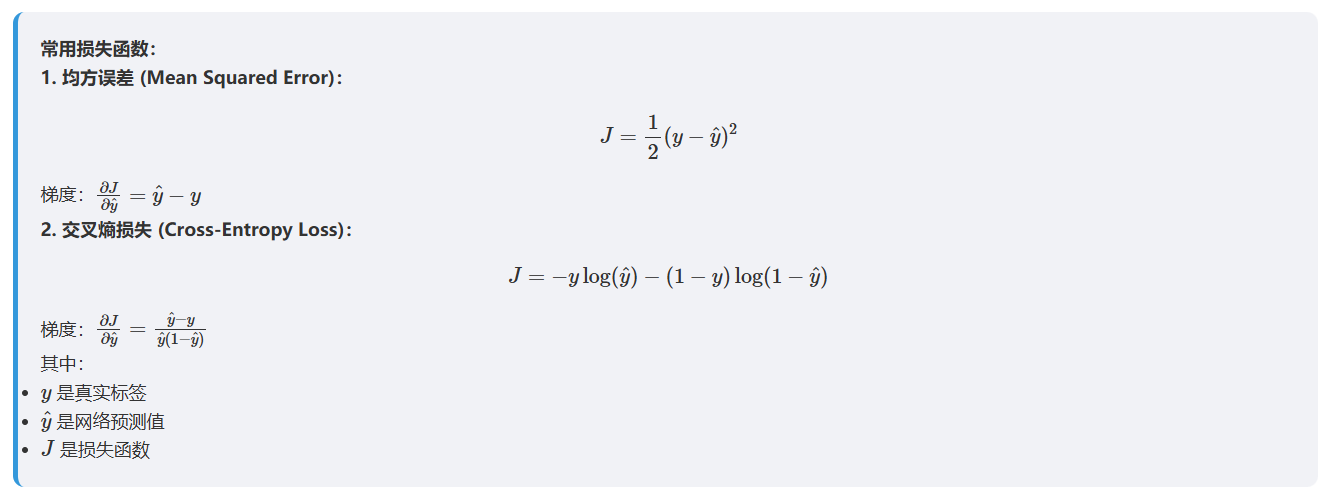

(2)梯度计算

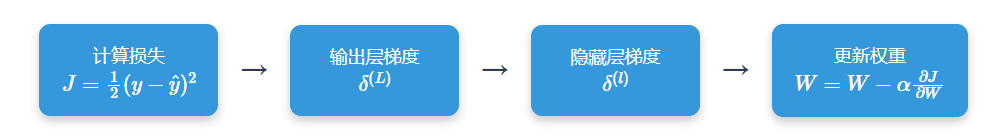

(3)计算流程

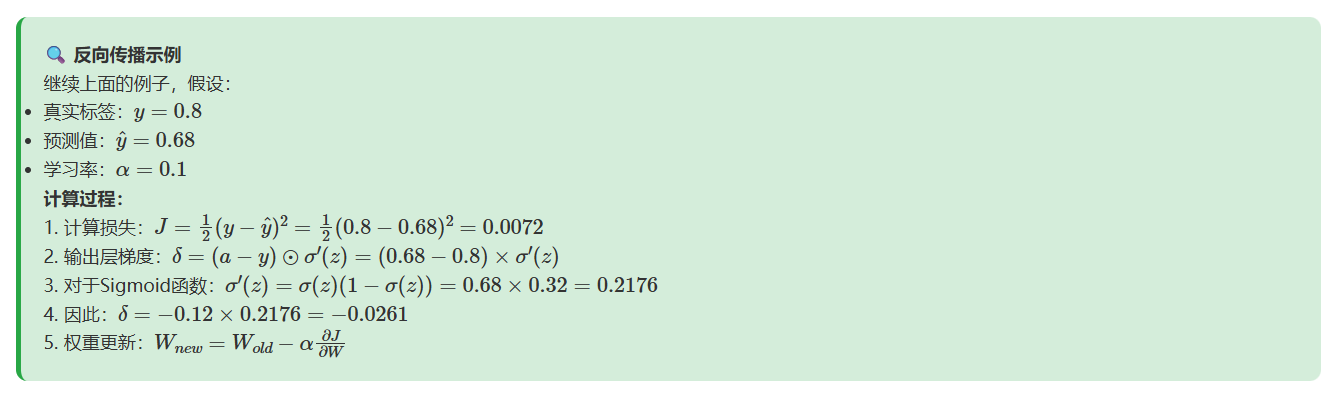

- 示例:

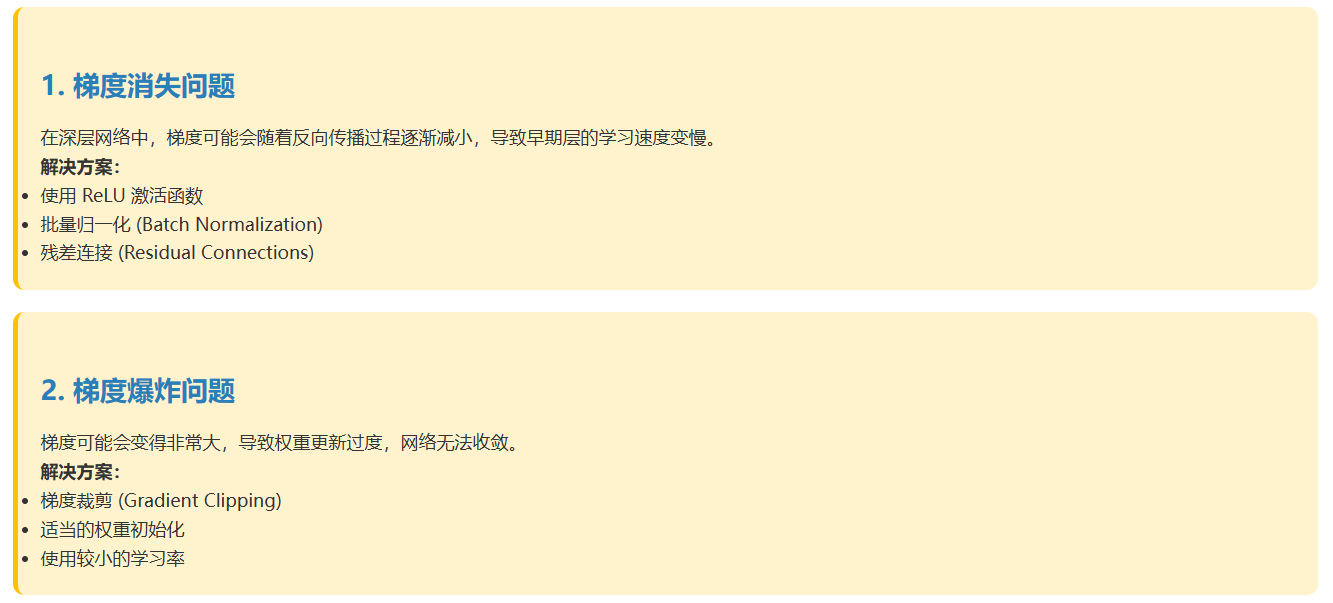

3. 梯度消失与梯度爆炸

2839

2839

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?