加州大学伯克利分校团队,让多模态大模型不再被迫将视觉信息翻译成贫瘠的文字。

人类在观察世界时,绝不会把眼前景象先在脑子里翻译成一长串文字描述,再通过文字逻辑去判断距离和方位。

我们会直接在大脑中通过视觉信号建立空间感。

这种直觉式的视觉思维,正是机器长久以来缺失的拼图。

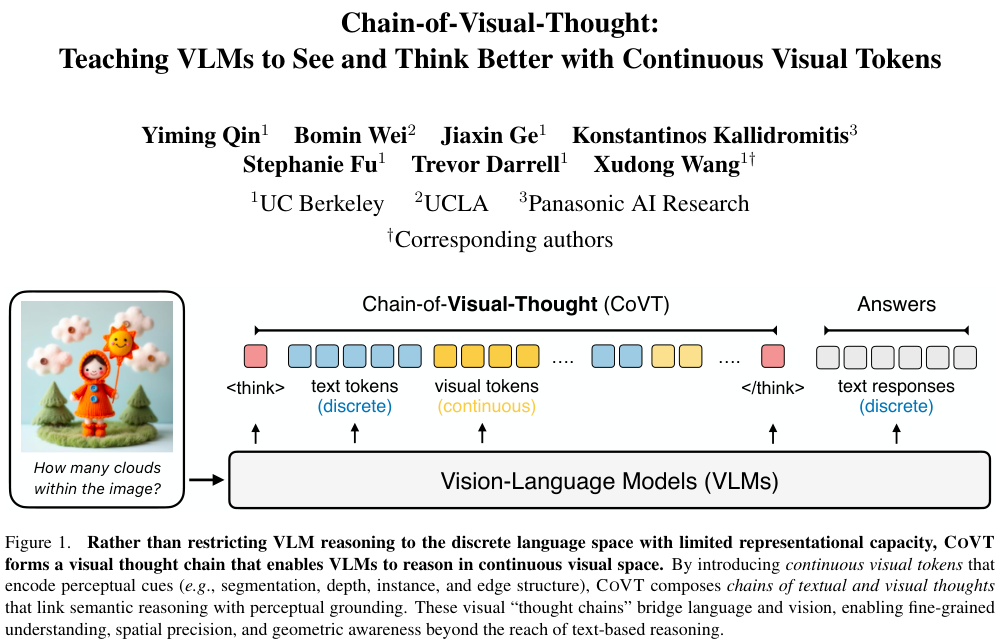

加州大学伯克利分校、加州大学洛杉矶分校(UCLA)与松下AI研究中心的团队联合提出了一种全新的架构——视觉思维链(Chain-of-Visual-Thought,简称CoVT)。

这项技术让视觉语言模型不再局限于离散的文本符号,而是在推理过程中直接生成连续的视觉信号,如同给人工智能装上了视觉想象力。

视觉翻译导致感知维度的坍缩

过去几年,视觉语言模型(VLMs)的发展路径相当明确。

研究者们试图让模型把图像看作一种特殊的语言,将视觉输入投射到文本空间中。

这种做法让模型继承了大型语言模型(LLMs)强大的逻辑推理和文本生成能力。

模型看似能看懂图了,能回答图里有什么或者这只猫在干什么。

这种机制存在一个隐蔽却致命的缺陷。

视觉信息本质上是连续的、高维的,包含着精细的几何结构、空间关系和光影变化。

而语言是离散的、符号化的,是对现实世界极度抽象的压缩。

当我们强迫模型把那把椅子在桌子左后方约30厘米处,稍微有点倾斜这种复杂的视觉状态压缩成几个文本词汇时,大量关键的感知细节就像指缝里的沙子一样流失了。

这种信息流失在处理需要精确感知的任务时尤为明显。

比如让模型数清楚图里有几只羊,或者判断两个物体谁离镜头更近。

现有的模型即便装备了最先进的视觉编码器,在进入推理阶段后,依然不得不把视觉特征翻译成文本中间量。

文本思维链(Chain-of-Thought)在数学和逻辑题上大杀四方,但面对视觉任务时,这种基于文本的推理往往不仅没有帮助,反而会因为文本描述的不准确产生幻觉,导致模型一本正经地胡说八道。

Qwen3-VL-Thinking在空间理解任务上的表现甚至不如不带思维链的版本,这就是最直接的证据。

问题的核心不在于模型看得不够清楚,而在于它想的方式不对。

人类在解决几何问题时,脑海里是在旋转图形、构建辅助线。机器也需要这种非语言的思考方式。

轻量级视觉专家内化为模型直觉

CoVT架构的诞生,正是为了打破视觉-文本的强制转换瓶颈。

它允许模型在推理过程中,除了生成文本文字,还能生成一种全新的东西——连续视觉Token(Continuous Visual Tokens)。

这些视觉Token并不是普通的乱码,它们承载着具体的视觉意义。

在不到20个Token的预算内,CoVT将原本需要庞大算力才能提取的视觉特征进行了极高效率的压缩。

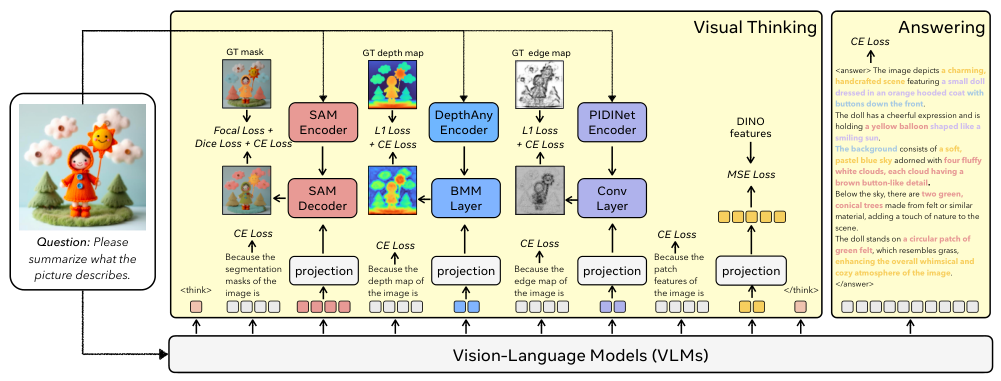

为了让这些Token具备真实的感知含义,研究团队引入了四位老师,也就是四个在特定视觉领域表现卓越的轻量级专家模型。

第一位老师是SAM(Segment Anything Model)。

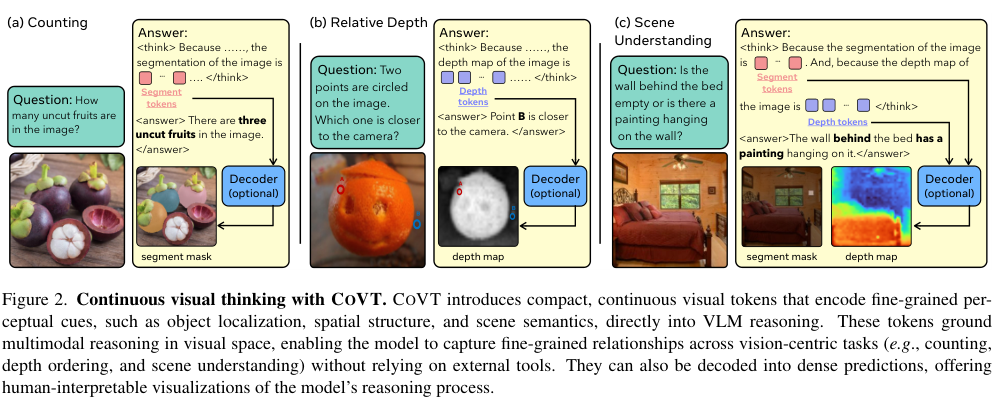

它负责教导模型如何区分物体。通过它,模型学会了生成分割Token,这不仅提供了物体的位置信息,还包含了物体的形状轮廓。

这就好比让模型在脑海里给每个物体描了一道边,它不仅知道这是猫,还知道猫的边界在哪里。

第二位老师是DepthAnything v2。

它专注于深度估计,教导模型生成深度Token。这些Token包含了像素级的距离信息。

有了它,模型就能建立起三维空间感,知道哪个物体在前,哪个在后,不再被二维图像的透视错觉所迷惑。

第三位老师是PIDINet。

它负责边缘检测,教导模型生成边缘Token。

这为模型提供了关键的几何结构细节,帮助模型理解物体的构造和纹理走向,补全了对于线条和结构的感知空白。

第四位老师是DINOv2。

它提供图像块级别的特征表示,教导模型生成DINO Token。

这不仅仅是简单的像素匹配,而是赋予模型对图像语义的深层理解,让模型能够捕捉到更抽象的视觉概念。

CoVT并不是在推理时调用这些外部模型。

调用外部工具虽然也是一种思路,但它会导致计算成本飙升,且模型的上限被工具锁死。

CoVT做的是内化。在训练阶段,模型被迫去预测这些专家模型会输出什么。

通过这种高强度的训练,模型把这些视觉专家的能力直接刻进了自己的神经网络里。

在推理时,它不需要任何外部辅助,仅凭自己的内部计算就能生成这些富含感知信息的视觉Token。

这种设计非常精妙。

它既保留了端到端模型的简洁高效,又获得了专用视觉工具的精细感知能力。

模型在回答问题之前,会先在潜在空间里生成这些视觉Token,相当于在回答有几只羊之前,先在脑海里把每只羊的位置圈出来,确认了空间关系,然后再生成最终的文本答案。

视觉思维不只是空想

让一个模型同时掌握语言和多种视觉感知能力,训练难度极大。

如果让模型随意生成视觉Token,很容易导致特征与实际图像脱节。CoVT采用了一套针对性的对齐策略,根据不同视觉专家的输出特性量体裁衣。

对于SAM、DepthAnything和PIDINet这种输出精细像素级结果的任务导向型模型,CoVT采用了Prompt级对齐。

模型生成的视觉Token被转换成一种特殊的提示符(Prompt),直接输入给对应的解码器。

这就像是模型在说:我认为这里的深度图应该是这样的,然后解码器尝试根据这个想法还原出深度图。

系统会比较还原出来的图和真实的深度图(Ground Truth)之间的差异,通过这种差异产生的损失函数(Loss)反向修正模型的思考过程。

具体到分割任务,8个分割Token被转化为SAM解码器的提示,每一个Token都要负责圈出一个潜在的掩码区域。

训练中使用了匈牙利匹配算法,确保模型预测的掩码能和真实物体一一对应。

深度任务则利用4个深度Token与编码器的特征进行矩阵交互,重构出整张深度图。

边缘任务同样利用4个Token作为卷积核来还原边缘细节。

对于DINO这种表征型模型,其输出本身就是抽象特征,因此采用了特征级对齐。

模型生成的4个DINO Token被直接映射,强迫它们在数值上尽可能接近DINOv2提取的原始特征。

这种混合对齐机制保证了每一个视觉Token都言之有物。

模型生成的每一个数据点,都对应着真实的视觉物理属性,而不是语言模型常见的胡编乱造。

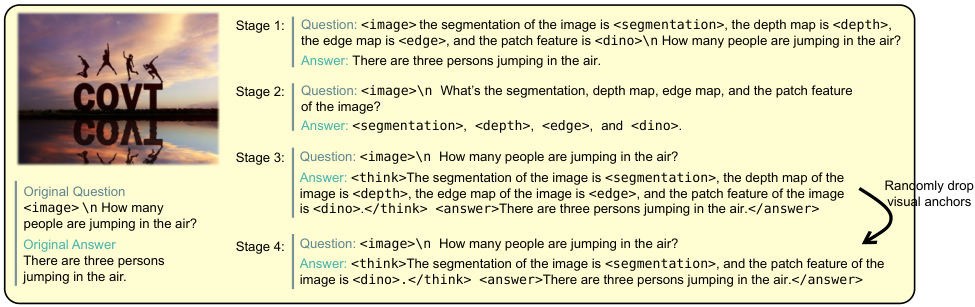

教会模型这种全新的思维方式不能一蹴而就。研究团队设计了一套循序渐进的四阶段课程表,像教小学生一样一步步引导模型。

第一阶段是理解课。

在这一步,数据中插入了视觉Token,模型只需要学会把这些Token和图像对应起来,理解这些新出现的信号代表了什么基本的语义信息。

第二阶段是生成课。

此时修改了训练数据的问答对,要求模型不仅要回答问题,还要能主动生成这些视觉Token。

这就像是让学生不仅能听懂,还得学会自己说出来,模仿老师的笔迹去描绘视觉特征。

第三阶段是推理课。

这是质变的一步。引入了视觉思维链格式,模型被要求在 <think> 标签内使用视觉Token进行推理,并必须依据这些视觉线索推导出最终答案。

这一步强迫模型建立因果联系:因为我看到了这个深度的变化,所以我判断它是圆柱体。

第四阶段是高效推理课。

为了防止模型产生依赖或者死记硬背固定的输出模式,训练中会随机丢弃部分类型的视觉Token。

这迫使模型在信息不全的情况下,也要学会利用仅有的视觉线索进行推理。这种特种兵式的训练极大地增强了模型的鲁棒性和灵活性。

思维升维带来的全方位碾压

CoVT的效果并非停留在理论层面,实验数据给出了最具说服力的证明。

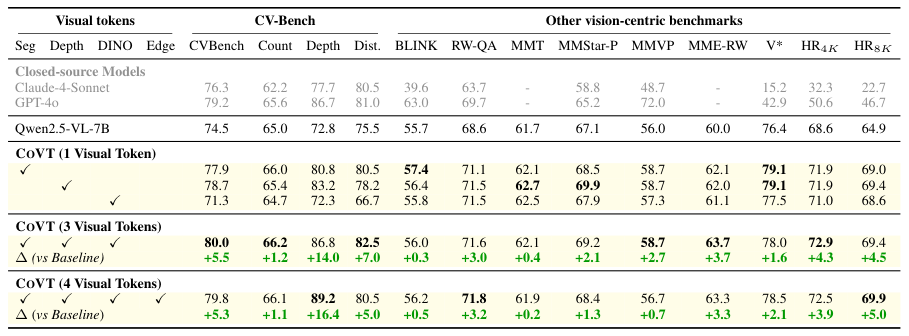

研究团队基于Qwen2.5-VL-7B这个强大的基线模型进行了改造,并在十几个严苛的基准测试中进行了验证。

在CV-Bench这个专注于视觉感知的基准测试中,CoVT的表现令人瞩目。

集成了所有视觉Token后,模型的整体得分提升了5.3%。

最惊人的是在深度这个子任务上,得分直接暴涨了16.4%。这直接证明了引入深度Token后,模型对于三维空间的理解不再是基于二维图像的猜测,而是有了实打实的感知依据。

在Counting(计数)和Distance(距离判断)这些传统VLM的老大难问题上,CoVT同样展现出了统治力。

它不仅击败了原始的Qwen2.5-VL,甚至在多项指标上超越了闭源的行业顶流Claude-4-Sonnet和GPT-4o。

一个7B参数量的模型,凭借更先进的思维架构,在感知精度上能够叫板甚至超越万亿参数的巨头,这本身就说明了架构创新的价值。

这种提升不仅仅局限于视觉任务。

人们担心引入这么多视觉信号会不会干扰模型原本的语言能力。

结果显示,在OCRBench、MME-translate等纯文本或通用多模态任务上,CoVT的性能不仅没有下降,反而有平均1.2%的微弱提升。

这意味着视觉思维的加入,让模型变得更聪明、更全面了,而不是顾此失彼。

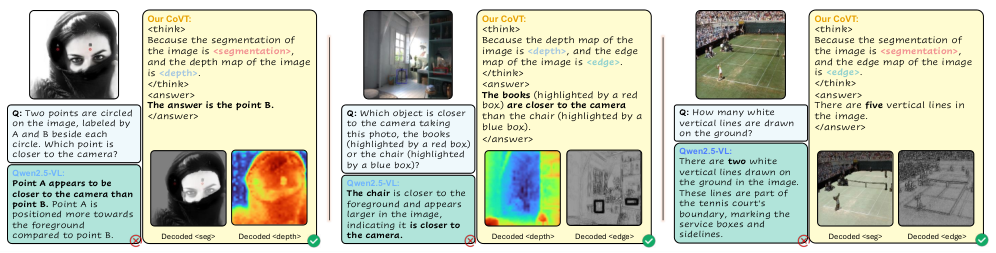

AI领域一直存在黑盒问题,我们不知道模型为什么给出这个答案。

CoVT提供了一个绝佳的观察窗口。

因为所有的视觉Token都可以被解码器还原成人类能看懂的图像,我们终于可以直接看到模型在想什么。

在一个判断远近的案例中,问题是A点和B点谁离相机更近。

原始模型可能会根据经验瞎猜。

而查看CoVT解码出来的深度图,我们可以清晰地看到,代表B点的人脸区域被模型赋予了表示更近的色块,而背景A点则是表示更远的颜色。

模型正是基于这张它自己在脑海里画出来的深度图,做出了正确判断。

在另一个数网球场白线的任务中,解码出来的分割掩码精准地覆盖了地上的白线。

这说明模型是真的看到并圈出了这些线,然后才报出的数字,而不是根据文本概率瞎蒙了一个数字。

这种可解释性对于医疗、自动驾驶等高风险领域具有不可估量的价值,它建立了人与AI之间信任的桥梁。

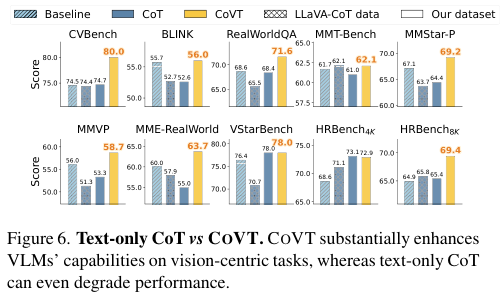

研究中还有一个极具启发性的发现。

团队专门对比了纯文本思维链和视觉思维链的效果。

结果显示,在视觉感知任务上,强迫模型用纯文本进行长篇大论的推理,效果往往适得其反。

在CV-Bench和BLINK等测试中,使用纯文本CoT的性能经常不如直接回答,甚至出现了显著的倒退。

这是因为语言在描述复杂的空间几何关系时是非常低效且容易产生歧义的。

让模型用语言去描述一个复杂的螺旋结构,远不如直接让它生成一个螺旋的视觉特征来得准确。文本推理的累积误差会导致模型在逻辑的迷宫里越走越偏。

这揭示了一个深刻的道理:智能的形式不应局限于语言。

人类的思维是多模态的,我们有图像思维、声音思维、逻辑思维。

让AI回归到所见即所得的直觉式感知,结合语言的逻辑推理,才是通往更高级通用智能的正确道路。

参考资料:

https://arxiv.org/abs/2511.19418

https://github.com/Wakals/CoVT

END

视觉思维链赋能多模态AI

视觉思维链赋能多模态AI

1474

1474

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?