学习来源:https://github.com/datawhalechina/team-learning/tree/master/%E6%9C%BA%E5%99%A8%E5%AD%A6%E4%B9%A0%E7%AE%97%E6%B3%95%E5%9F%BA%E7%A1%80

https://github.com/datawhalechina/team-learning/blob/master/机器学习算法基础/Task1%20Linear_regression.ipynb

主要内容:

- 模型建立:线性回归原理、线性回归模型

- 学习策略:线性回归损失函数、代价函数、目标函数

- 算法求解:梯度下降法、牛顿法、拟牛顿法等

- 线性回归的评估指标

- sklearn参数详解

练习部分

- 基于线性回归的房价预测问题

- 利用sklearn解决回归问题

- sklearn.linear_model.LinearRegression

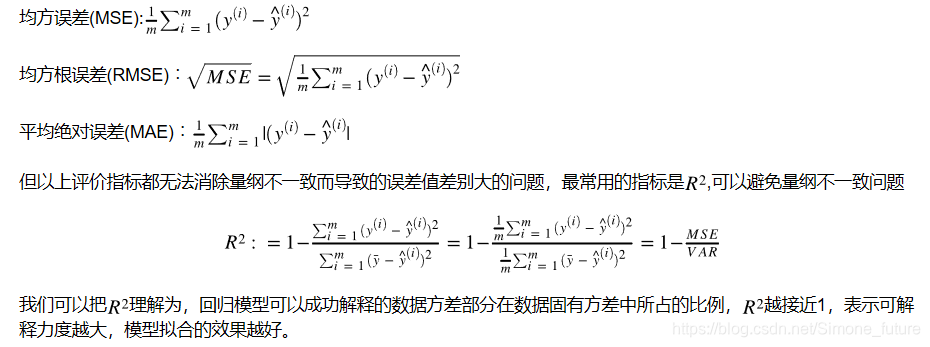

线性回归的评价指标:

sklearn.linear_model参数详解:

fit_intercept : 默认为True,是否计算该模型的截距。如果使用中心化的数据,可以考虑设置为False,不考虑截距。注意这里是考虑,一般还是要考虑截距

normalize: 默认为false. 当fit_intercept设置为false的时候,这个参数会被自动忽略。如果为True,回归器会标准化输入参数:减去平均值,并且除以相应的二范数。当然啦,在这里还是建议将标准化的工作放在训练模型之前。通过设置sklearn.preprocessing.StandardScaler来实现,而在此处设置为false

copy_X : 默认为True, 否则X会被改写、n_jobs: int 默认为1. 当-1时默认使用全部CPUs ??(这个参数有待尝试)

可用属性:

coef_:训练后的输入端模型系数,如果label有两个,即y值有两列。那么是一个2D的arrayintercept_: 截距

可用的methods:

fit(X,y,sample_weight=None): X: array, 稀疏矩阵 [n_samples,n_features] y: array [n_samples, n_targets] sample_weight: 权重 array [n_samples] 在版本0.17后添加了sample_weight

get_params(deep=True): 返回对regressor 的设置值

predict(X): 预测 基于 R^2值

score: 评估

参考https://blog.youkuaiyun.com/weixin_39175124/article/details/79465558

练习完成代码如下:

#生成数据

import numpy as np

#生成随机数

np.random.seed(1234)

x = np.random.rand(500,3)

#构建映射关系,模拟真实的数据待预测值,映射关系为y = 4.2 + 5.7*x1 + 10.8*x2,可自行设置值进行尝试

y = x.dot(np.array([4.2,5.7,10.8]))

#1、先尝试调用sklearn的线性回归模型训练数据

import numpy as np

from sklearn.linear_model import LinearRegression

import matplotlib.pyplot as plt

%matplotlib inline

# 调用模型

lr = LinearRegression(fit_intercept=True)

# 训练模型

lr.fit(x,y)

print("估计的参数值为:%s" %(lr.coef_))

# 计算R平方

print('R2:%s' %(lr.score(x,y)))

# 任意设定变量,预测目标值

x_test = np.array([2,4,5]).reshape(1,-1)

y_hat = lr.predict(x_test)

print("预测值为: %s" %(y_hat))

# 调用模型

lr = LinearRegression(fit_intercept=True)

# 训练模型

lr.fit(x,y)

print("估计的参数值为:%s" %(lr.coef_))

# 计算R平方

print('R2:%s' %(lr.score(x,y)))

# 任意设定变量,预测目标值

x_test = np.array([2,4,5]).reshape(1,-1)

y_hat = lr.predict(x_test)

print("预测值为: %s" %(y_hat))

#2、最小二乘法的矩阵求解

class LR_LS():

def __init__(self):

self.w = None

def fit(self, X, y):

# 最小二乘法矩阵求解

#============================= show me your code =======================

self.w = np.linalg.inv(X.T.dot(X)).dot(X.T).dot(y)

#============================= show me your code =======================

def predict(self, X):

# 用已经拟合的参数值预测新自变量

#============================= show me your code =======================

y_pred = X.dot(self.w)

#============================= show me your code =======================

return y_pred

if __name__ == "__main__":

lr_ls = LR_LS()

lr_ls.fit(x,y)

print("估计的参数值:%s" %(lr_ls.w))

x_test = np.array([2,4,5]).reshape(1,-1)

print("预测值为: %s" %(lr_ls.predict(x_test)))

#3、梯度下降法

class LR_GD():

def __init__(self):

self.w = None

def fit(self,X,y,alpha=0.02,loss = 1e-10): # 设定步长为0.002,判断是否收敛的条件为1e-10

y = y.reshape(-1,1) #重塑y值的维度以便矩阵运算

[m,d] = np.shape(X) #自变量的维度

self.w = np.zeros((d)) #将参数的初始值定为0

tol = 1e5

#============================= show me your code =======================

while tol > loss:

h_f = X.dot(self.w).reshape(-1,1)

theta = self.w + alpha*np.mean(X*(y - h_f),axis=0) #计算迭代的参数值

tol = np.sum(np.abs(theta - self.w))

self.w = theta

#============================= show me your code =======================

def predict(self, X):

# 用已经拟合的参数值预测新自变量

y_pred = X.dot(self.w)

return y_pred

if __name__ == "__main__":

lr_gd = LR_GD()

lr_gd.fit(x,y)

print("估计的参数值为:%s" %(lr_gd.w))

x_test = np.array([2,4,5]).reshape(1,-1)

print("预测值为:%s" %(lr_gd.predict(x_test)))参考吴恩达 CS229课程

周志华 《机器学习》

李航 《统计学习方法》https://hangzhou.anjuke.com/

https://www.jianshu.com/p/e0eb4f4ccf3e

https://blog.youkuaiyun.com/qq_28448117/article/details/79199835https://blog.youkuaiyun.com/weixin_39175124/article/details/79465558

本文介绍了线性回归的基本原理,包括模型建立、学习策略、算法求解方法如梯度下降、牛顿法和拟牛顿法。讨论了线性回归的评估指标,如sklearn.linear_model.LinearRegression模型的参数解释。此外,文章还提供了线性回归在房价预测问题上的应用实例,强调了预处理数据的重要性,并给出了相关学习资源。

本文介绍了线性回归的基本原理,包括模型建立、学习策略、算法求解方法如梯度下降、牛顿法和拟牛顿法。讨论了线性回归的评估指标,如sklearn.linear_model.LinearRegression模型的参数解释。此外,文章还提供了线性回归在房价预测问题上的应用实例,强调了预处理数据的重要性,并给出了相关学习资源。

471

471

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?