逐步回归是多元线性回归中常用的自变量筛选方法,在SPSSAU(在线SPSS)平台中提供了三种主要的筛选方式。下面我将详细介绍这三种方法及其适用场景。

1. 向前法(Forward Selection)

方法特点

- 只进不出:自变量逐个引入回归方程,一旦进入就不会被剔除

- 筛选过程:

- 先对每个自变量单独做线性回归

- 按重要性依次逐个引入有显著性的自变量

- 不对已引入的自变量做显著性检验

- 直到没有自变量被引入为止

适用场景

- 当自变量数量较少时

- 研究者希望尽可能多地保留自变量时

- 初步探索性分析阶段

2. 向后法(Backward Elimination)

方法特点

- 先全后减:先将所有自变量引入模型,然后逐步剔除

- 筛选过程:

- 将所有自变量一次性引入建立多重线性回归方程

- 按重要性逐个剔除无显著性意义的自变量

- 每剔除一个自变量后重新建立回归方程

- 直到回归方程中的自变量都不能被剔除为止

适用场景

- 当自变量数量适中时

- 研究者希望尽可能保留分析项在模型中

- 已有理论基础支持大部分自变量可能相关时

3. 逐步法(Stepwise)

方法特点

- 双向筛选:结合向前法和向后法的优点

- 筛选过程:

- 先按向前法引入自变量

- 每引入一个自变量后,对当前模型所有自变量做显著性检验

- 已进入模型的自变量如果变得无显著性则剔除

- 确保每次引入新自变量前回归方程中都是有显著意义的自变量

- 直到没有自变量可以被引入或剔除为止

适用场景

- 最常用的方法,适用于大多数情况

- 当自变量数量较多且关系复杂时

- 需要平衡模型简洁性和预测能力时

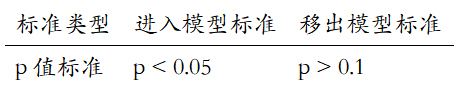

SPSSAU(网页SPSS)中的实现标准

在SPSSAU平台进行逐步回归时,使用以下标准:

注意:SPSSAU默认使用p值标准(与IBM SPSS保持一致),2022年3月17日更新后从F值标准改为p值标准。

方法选择建议

- 逐步法是最常用的方法,能克服向前法和向后法的一些缺陷

- 三种方法的选择没有严格规定,应结合专业理论判断

- 不能完全依赖统计方法进行自变量筛选,专业判断同样重要

- 在SPSSAU中操作时,可通过【进阶方法】→【逐步回归】功能模块实现

实例应用

例如在研究工资影响因素时,可以将"Ln_工资"作为因变量(Y),其他如年龄、教育年限等作为自变量(X),在SPSSAU中选择【逐步法】进行分析,同时可勾选【保存残差和预测值】选项。

通过理解这三种方法的差异,研究者可以更科学地选择适合自己数据的自变量筛选方式,建立更优的回归模型。

3805

3805

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?