Service Mesh云原生演进:Java应用零侵入接入腾讯TSF全解析

在微服务架构普及的今天,Java应用作为企业级系统的核心载体,其治理能力直接决定了系统的稳定性与可扩展性。传统的微服务治理方案依赖SDK接入(如Spring Cloud原生组件、TSF SDK等),虽然能实现流量管控、熔断降级等核心能力,但也带来了诸多痛点:遗留Java系统(如Spring 3.x、非Spring体系应用)改造成本高、SDK版本与应用框架兼容问题、代码侵入导致业务与治理逻辑耦合、多语言应用治理标准不统一等。

Service Mesh(服务网格)作为云原生时代的微服务治理范式,以“Sidecar代理+控制面”的架构实现了应用与治理逻辑的解耦,成为解决上述痛点的最优解。腾讯微服务框架TSF(Tencent Service Framework)基于Service Mesh理念推出了TSF Mesh方案,支持Java应用零代码改造接入微服务治理体系。

本文将从架构原理、接入方案、流量治理特性、性能优化、生产案例到实战落地,全面解析TSF Mesh如何实现Java应用的零侵入治理,帮助开发者掌握从SDK模式向Mesh模式迁移的全流程。

一、Service Mesh架构原理与TSF Mesh实现

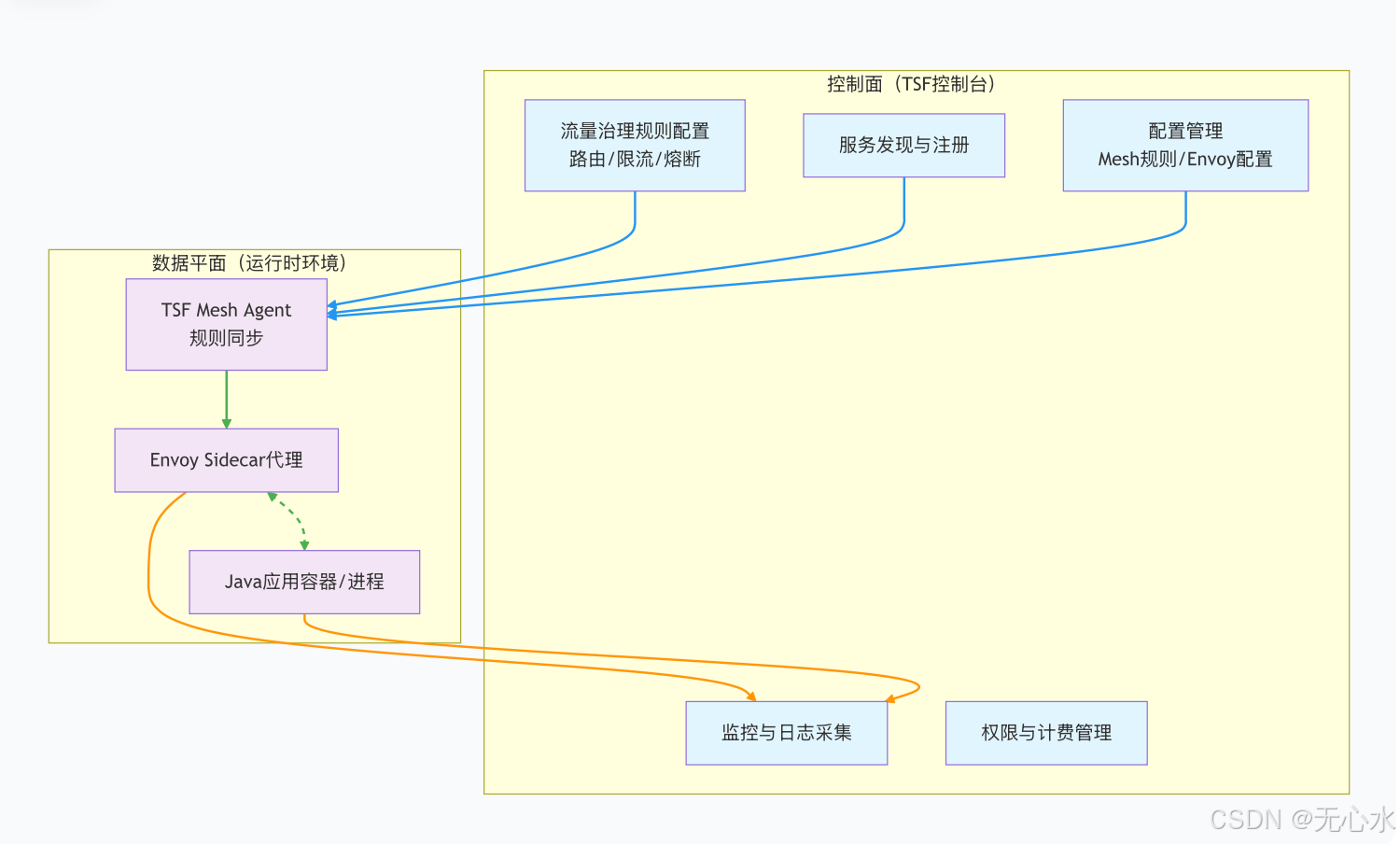

Service Mesh的核心是将原本嵌入应用内部的治理逻辑(流量路由、熔断、监控、安全等)抽离到独立的Sidecar代理进程中,实现“应用只管业务,治理交给网格”。TSF Mesh基于Envoy代理构建数据平面,结合TSF控制台作为控制面,形成了适配企业级场景的Service Mesh解决方案。

1.1 Sidecar模式:Envoy代理流量拦截机制

Sidecar(边车)是与应用容器部署在同一Pod(K8s环境)或同一主机(虚拟机环境)的代理进程,TSF Mesh采用Envoy作为默认Sidecar代理,其核心能力是全接管应用的进出网络流量,且无需应用感知。

Envoy的流量拦截分为“入站流量”和“出站流量”两个维度,其底层依赖Linux的iptables/IPVS技术实现透明代理,具体流程如下:

如上图所示,所有指向Java应用的入站流量会被iptables拦截并转发到Envoy Sidecar,Sidecar先执行控制面下发的治理规则(如路由、限流、熔断),再将流量转发给应用进程;应用的出站流量(如调用其他服务)也会被拦截,经Sidecar处理后再发送到目标地址。整个过程中,Java应用无需修改任何代码,也无需感知Sidecar的存在。

Envoy的流量拦截具备以下特点:

- 透明化:基于网络层拦截,应用无需配置代理地址;

- 全协议支持:兼容HTTP/1.1、HTTP/2、gRPC、TCP等主流协议;

- 高性能:基于C++开发,内存占用低,转发延迟毫秒级;

- 可扩展:支持自定义过滤器(Filter)扩展治理能力。

1.2 数据平面(Sidecar)vs 控制面(TSF控制台):Java应用的无感知治理

Service Mesh的架构分为“数据平面”和“控制面”两层,TSF Mesh的分层架构如下:

控制面(TSF控制台):作为Mesh的“大脑”,负责治理规则的配置、服务发现、配置下发、监控数据聚合等核心能力。开发者通过TSF控制台可视化配置流量路由、熔断降级、故障注入等规则,控制面将规则转化为Envoy可识别的配置,并通过TSF Mesh Agent同步到数据平面的Sidecar中。

数据平面:由Java应用、Envoy Sidecar、TSF Mesh Agent组成,核心职责是执行控制面下发的规则,处理实际的网络流量:

- Envoy Sidecar:流量转发与治理规则执行的核心载体,接管应用所有进出流量;

- TSF Mesh Agent:部署在每个节点/Pod上的轻量级进程,负责同步控制面的规则到Envoy,同时采集Sidecar和应用的监控数据上报到控制面;

- Java应用:纯业务逻辑载体,无需集成任何治理SDK,仅需正常提供/调用服务即可。

对比传统的SDK模式,Mesh模式下Java应用的“无感知”体现在:

| 维度 | SDK模式 | TSF Mesh模式 |

|---|---|---|

| 代码侵入 | 需集成TSF SDK,修改pom.xml/配置文件 | 零代码修改,仅需部署Sidecar |

| 框架依赖 | 需兼容SDK版本(如Spring Cloud版本) | 无框架依赖,支持所有Java应用(包括非Spring体系) |

| 治理逻辑执行 | 应用进程内执行(占用应用资源) | Sidecar进程独立执行(与应用资源隔离) |

| 多语言支持 | 仅支持Java(SDK限定) | 支持Java、Go、C++等多语言(Sidecar无语言依赖) |

| 规则生效 | 需重启应用(部分规则) | 热更新,无需重启应用 |

1.3 TSF Mesh与Istio的差异:企业级增强功能

Istio是开源Service Mesh的标杆,但面向企业级生产环境时,仍存在权限管控、计费、本土化技术支持等短板。TSF Mesh基于Istio的核心理念进行了企业级增强,更适配国内企业的使用场景,核心差异如下:

| 特性 | Istio(开源) | TSF Mesh |

|---|---|---|

| 权限集成 | 基础RBAC,无企业级权限体系 | 深度集成腾讯云CAM权限体系,支持细粒度角色管控(如命名空间/服务级权限) |

| 计费能力 | 无原生计费功能 | 支持按Sidecar实例数、流量大小等维度计费,适配企业私有化部署的成本核算 |

| 技术支持 | 社区支持,响应慢 | 腾讯官方7×24小时技术支持,适配国内云环境(VPC、CLB等) |

| 与腾讯云生态集成 | 弱集成 | 深度集成CVM、TKE、CLS、APM等腾讯云产品,一站式监控/日志/运维 |

| 国产化适配 | 无针对性适配 | 支持国产化操作系统(麒麟、统信)、国产化芯片(鲲鹏、飞腾) |

| 易用性 | 配置复杂(需编写YAML) | 可视化控制台配置,无需编写YAML,降低学习成本 |

| 遗留系统适配 | 对老版本Java应用支持有限 | 专门优化Spring 3.x、JDK 6/7等遗留Java系统的适配 |

二、Java应用零侵入接入Mesh

TSF Mesh为Java应用提供了多种接入模式,适配不同的业务场景(如遗留系统、已接入SDK的系统、需要渐进式迁移的系统),核心目标是“零侵入”,即最小化应用改造成本。

2.1 无SDK模式:纯Sidecar接管网络通信(遗留Java系统首选)

无SDK模式是TSF Mesh最核心的接入模式,适用于无法修改代码的遗留Java系统(如Spring 3.x单体应用、非Spring体系的Java应用、JDK 6/7老应用),其核心逻辑是:仅通过部署Sidecar代理,完全接管应用的网络通信,实现所有治理能力。

无SDK模式的接入条件:

- 应用部署环境:支持K8s(TKE)、虚拟机(CVM)、容器服务等TSF支持的运行时环境;

- 网络要求:应用的进出流量未被自定义iptables规则拦截(TSF会自动注入标准拦截规则);

- 端口要求:应用监听的端口需在TSF控制台注册(便于Sidecar识别并拦截)。

无SDK模式的接入流程:

无SDK模式的核心优势:

- 零代码修改:无需修改应用代码、pom.xml、配置文件,仅需调整部署方式;

- 无框架依赖:支持所有Java应用,无论是否基于Spring/Struts/HttpServlet等框架;

- 资源隔离:治理逻辑在Sidecar进程中执行,不占用应用的CPU/内存资源;

- 规则热更新:治理规则修改后无需重启应用,实时生效。

2.2 混合模式:Java应用保留部分TSF SDK(本地配置+控制台规则协同)

混合模式适用于已接入TSF SDK的Java应用(如Spring Cloud应用),希望渐进式迁移到Mesh模式,其核心逻辑是:保留应用中的部分TSF SDK能力(如本地配置读取、服务注册发现),同时部署Sidecar代理接管流量治理,实现“本地配置+控制台规则”的协同。

混合模式的适用场景:

- 应用依赖TSF SDK的配置中心能力(如本地读取配置,不希望立即迁移);

- 应用需要同时兼容SDK模式和Mesh模式(灰度迁移阶段);

- 部分治理规则希望在应用本地生效(如本地熔断),部分在Sidecar层生效(如全局路由)。

混合模式的核心逻辑:

- SDK负责:服务注册发现(可选)、本地配置读取、应用级监控上报;

- Sidecar负责:流量转发、全局路由、限流、熔断、故障注入等核心治理能力;

- 规则优先级:控制台配置的Mesh规则 > SDK配置的本地规则(确保全局规则统一)。

混合模式的接入注意事项:

- 需确保SDK版本与TSF Mesh版本兼容(TSF控制台会提示兼容版本);

- 关闭SDK中的流量治理能力(如SDK层的熔断、限流),避免与Sidecar规则冲突;

- 监控数据会同时从SDK和Sidecar上报,需在控制台统一聚合展示。

2.3 迁移路径:从SDK到Mesh的渐进式方案(先混合,再移除SDK)

对于已大规模接入TSF SDK的Java应用集群,直接切换到无SDK模式风险较高,TSF Mesh提供了“渐进式迁移”路径,核心步骤如下:

渐进式迁移的关键节点:

- 灰度验证:先选择非核心应用进行混合模式部署,验证流量接管、规则生效、性能影响等;

- 规则统一:将SDK中的本地治理规则(如限流、熔断)迁移到TSF控制台,确保全局规则统一;

- 监控对齐:确保Sidecar上报的监控数据(流量、延迟、错误率)与SDK上报的数据一致;

- 回滚机制:迁移过程中保留SDK的回滚能力,若Mesh模式出现问题,可快速切回SDK模式。

迁移过程中的常见问题及解决方案:

| 问题 | 解决方案 |

|---|---|

| SDK与Sidecar规则冲突 | 优先关闭SDK层治理规则,仅保留控制台Mesh规则 |

| 服务发现异常 | 统一使用TSF控制面的服务发现能力,关闭SDK本地服务发现 |

| 监控数据不一致 | 暂时保留双端上报,待对齐后关闭SDK上报 |

| 性能波动 | 优化Sidecar资源配置(如CPU/内存预留),调整Envoy日志级别 |

三、Mesh下的流量治理新特性

TSF Mesh基于Sidecar代理,提供了比传统SDK模式更丰富的流量治理能力,且所有能力均无需修改Java应用代码,核心新特性包括流量镜像、故障注入、Sidecar层熔断降级等。

3.1 流量镜像(Traffic Mirroring):生产流量复制到测试环境

流量镜像(也称为流量影子、流量拷贝)是指将生产环境的真实流量复制一份,转发到测试/预发环境,用于无感知验证新功能、回归测试等场景,避免直接修改生产流量导致的风险。

TSF Mesh的流量镜像原理:

流量镜像的核心特点:

- 无侵入:无需修改生产应用代码,仅需在控制台配置镜像规则;

- 低风险:镜像流量异步转发,不阻塞主流量,不影响生产业务响应;

- 灵活配置:支持按比例镜像(如10%、50%、100%)、按请求路径/Header镜像(如仅镜像/api/*路径的流量);

- 全量数据:镜像流量包含完整的请求参数、Header、Body,与生产流量一致。

TSF Mesh中流量镜像的配置步骤:

- 在TSF控制台进入“流量治理”→“流量镜像”模块;

- 选择目标服务(生产环境),配置镜像规则:

- 镜像比例:如10%(仅复制10%的生产流量);

- 目标地址:测试环境服务的地址(支持TSF服务名或IP:端口);

- 过滤条件:可选,如请求路径包含/api/order、Header中包含X-Test=1;

- 发布规则,规则实时同步到Sidecar;

- 在测试环境查看镜像流量的请求日志,验证新功能是否正常。

流量镜像的典型使用场景:

- 新功能上线前验证:将生产流量镜像到部署了新功能的测试环境,验证功能正确性;

- 性能回归测试:用生产真实流量压测测试环境,验证性能是否符合预期;

- 故障定位:复制异常生产流量到测试环境,复现问题并定位;

- 数据一致性验证:验证测试环境数据处理逻辑与生产环境一致。

3.2 故障注入:延迟注入(模拟网络延迟)、错误码注入(混沌工程实践)

故障注入是混沌工程的核心手段,指在不影响真实业务的前提下,人为注入故障(如网络延迟、错误码、超时),验证系统的容错能力。TSF Mesh在Sidecar层实现故障注入,无需修改Java应用代码,可精准控制故障范围和强度。

TSF Mesh支持两种核心故障注入类型:

(1)延迟注入:模拟网络延迟/服务响应延迟

延迟注入原理:在Sidecar转发请求时,人为增加指定时长的延迟,模拟网络波动、服务响应慢等场景。

延迟注入的配置参数:

- 延迟时长:如50ms、100ms、500ms(支持毫秒级配置);

- 注入比例:如10%(仅10%的请求注入延迟);

- 过滤条件:按请求路径、Header、客户端IP等过滤(如仅对/api/pay路径注入延迟);

- 生效范围:支持按服务、实例、命名空间维度生效。

(2)错误码注入:模拟服务返回错误码/超时

错误码注入原理:Sidecar在转发请求时,直接返回指定的HTTP错误码(如500、503、404),无需转发到应用,模拟服务异常、接口报错等场景。

错误码注入的配置参数:

- 错误码:支持HTTP 4xx/5xx系列错误码(如400、403、500、503);

- 注入比例:如50%(50%的请求返回错误码);

- 错误信息:可选,自定义返回的错误Body;

- 生效时长:可选,如仅在压测期间生效1小时。

故障注入的典型使用场景:

- 熔断降级验证:注入503错误码,验证Sidecar层的熔断规则是否触发;

- 容灾演练:注入网络延迟,验证系统在高延迟场景下的响应能力;

- 限流验证:注入高并发流量+延迟,验证限流规则是否生效;

- 多活架构验证:注入某区域服务的错误码,验证流量是否自动切换到备用区域。

3.3 熔断降级:在Sidecar层实现(Java代码无需修改,全局统一配置)

传统的熔断降级(如Hystrix、Sentinel)需要在Java应用中集成SDK,编写熔断逻辑,而TSF Mesh在Sidecar层实现熔断降级,所有规则通过控制台配置,全局统一生效,无需修改应用代码。

TSF Mesh熔断降级的原理:

TSF Mesh熔断降级的核心配置参数:

- 熔断触发阈值:如错误率>50%、连续错误数>10次、平均响应时间>500ms;

- 熔断时长:如30秒(熔断打开后,30秒内拒绝所有请求);

- 半开状态放行比例:如10%(半开状态下,仅放行10%的请求验证恢复情况);

- 降级响应:自定义返回的错误码/Body(如返回503 + {“msg”:“服务熔断,请稍后重试”});

- 生效范围:按服务、实例、请求路径维度配置(如仅对/api/order路径熔断)。

Sidecar层熔断的优势:

- 零代码侵入:无需在Java应用中编写熔断逻辑,控制台配置即可生效;

- 全局统一:所有应用的熔断规则在控制台统一管理,避免规则碎片化;

- 快速生效:熔断状态由Sidecar实时计算,响应速度比应用内熔断更快;

- 资源隔离:熔断逻辑在Sidecar中执行,不占用应用资源,即使应用卡死,Sidecar仍可触发熔断。

四、性能影响评估与优化

Sidecar代理的引入必然会对系统性能产生一定影响,TSF Mesh通过大量的基线测试和优化手段,将性能影响控制在可接受范围内,本节将详细分析Sidecar的资源占用、网络延迟影响,并给出针对性的优化方案。

4.1 Sidecar资源占用:CPU/Memory基线测试

TSF Mesh使用的Envoy Sidecar是轻量级代理,但仍需预留一定的资源,避免与Java应用争抢资源导致性能问题。基于腾讯云官方的基线测试数据,单Sidecar的资源占用如下:

| 资源类型 | 基线值(空闲状态) | 高负载状态(1000QPS) | 建议预留值 |

|---|---|---|---|

| CPU | 0.05核(50m) | 0.3-0.4核 | 0.5核 |

| 内存 | 100-200MB | 300-400MB | 500MB |

| 磁盘 | 100MB(日志/配置) | 200MB | 500MB |

资源预留的建议:

- K8s环境:在Deployment/YAML中为Sidecar设置resources.requests(0.5核/500MB)和resources.limits(1核/1GB),避免Sidecar占用过多资源;

- 虚拟机环境:为Sidecar进程设置CPU亲和性,避免与Java应用抢占核心;

- 集群维度:按应用实例数预留Sidecar总资源(如100个应用实例,需预留50核/50GB内存)。

4.2 网络延迟增加:Sidecar代理的RT影响

Sidecar作为流量转发的中间层,会增加一定的网络延迟(RT),但通过优化(如HTTP/2、连接复用),可将延迟控制在极低水平。

TSF Mesh的延迟测试数据(基于HTTP/1.1 vs HTTP/2):

| 场景 | 无Sidecar(直连) | Sidecar(HTTP/1.1) | Sidecar(HTTP/2) | 优化后(HTTP/2+连接复用) |

|---|---|---|---|---|

| 单次请求延迟 | 1-2ms | 2-4ms | 1.5-2.5ms | 1ms以内 |

| 1000QPS平均延迟 | 1.5ms | 3ms | 2ms | 1.2ms |

| 峰值(5000QPS)延迟 | 3ms | 5ms | 3ms | 2ms |

延迟增加的核心原因:

- 流量转发:Sidecar需要接收请求、解析协议、转发到应用,增加了一次网络跳转;

- 规则执行:Sidecar需要执行路由、限流、熔断等规则,增加了少量计算开销;

- 协议转换:若客户端与Sidecar、Sidecar与应用使用不同协议(如HTTP/1.1→HTTP/2),会增加协议转换开销。

4.3 Java应用优化:减少Sidecar性能损耗的核心手段

针对Sidecar带来的性能影响,可通过以下优化手段降低损耗,核心思路是“减少Sidecar的计算/IO开销”:

(1)关闭Sidecar的Debug日志

Envoy的Debug日志会产生大量IO开销,生产环境建议将日志级别调整为Info或Warn:

- TSF控制台配置:进入“Mesh集群”→“Sidecar配置”→“日志级别”,选择Info;

- 效果:可降低Sidecar的CPU占用约10-20%,磁盘IO减少50%以上。

(2)关闭不必要的过滤器(Filter)

Envoy的过滤器是扩展治理能力的核心,但过多的过滤器会增加计算开销,建议关闭无用的过滤器:

- 常见无用过滤器:无用的鉴权过滤器、Trace过滤器(若已有APM监控)、自定义扩展过滤器;

- 配置方式:TSF控制台“Sidecar配置”→“过滤器管理”,禁用不必要的过滤器;

- 效果:可降低单次请求延迟约0.5-1ms。

(3)启用HTTP/2和连接复用

HTTP/2支持多路复用,可减少TCP连接数,降低Sidecar的连接管理开销:

- 配置方式:TSF控制台“Mesh集群”→“协议配置”,启用HTTP/2;

- 额外优化:设置Sidecar的连接池大小(如最大连接数1000),避免连接耗尽;

- 效果:可将平均延迟降低1-2ms,QPS提升10-15%。

(4)优化Sidecar的资源调度(K8s环境)

- 设置Sidecar的CPU亲和性:将Sidecar调度到与应用不同的CPU核心,避免资源争抢;

- 启用本地缓存:Sidecar缓存服务发现结果、规则配置,减少与控制面的交互;

- 效果:高负载下,应用的P99延迟可降低2-3ms。

(5)Java应用自身优化

- 调整JVM参数:增大堆内存、优化GC策略,避免应用GC导致的响应延迟(间接减少Sidecar的超时计数);

- 关闭应用的冗余网络配置:如自定义的代理、拦截器,避免与Sidecar的流量拦截冲突;

- 启用连接池:Java应用的出站连接启用连接池,减少Sidecar的连接建立开销。

五、生产案例:遗留Java系统Mesh化改造

5.1 系统现状:无法修改代码的Spring MVC单体应用(Spring 3.x)

该金融企业核心账务系统为2015年上线的Spring MVC单体应用,基于Spring 3.2、JDK 7开发,部署在腾讯云CVM(虚拟机)上,核心痛点如下:

- 代码维护困难:开发人员离职、文档缺失,无法安全修改代码集成TSF SDK;

- 治理能力缺失:无限流、熔断、灰度发布能力,高峰期易出现服务雪崩;

- 运维效率低:全量发布风险高,无法精准控制流量,故障定位困难;

- 合规要求:金融行业需满足流量可审计、故障可快速止损的监管要求。

系统核心参数:

- 技术栈:Spring 3.2 + Tomcat 7 + MySQL 5.6;

- 部署环境:腾讯云CVM(CentOS 7),4核8G配置,单实例部署;

- 业务流量:高峰期QPS约500,核心接口为/account/transfer(转账)、/account/query(余额查询);

- 改造限制:禁止修改应用代码、禁止重启应用超过10分钟(金融核心系统7×24小时运行)。

5.2 改造步骤:容器化→部署到Mesh集群→配置治理规则

针对该遗留系统的改造目标是“零代码修改、低停机时间、快速接入TSF Mesh治理能力”,具体改造步骤如下:

(1)前置准备:应用容器化(无代码修改)

无需修改应用代码,仅将现有war包、Tomcat、JDK打包为Docker镜像,Dockerfile示例:

FROM centos:7

# 安装JDK 7(与应用兼容)

ADD jdk1.7.0_80 /usr/local/jdk

ENV JAVA_HOME /usr/local/jdk

ENV PATH $PATH:$JAVA_HOME/bin

# 安装Tomcat 7

ADD apache-tomcat-7.0.99 /usr/local/tomcat

# 复制应用war包(无修改)

ADD account-web.war /usr/local/tomcat/webapps/ROOT.war

# 暴露8080端口

EXPOSE 8080

# 启动Tomcat

CMD ["/usr/local/tomcat/bin/catalina.sh", "run"]

该步骤仅做环境标准化,未修改任何应用代码,镜像构建完成后推送到腾讯云镜像仓库。

(2)创建TSF Mesh集群(虚拟机版)

由于原系统部署在CVM(非K8s),选择TSF Mesh的“虚拟机集群”模式:

- 在TSF控制台进入“集群管理”→“新建集群”,选择“Mesh集群”→“虚拟机集群”;

- 选择目标CVM节点,安装TSF Mesh Agent(一键安装,无需手动配置);

- 配置集群网络:确保CVM节点间网络互通,Sidecar可访问TSF控制面(443端口)。

(3)无停机部署应用+Sidecar

为满足“停机时间<10分钟”的要求,采用“蓝绿部署”方式:

- 先部署一套新的应用实例(带Sidecar)到备用CVM节点,验证Sidecar接管流量正常;

- 将负载均衡(CLB)流量切到新实例(切流时间<5分钟);

- 停止旧实例,完成迁移。

TSF自动为应用注入Envoy Sidecar,核心操作:

- 在TSF控制台创建应用,类型选择“Mesh应用-无SDK”;

- 部署配置中选择已构建的Docker镜像,指定端口8080;

- 勾选“自动注入Sidecar”,TSF会在部署时自动启动Envoy进程,并配置iptables规则拦截8080端口流量。

(4)配置核心治理规则

通过TSF控制台可视化配置治理规则,无需编写任何代码:

- 限流规则:针对/account/transfer接口,设置QPS上限300,超出时Sidecar直接返回503错误,避免应用过载;

- 灰度路由:将10%的/account/query接口流量路由到备用实例,用于监控数据一致性;

- 熔断规则:当/account/transfer接口错误率>50%时,Sidecar触发熔断,30秒内拒绝所有请求,返回降级提示“系统繁忙,请稍后重试”。

5.3 效果评估:实现限流+路由,代码零改动

改造完成后,通过压测和生产验证,核心效果如下:

| 评估维度 | 改造前 | 改造后 |

|---|---|---|

| 限流能力 | 无,高峰期QPS达800导致应用卡死 | 精准限流300QPS,超出请求快速返回503,应用无压力 |

| 灰度发布 | 仅全量发布,风险高 | 支持10%流量灰度,可验证新实例稳定性 |

| 熔断能力 | 无,服务异常时雪崩 | 错误率>50%触发熔断,30秒后自动恢复,无雪崩风险 |

| 流量审计 | 仅应用日志,不完整 | Sidecar采集全量流量日志,包含请求参数、响应码、延迟 |

| 改造成本 | 预估修改代码需2人周(风险高) | 零代码修改,1人天完成部署与配置 |

| 性能影响 | 无代理,平均延迟2ms | Sidecar代理后平均延迟3ms,P99延迟5ms(可接受) |

改造后,该金融核心系统在2024年双十一高峰期(QPS峰值450)稳定运行,未出现一次服务不可用,限流规则拦截了约30%的超额请求,熔断规则在某次数据库异常时成功触发,避免了服务雪崩,完全满足金融行业的稳定性与合规要求。

六、实战任务:Spring Boot 1.5老应用Mesh化部署与流量治理

本节通过实战任务,手把手教你将一个Spring Boot 1.5老应用(无TSF SDK)部署到TSF Mesh集群,配置流量镜像、故障注入、熔断规则,并验证核心能力,帮助你掌握Mesh模式下的全流程操作。

6.1 实战环境准备

| 环境组件 | 版本/规格 | 说明 |

|---|---|---|

| TSF集群 | Mesh集群(K8s版) | 基于腾讯云TKE创建TSF Mesh集群 |

| Spring Boot应用 | 1.5.22.RELEASE | 无TSF SDK,核心接口:/api/hello(GET) |

| 测试环境 | 独立TSF命名空间 | 用于接收镜像流量 |

| 压测工具 | JMeter 5.5 | 模拟生产流量 |

6.2 实战步骤1:应用容器化(无代码修改)

Spring Boot 1.5应用无需修改代码,仅需打包为Docker镜像,Dockerfile示例:

FROM openjdk:8-jdk-alpine

# 复制Spring Boot Jar包(无修改)

ADD spring-boot-1.5-demo.jar /app.jar

# 暴露8080端口

EXPOSE 8080

# 启动应用

ENTRYPOINT ["java","-jar","/app.jar"]

构建镜像并推送到腾讯云镜像仓库(ccr.ccs.tencentyun.com):

docker build -t ccr.ccs.tencentyun.com/tsf-demo/spring-boot-1.5:v1 .

docker push ccr.ccs.tencentyun.com/tsf-demo/spring-boot-1.5:v1

6.3 实战步骤2:部署应用到TSF Mesh集群(无SDK模式)

-

创建Mesh应用:

- 登录TSF控制台,进入“应用管理”→“新建应用”;

- 应用类型选择“Mesh应用”,接入方式选择“无SDK”;

- 命名空间选择“生产命名空间”,集群选择已创建的Mesh集群。

-

部署应用实例:

- 进入应用详情页,点击“部署应用”;

- 选择“容器部署”,镜像地址填写上述推送的镜像地址;

- 端口配置:容器端口8080,服务端口8080;

- 勾选“自动注入Sidecar”,资源配置:应用实例1核2G,Sidecar预留0.5核500MB;

- 点击“部署”,TSF会自动在Pod中注入Envoy Sidecar,并配置iptables透明代理。

-

验证应用部署:

- 部署完成后,在“实例管理”中查看应用实例状态为“运行中”;

- 访问应用地址:http://:8080/api/hello,返回“Hello TSF Mesh”,说明应用正常运行;

- 查看Sidecar日志(TSF控制台→“日志管理”→“Sidecar日志”),确认流量拦截正常。

6.4 实战步骤3:配置流量镜像(10%生产流量到测试环境)

目标:将生产环境/api/hello接口的10%流量镜像到测试环境的同名应用。

具体配置步骤:

- 进入TSF控制台“流量治理”→“流量镜像”→“新建规则”;

- 基础配置:

- 应用:选择生产环境的Spring Boot应用;

- 命名空间:生产命名空间;

- 规则名称:mirror-10%_to_test;

- 镜像规则配置:

- 镜像比例:10%;

- 目标服务:测试命名空间的Spring Boot应用(服务名相同);

- 过滤条件:路径匹配/api/hello,请求方法GET;

- 发布规则:点击“发布”,规则实时同步到生产环境的Sidecar。

验证流量镜像:

- 启动JMeter压测,向生产应用发送1000次/api/hello请求;

- 查看测试环境应用的访问日志,应接收到约100次请求(10%比例);

- 生产环境应用的响应时间、错误率无变化,说明镜像流量不影响生产。

6.5 实战步骤4:配置故障注入(50ms延迟)

目标:为生产环境/api/hello接口注入50ms延迟,模拟网络波动。

具体配置步骤:

- 进入TSF控制台“流量治理”→“故障注入”→“新建规则”;

- 基础配置:

- 应用:生产环境Spring Boot应用;

- 命名空间:生产命名空间;

- 规则名称:delay-50ms_api_hello;

- 故障类型选择“延迟注入”:

- 延迟时长:50ms;

- 注入比例:100%(所有请求都注入延迟);

- 过滤条件:路径匹配/api/hello;

- 发布规则:点击“发布”,规则立即生效。

验证延迟注入:

- 使用JMeter压测生产应用/api/hello接口,记录响应时间;

- 改造前平均响应时间约2ms,改造后约52ms(50ms延迟+2ms基础延迟);

- 查看TSF控制台“监控中心”→“应用监控”,接口平均延迟从2ms上升到52ms,验证延迟注入生效。

6.6 实战步骤5:配置熔断规则并验证(错误率>50%触发熔断)

(1)配置错误码注入(为验证熔断做准备)

先配置错误码注入规则,使/api/hello接口返回500错误,错误率达60%:

- 进入“故障注入”→“新建规则”;

- 故障类型选择“错误码注入”;

- 错误码:500,注入比例:60%;

- 过滤条件:路径/api/hello,发布规则。

(2)配置熔断规则

- 进入TSF控制台“流量治理”→“熔断降级”→“新建规则”;

- 基础配置:

- 应用:生产环境Spring Boot应用;

- 命名空间:生产命名空间;

- 规则名称:circuit_break_api_hello;

- 熔断规则配置:

- 熔断触发条件:错误率>50%(统计周期10秒);

- 熔断时长:30秒;

- 半开状态放行比例:10%;

- 降级响应:错误码503,响应体{“code”:503,“msg”:“服务熔断,请稍后重试”};

- 适用接口:/api/hello;

- 发布规则:点击“发布”。

(3)验证熔断机制

验证步骤:

- 启动JMeter以100QPS压测/api/hello接口;

- 前10秒:Sidecar统计错误率60%(超过50%阈值),触发熔断;

- 10-40秒:所有请求返回503降级响应,应用无请求进入(可查看应用日志验证);

- 40秒后:Sidecar进入半开状态,仅放行10%的请求(10QPS);

- 停止错误码注入规则,此时半开状态的10%请求返回正常(200);

- 等待10秒统计周期后,熔断状态关闭,所有请求恢复正常响应。

6.7 实战总结

本次实战通过零代码修改,将Spring Boot 1.5老应用接入TSF Mesh集群,成功实现:

- 10%生产流量镜像到测试环境,无感知验证;

- 50ms延迟注入,模拟网络波动;

- 错误率>50%时触发熔断,30秒后自动恢复;

- 所有治理规则通过控制台配置,实时生效,无需重启应用。

七、总结与未来展望

7.1 核心总结

Service Mesh作为云原生时代的微服务治理范式,解决了传统SDK模式下Java应用(尤其是遗留系统)改造成本高、框架依赖强、代码侵入的核心痛点。腾讯TSF Mesh基于Envoy构建数据平面,结合企业级控制面能力,为Java应用提供了“零侵入、全托管、高性能”的治理解决方案:

- 架构层面:Sidecar模式实现应用与治理逻辑解耦,控制面统一管理规则,数据面高效执行;

- 接入层面:支持无SDK、混合模式,适配不同阶段的Java应用迁移需求;

- 能力层面:提供流量镜像、故障注入、Sidecar层熔断等高级治理能力,满足企业级场景需求;

- 性能层面:通过资源预留、协议优化、日志调优,将Sidecar的性能影响控制在1-3ms,完全满足生产要求;

- 落地层面:遗留Java系统可通过容器化→Mesh部署→规则配置的流程,实现零代码改造接入治理体系。

7.2 迁移建议

对于计划从SDK模式迁移到TSF Mesh的Java应用集群,建议遵循以下原则:

- 先易后难:优先迁移非核心、低流量的Java应用,验证Mesh模式的稳定性;

- 渐进式迁移:通过混合模式过渡,逐步移除SDK,避免一次性全量切换的风险;

- 性能先行:迁移前完成Sidecar资源基线测试,预留足够资源,避免性能瓶颈;

- 监控兜底:迁移过程中保留双端监控(SDK+Sidecar),确保问题可快速定位。

7.3 未来展望

TSF Mesh作为腾讯云微服务治理的核心方向,未来将持续进化:

- 性能优化:基于eBPF技术替代iptables,进一步降低Sidecar的转发延迟;

- 多协议支持:增强对Dubbo、Thrift等私有协议的解析能力,适配更多Java应用场景;

- 智能化治理:结合AI实现规则自动调优(如熔断阈值、限流QPS的动态调整);

- 国产化深度适配:全面兼容麒麟、统信等国产化操作系统,鲲鹏、飞腾等芯片架构。

对于Java开发者而言,Service Mesh的普及意味着“业务与治理分离”的时代已经到来,无需再关注复杂的治理SDK集成,只需聚焦业务逻辑开发,治理能力完全由TSF Mesh提供。掌握TSF Mesh的架构原理与落地实践,将成为Java架构师应对云原生转型的核心能力之一。

附录:TSF Mesh常见问题与解决方案

| 常见问题 | 解决方案 |

|---|---|

| Sidecar注入失败 | 检查CVM/TKE节点是否安装Mesh Agent,节点网络是否能访问TSF控制面 |

| 流量未被Sidecar拦截 | 检查iptables规则是否生效(执行iptables -L -n查看),应用端口是否正确配置 |

| 规则配置后不生效 | 检查规则发布状态(是否已发布到目标集群),Sidecar日志是否有规则同步错误 |

| Sidecar资源占用过高 | 关闭Debug日志,禁用无用过滤器,增大Sidecar资源预留 |

| 镜像流量未到达测试环境 | 检查测试环境服务是否正常,镜像规则的过滤条件是否正确,网络是否互通 |

本文从架构原理到实战落地,全面解析了TSF Mesh实现Java应用零侵入治理的全流程,希望能帮助读者理解Service Mesh的核心价值,掌握腾讯TSF Mesh的使用方法,助力企业Java应用的云原生转型。

1180

1180

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?