权重衰退+Dropout

最新推荐文章于 2025-06-15 18:32:49 发布

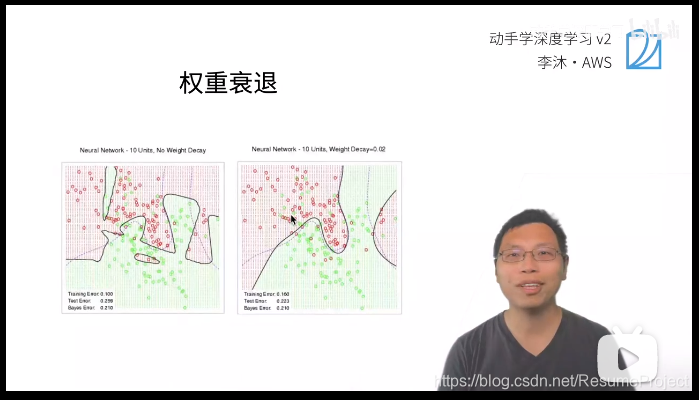

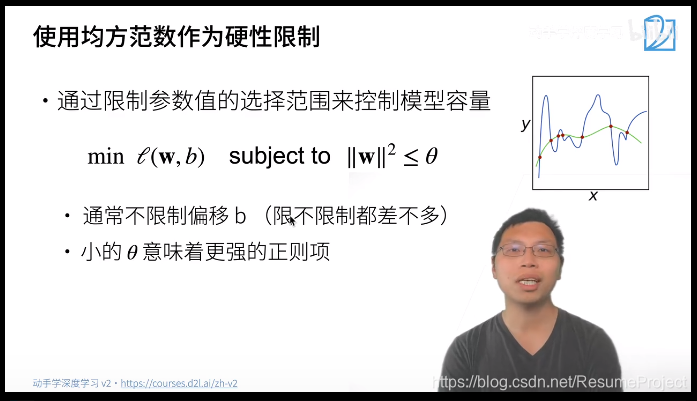

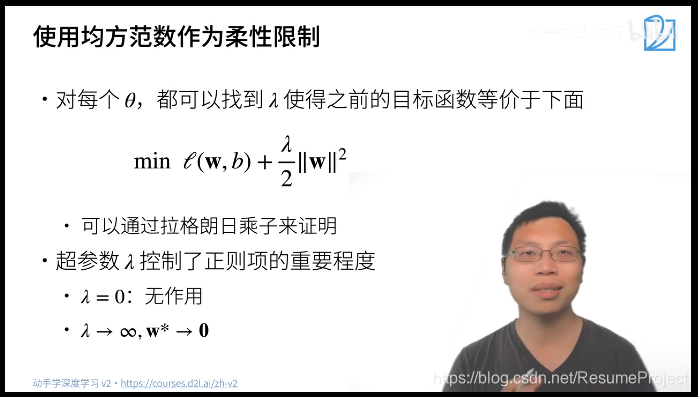

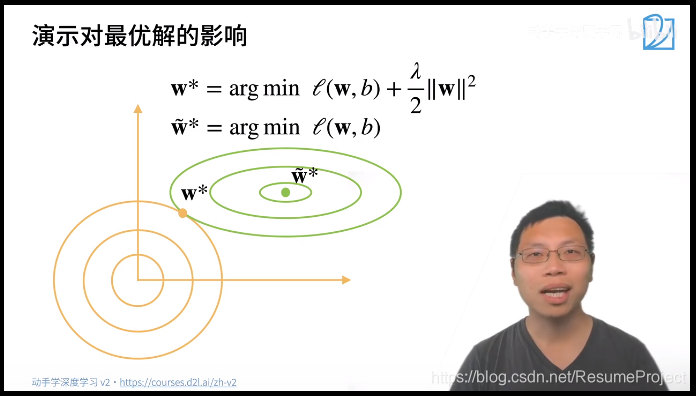

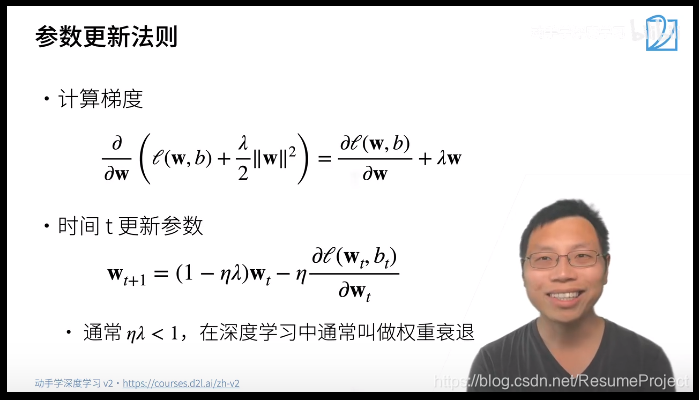

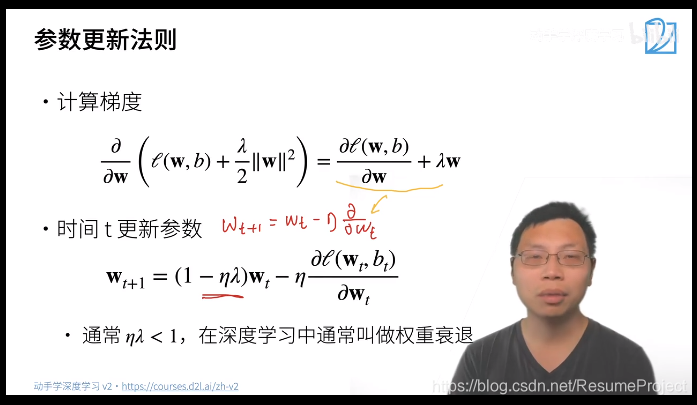

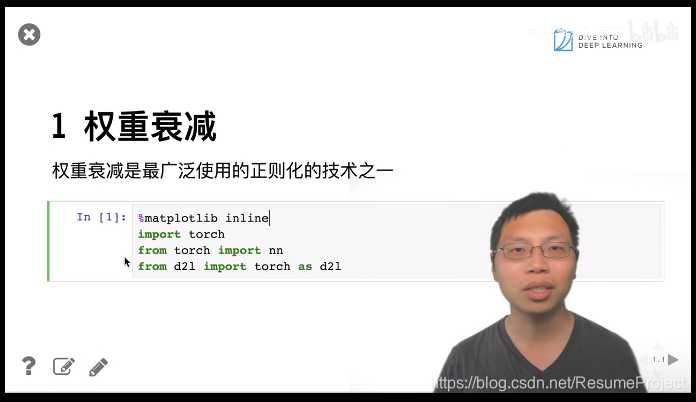

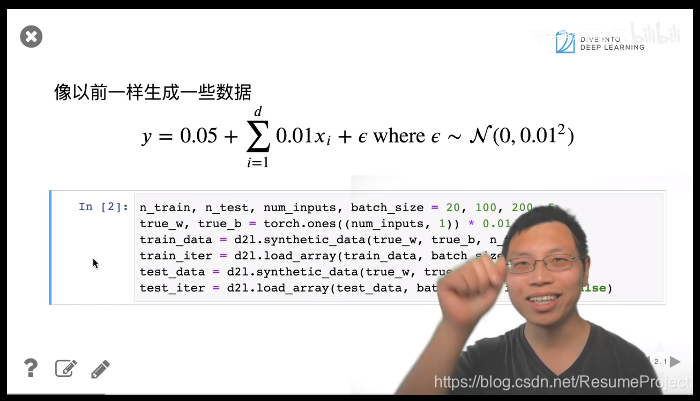

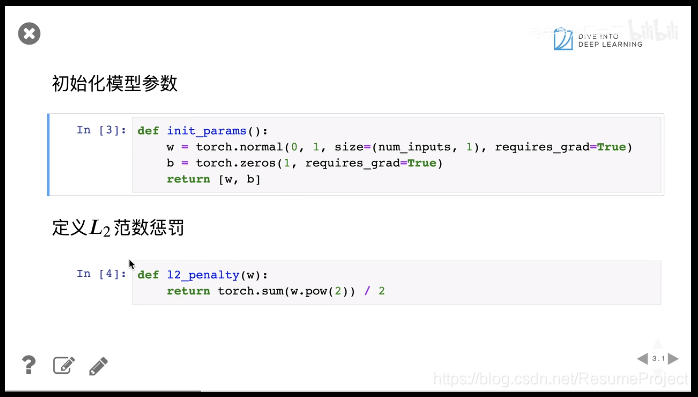

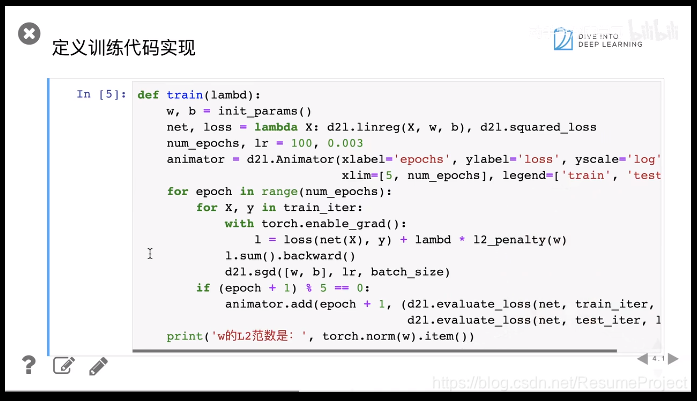

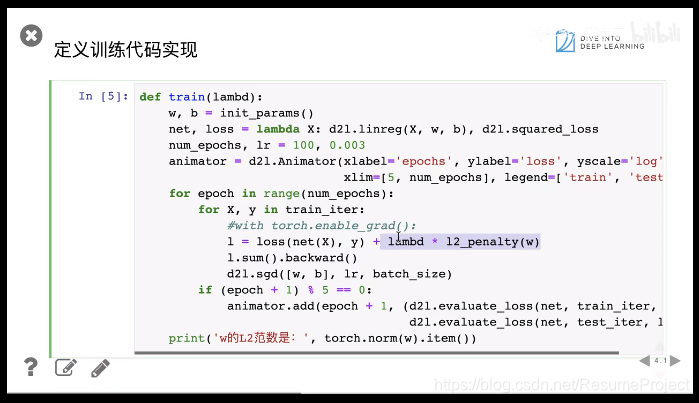

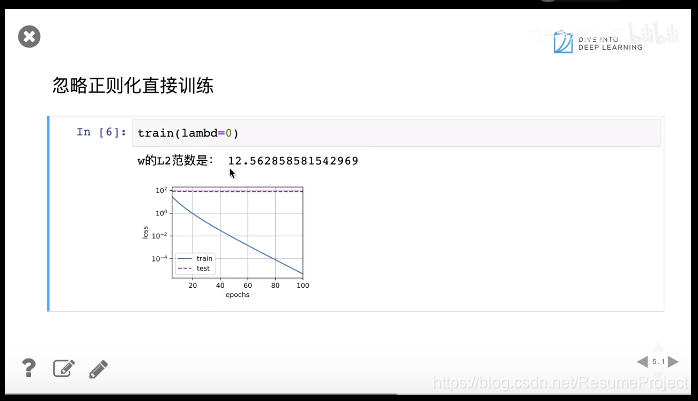

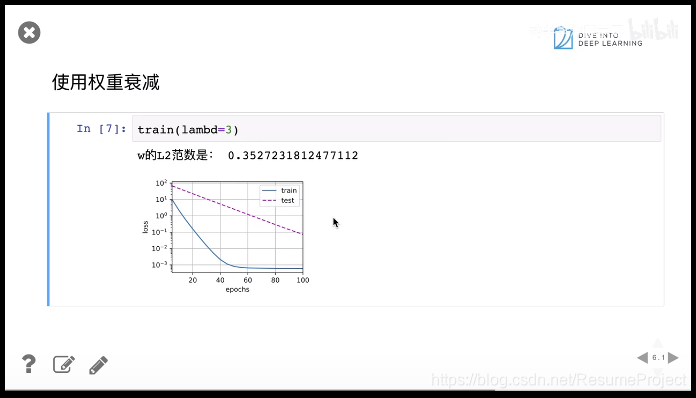

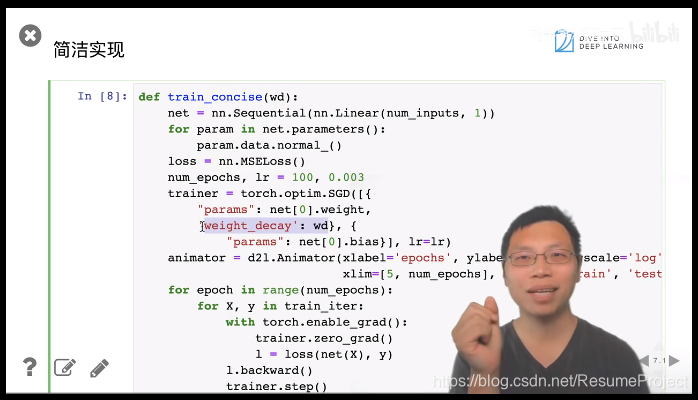

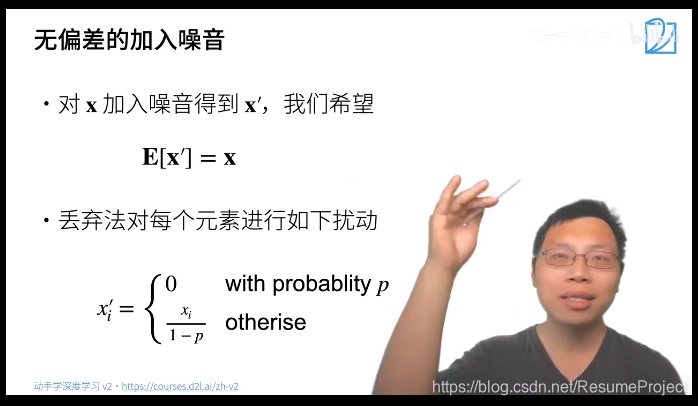

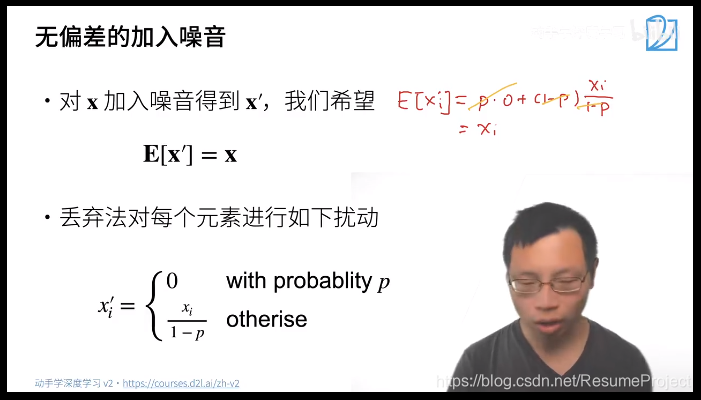

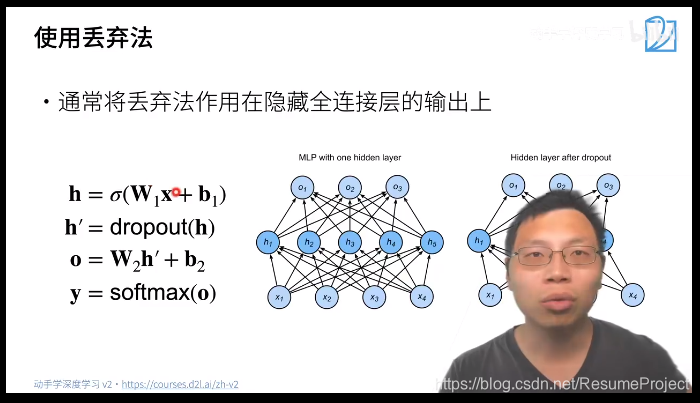

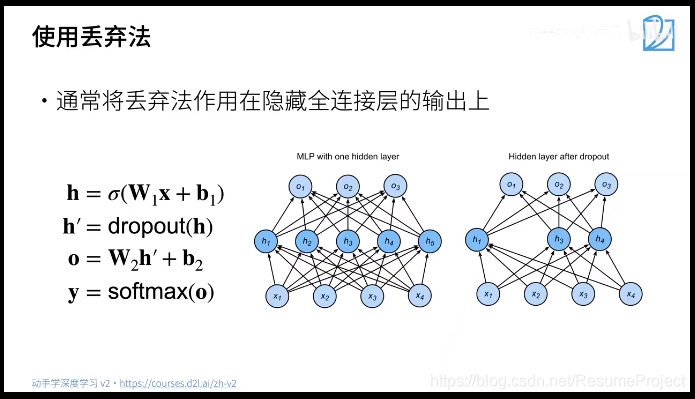

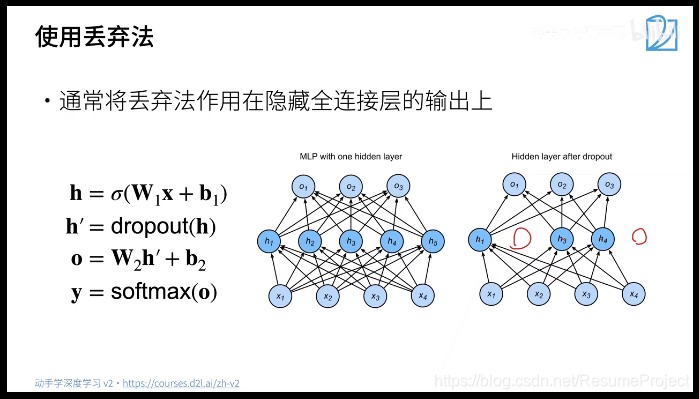

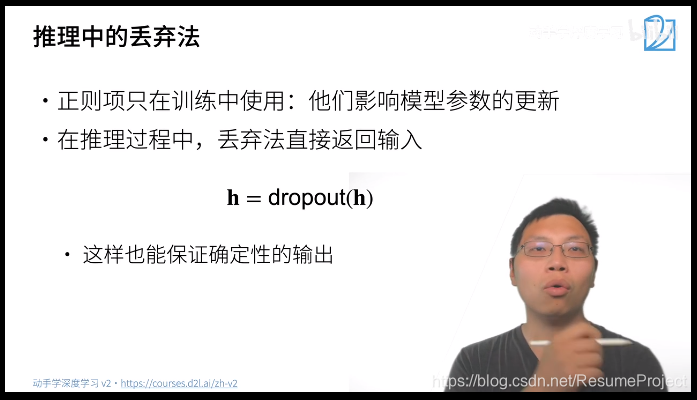

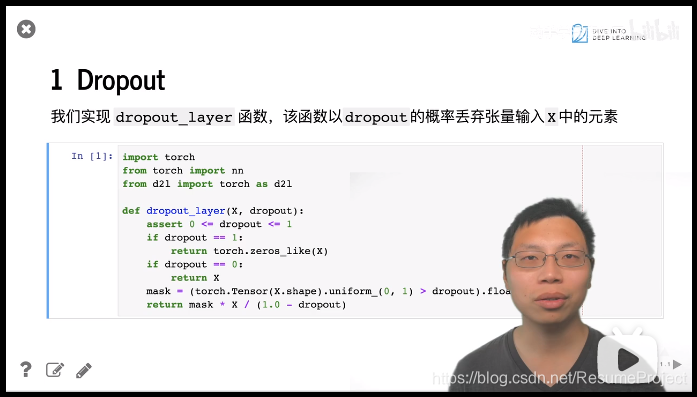

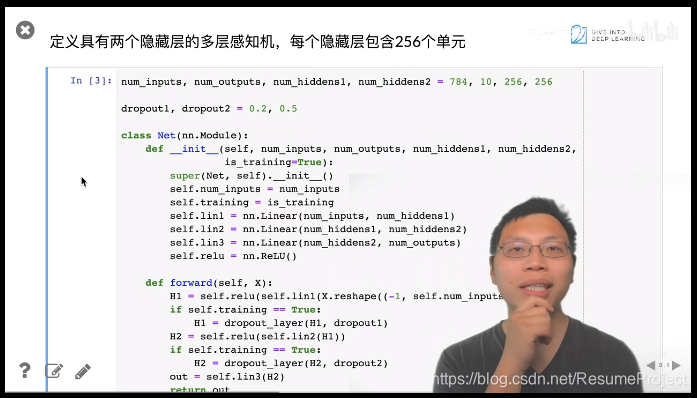

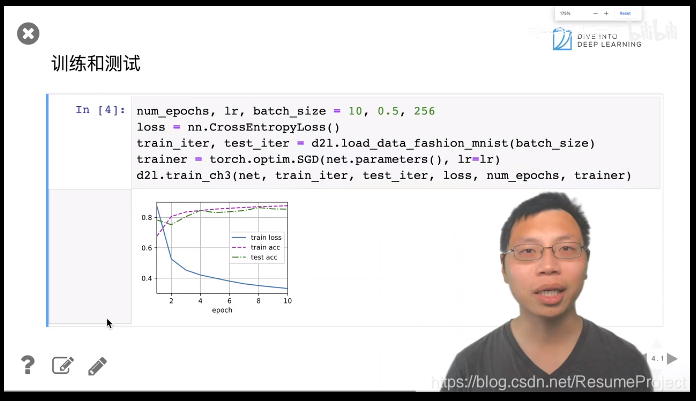

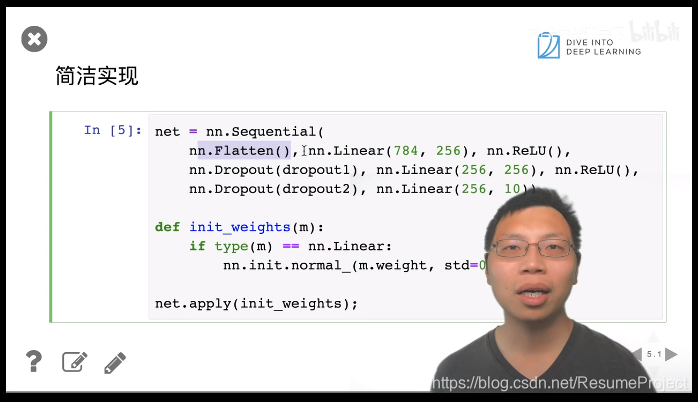

权重衰退,又称L1或L2正则化,是防止深度学习模型过拟合的有效方法。通过在损失函数中添加正则项,训练期间模型的权重会被约束,避免权重值过大导致过度复杂。在推理时,不使用正则项以获得更简洁的模型。 Dropout技术则是另一种防止过拟合的手段,它在训练过程中随机忽略一部分神经元,增加模型的泛化能力。乘法运算在GPU上的计算速度更快,因此在实现Dropout时常用此方法。

权重衰退,又称L1或L2正则化,是防止深度学习模型过拟合的有效方法。通过在损失函数中添加正则项,训练期间模型的权重会被约束,避免权重值过大导致过度复杂。在推理时,不使用正则项以获得更简洁的模型。 Dropout技术则是另一种防止过拟合的手段,它在训练过程中随机忽略一部分神经元,增加模型的泛化能力。乘法运算在GPU上的计算速度更快,因此在实现Dropout时常用此方法。

425

425

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?