停止条件:对所有的样本分类正确

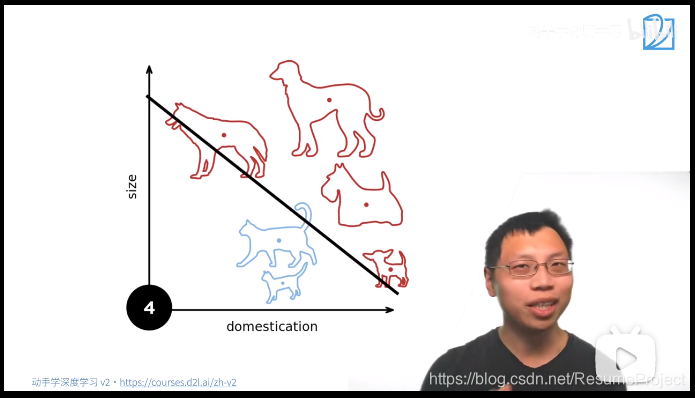

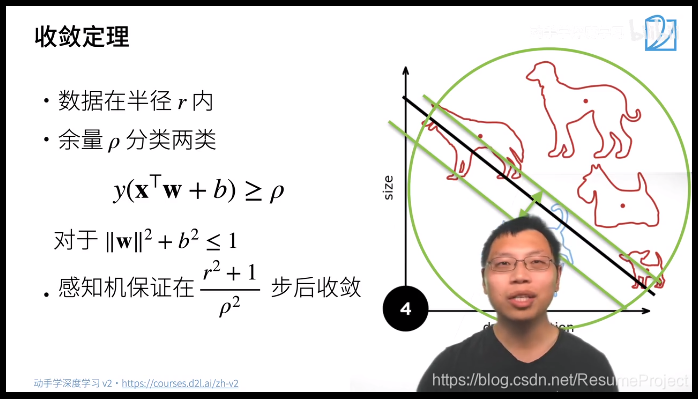

感知机存在的问题:

一条线无法分割以下四个点:

😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁

再1969年,因为发现了这个问题,机器学习陷入了一个寒冬

😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁😁

对1,2,3,4进行分类,分别使用蓝色和黄色进行分类,得到的结果“相乘”(乘法定义为,相同为+,相异为-)

观察:终于有一个多层次的网络了,虽然只有两层

为什么叫隐藏层呢? 因为输入输出是不能改变的,能控制的只有中间的一层

“激活”函数:非线性

Sigmoid是一个soft版本

Tanh是-1到1

早期经常做的就是给一堆已存在的东西重命名😂😂😂😂😂😂😂😂😂😂😂😂😂😂😂😂😂😂😂😂😂

就是再Softmax 中加入了一层,然后起了一个新的名字

激活函数是为了防止层数的塌陷

一般的。如果单层使用128能较好的拟合,多层的模型(比如3层)可能就不需要每层都128个,比如64-》32-》10,或者可以先expend 256->64->32

----------------------------------

这篇博客探讨了感知机在面对无法用一条直线分割的数据集时的问题,导致1969年机器学习的寒冬。文章介绍了多层网络的概念,特别是隐藏层的由来,以及激活函数的重要性。激活函数如Sigmoid和Tanh引入了非线性,防止了模型层数增加时的梯度消失问题,使得更复杂的模式得以学习。同时,讨论了层的结构优化,如减少节点数或使用不同的节点配置。

这篇博客探讨了感知机在面对无法用一条直线分割的数据集时的问题,导致1969年机器学习的寒冬。文章介绍了多层网络的概念,特别是隐藏层的由来,以及激活函数的重要性。激活函数如Sigmoid和Tanh引入了非线性,防止了模型层数增加时的梯度消失问题,使得更复杂的模式得以学习。同时,讨论了层的结构优化,如减少节点数或使用不同的节点配置。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?