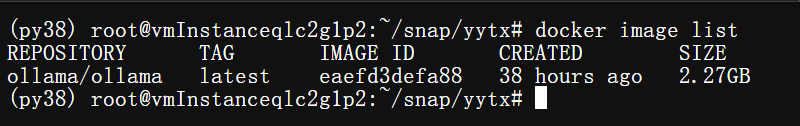

首先:拉取镜像(确保网络环境).

docker pull ollama/ollama:latest

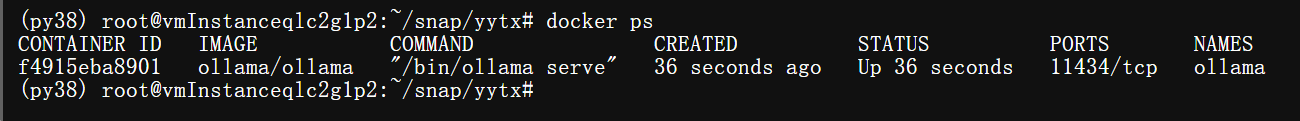

启动ollama

docker run -d --name ollama ollama/ollama

docker run -d -v ollama:/data/ollama -p 11434:11434 --name ollama ollama/ollama

进入docker容器

docker exec -it ollama bash

进入 Ollama 容器并列出所有模型

docker exec -it <ollama_container_name> ollama list

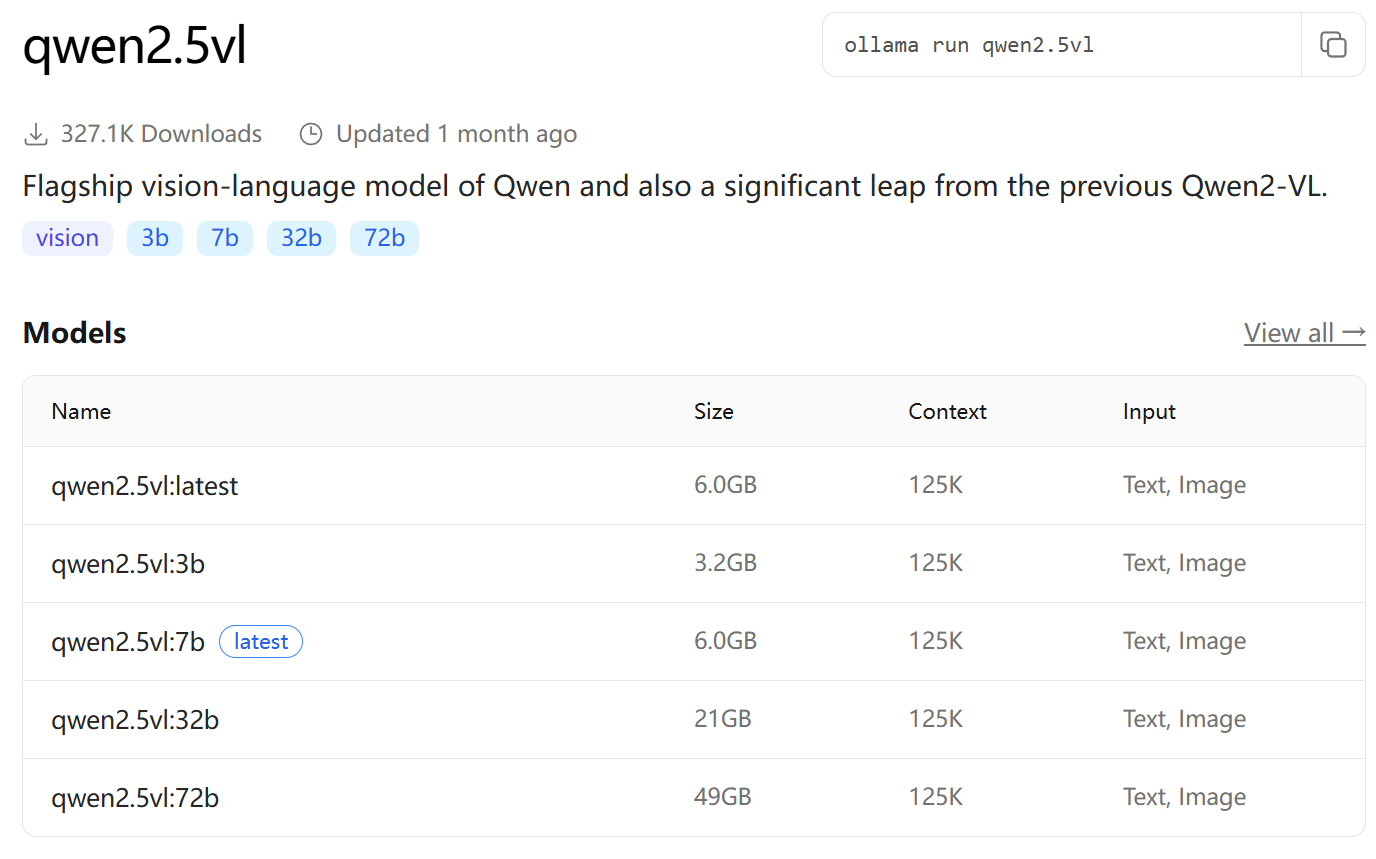

嫌麻烦,可以不执行上一步,直接起模型就行。这里以qwen2.5vl为例。

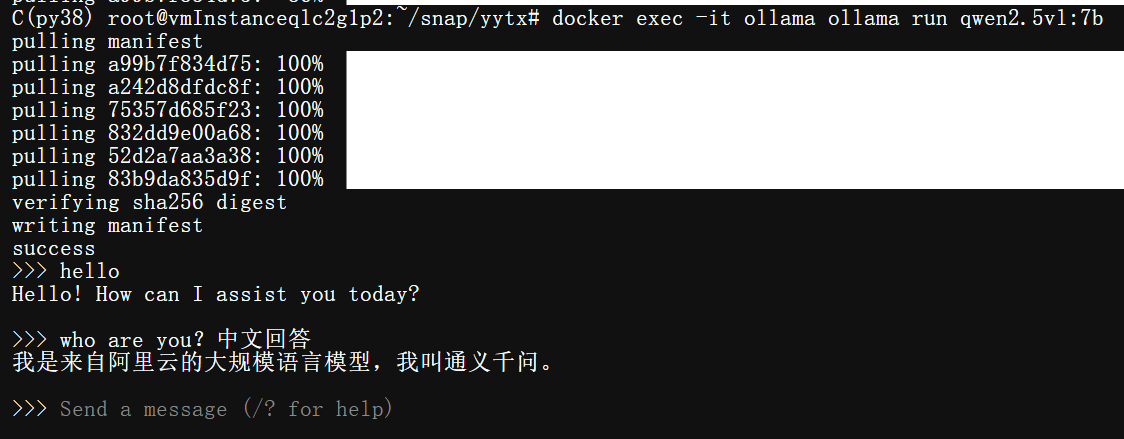

注:如果发现下载速度由快变慢,就 Ctrl+C 先停掉然后再运行一遍(ollama老bug了)。

docker exec -it ollama ollama run qwen2.5vl:7b

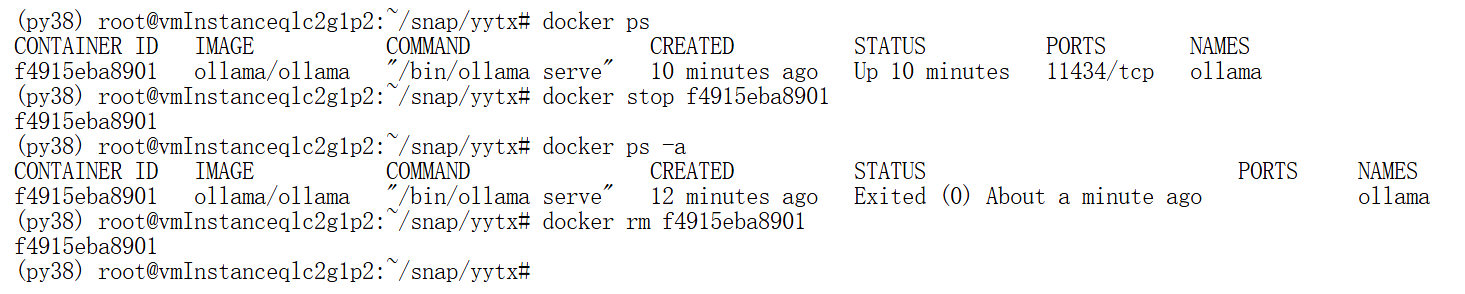

想要退出,先停止后退出。如图所示

docker stop xxxxx

docker rm xxxx

269

269

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?