内容来源:量子前哨(ID:Qforepost)

文丨浪味仙 排版丨浪味仙

行业动向:2300字丨6分钟阅读

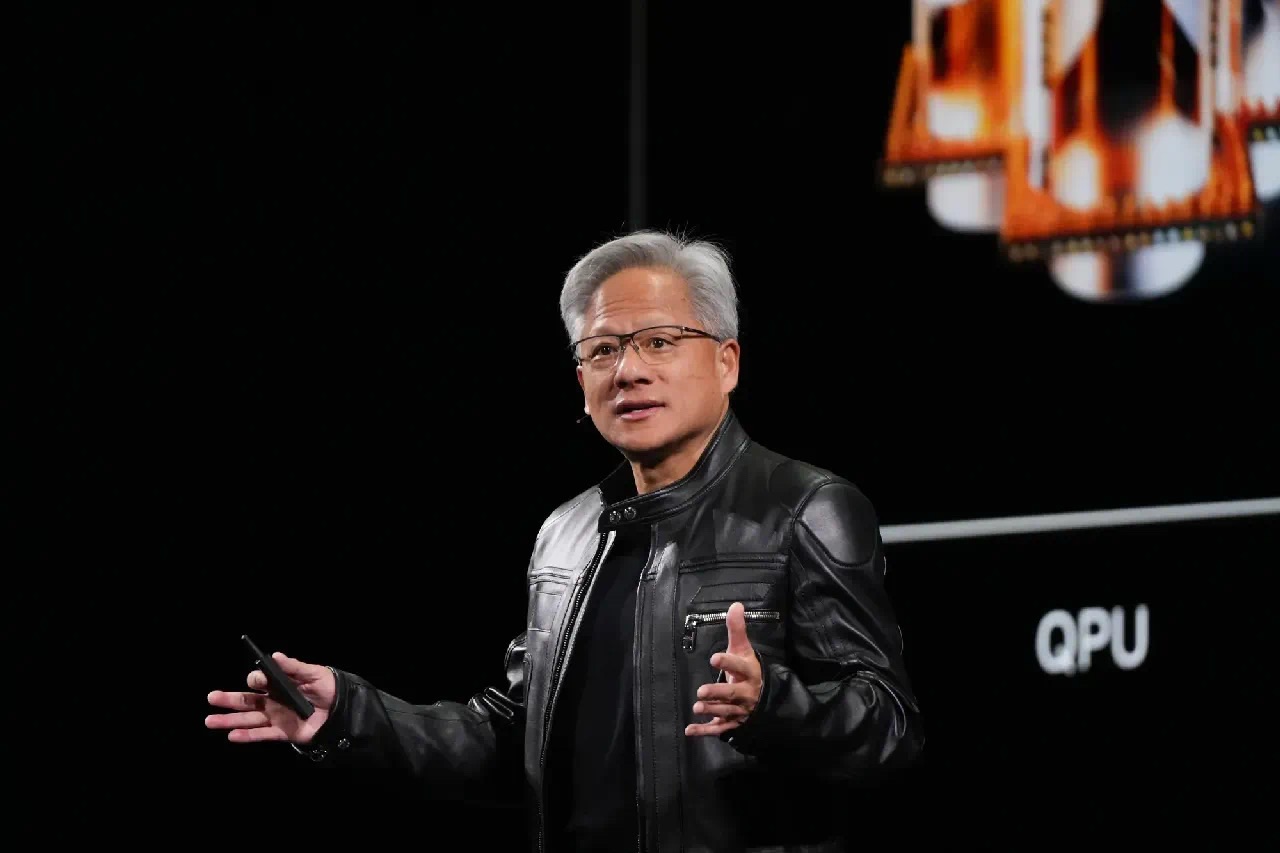

英伟达 CEO 黄仁勋在 Viva Tech 2025 大会上发表了对未来科技的展望。

他认为量子计算正迎来一个“拐点”,英伟达已推出 CUDA-Q 平台,旨在促进量子与经典计算的结合,并预测未来所有超级计算机都将集成量子处理单元(QPU)与图形处理单元(GPU)。

此外,黄仁勋还发布了下一代 Grace Blackwell 平台,将其描述为一台“思考机器”,能实现数字孪生技术,让物理世界的一切都可被虚拟模拟。

他还提出 AI 工厂的概念,这些数据中心将不再仅用于存储,而是专注于处理和生成智能数据,以推动 AI 应用的发展。他强调,智能基础设施对各国、社会和企业都至关重要,欧洲也已认识到 AI 工厂的重要性。

要点一

量子计算正迎来“拐点”

英伟达 CEO 黄仁勋正将目光投向人工智能(AI)革命的下一个关键推动者:量子计算。

在周三(6月11日)举办的 2025 年巴黎 Viva Tech 大会上,黄仁勋表示:“量子计算正迎来一个拐点。”他还补充道:“现在很清楚的是,我们已接近能够将量子与经典计算结合应用的阶段,这将能够解决一些有趣的问题。”

今年 1 月,黄仁勋曾质疑是否有可能在未来 15 年内推出实用的量子计算机,该言论导致部分量子股下跌,但在随后的 GTC 大会上他承认自己此前的看法是错误的。此次他在 Viva Tech 2025 大会上的演讲再次与 1 月的发言形成鲜明对比,显示出他对量子计算进展更为乐观的态度。

正如摩尔定律曾预言经典计算的指数增长一样,黄仁勋认为量子计算正迎来类似的增长轨迹。“我完全可以预期,每五年,逻辑量子比特将增加 10 倍,每十年,逻辑量子比特将增加 100 倍。”此外他还提到目前在纠错、鲁棒性和可扩展性的进步已触手可及。(就在 Viva Tech 2025 前一天,IBM 表示正在构建世界上第一台大规模容错型量子计算机,将于 2029 年推出。)

黄仁勋还强调了英伟达对支持量子生态系统的承诺,表示英伟达的芯片将用于支持量子计算,且公司完整的量子算法栈将在其 Grace Blackwell 200 芯片上加速运行。量子计算机有潜力大幅提升大语言模型的运算速度,并推动更强大 AI 的诞生。

要点二

量子计算新篇章:CUDA-Q 面世

黄仁勋曾以将英伟达的未来押注在 AI 和 GPU 上而闻名,彼时这项技术尚未家喻户晓。而在被誉为“法国版 CES”的 Viva Tech 大会的主题演讲中,黄仁勋透露,英伟达正在为 AI 发展进程中的下一个关键节点做好准备。“每一次工业革命都始于基础设施。AI 是我们这个时代必不可少的基础设施,就像电力和互联网一样。”

量子计算是一类比当今经典计算机强大数倍的计算机,能够加速 AI(智能软件)的处理。量子计算机使用量子比特(qubits),相比于经典计算机(使用 1 和 0 表示的比特)能够处理更多的数据。

在 Viva Tech 上,黄仁勋发布了 CUDA-Q,这是其 CUDA 平台的新扩展,专为量子-经典混合计算而设计。作为一个开源的混合计算平台,CUDA-Q 能够使运行量子计算应用程序所需的硬件和软件协同工作。

黄仁勋预测:“至少在下一代超级计算机中,每一台都将配备 QPU(量子处理单元)并与 GPU 相连。”基于此,他描绘了一个量子和经典架构协同工作,解决曾被认为无法解决问题的未来。

要点三

Grace Blackwell 平台:数字孪生时代来临

除了量子计算,黄仁勋还展示了英伟达的下一代 Grace Blackwell 平台,他将其描述为一台专为推理和规划而设计的“思考机器”。

这一硬件上的飞跃使得数字孪生(物理系统的数字副本)得以创建和运行,并在虚拟环境中进行设计和测试,然后再部署到现实世界中。

黄仁勋提到:“由于我们现在能够以极快的速度模拟几乎所有事物,因此我们可以将一切都变成数字孪生。”同时他还强调:“所有物理实体都将以可视化的方式被构建。”

要点四

AI 工厂:智能时代的制造中心

上述这些 AI 能力需要一种全新的数据中心,黄仁勋称之为 AI 工厂,尽管这可能看起来与传统的数据中心无二,但事实上,它们不仅仅是用于存储和检索文件的地方。

黄仁勋提到,AI 工厂处理和生成用于 AI 应用的智能令牌(例如词汇组和其他数据),就像汽车工厂制造汽车一样。“每个国家、每个社会、每个公司都将依赖于这种智能基础设施,欧洲现在已经意识到这些 AI 工厂、以及 AI 基础设施的重要性。”

欧洲有 20 多个 AI 工厂正在计划中,黄仁勋提到,两年之内,英伟达就会助力欧洲将 AI 计算能力提升 10 倍。与此同时,英伟达已与多个国家合作开发生态系统,包括与 77 个国家合作建立 AI 技术中心,目标之一是与初创公司合作共建生态系统。此外,英国光量子计算公司 ORCA Computing 也正在为 AI 工厂量身打造量子加速器🔗。

黄仁勋在 Viva Tech 大会上的言论,令多家开发量子技术的公司股价在当日盘前交易中出现大幅上涨,这反映出公众对该行业的广泛热情,市场预期量子突破可能很快为医疗、科研和金融等领域解锁新能力。

Reference:

NVIDIA CEO Jensen Huang Live GTC Paris Keynote at VivaTech 2025

https://www.youtube.com/watch?v=X9cHONwKkn4

903

903

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?