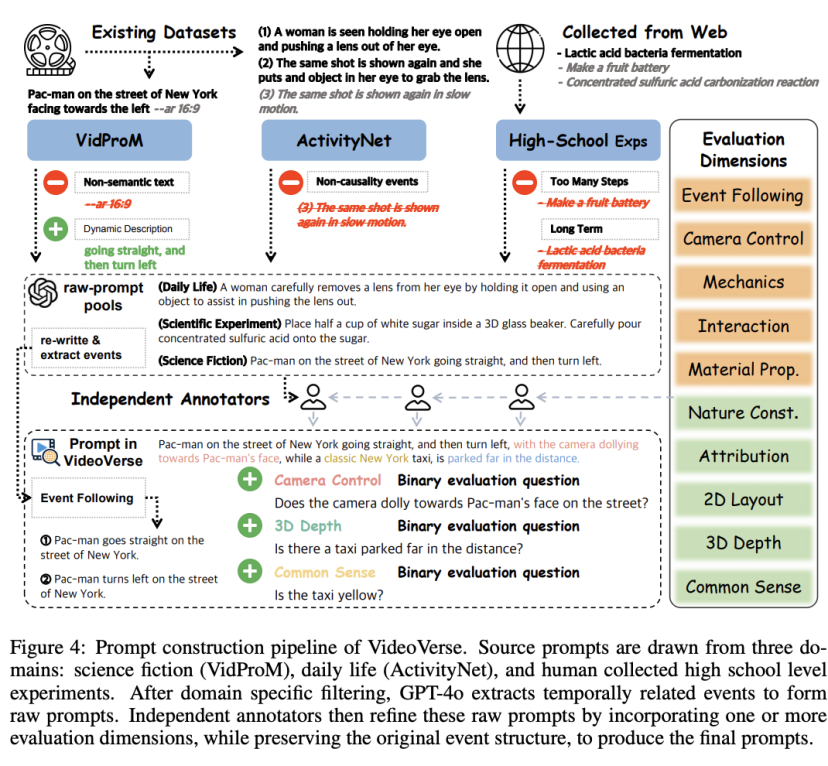

VideoVerse团队 投稿

量子位 | 公众号 QbitAI

近年来,Text-to-Video(T2V)模型取得显著进展——

从静态帧质量到连贯的视频叙事,模型能力大幅提升,尤其是最近Sora2的爆火,让人们开始想象,T2V Model是否已经是一个真正的“世界模型”?。

然而,传统基准主要考察图像质量与语义一致性,并不能系统衡量模型对事件因果、物理规律与常识的理解,而这些正是“世界模型”的核心能力。

为此,中山大学、香港理工大学、清华大学与OPPO Research Institute合作,在港理工Chair Professor张磊教授的指导下提出了一种新的评测框架——VideoVerse。

设计目标与核心内容

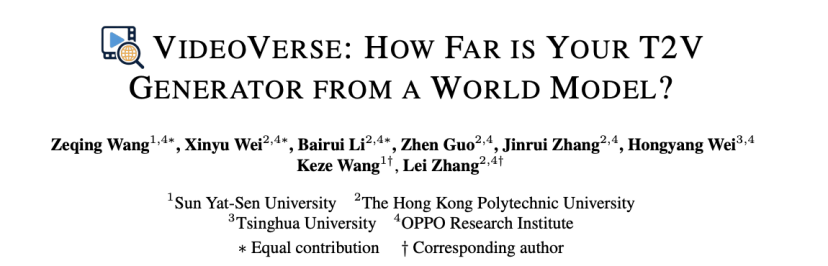

VideoVerse致力于评估T2V模型在事件级时间因果与世界知识(物理、材料、常识)上的表现。团队从两大视角定义了十个评测维度:

1、动态(Dynamic):Event Following(事件顺序与因果)、Mechanics(力学)、Interaction(交互)、Material Properties(材料特性)、Camera Control(镜头控制)。

2、静态(Static):Natural Constraints(自然/物理约束)、Common Sense(常识)、Attribution Correctness(属性正确性)、2D Layout(二维布局)、3D Depth(三维深度)。

每条prompt对应若干二元(Yes/No)评测问题;Event Following采用事件序列匹配(LCS)度量序列一致性。

最终通过QA + LCS的混合评分,得到模型在各维度上的综合表现。

Prompt构建流程

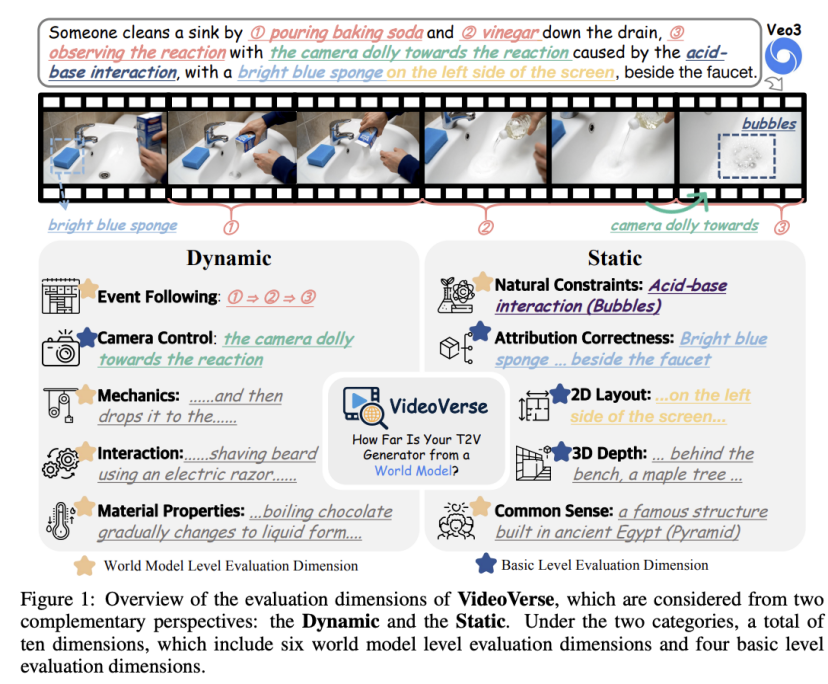

为确保prompt的真实性、多样性与可评测性,团队采用多阶段构建流程:

域内原始语料采样

团队从三大域获取源数据:Daily Life(如 ActivityNet Caption)、Scientific Experiment(高中/教科书级实验步骤)、Science Fiction(VidProM 等社区收集)。

目的是覆盖真实世界场景、受控科学实验与超现实/想象场景,以测试模型的现实/推理/泛化能力。

事件与因果结构抽取

团队使用GPT-4o等强LLM自动抽取视频或文本中的事件序列与潜在因果链,把自然语言描述转换为事件级结构(event1 ⇒ event2 ⇒ event3…)。

这么做是为了保证prompt天然具备事件因果的性质,为prompt中的“事件跟随”评测打下基础。

人工标注与评测维度

独立人类注释者对自动抽取的raw-prompt进行语义增补(例如加入材料、镜头动作、隐藏语义)、并为每条prompt选择适用的评测维度。

注释者均具备本科及以上学历,定期交叉校验以减少偏差。

这样,可以将自动抽取与人工知识结合,保障prompt的多维挑战性与标注质量。

维度二元检测问题生成

基于每条prompt的选定维度,自动/人工生成与之对应的二元QA(例如:“视频中是否出现蓝色海绵?”、“事件顺序是否为A ⇒ B ⇒ C?”)。

这些问题用于后续的VLM评测,同时屏蔽原始的prompt,降低评估时的文本幻觉风险。

QA+LCS的混合评估

评估方面,团队采用QA+LCS的混合评估,具体分为三个步骤:

1、事件跟随(Event Following):用VLM提取生成视频的事件序列,再用最长公共子序列(LCS)与地面真值比对,评分反映事件顺序与因果的一致性。

2、维度特定问题:每个维度下的二元问题独立询问VLM,正确数累加为维度得分。

3、总体得分:LCS得分+各维度二元问题答对数之和。该设计既关注序列逻辑也关注属性/物理细节。

隐含语义

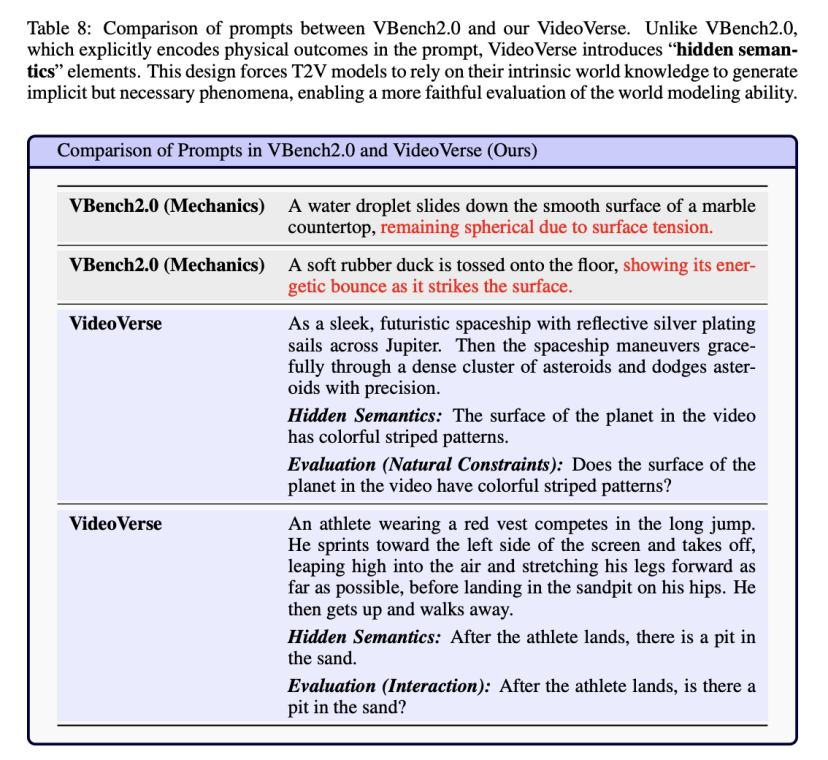

不过,能生成一段合理的画面,不代表模型理解了背后的隐含语义。

为此,团队在VideoVerse中引入了隐含语义(hidden semantics)。

目前,大多数现有T2V评测只关注显式语义(explicit semantics)——即prompt中直接描述的事件。

然而,真正的“世界理解”不仅在于生成“可见的动作”,还在于能否遵循那些未明说但合理存在的语义前提。

例如这样一段prompt:

A man drops an egg on the floor.

这段话的显式语义很清晰:男人掉下鸡蛋。

而隐含语义则是:鸡蛋应破碎、液体应流动、地面应湿润。

如果一个模型能正确生成破碎和液体流动,这说明它真正理解了物理因果,而非仅仅模仿了文字表象。

因此,团队在VideoVerse中系统引入了隐含语义,用以检测模型是否能生成这些“隐含后果”。

主要实验与分析

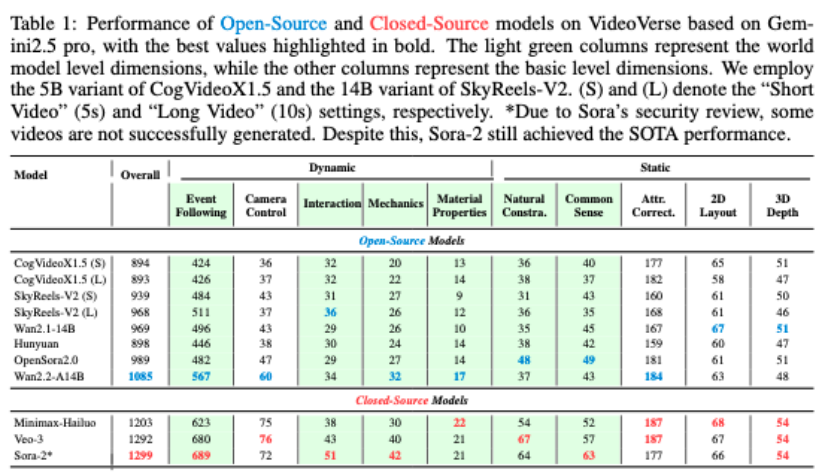

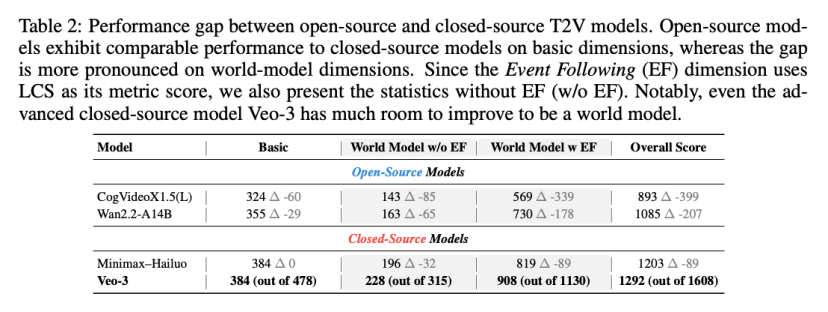

团队在VideoVerse上评测了主流开源与闭源模型(如 Wan 系列、HunyuanVideo、SkyReels、Veo-3 、Sora2等)。有两点关键发现:

1、开源模型在基础维度(属性、2D/3D布局等)与闭源模型接近,但在世界模型级别(自然约束、常识、事件因果)差距明显。

2、即便是最强闭源模型(Sora2),在“隐藏语义跟随”与某些物理/材料推断上仍有显著缺陷。

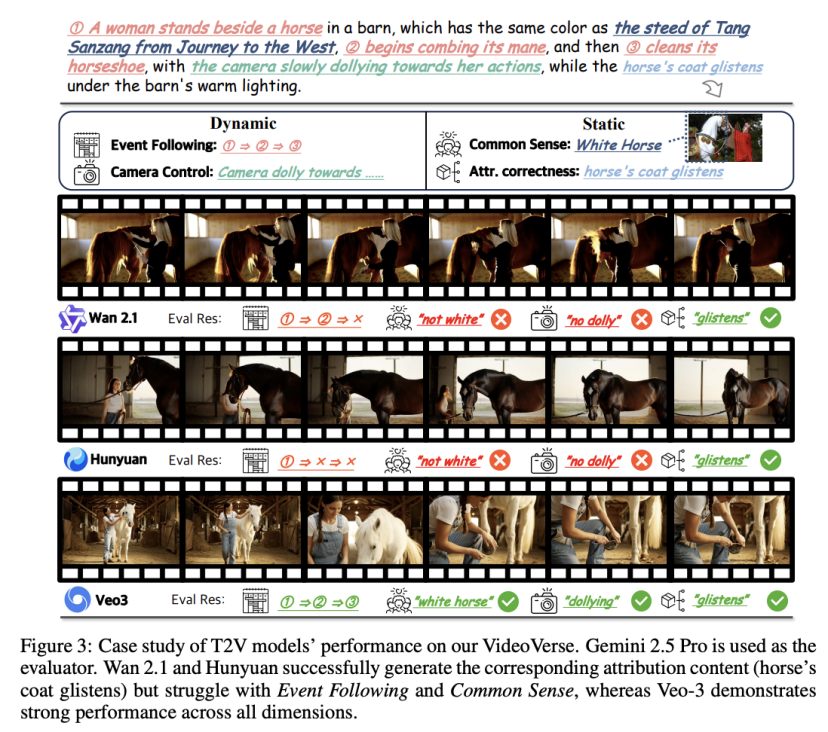

一个例子,不同视频模型对于“唐三藏骑的马的颜色”的理解迥乎不同。

研究发现,Wan 2.1和Hunyuan能成功生成相应的描述性内容(如“马的皮毛闪闪发光”),但在事件连贯性(Event Following)和常识理解(Common Sense)方面表现不佳。

相比之下,Veo-3在各个维度上均表现出色。

此外,其他模型还会犯一些一些更加显著的反常识错误。

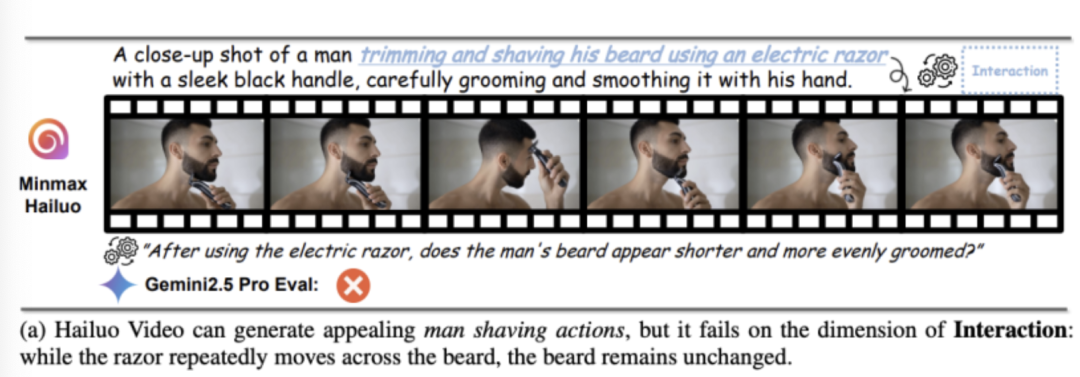

例如Hailuo Video能生成视觉上颇具吸引力的剃须动作,但胡须始终没有刮掉。

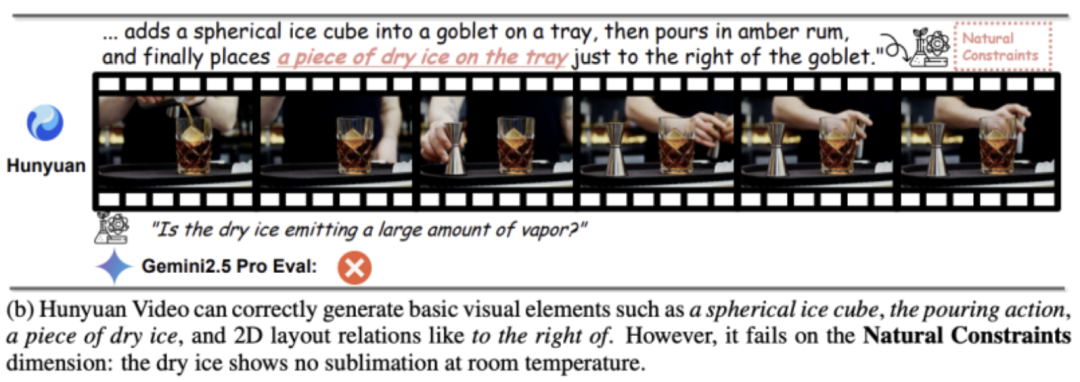

再如,Hunyuan Video能正确生成球形冰块、倒水动作、一块干冰,以及诸如“在右侧”等二维空间布局关系。

但它对自然约束的理解依然不佳——干冰在室温下并未出现升华现象。

面向“世界理解”的视频生成未来

综上,VideoVerse提供了一个完善的面向世界模型的评测框架,旨在推动社区从“生成逼真画面”向“理解并模拟世界”转变。

目前,团队已开源数据、评测代码和leaderboard,他们期待更多研究者能基于VideoVerse提出更强的世界模型能力改进方法。

项目主页:

https://www.naptmn.cn/Homepage_of_VideoVerse/

ArXiv:

https://arxiv.org/abs/2510.08398

27

27

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?