工具是扩展大模型能力边界的主要手段,也是实现复杂任务的核心机制,正确、灵活的使用工具是我们开发 AI 应用中必不可少的技能。一起行动起来,体验一下 Dify 中好玩又有用的这些插件吧。

Dify 中的工具是指其平台内置或支持集成的功能插件,用于扩展 AI 应用的能力。

1.工具作用

- 扩展 LLM 的能力:工具可以赋予 LLM 连接外部世界的能力,例如联网搜索、科学计算、绘制图片等。例如,通过集成谷歌搜索工具,AI 助手可以回答实时问题。

- 完成复杂任务:工具可以帮助 LLM 进行任务推理、步骤拆解和工具调用,从而完成复杂的任务。例如,在开发数据报表生成助手时,可以通过连接数据库工具获取数据,再利用数据分析工具进行处理,最后借助文件处理工具将结果生成报表。

- 与其他系统或服务连接:工具可以方便地将 Dify 应用与其他系统或服务连接,实现与外部环境的交互。例如,通过集成邮件发送工具,可以实现自动发送邮件的功能。

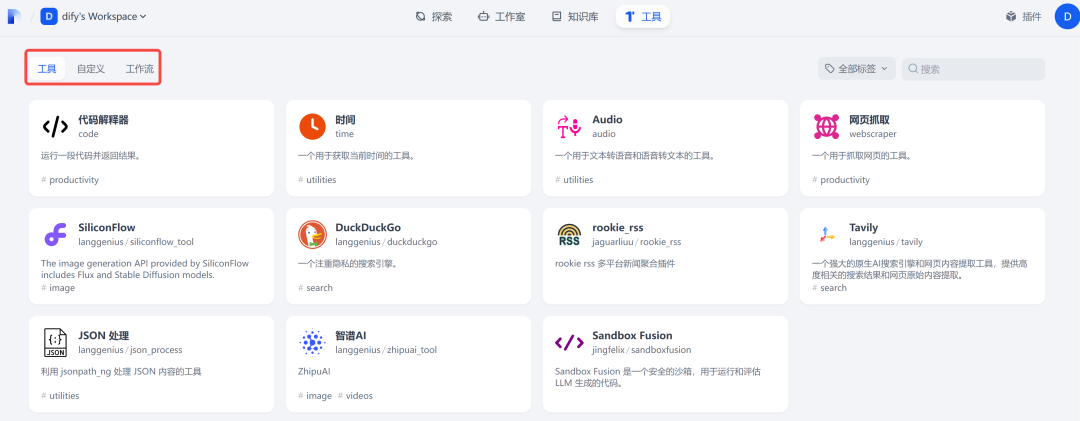

2.工具分类

Dify 中工具分为以下 3 种类型:

- 内置工具:Dify 第一方提供的工具,使用该工具前可能需要先给工具进行 授权。

- 自定义工具:如果内置工具无法满足使用需求,你可以在 Dify 菜单导航 —工具,内创建自定义工具。你可以通过 OpenAPI/Swagger 标准格式导入或配置的工具,但在此之前你需要预先提供自定义服务器端,Http 协议的接口,让 Dify 进行调用。

- 工作流:你可以编排一个更复杂的工作流,并将其发布为工具。详细说明请参考工具配置说明。

3.内置工具

内置工具可以点击“插件”、“市场”,通过浏览或搜索进行安装,如下图所示:

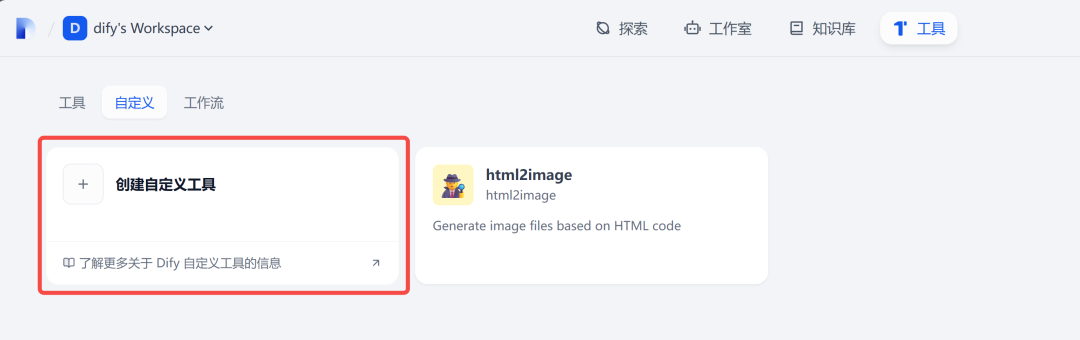

4.自定义工具

自定义工具实现分为以下两步:

- HTTP 协议的自定义服务器端,用于处理某个业务逻辑。

- 使用 OpenAPI/Swagger 协议将其添加到 Dify 中。

自定义的服务器端使用任何语言都可以,只要是 HTTP 协议即可,OpenAI/Swagger 协议如下。

例如添加一个天气预报的协议:

配置如下:

{

"openapi": "3.1.0",

"info": {

"title": "Get weather data",

"description": "Retrieves current weather data for a location.",

"version": "v1.0.0"

},

"servers": [

{

"url": "https://weather.example.com"

}

],

"paths": {

"/location": {

"get": {

"description": "Get temperature for a specific location",

"operationId": "GetCurrentWeather",

"parameters": [

{

"name": "location",

"in": "query",

"description": "The city and state to retrieve the weather for",

"required": true,

"schema": {

"type": "string"

}

}

],

"deprecated": false

}

}

},

"components": {

"schemas": {}

}

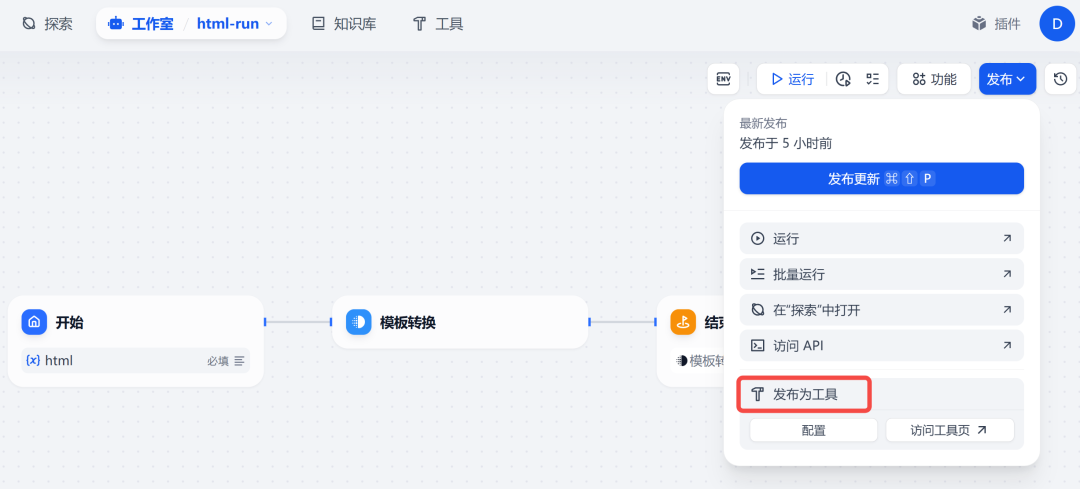

}5.工作流

工作流就是将 Dify 中创建的 WorkFlow 发布为工具,让 Dify 其他地方进行调用:

小结

工具是扩展大模型能力边界的主要手段,也是实现复杂任务的核心机制,正确、灵活的使用工具是我们开发 AI 应用中必不可少的技能。一起行动起来,体验一下 Dify 中好玩又有用的这些插件吧。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

5.免费获取(扫下方二v码即可100%领取)

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?