Admix方法针对mixup在对抗攻击中的局限性进行改进,通过保留主图像标签并融合少量其他类图像来提升对抗样本的可迁移性。相比mixup的线性插值,admix不改变原始标签且生成更多样化的图像,通过调整混合比例和图像数量计算平均梯度来优化攻击效果。实验表明admix能有效解决mixup在白盒攻击性能下降和迁移性提升不足的问题。代码实现简单但需调试兼容性。

Wang, **aosen, et al. "Admix: Enhancing the transferability of adversarial attacks." Proceedings of the IEEE/CVF international conference on computer vision. 2021.

Admix是在mixup方法上进行改进。

发现的问题是在使用mixup制造对抗样本时,白盒设置下的攻击性能明显下降,可迁移性提升不大。原因有两点:一是混合时x和x'![]() 之间没有差异,这可能会在输入x的梯度计算时使用过多的外界图像x'

之间没有差异,这可能会在输入x的梯度计算时使用过多的外界图像x'![]() 的信息,从而为更新提供错误的方向。二是当x和x'

的信息,从而为更新提供错误的方向。二是当x和x'![]() 不在同一类别时,mixup还将引入其他类别梯度的标签进行混合更新。

不在同一类别时,mixup还将引入其他类别梯度的标签进行混合更新。

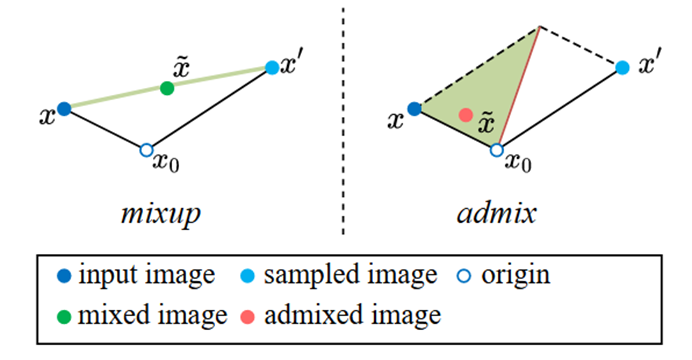

Mixup:(x, y) 和 (x′, y′) ,其中 λ ∈ [0, 1]

![]()

提出新方法:不同于mixup将两幅图像同等对待,并将其标签进行相应的混合,admix是将其他类别的小部分图像添加到原始图像,但不改变标签。

Admix:

![]()

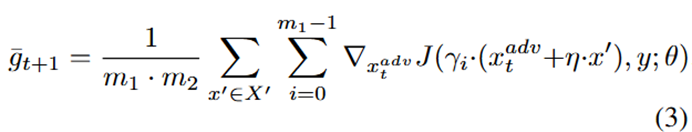

其中η = η′/γ, γ ∈ [0, 1] 和 η′ ∈ [0, γ),分别控制原始图像和随机采样图像的部分。

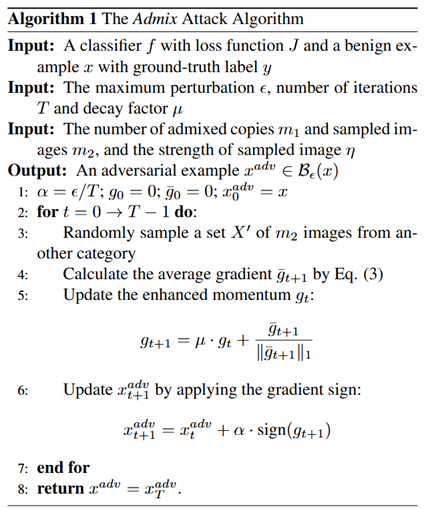

由此提出一种Admix的攻击方法,通过改变γ的值或从不同类中提取图像x′,来计算混合图像的平均梯度。

其中m1代表添加的混合图像的个数;X′表示从其他类别中随机抽取的m2幅图像组成的集合;

总结:

1)mixup的目标是提高训练好的DNNs的泛化性,而admix的目标是生成更多可迁移的对抗样本。

2)mixup平等对待x和x′,同时混合x和x′的标签。相比之下,admix将x作为主成分,合并少部分x′,同时保持x的标签。

3)如图所示,mixup对x和x′进行线性插值,admix则没有这样的约束,变换后的图像更加多样化。

代码复现

代码见文章,实施很简单,但是需要对一些老版本的库进行调试。

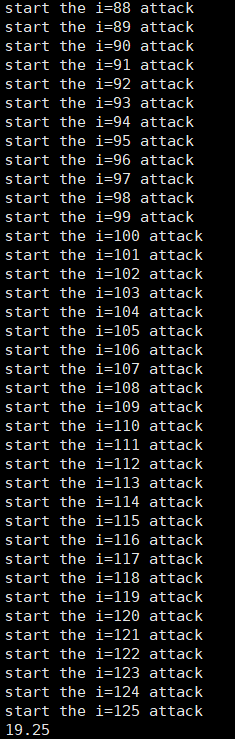

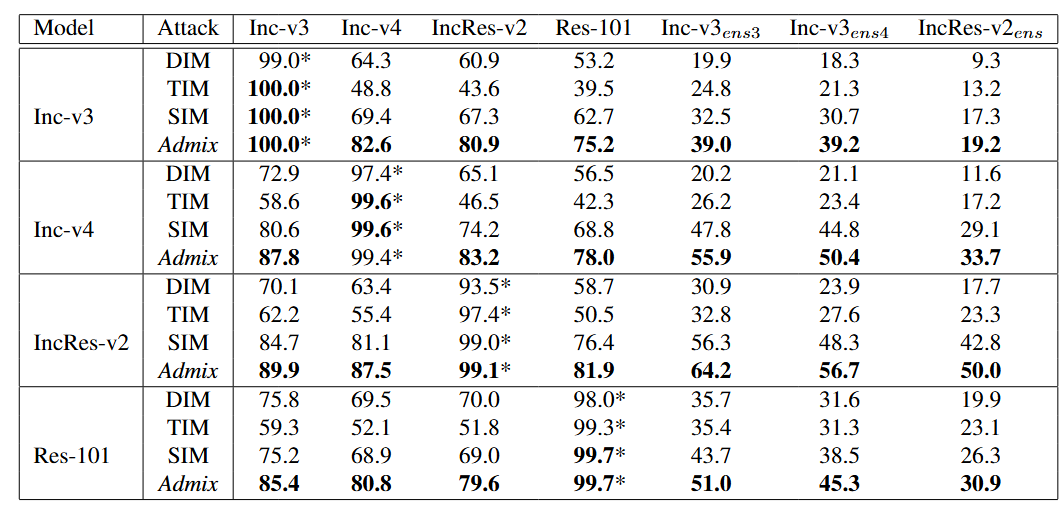

采用模型Inc-v3作为输入变换模型。

总图像1000张,每次8张,一共攻击125次,最后得到的平均L2扰动距离为19.25,表明攻击在隐蔽性和有效性之间取得了不错的平衡。

测试结果和实验结果基本一致。

3691

3691

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?