📌 一句话总结:

本工作提出 EAG-RL(Expert-Attention Guided Reinforcement Learning) 框架,通过专家注意力引导的强化学习,显著提升大语言模型在电子病历(EHR)推理任务中的内在临床推理能力与泛化性能。

🔍 背景问题:

当前大语言模型虽在医学文本理解任务中表现优异,但在 EHR-based 临床预测 上仍存在明显短板:

1️⃣ 结构差异问题:EHR 数据具有强时序性与高维结构,LLM 难以直接建模;

2️⃣ 范式割裂问题:多数方法采用“LLM 检索 + 深度模型预测”的混合模式,LLM 仅作为“前端先验”,无法提升自身的推理能力;

3️⃣ 泛化瓶颈:传统 EHR 模型依赖固定输入结构,跨机构与跨场景泛化差。

因此,如何让 LLM 学会像医生一样 基于病历进行循证推理(Hypothetico-Deductive Reasoning),成为关键挑战。

💡 方法简介:

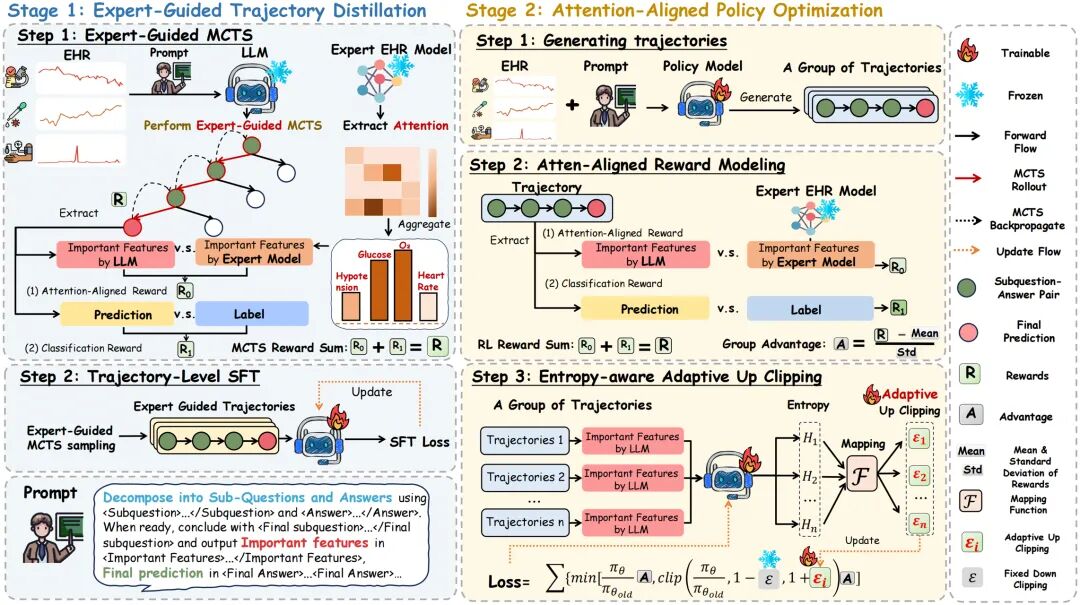

EAG-RL 创新性地提出 两阶段强化学习框架,将医学专家模型的“注意力”注入 LLM 的推理过程:

Stage 1:Expert-Guided Trajectory Distillation

通过专家模型引导的 蒙特卡洛树搜索(MCTS) 构建高质量的逐步推理轨迹,让模型学会医生式的“提问-回答-总结”思考链。

Stage 2:Attention-Aligned Policy Optimization

在强化学习阶段,引入两种核心机制:

🩺 Attention-Aligned Reward —— 利用专家模型的注意力模式作为辅助奖励,引导模型关注临床关键特征;

🔄 Entropy-Aware Adaptive Up-Clipping —— 自适应地调整探索强度,鼓励模型关注不确定但潜在有用的特征。

该框架通过 “专家注意力蒸馏 + 强化学习策略优化” 双管齐下,实现了 LLM 在临床推理层面的本质强化。

📊 实验结果:

在 MIMIC-IV 与 TJH 两个真实 EHR 数据集上,EAG-RL 平均提升 14.62% 的预测性能(AUPRC),在 死亡预测 与 再入院预测 任务上均显著优于 SFT、GRPO、DAPO 等最新基线。

跨数据集泛化:在从 MIMIC-IV 迁移至 TJH 的实验中,EAG-RL 保持稳定性能,展示出强大的 领域适应能力。

鲁棒性测试:在随机扰动 EHR 特征顺序时,EAG-RL 依然保持高 AUROC,相比专家模型 Concare 明显更稳健。

消融实验 进一步验证:无论去掉专家注意力奖励(R_att)还是自适应剪裁(ϵ(τ)),性能均明显下降,证明两模块缺一不可。

如何高效转型Al大模型领域?

作为一名在一线互联网行业奋斗多年的老兵,我深知持续学习和进步的重要性,尤其是在复杂且深入的Al大模型开发领域。为什么精准学习如此关键?

- 系统的技术路线图:帮助你从入门到精通,明确所需掌握的知识点。

- 高效有序的学习路径:避免无效学习,节省时间,提升效率。

- 完整的知识体系:建立系统的知识框架,为职业发展打下坚实基础。

AI大模型从业者的核心竞争力

- 持续学习能力:Al技术日新月异,保持学习是关键。

- 跨领域思维:Al大模型需要结合业务场景,具备跨领域思考能力的从业者更受欢迎。

- 解决问题的能力:AI大模型的应用需要解决实际问题,你的编程经验将大放异彩。

以前总有人问我说:老师能不能帮我预测预测将来的风口在哪里?

现在没什么可说了,一定是Al;我们国家已经提出来:算力即国力!

未来已来,大模型在未来必然走向人类的生活中,无论你是前端,后端还是数据分析,都可以在这个领域上来,我还是那句话,在大语言AI模型时代,只要你有想法,你就有结果!只要你愿意去学习,你就能卷动的过别人!

现在,你需要的只是一份清晰的转型计划和一群志同道合的伙伴。作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

233

233

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?