一、自动化配置与批量操作。

转换获取数据的单位

def bytes_to_readable(num):

“”“将字节数转换为易读的格式”“”

units = [‘B’, ‘KB’, ‘MB’, ‘GB’, ‘TB’]

unit_index = 0

while num >= 1024 and unit_index < len(units) - 1:

num /= 1024.0

unit_index += 1

return f"{num:.2f} {units[unit_index]}"

-

批量配置网络设备

场景:通过SSH批量配置路由器/交换机,提升效率。

工具:Paramiko(SSH协议库)

代码示例:import paramiko devices = \[{'ip': '192.168.1.1', 'username': 'admin', 'password': 'password'}, ...\] commands = \['interface GigabitEthernet0/1', 'ip address 192.168.1.10 255.255.255.0'\] def configure\_device(device, commands): ssh = paramiko.SSHClient() ssh.connect(device\['ip'\], username=device\['username'\], password=device\['password'\]) for cmd in commands: ssh.exec\_command(cmd) ssh.close() for device in devices: configure\_device(device, commands)说明:通过遍历设备列表执行配置命令,适用于更新ACL、接口配置等任务。

-

自动化部署LVS+Keepalived

场景:一键部署负载均衡集群。

工具:Ansible集成 + Shell命令调用

代码片段:import os def deploy\_lvs(): os.system('yum install ipvsadm -y') os.system('ipvsadm -A -t 192.168.1.250:80 -s rr') os.system('ipvsadm -a -t 192.168.1.250:80 -r 192.168.1.144:80 -g') # 配置Keepalived并启动服务说明:结合Ansible和Shell脚本实现集群自动化配置,适合高可用环境搭建。

二、系统监控与告警

-

实时监控进程内存占用

场景:统计所有进程的RSS内存总和。

工具:os.popen执行系统命令

代码示例:import os sum\_mem = 0 output = os.popen('ps aux').read().splitlines() for line in output\[1:\]: # 跳过标题行 rss = int(line.split()\[5\]) # RSS列 sum\_mem += rss print(f"总内存占用: {sum\_mem} KB")说明:用于快速定位内存泄漏或异常进程。

-

端口存活检测与自动重启服务

场景:监控HTTP服务端口,异常时重启并邮件通知。

工具:socket+smtplib

代码片段:import socket, smtplib def check\_port(ip, port): sock = socket.socket() result = sock.connect\_ex((ip, port)) return result == 0 if not check\_port('localhost', 80): os.system('systemctl restart httpd') # 发送邮件通知 server = smtplib.SMTP('smtp.example.com') server.sendmail('alert@example.com', 'admin@example.com', 'HTTP服务已重启')说明:结合定时任务(如Cron)实现周期性检测。

三、日志分析与处理

-

统计日志中IP访问量

场景:分析Nginx日志,统计每个IP的请求次数。

工具:collections.defaultdict

代码示例:from collections import defaultdict ip\_counts = defaultdict(int) with open('/var/log/nginx/access.log') as f: for line in f: ip = line.split()\[0\] ip\_counts\[ip\] += 1 for ip, count in ip\_counts.items(): print(f"{ip}: {count}次")说明:快速识别恶意IP或流量高峰来源。

-

日志异常检测与可视化

场景:使用Pandas分析错误日志频率并生成图表。

工具:pandas+matplotlib

代码片段:import pandas as pd import matplotlib.pyplot as plt logs = pd.read\_csv('error.log', sep=' ', names=\['timestamp', 'level', 'message'\]) error\_counts = logs\[logs\['level'\] == 'ERROR'\].groupby('message').size() error\_counts.plot(kind='bar') plt.savefig('error\_report.png')说明:适用于周期性生成运维报告。

四、文件与目录管理

-

批量清理过期日志文件

场景:删除超过30天的日志文件。

工具:os+time

代码示例:import os, time log\_dir = '/var/log/app' now = time.time() for fname in os.listdir(log\_dir): filepath = os.path.join(log\_dir, fname) if os.stat(filepath).st\_mtime < now - 30\*86400: os.remove(filepath)说明:结合定时任务实现自动化清理。

-

目录遍历与文件搜索

场景:查找指定名称的文件并返回绝对路径。

工具:os.walk

代码示例:import os def find\_file(start\_dir, target\_file): for root, dirs, files in os.walk(start\_dir): if target\_file in files: print(os.path.join(root, target\_file)) find\_file('/etc', 'nginx.conf')说明:快速定位配置文件或特定日志。

五、进阶场景:云原生与AIOps

-

Kubernetes集群监控

场景:使用Python调用K8s API获取Pod状态。

工具:kubernetes库

代码片段:from kubernetes import client, config config.load\_kube\_config() v1 = client.CoreV1Api() pods = v1.list\_pod\_for\_all\_namespaces().items for pod in pods: print(f"{pod.metadata.name}: {pod.status.phase}")说明:集成Prometheus实现自定义监控面板。

-

智能日志分析(AIOps)

场景:使用AI模型自动分类日志错误类型。

工具:scikit-learn+ 日志数据集

步骤:-

提取日志关键词(如

error_code、request_id) -

训练分类模型(如随机森林)

-

自动化标记高优先级告警7。

-

六、工具与库推荐

-

远程操作:Paramiko(SSH)、Fabric(批量任务)

-

配置管理:Ansible Python API

-

监控:Prometheus Client、psutil(系统资源)

-

日志处理:ELK Stack集成、Pandas

-

云原生:Kubernetes Python Client、OpenStack SDK。

实践建议

-

从脚本化到工具化:将常用脚本封装为命令行工具(如使用

argparse)。 -

结合定时任务:通过Cron或Airflow调度周期性任务。

-

版本控制:将运维脚本纳入Git管理,确保可追溯性。

-

安全性:敏感信息(如SSH密码)使用Vault或环境变量存储。

Python编写的Zabbix监控脚本,支持通过命令行参数获取网络接口、CPU、内存、磁盘等信息,并封装成可直接执行的命令行工具:

#!/usr/bin/env python3

# -\*- coding: utf-8 -\*-

# 文件名:zabbix\_source.py

import argparse

import psutil

import time

import sys

class SystemMonitor:

def \_\_init\_\_(self):

pass

def get\_network\_usage(self, interface, duration=1):

"""获取指定网络接口流量统计"""

stats = psutil.net\_io\_counters(pernic=True).get(interface)

if not stats:

raise ValueError(f"Interface {interface} not found")

return {

'bytes\_sent': stats.bytes\_sent,

'bytes\_recv': stats.bytes\_recv,

'packets\_sent': stats.packets\_sent,

'packets\_recv': stats.packets\_recv

}

def get\_cpu\_usage(self, interval=1):

"""获取CPU使用率"""

return psutil.cpu\_percent(interval=interval)

def get\_memory\_usage(self):

"""获取内存使用情况"""

mem = psutil.virtual\_memory()

return {

'total': mem.total,

'available': mem.available,

'used': mem.used,

'percent': mem.percent

}

def get\_disk\_usage(self, device):

"""获取指定磁盘使用情况"""

partitions = psutil.disk\_partitions()

for part in partitions:

if part.device == device:

usage = psutil.disk\_usage(part.mountpoint)

io = psutil.disk\_io\_counters(perdisk=True).get(device.split('/')\[-1\])

return {

'total': usage.total,

'used': usage.used,

'free': usage.free,

'percent': usage.percent,

'read\_count': io.read\_count if io else 0,

'write\_count': io.write\_count if io else 0

}

raise ValueError(f"Device {device} not found")

def main():

parser = argparse.ArgumentParser(

description='Zabbix System Monitor Tool',

formatter\_class=argparse.RawTextHelpFormatter

)

group = parser.add\_mutually\_exclusive\_group(required=True)

group.add\_argument('-n', '--network', metavar='INTERFACE',

help='Monitor network interface (e.g. ens33)')

group.add\_argument('-c', '--cpu', action='store\_true',

help='Monitor CPU usage')

group.add\_argument('-m', '--memory', action='store\_true',

help='Monitor memory usage')

group.add\_argument('-d', '--disk', metavar='DEVICE',

help='Monitor disk usage (e.g. /dev/sda)')

args = parser.parse\_args()

monitor = SystemMonitor()

try:

if args.network:

data = monitor.get\_network\_usage(args.network)

print(f"bytes\_sent:{data\['bytes\_sent'\]}")

print(f"bytes\_recv:{data\['bytes\_recv'\]}")

elif args.cpu:

usage = monitor.get\_cpu\_usage()

print(f"cpu\_usage:{usage:.1f}%")

elif args.memory:

mem = monitor.get\_memory\_usage()

print(f"mem\_total:{mem\['total'\]}")

print(f"mem\_used:{mem\['used'\]}")

print(f"mem\_percent:{mem\['percent'\]:.1f}%")

elif args.disk:

disk = monitor.get\_disk\_usage(args.disk)

print(f"disk\_total:{disk\['total'\]}")

print(f"disk\_used:{disk\['used'\]}")

print(f"disk\_percent:{disk\['percent'\]:.1f}%")

except Exception as e:

print(f"ERROR: {str(e)}", file=sys.stderr)

sys.exit(1)

if \_\_name\_\_ == '\_\_main\_\_':

main()

使用说明:

- 安装依赖:

pip install psutil

- 设置可执行权限:

chmod +x zabbix\_source.py

- 创建系统级软链接:

sudo ln -s $(pwd)/zabbix\_source.py /usr/local/bin/zabbix-source

- 使用示例:

- 监控网络接口:

zabbix-source -n ens33

# 输出示例:

# bytes\_sent:18446744073709551615

# bytes\_recv:18446744073709551615

- 监控CPU使用率:

zabbix-source -c

# 输出示例:

# cpu\_usage:12.3%

- 监控内存使用:

zabbix-source -m

# 输出示例:

# mem\_total:16688427008

# mem\_used:9124454400

# mem\_percent:54.7%

- 监控磁盘使用:

zabbix-source -d /dev/sda1

# 输出示例:

# disk\_total:21474836480

# disk\_used:6442450944

# disk\_percent:30.0%

与Zabbix集成步骤:

- 配置Zabbix Agent:

sudo vim /etc/zabbix/zabbix\_agentd.conf

# 添加以下自定义监控项:

UserParameter=custom.net\[\*\], zabbix-source -n $1

UserParameter=custom.cpu, zabbix-source -c

UserParameter=custom.mem, zabbix-source -m

UserParameter=custom.disk\[\*\], zabbix-source -d $1

- 重启Zabbix Agent:

sudo systemctl restart zabbix-agent

- 在Zabbix Web界面创建监控项:

-

网络监控项键值:

custom.net["ens33"] -

CPU监控项键值:

custom.cpu -

内存监控项键值:

custom.mem -

磁盘监控项键值:

custom.disk["/dev/sda1"]

脚本特点:

-

使用Python标准库和psutil实现跨平台支持

-

互斥参数设计确保单次调用只获取一类指标

-

支持输出多指标值(网络和内存返回多组数据)

-

完善的错误处理机制

-

数值输出直接适配Zabbix的自动发现机制

-

支持所有主流Linux发行版(需要Python 3.6+)

性能优化建议:

-

对于高频采集场景,可以添加缓存机制

-

对于需要实时IO统计的监控项,可以增加采样间隔参数

-

对于大规模部署,建议使用二进制打包(如pyinstaller)提升执行效率

扩展功能(可根据需要添加):

-

增加温度监控支持

-

添加进程监控功能

-

支持JSON格式输出

-

增加历史数据记录功能

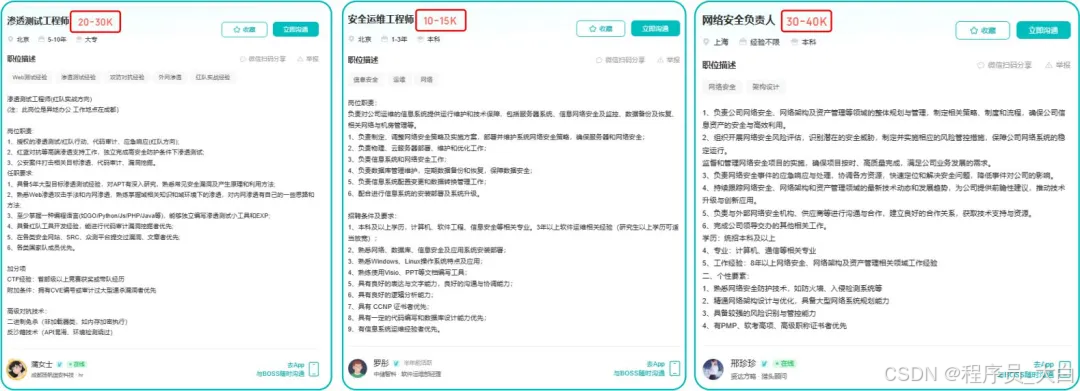

这两年,IT行业面临经济周期波动与AI产业结构调整的双重压力,确实有很多运维与网络工程师因企业缩编或技术迭代而暂时失业。

很多人都在提运维网工失业后就只能去跑滴滴送外卖了,但我想分享的是,对于运维人员来说,即便失业以后仍然有很多副业可以尝试。

运维副业方向

运维,千万不要再错过这些副业机会!

第一个是知识付费类副业:输出经验打造个人IP

在线教育平台讲师

操作路径:在慕课网、极客时间等平台开设《CCNA实战》《Linux运维从入门到精通》等课程,或与培训机构合作录制专题课。

收益模式:课程销售分成、企业内训。

技术博客与公众号运营

操作路径:撰写网络协议解析、故障排查案例、设备评测等深度文章,通过公众号广告、付费专栏及企业合作变现。

收益关键:每周更新2-3篇原创,结合SEO优化与社群运营。

第二个是技术类副业:深耕专业领域变现

企业网络设备配置与优化服务

操作路径:为中小型企业提供路由器、交换机、防火墙等设备的配置调试、性能优化及故障排查服务。可通过本地IT服务公司合作或自建线上接单平台获客。

收益模式:按项目收费或签订年度维护合同。

远程IT基础设施代维

操作路径:通过承接服务器监控、日志分析、备份恢复等远程代维任务。适合熟悉Zabbix、ELK等技术栈的工程师。

收益模式:按工时计费或包月服务。

网络安全顾问与渗透测试

操作路径:利用OWASP Top 10漏洞分析、Nmap/BurpSuite等工具,为企业提供漏洞扫描、渗透测试及安全加固方案。需考取CISP等认证提升资质。

收益模式:单次渗透测试报告收费;长期安全顾问年费。

比如不久前跟我一起聊天的一个粉丝,他自己之前是大四实习的时候做的运维,发现运维7*24小时待命受不了,就准备转网安,学了差不多2个月,然后开始挖漏洞,光是补天的漏洞奖励也有个四五千,他说自己每个月的房租和饭钱就够了。

为什么我会推荐你网安是运维人员的绝佳副业&转型方向?

1.你的经验是巨大优势: 你比任何人都懂系统、网络和架构。漏洞挖掘、内网渗透、应急响应,这些核心安全能力本质上是“攻击视角下的运维”。你的运维背景不是从零开始,而是降维打击。

2.越老越吃香,规避年龄危机: 安全行业极度依赖经验。你的排查思路、风险意识和对复杂系统的理解能力,会随着项目积累而愈发珍贵,真正做到“姜还是老的辣”。

3.职业选择极其灵活: 你可以加入企业成为安全专家,可以兼职“挖洞“获取丰厚奖金,甚至可以成为自由顾问。这种多样性为你提供了前所未有的抗风险能力。

4.市场需求爆发,前景广阔: 在国家级政策的推动下,从一线城市到二三线地区,安全人才缺口正在急剧扩大。现在布局,正是抢占未来先机的黄金时刻。

运维转行学习路线

(一)第一阶段:网络安全筑基

1. 阶段目标

你已经有运维经验了,所以操作系统、网络协议这些你不是零基础。但要学安全,得重新过一遍——只不过这次我们是带着“安全视角”去学。

2. 学习内容

**操作系统强化:**你需要重点学习 Windows、Linux 操作系统安全配置,对比运维工作中常规配置与安全配置的差异,深化系统安全认知(比如说日志审计配置,为应急响应日志分析打基础)。

**网络协议深化:**结合过往网络协议应用经验,聚焦 TCP/IP 协议簇中的安全漏洞及防护机制,如 ARP 欺骗、TCP 三次握手漏洞等(为 SRC 漏扫中协议层漏洞识别铺垫)。

**Web 与数据库基础:**补充 Web 架构、HTTP 协议及 MySQL、SQL Server 等数据库安全相关知识,了解 Web 应用与数据库在网安中的作用。

**编程语言入门:**学习 Python 基础语法,掌握简单脚本编写,为后续 SRC 漏扫自动化脚本开发及应急响应工具使用打基础。

**工具实战:**集中训练抓包工具(Wireshark)、渗透测试工具(Nmap)、漏洞扫描工具(Nessus 基础版)的使用,结合模拟场景练习工具应用(掌握基础扫描逻辑,为 SRC 漏扫工具进阶做准备)。

(二)第二阶段:漏洞挖掘与 SRC 漏扫实战

1. 阶段目标

这阶段是真正开始“动手”了。信息收集、漏洞分析、工具联动,一样不能少。

熟练运用漏洞挖掘及 SRC 漏扫工具,具备独立挖掘常见漏洞及 SRC 平台漏扫实战能力,尝试通过 SRC 挖洞搞钱,不管是低危漏洞还是高危漏洞,先挖到一个。

2. 学习内容

信息收集实战:结合运维中对网络拓扑、设备信息的了解,强化基本信息收集、网络空间搜索引擎(Shodan、ZoomEye)、域名及端口信息收集技巧,针对企业级网络场景开展信息收集练习(为 SRC 漏扫目标筛选提供支撑)。

漏洞原理与分析:深入学习 SQL 注入、CSRF、文件上传等常见漏洞的原理、危害及利用方法,结合运维工作中遇到的类似问题进行关联分析(明确 SRC 漏扫重点漏洞类型)。

工具进阶与 SRC 漏扫应用:

-

系统学习 SQLMap、BurpSuite、AWVS 等工具的高级功能,开展工具联用实战训练;

-

专项学习 SRC 漏扫流程:包括 SRC 平台规则解读(如漏洞提交规范、奖励机制)、漏扫目标范围界定、漏扫策略制定(全量扫描 vs 定向扫描)、漏扫结果验证与复现;

-

实战训练:使用 AWVS+BurpSuite 组合开展 SRC 平台目标漏扫,练习 “扫描 - 验证 - 漏洞报告撰写 - 平台提交” 全流程。

SRC 实战演练:选择合适的 SRC 平台(如补天、CNVD)进行漏洞挖掘与漏扫实战,积累实战经验,尝试获取挖洞收益。

恭喜你,如果学到这里,你基本可以下班搞搞副业创收了,并且具备渗透测试工程师必备的「渗透技巧」、「溯源能力」,让你在黑客盛行的年代别背锅,工作实现升职加薪的同时也能开创副业创收!

如果你想要入坑黑客&网络安全,笔者给大家准备了一份:全网最全的网络安全资料包需要保存下方图片,微信扫码即可前往获取!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

优快云大礼包:《黑客&网络安全入门&进阶学习资源包》免费分享

(三)第三阶段:渗透测试技能学习

1. 阶段目标

全面掌握渗透测试理论与实战技能,能够独立完成渗透测试项目,编写规范的渗透测试报告,具备渗透测试工程师岗位能力,为护网红蓝对抗及应急响应提供技术支撑。

2. 学习内容

渗透测试核心理论:系统学习渗透测试流程、方法论及法律法规知识,明确渗透测试边界与规范(与红蓝对抗攻击边界要求一致)。

实战技能训练:开展漏洞扫描、漏洞利用、电商系统渗透测试、内网渗透、权限提升(Windows、Linux)、代码审计等实战训练,结合运维中熟悉的系统环境设计测试场景(强化红蓝对抗攻击端技术能力)。

工具开发实践:基于 Python 编程基础,学习渗透测试工具开发技巧,开发简单的自动化测试脚本(可拓展用于 SRC 漏扫自动化及应急响应辅助工具)。

报告编写指导:学习渗透测试报告的结构与编写规范,完成多个不同场景的渗透测试报告撰写练习(与 SRC 漏洞报告、应急响应报告撰写逻辑互通)。

(四)第四阶段:企业级安全攻防(含红蓝对抗)、应急响应

1. 阶段目标

掌握企业级安全攻防、护网红蓝对抗及应急响应核心技能,考取网安行业相关证书。

2. 学习内容

护网红蓝对抗专项:

-

红蓝对抗基础:学习护网行动背景、红蓝对抗规则(攻击范围、禁止行为)、红蓝双方角色职责(红队:模拟攻击;蓝队:防御检测与应急处置);

-

红队实战技能:强化内网渗透、横向移动、权限维持、免杀攻击等高级技巧,模拟护网中常见攻击场景;

-

蓝队实战技能:学习安全设备(防火墙、IDS/IPS、WAF)联动防御配置、安全监控平台(SOC)使用、攻击行为研判与溯源方法;

-

模拟护网演练:参与团队式红蓝对抗演练,完整体验 “攻击 - 检测 - 防御 - 处置” 全流程。

应急响应专项: -

应急响应流程:学习应急响应 6 步流程(准备 - 检测 - 遏制 - 根除 - 恢复 - 总结),掌握各环节核心任务;

-

实战技能:开展操作系统入侵响应(如病毒木马清除、异常进程终止)、数据泄露应急处置、漏洞应急修补等实战训练;

-

工具应用:学习应急响应工具(如 Autoruns、Process Monitor、病毒分析工具)的使用,提升处置效率;

-

案例复盘:分析真实网络安全事件应急响应案例(如勒索病毒事件),总结处置经验。

其他企业级攻防技能:学习社工与钓鱼、CTF 夺旗赛解析等内容,结合运维中企业安全防护需求深化理解。

证书备考:针对网安行业相关证书考试内容(含红蓝对抗、应急响应考点)进行专项复习,参加模拟考试,查漏补缺。

运维转行网络攻防知识库分享

网络安全这行,不是会几个工具就能搞定的。你得有体系,懂原理,能实战。尤其是从运维转过来的,别浪费你原来的经验——你比纯新人强多了。

但也要沉得住气,别学了两天Web安全就觉得自己是黑客了。内网、域渗透、代码审计、应急响应,要学的还多着呢。

如果你真的想转,按这个路子一步步走,没问题。如果你只是好奇,我劝你再想想——这行要持续学习,挺累的,但也是真有意思。

关于如何学习网络安全,笔者也给大家整理好了全套网络安全知识库,需要的可以扫码获取!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

优快云大礼包:《黑客&网络安全入门&进阶学习资源包》免费分享

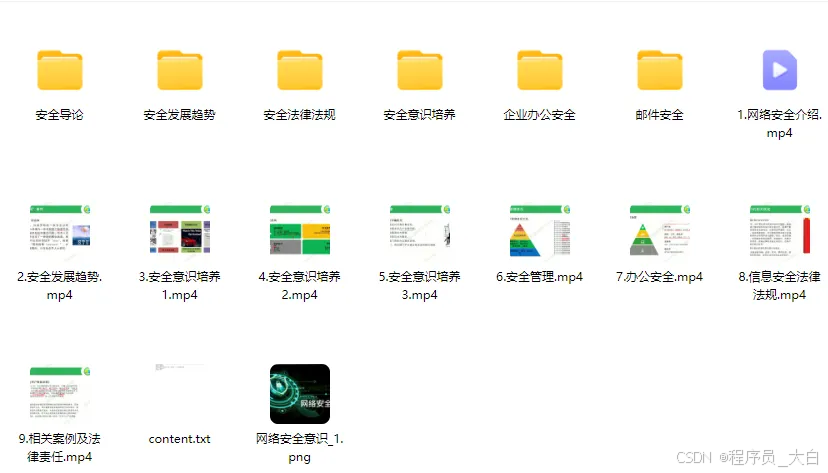

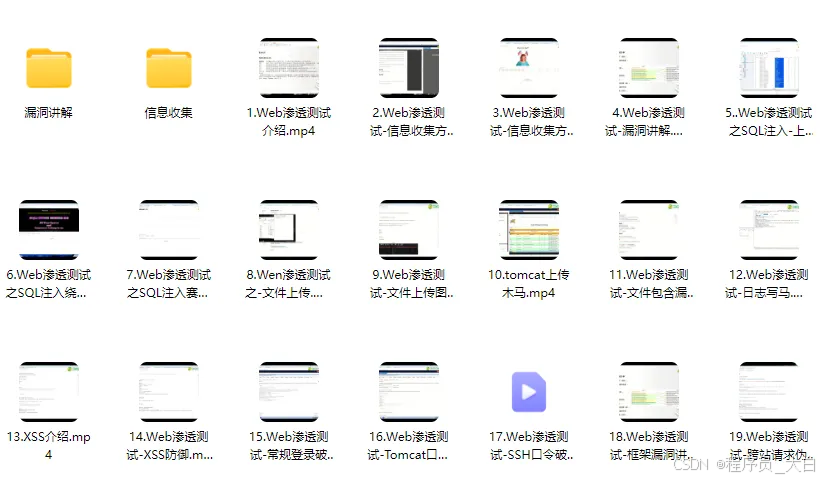

1、网络安全意识

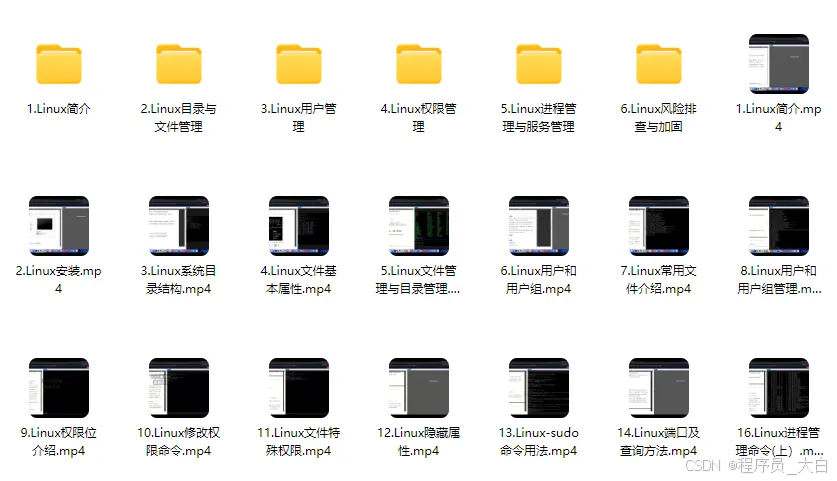

2、Linux操作系统

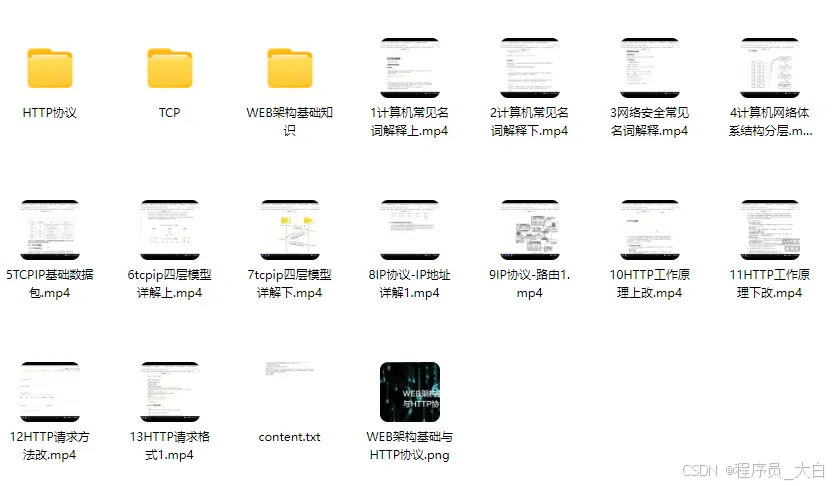

3、WEB架构基础与HTTP协议

4、Web渗透测试

5、渗透测试案例分享

6、渗透测试实战技巧

7、攻防对战实战

8、CTF之MISC实战讲解

关于如何学习网络安全,笔者也给大家整理好了全套网络安全知识库,需要的可以扫码获取!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2040

2040

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?