今年老美出了很多牛逼哄哄的大模型,比如Claude 4.5 、Gemini 3 Pro,但无一例外都限制咱们使用,Anthropic甚至不给国内企业接入其API服务,导致很多Vibe Coding产品一下子性能下降不少。

这是好事还是坏事?

短期是有影响,特别是一些依赖Claude模型的Agent、RAG、Code产品,但长期反而会帮了国内AI产品。

因为一个人越饥饿,越会自己寻找食物,很多强大是被“饿”出来的。

我看到有的回答指望openai的gpt、codex等产品去替代claude,但谁都不敢保证明天openai会不会像claude一样,来个360度大禁止,到时候哭都没眼泪。

这是一个警示,国内的AI产品应该要具备抗风险意识,同时采用国内国外两种技术方案并行模式。

比如你做一个Code应用,初期采用openai codex没问题,但要同时部署Qwen code、K2、GLM 4.5等国内模型,而且应该把重心放到国内模型上。

为什么说Anthropic一纸禁令,长期反而会帮了国内AI产业,因为我觉得LLM的有3个趋势不可逆的。

1、开源会成为主流

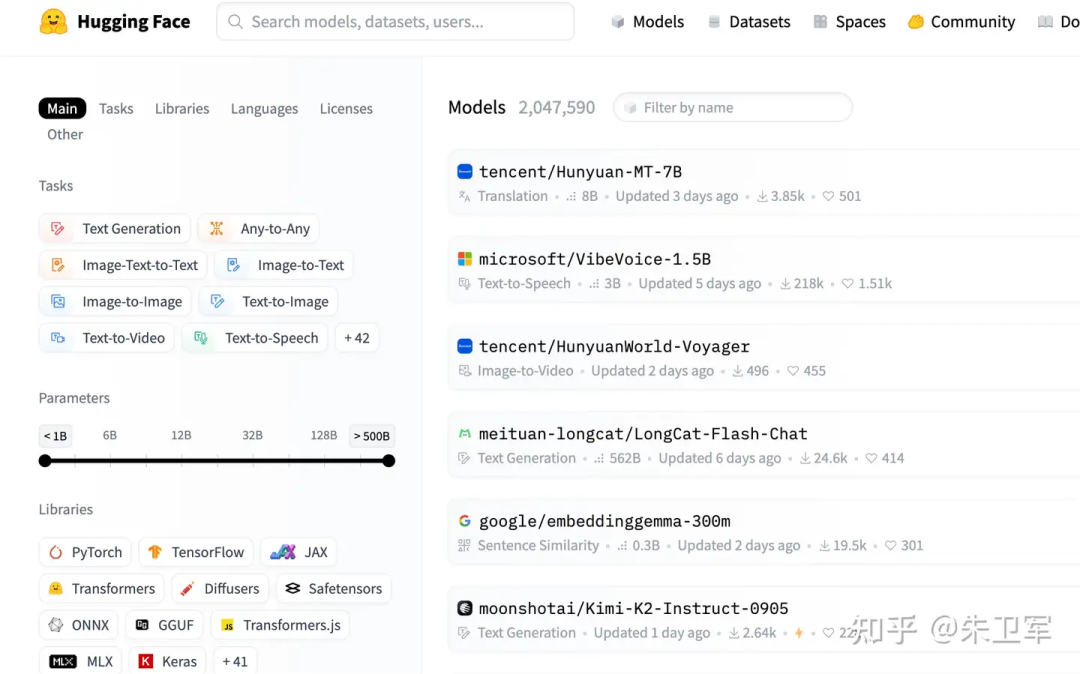

今年能明显的感觉到来自国内的开源模型登上LLM主舞台,huggingface经常会被国内的开源模型霸榜,比如Qwen、DeepsSeek、kimi等。

这极大的促进了AI的普及和民主化,不再被OpenAI、Gemini、Claude等少数几个闭源模型垄断,让更多人享受到AI的红利,OpenAI的连续降价说明这一点。

开源项目会有全球的开发者建言献策和贡献代码,比如DeepSeek就曾经收到大量开发者的优化建议,才有这样轰动一时的产品出现。

开源模型会被全球大量公司/个人应用,场景爆炸式增长,对于开源模型的正反馈也会越来越多。

所以长期来看,LLM开源项目进化速度会快于闭源模型,顶尖模型都会集中在开源,最终大家拼的是数据、产品和服务。

2、AI人才流动会加速

现在硅谷AI公司有数不清的华人工程师、科学家,OpenAI的GPT-5模型训练团队中,华人工程师占比高达57%,在为LLM发展贡献着巨大的价值。

最近前OpenAI研究员姚顺雨刚入职了腾讯,入职即高管。

Anthropic不接受华人员工、放弃中国市场是它自己的损失,因为AI人才在全球加速流动,意味着最先进的技术、最好的产品在流动,谁开放谁获利,谁封闭谁落伍。

3、AI发展会强绑定产业发展

LLM作为基座模型本身没有价值,只有服务于垂直产业才能创作价值,中国制造了全球35%的汽车、50%的船舶、70%的手机、80%的电脑,我不信Anthropic能封的住中国AI发展,因为AI发展主要是市场需求驱动的,而不是单单技术驱动的。

我很相信中国的AI公司会快速拉近同OpenAI、Anthropic、Google们的距离,有这么庞大的市场供它们淘金,从DeepSeek R1到Qwen3-Max-Preview、Kimi k2、GLM4.5、MiMo v2等,国内开源LLM发展非常之快。

让Anthropic们封锁去吧!

他强任他强,清风拂山岗; 他横任他横,明月照大江。

781

781

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?