Adaptive Hierarchical Down-Sampling for Point Cloud Classification

本文介绍一篇cvpr2020里面关于点云分类降采样的文章。

论文

没有开源代码

1. 问题

FPS的时间复杂度太高,类似Samplenet 的方法会产生新的点,随机采样无法保证重要的点被保留下来。所以本文提出了一种不产生新的点的采样方法。

2. 思想

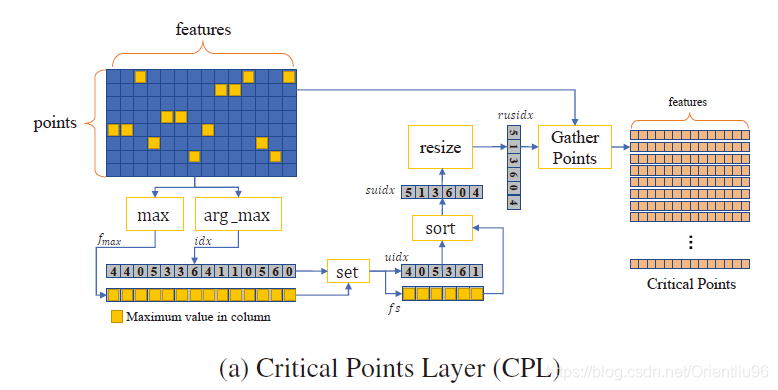

整体思想非常简单,借鉴pointnet中最后的maxpooling操作。将每个feature属性最max的点视为critical points,只保留这些点,从而完成sampling的操作,将其定义为Critical Points Layer。但是我们都知道,在batch 操作中,点的数目必须相同,所以他必须将采样之后点的数目固定,如果不够就进行upsampling。进一步考虑,有的点可能在10个feature channel上都是argmax,如何进一步体现其importance就需要weight。所以作者又提出了加强版Weighted Critical Points Layer,一个point是几个feature channel的argmax就将其重复几次,从而增大在downsa

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

889

889

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?