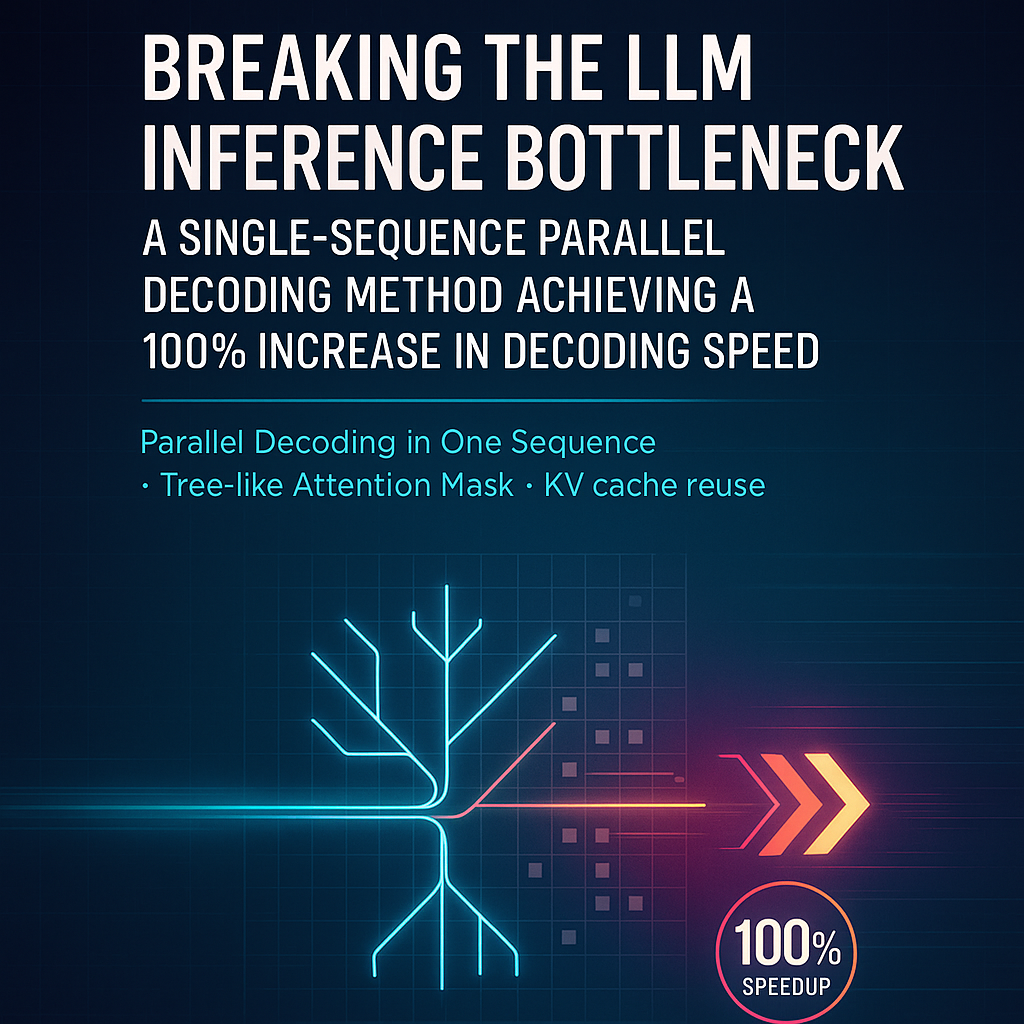

EMNLP2025 | 突破LLM推理瓶颈:单序列并行解码加速方法实现解码速度提升100%

【EMNLP论文速读】本论文旨在提出一种名为“单序列并行解码”(Parallel Decoding in One Sequence)的创新方法,通过一个特制的“树状”注意力掩码(Tree-like Attention Mask)在单个序列内实现多分支并行解码,以解决大型语言模型在处理可并行的推理任务 (Parallelizable Reasoning Tasks) 时因自回归机制导致的解码速度慢、计算与内存资源消耗大的核心瓶颈问题。

大型语言模型(LLM)在处理复杂推理任务时,其逐词元生成的自回归机制往往导致计算成本高昂和延迟过长,这一直是业界的核心痛点。针对该问题,OpenCSG算法团队的成员 Yijiong Yu 提出了一种名为“单序列并行解码”(Parallel Decoding in One Sequence)的创新解码加速方法。该方法的核心思想是利用特定任务中固有的可并行性,在不增加额外内存消耗和避免重置KV缓存的前提下,通过一个特制的注意力掩码(Attention Mask)在单个序列中一次性解码多个并行推理分支的多个词元(Token)。该方法通过利用任务中固有的可并行性,在单个序列内一次性解码多个并行推理分支,实现了在保持回答质量基本不变的前提下,解码速度超过100%的显著提升。

1. 引言与背景

大型语言模型(LLM)的自回归(Autoregressive)生成方式,即逐词元生成,是其强大能力的基石,但同时也构成了其在推理效率上的主要瓶颈。对于许多复杂任务(如多文档问答、多角度分析规划、对多个对象进行评估等),其推理过程天然包含多个可以并行处理、互不依赖的步骤。然而,传统的自回归解码迫使这些并行步骤被串行处理,极大地浪费了计算资源,并延长了等待时间。

现有的一些加速方法,如“思想骨架”(Skeleton-of-Thoughts, SoT),虽然尝试解决此问题,但存在明显缺陷:

- 资源消耗大:SoT依赖于批处理解码(Batch Decoding)或多次独立的API调用来并行处理各个骨架节点,这会导致计算量和内存需求(尤其是存储KV缓存)呈指数级增长。

- KV缓存效率低:SoT需要为不同生成阶段设计不同的Prompt模板,这妨碍了KV缓存的复用。

- 因果关系忽略:SoT将骨架中的每个节点都视为独立,可能忽略了某些节点间潜在的因果关系,缺乏灵活性。

此外,像MEDUSA这类方法需要为新模型

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5142

5142

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?