告别音色漂移!微软超长语音合成模型VibeVoice正式开源

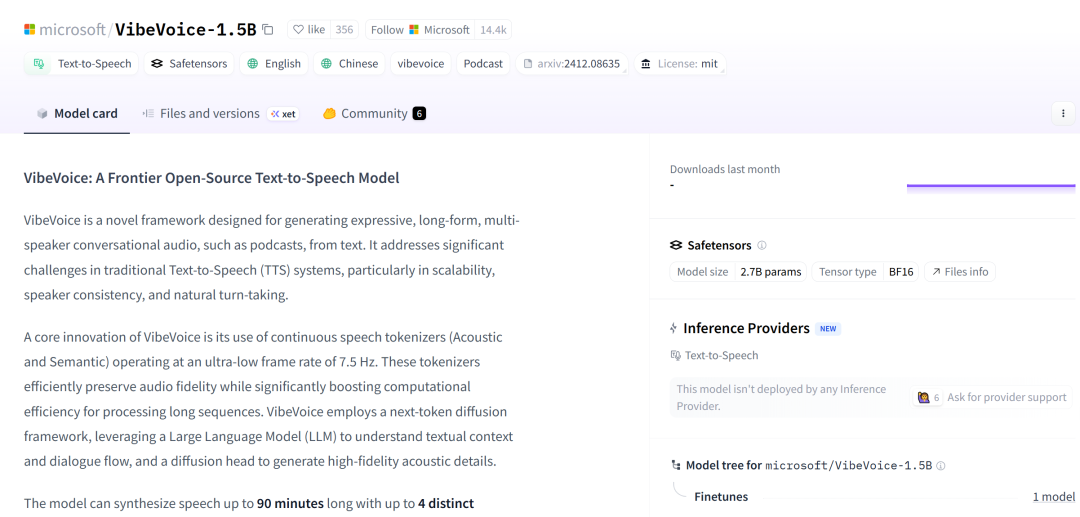

今日凌晨,AI语音合成领域迎来了一枚由微软研究院投下的“重磅炸弹”——VibeVoice-1.5B模型正式开源!

这不仅是一次简单的代码共享,更标志着长时、多speaker、高保真语音合成的技术壁垒被彻底击穿。它一举解决了困扰业界多年的三大难题:时长限制、音色漂移与多人交互,将AI语音生成的“天花板”提升到了一个前所未有的高度。

想象一下,让AI一键生成90分钟的有声书、一场多人参与的专题播客,甚至是一部广播剧的完整音频,期间多位主播谈笑风生、音色稳定、对话流畅,且无需任何后期剪辑——这,就是VibeVoice-1.5B为我们描绘的未来图景。

它的开源,无疑是为全球开发者和创作者送上了一份“大礼包”。无论是想打造下一代AI配音平台、开发沉浸式游戏叙事,还是构建多语言虚拟助手,VibeVoice都提供了此前难以想象的强大基础能力。

技术的边界已被刷新,AI语音合成的“GPT时刻”,或许真的来了。

架构介绍

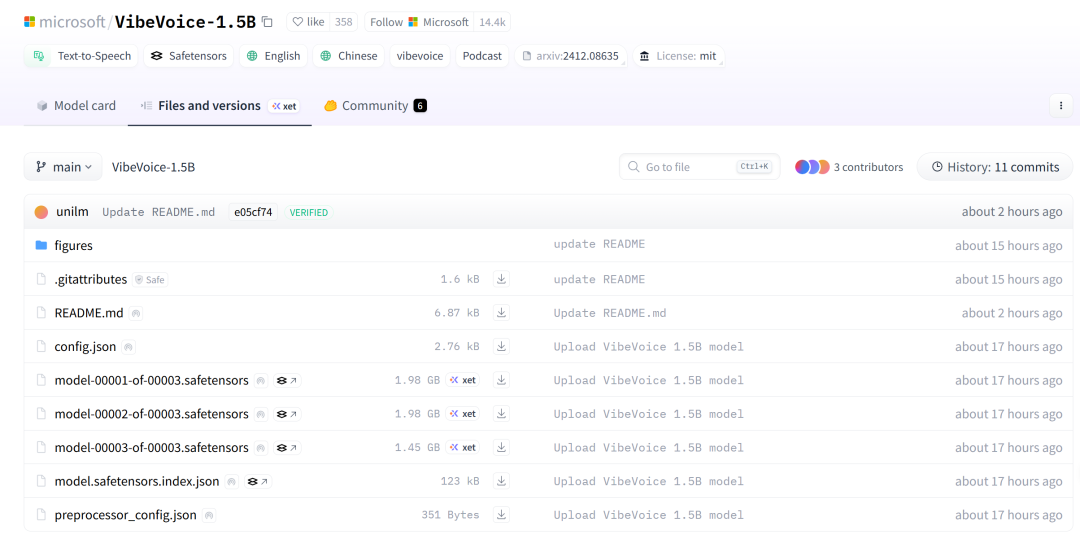

VibeVoice 的核心架构以 Qwen2.5-1.5B 语言模型为基座,通过多阶段建模与模块化设计实现了高质量、长序列的语音生成。系统主要由以下部分组成:

1. 语言模型骨干(LLM Backbone)

采用 Qwen2.5-1.5B 作为核心语言模型,负责理解和建模文本语义与对话结构,输出高层语义

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

201

201

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?