目录

鄙人生医转码,道行浅薄请多见谅~

感觉这里书上有点乱?首先一言以蔽之感知机的功能是主要功能是根据输入数据预测其所属的类别,起到了输入的激活判断作用,我感觉好像这里并不是讲的很仔细,可能要求不是很高,等到后面到更底层的时候再去仔细推导吧~

一、隐藏层

线性是一个很强制性的单调性假设

1.线性模型可能会出错

线性意味着任何特征的增大都会导致模型输出的增大or减小,然而在更加实际的问题中,很多东西并不是单调的,这意味着我们要做出一些改变

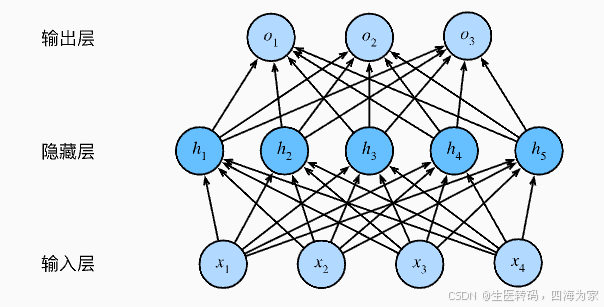

2.在网络中加入隐藏层

面对这种非线性问题我们的处理办法就是在网络中加入隐藏层:

这个称为多层感知机,比单纯二分类的感知机要多隐藏层和非线性激活函数两个部分。

3.从线性到非线性

这一部分主要讲了其实就是激活函数的作用,就是如果没有激活函数只是引入隐藏层的话实际上还是一个线性模型:

![]()

4.通用近似定理

多层感知机可以通过隐藏层中的神经元捕捉到输入之间的复杂相互作用,根据通用近似定理,即使是只有一个隐藏层的神经网络,只要有足够的神经元和正确的权重,就能够逼近任何函数。这使得多层感知机成为了通用的函数近似器,尽管单隐藏层网络可以逼近任何函数,但这并不意味着我们应该总是使用它,后续应该去用更多隐藏层的网络。

二、激活函数

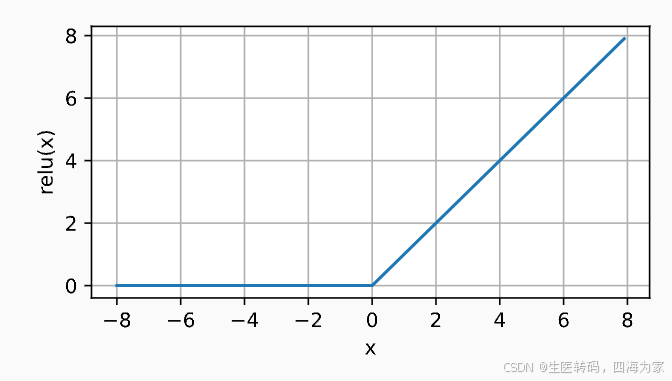

1.Relu函数

最受欢迎的激活函数:

![]()

该函数仅保留正元素并丢弃所有负元素:

当输入为负时,ReLU函数的导数为0,而当输入为正时,ReLU函数的导数为1 ,因此使用ReLU的原因是,它求导表现得特别好:要么让参数消失,要么让参数通过,当然relu还有很多变体···

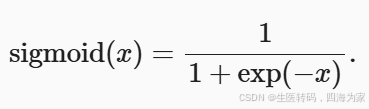

2.sigmoid函数

对于一个定义域在R中的输入,sigmoid函数将输入变换为区间(0,1)上的输出:

李沐老师说,sigmoid函数是一个更加soft的函数,相比于“单位阶跃信号”消失的0处导数:

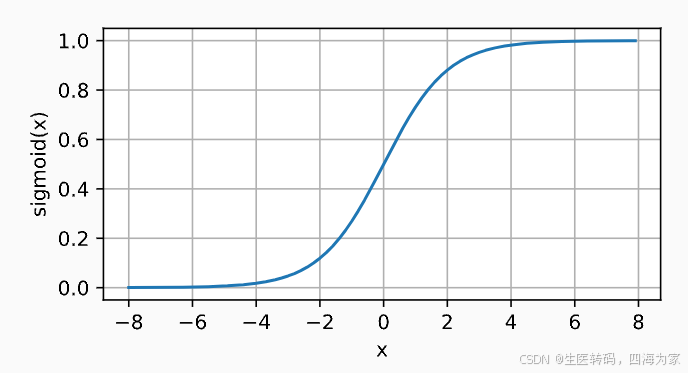

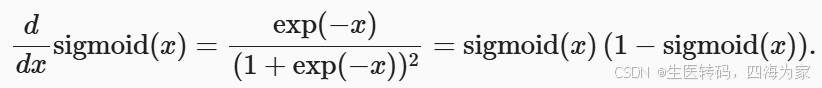

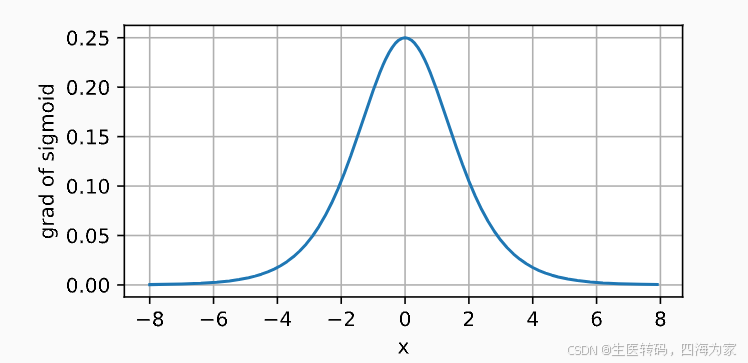

sigmoid函数的导数为下面的公式:

理所当然的sigmoid函数的导数图像如下所示:

3.tanh函数

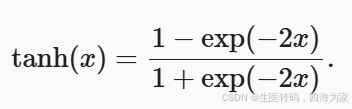

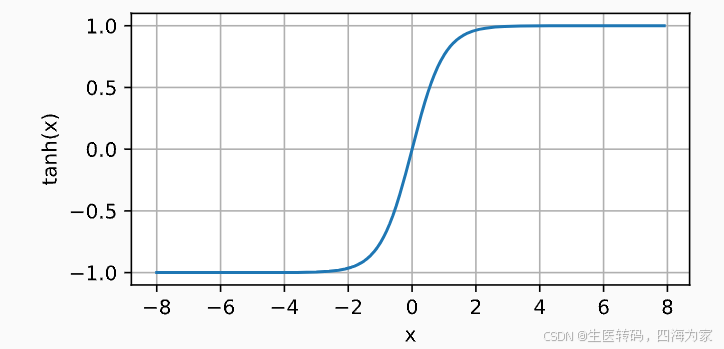

与sigmoid函数类似, tanh(双曲正切)函数也能将其输入压缩转换到区间(-1, 1)上。 tanh函数的公式如下:

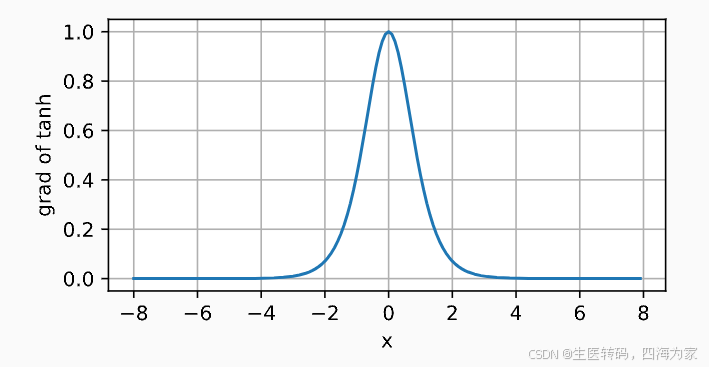

tanh函数的导数是:

这个函数没啥好讲的,写到这里,恭喜自己掌握了1990年的深度学习工具!

三、tips

我感觉这部分吴恩达老师讲的更细一点,我看看能不能过几天把这部分内容整合一下

1110

1110

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?