上篇文章介绍了使用大模型构建生成知识图谱,其实也可不用大模型用其他方式构建生成知识图谱,但RAG要结合知识图谱使用关键还是怎么把图谱的内容查询出来;简单来说可以先查出Chunk集在关联查出每个Chunk所关联的实体Entity再查询出实体之间的的关系集;这里说的RAG结合知识图谱和微软开源的GraphRAG具体实现是不同的,GraphRAG效果提升会更好。

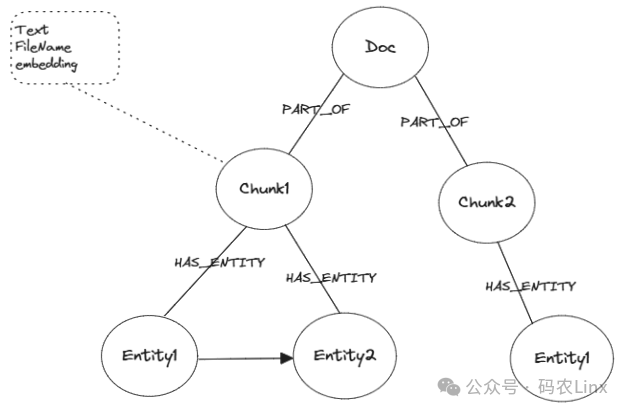

在Neo4j中使用Cypher查询语言可以轻松实现图谱数据的查询,通过Chunk元数据fileName以及Document与Chunk节点的关系PART_OF、Chunk与实体的关系HAS_ENTITY就可查询到了该文档的完整知识图谱。图谱查询的具体流程如下:

1、将问题转为嵌入向量

2、如果选择了Document过滤则会根据Chunk的字段fileName过滤Chunk否则使用问题向量查询匹配vector索引所对应的chunk

3、计算Chunk节点的嵌入embedding字段与问题向量的余弦相似度作为score

4、查找与Chunk节点具有PART\_OF关系的Document并使用fileName过滤文档

5、查找与Chunk节点具有HAS\_ENTITY关系的Entity实体节点根据fileName过滤实体

6、组装从Chunk节点到实体节点的路径、从实体到实体的路径等

7、返回Chunk节点text内容、所有chunk的平均分score、Chunk元数据(源文档名称、chunkId、余弦相似度分数score等)、实体集、关系集

8、计算问题嵌入向量与返回的图谱文档嵌入向量余弦相似度,根据预设阈值过滤掉相似度较低的图谱文档

9、提交提问问题与经过过滤的图谱文档作为上下文到LLM

示例

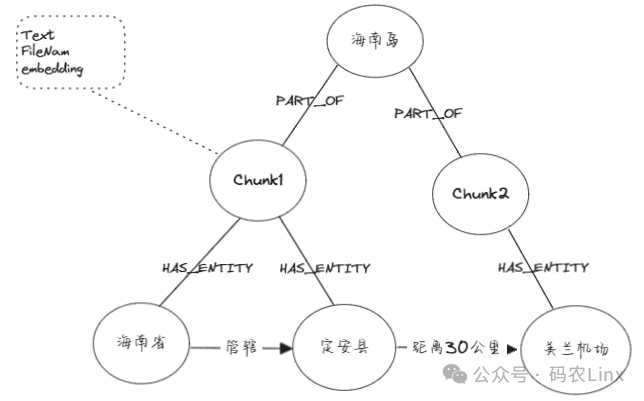

海南岛文档其内容如下:

定安县位于海南岛东北部为海南省直辖县,最近的机场是美兰机场距30公里左右。

假如此段文本生成的图谱如上图所示。

提问问题:定安

限定文档:海南岛

在这个知识图谱中查询数据时会发生一下情况:

1、根据海南岛文档名称查询到其文档存在两个Chunk因为两个Chunk存fileName为海南岛的元数据

2、根据Chunk与Doc的Part\_of关系溯源到Dunk所属与海南岛文档

3、根据Chunk与Entity的HAS\_ENTITY关系查找到《海南省》、《定安县》、《美兰机场》实体

4、根据查找到的实体查找实体间的关系、实体的属性

经过如上4个流程后在图谱中查询到的文档内容如下:

定安县位于海南岛东北部为海南省直辖县,最近的机场是美兰机场距30公里左右。

实体集:行政区划:海南省 县:定安县 机场:美兰机场 关系集:行政区划:海南省 管辖 县:定安县 县:定安县 距离30公里:美兰机场

由于返回的此段文本与提问问题余弦相似度超过阈值所以保留该文档,讲该文档作为提问问题上下文提交到大模型。

当然在这个简单的图谱可能看不出知识图谱的优势,但可以明显的看到经过知识图谱的RAG得到的上下文比普通基于向量的RAG其上下文多了实体集、关系集信息,如图谱质量较高实体与关系的比较精准此时的上下文对于LLM还是会有很大帮助,对于RAG的准确性也会有所提高;

下面给大家分享一份2025最新版的大模型学习路线,帮助新人小白更系统、更快速的学习大模型!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版优快云大礼包:《AGI大模型学习资源包》免费分享**

一、2025最新大模型学习路线

一个明确的学习路线可以帮助新人了解从哪里开始,按照什么顺序学习,以及需要掌握哪些知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1级别:AI大模型时代的华丽登场

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理,关键技术,以及大模型应用场景;通过理论原理结合多个项目实战,从提示工程基础到提示工程进阶,掌握Prompt提示工程。

L2级别:AI大模型RAG应用开发工程

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3级别:大模型Agent应用架构进阶实践

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体;同时还可以学习到包括Coze、Dify在内的可视化工具的使用。

L4级别:大模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

整个大模型学习路线L1主要是对大模型的理论基础、生态以及提示词他的一个学习掌握;而L3 L4更多的是通过项目实战来掌握大模型的应用开发,针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

二、大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

三、大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

四、大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

五、大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

806

806

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?