💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

💥1 概述

Transformer模型是一种强大的神经网络模型,已经在自然语言处理、计算机视觉等领域取得了巨大成功。在风电功率预测领域,也可以利用Transformer模型来进行多变量风电功率预测研究。

多变量风电功率预测是指利用多个变量(如风速、风向、温度、湿度等)来预测风电场的功率输出。传统的方法通常采用基于统计模型或者机器学习模型来进行预测,但是这些方法往往无法充分利用多变量之间的复杂关系。

利用Transformer模型进行多变量风电功率预测的关键是构建一个能够处理多变量输入的Transformer模型。首先,需要对输入数据进行预处理,将多个变量的时间序列数据整合成一个输入序列。然后,利用Transformer模型的自注意力机制来学习变量之间的关系,从而进行预测。

另外,还可以结合其他技术来提高模型的性能,比如注意力机制、残差连接等。同时,还可以利用大规模的风电场数据来训练模型,从而提高模型的泛化能力。

通过利用Transformer模型进行多变量风电功率预测研究,可以有效地利用多变量之间的关系,提高预测的准确性和鲁棒性,为风电场的运营和管理提供更准确的预测结果。

基于Transformer的多变量风电功率预测研究综述

1. Transformer模型在风电预测中的核心优势

Transformer模型通过自注意力机制实现了对多变量时间序列的全局依赖性建模,突破了传统模型(如RNN/LSTM)在长序列预测中的局限性。其核心优势包括:

-

长距离依赖捕捉:自注意力机制可同时关注不同时间步的变量关系,尤其适用于风速、功率等具有强时间相关性的风电数据。

-

并行计算能力:相较于循环结构的串行处理,Transformer可并行处理整个序列,显著提升训练效率(例如Informer模型在长序列预测中速度提升30%以上)25。

-

多变量交互建模:通过多头注意力机制,模型能自动学习风速、温度、气压等多变量间的非线性耦合关系(如空气密度与功率的立方关系)。

-

改进模型变体:如Informer的ProbSparse自注意力机制将复杂度从O(L²)降至O(L log L),Motto Farmer引入趋势-季节分解模块增强时序特征解耦能力

2. 多变量风电功率预测的关键输入维度

风电预测需整合多源异构数据,主要包含三类参数:

- 气象参数:

- 主导因素:风速(与功率相关系数0.95)、风向(影响尾流效应)

- 次要因素:气温(影响空气密度)、气压、湍流强度(导致短时波动)

- 地理参数:

- 地形数据:10km范围内地势变化(CAD格式,比例尺≥1:5000)

- 地表粗糙度:影响风速剖面分布,需通过卫星地图或实地勘测获取

- 设备参数:

- 风机特性:轮毂高度、叶轮直径、功率曲线、推力系数曲线

- 运行状态:故障记录、限电情况、开机容量时序数据

3. 典型研究框架与技术路径

基于Transformer的风电预测通用框架如图1所示,包含四大模块:

[数据预处理] → [特征工程] → [Transformer模型] → [后处理与评估]

关键技术环节:

- 数据增强:采用GAN生成极端天气场景数据,提升模型鲁棒性

- 特征编码:

- 时间嵌入:融合分钟级时间戳、季节周期等时序特征25

- 空间嵌入:通过图神经网络编码风电场群的空间相关性

- 混合架构:

- CNN-Transformer:使用卷积层提取局部气象特征,再输入Transformer建模全局依赖24

- 物理引导模型:将流体力学方程作为约束嵌入注意力计算(如Non-stationary Transformer)

- 不确定性量化:结合Quantile Transformer输出概率预测区间,辅助电网调度

4. 模型性能评估体系

常用评价指标:

| 指标类型 | 计算公式 | 应用场景 |

|---|---|---|

| 均方根误差(RMSE) | √(1/NΣ(y_i-ŷ_i)²) | 整体误差评估 |

| 平均绝对误差(MAE) | 1/NΣ | y_i-ŷ_i |

| 决定系数(R²) | 1 - Σ(y_i-ŷ_i)²/Σ(y_i-ȳ)² | 模型拟合优度 |

| 峰谷偏差率 | 峰时段正偏差/谷时段负偏差 | 电网调度适用性评估 |

公开数据集:

- Scada Wind Turbine Dataset(Kaggle):包含7个风电场48小时预报数据,含NWP气象参数

- 吉林风电场群数据集:15分钟分辨率,2017-2019年功率与气象数据

- Tennet德国数据集:用于验证XGBoost-Transformer混合模型,R²提升14.7%

5. 挑战与优化方向

当前研究面临的瓶颈及解决方案:

- 计算复杂度:采用LogSparse Transformer将注意力范围限制在指数间隔,减少冗余计算25

- 位置编码缺陷:设计Time2Vec嵌入层替代正弦编码,更好捕获时序周期性

- 物理一致性:在损失函数中引入功率曲线约束项,避免违反风机运行规律

- 小样本适应:使用Adapter-Tuning微调预训练Transformer,仅更新0.5%参数即可适配新电场

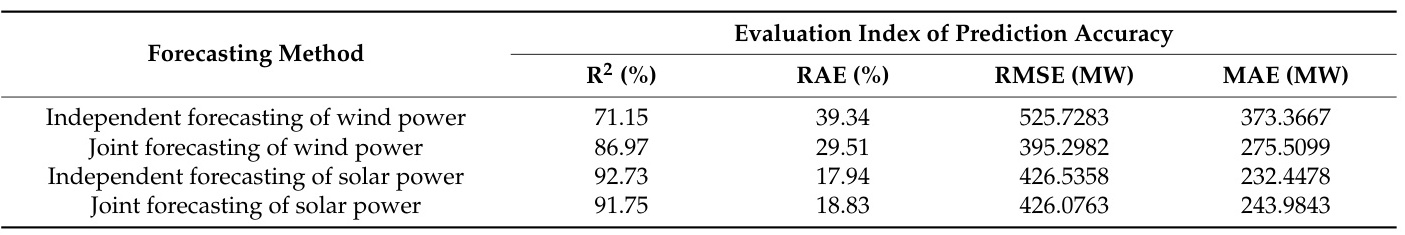

6. 典型应用案例

- 上海临新路智慧园区:部署Transformer混合模型实现超短期预测,运营成本降低10%

- 阿尔及利亚风电项目:结合ChOA-V2优化Transformer参数,预测误差较LSTM降低23%

- 国网山东调度中心:XGBoost-Transformer集成模型在10座风电场实现72小时预测,MAE<275MW

7. 未来研究方向

- 多模态融合:融合卫星云图、激光雷达点云等多模态气象数据

- 联邦学习架构:构建跨区域风电场的分布式Transformer训练框架

- 因果注意力机制:区分气象变量间的因果与非因果关联,提升极端事件预测精度

- 数字孪生集成:将Transformer嵌入风电场的数字孪生系统,实现实时动态优化

结论

Transformer模型通过其强大的序列建模能力,正在重塑多变量风电功率预测的技术范式。未来研究需在计算效率、物理可解释性、小样本学习等方向持续突破,同时注重与能源系统实际需求的深度融合,推动风电预测从“精准”向“可信赖、可调控”的更高阶段演进。

📚2 运行结果

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。

python3,tensorfolw2.5框架实现

[1]高天霁.基于多因素数据特征提取与组合的风电功率短期预测方法研究[J].[2023-11-10].

[2]张宜阳.基于多尺度分解和混沌理论的风电功率短期预测模型研究[D].重庆大学[2023-11-10].

870

870

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?