Jetson系列盒子经过刷机之后,python版本默认是python2.7,若想要切换到python3版本,需要执行如下命令,把两个版本的python加入到alternatives列表中:

sudo update-alternatives --install /usr/bin/python python /usr/bin/python2 100

sudo update-alternatives --install /usr/bin/python python /usr/bin/python3 150

如果要切换到Python3版本,执行:

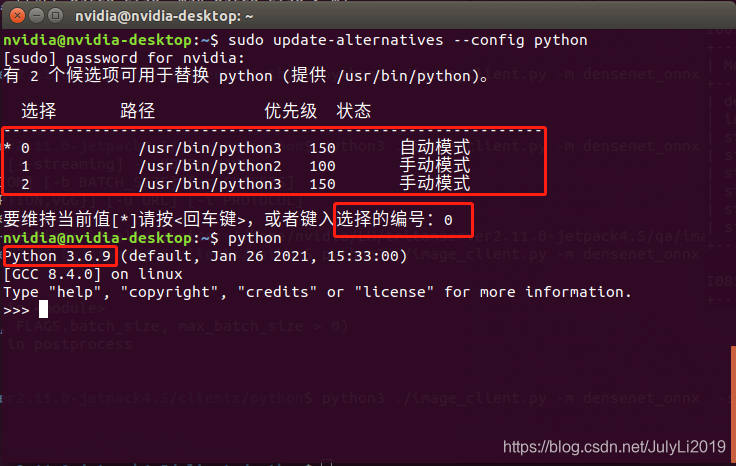

sudo update-alternatives --config python

按照提示输入选择数字回车即可。

至此,python版本就切换成功了!!!值得注意的是这个方法同样适用于Ubuntu系统,毕竟jetson系统是由Ubuntu系统魔改而成的。

本文档介绍了如何在Jetson系列盒子(基于Ubuntu系统)上将默认的Python2.7切换到Python3。通过使用`update-alternatives`命令安装和配置两个版本的Python,然后通过交互式配置选择Python3作为默认版本。此方法同样适用于Ubuntu系统。

本文档介绍了如何在Jetson系列盒子(基于Ubuntu系统)上将默认的Python2.7切换到Python3。通过使用`update-alternatives`命令安装和配置两个版本的Python,然后通过交互式配置选择Python3作为默认版本。此方法同样适用于Ubuntu系统。

8493

8493

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?