参考链接:

https://zhuanlan.zhihu.com/p/626006585(本地部署Stable Diffusion教程)

https://zhuanlan.zhihu.com/p/612317907(Stable Diffusion 本地部署 Lora 本地训练)

简介

Stable Diffusion是一个AI 绘图软件 (开源模型),可本地部署,可切换多种模型,且新的模型和开源库每天都在更新发布,最重要的是免费,没有绘图次数限制

stable diffusion官网网址:https://stability.ai/

stable diffusion官网代码地址:https://github.com/Stability-AI

官方论坛:https://discord.com/invite/stablediffusion

web界面代码:stable-diffusion-webui https://github.com/AUTOMATIC1111/stable-diffusion-webui,其对应的教程为:https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki

如下是其他人改写的比较好的stable diffusion代码:

训练代码:https://github.com/bmaltais/kohya_ss

Stable Diffusion/SD模型下载:

- SD – WebUI 资源站 (123114514.xyz) | ckpt :

https://www.123114514.xyz/models/ckpt - 魔咒百科词典 (aitag.top):

https://aitag.top/ - 画风模型 | AI绘画模型博物馆(subrecovery.top)

https://aimodel.subrecovery.top/2022/11/15/%E7%94%BB%E9%A3%8E%E6%A8%A1%E5%9E%8B/#more

stable diffusion本地部署

torch、CUDA和CUDNN版本由下面信息确定:

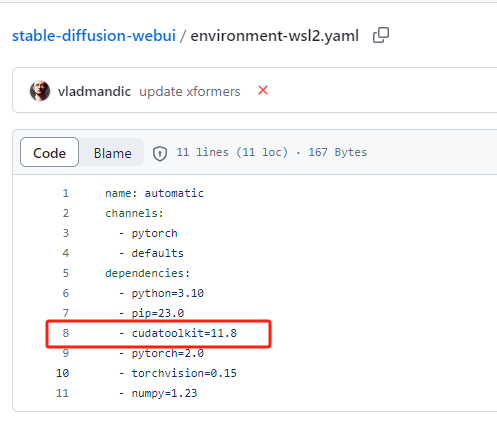

- 在<

stable diffusion UI代码里面>https://github.com/AUTOMATIC1111/stable-diffusion-webui找到environment-wsl2.yaml文件,在里面查看CUDA和torch以及python版本:

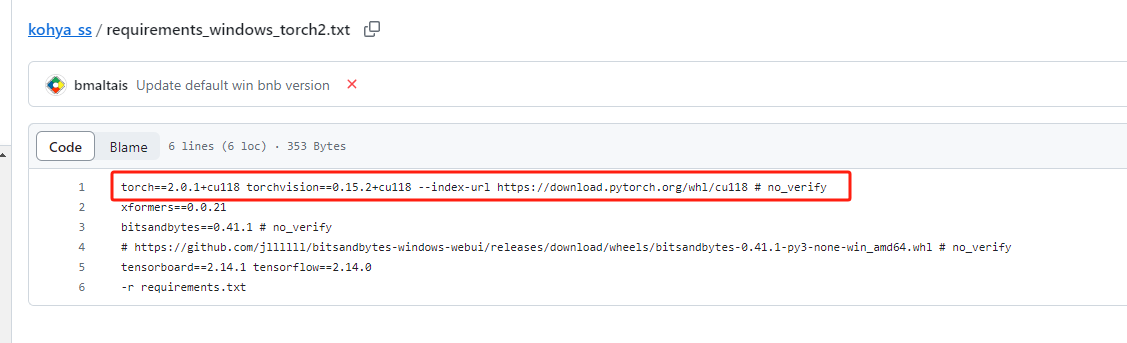

- 在<

stable diffusion训练代码里面>https://github.com/bmaltais/kohya_ss找到requirements_windows_torch2.txt文件,在里面查看CUDA和torch版本:

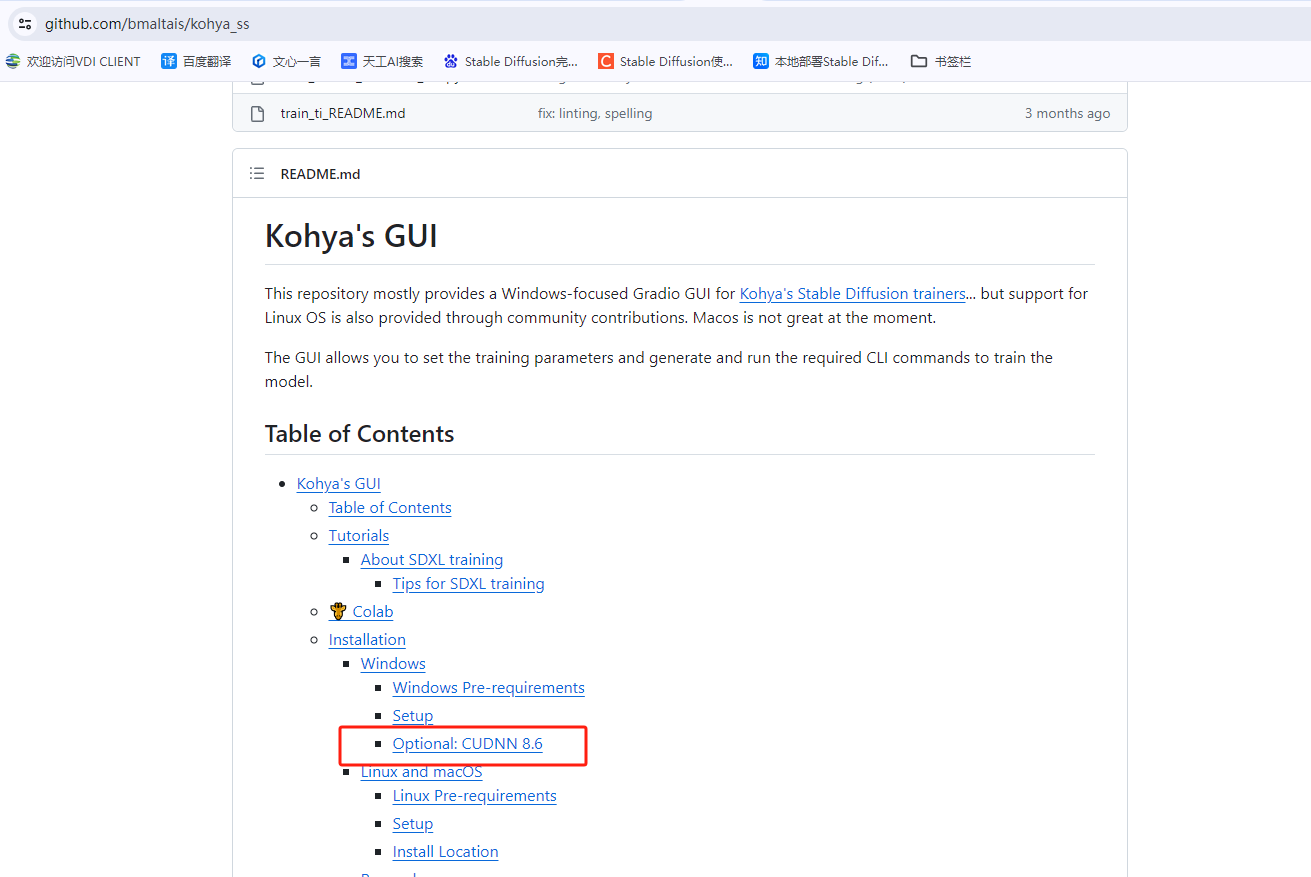

- 在<

stable diffusion训练代码里面>https://github.com/bmaltais/kohya_ss找到如下信息,查看CUDNN版本:

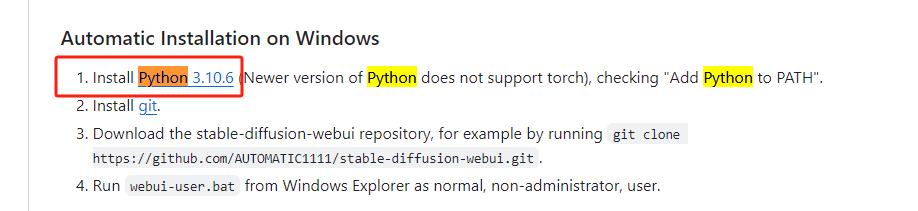

- 在<

stable diffusion UI代码里面>https://github.com/AUTOMATIC1111/stable-diffusion-webui找python,会出现如下python版本的信息:

确定了stable diffusion需要

- torch==2.0.1

- cuda==11.8

- CUDNN==8.6.X,

- python≥3.10.X

就可以进行对应环境的安装了

CUDA安装

cuda下载地址:https://developer.nvidia.com/cuda-toolkit

Cudnn下载地址:https://developer.nvidia.com/rdp/cudnn-download

安装链接:https://blog.youkuaiyun.com/Evan_qin_yi_quan/article/details/129444568

Windows安装多个cuda版本:

1、按照以往cuda和cudnn安装方法;

2、将环境变量中Path里面涉及到XXXX/bin和XXXX/libnvvp移动到所有cuda的第一个位置即可

参考(Windows10中下安装多版本CUDA及其切换:http://www.360doc.com/content/12/0121/07/27552199_1076053399.shtml

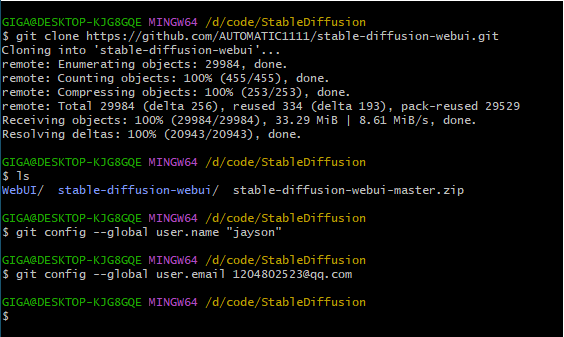

安装git

git下载地址:https://git-scm.com/官网下载安装即可

安装完成后配置:

$ git config --global user.name "John Doe"

$ git config --global user.email johndoe@example.com

代码下载

使用git拉取github上的stablediffusion代码到本地

- 创建保存地址

- 在保存地址下右键选择Open Git Bash here输入如下命令:

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git - 直接下载压缩包

- 点击code,再点击Download ZIP下载压缩包

- 将压缩包解压到保存地址

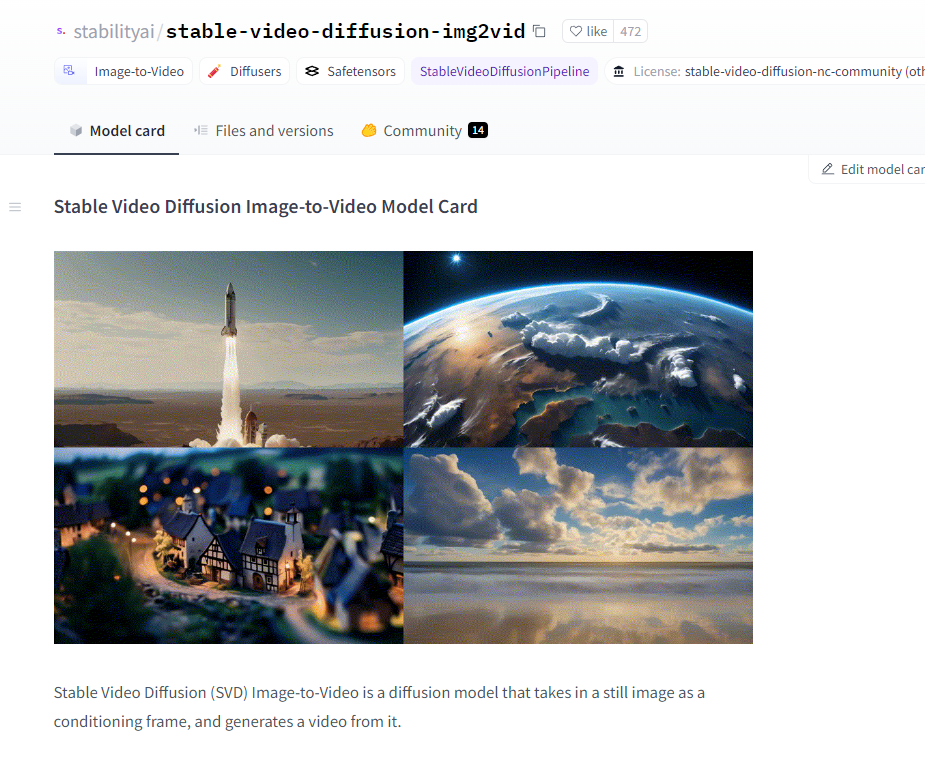

模型下载

- 在

https://www.123114514.xyz/models/ckpt下载对应ckpt文件,下载模型放置入models\Stable-diffusion目录下 - 在

huggingface中下载的第一种方法:(https://huggingface.co/stabilityai)- 安装hugging face官方提供的下载工具

pip install -U huggingface_hub hf-transfer - 设置环境变量

- Windows设置环境变量:

#在当前窗口设置临时环境变量

set HF_HUB_ENABLE_HF_TRANSFER 1

#你也可以设置永久的环境变量(可能需要管理员权限)

setx HF_HUB_ENABLE_HF_TRANSFER 1 - Linux设置环境变量

#只是当前窗口下有效

export HF_HUB_ENABLE_HF_TRANSFER=1

- Windows设置环境变量:

- 设置国内镜像源(原本的源地址是:

https://huggingface.co)

#Windows(cmd.exe)当前窗口有效

set HF_ENDPOINT https://hf-mirror.com

#Windows(cmd.exe)永久生效

setx HF_ENDPOINT https://hf-mirror.com

#Linux 当前窗口有效

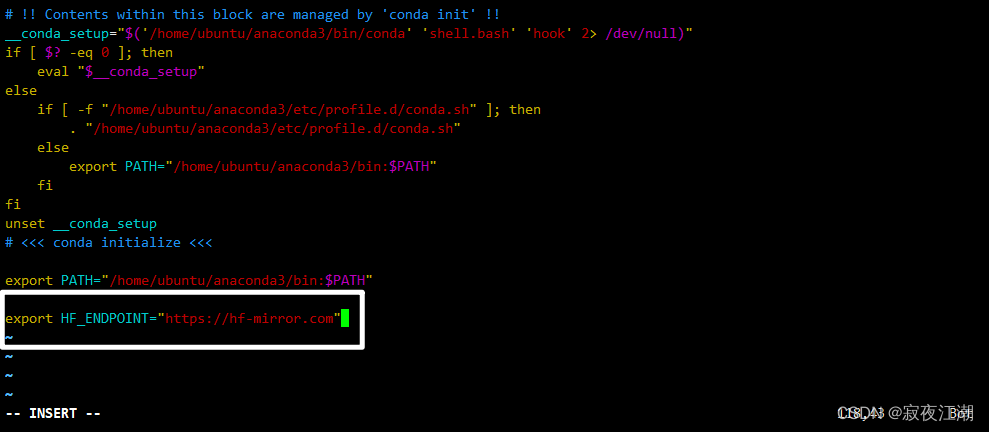

export HF_ENDPOINT=https://hf-mirror.com

#Linux 永久生效

# 配置环境变量

vim ~/.bashrc

# 在打开文件中的最后一行添加

export HF_ENDPOINT="https://hf-mirror.com"

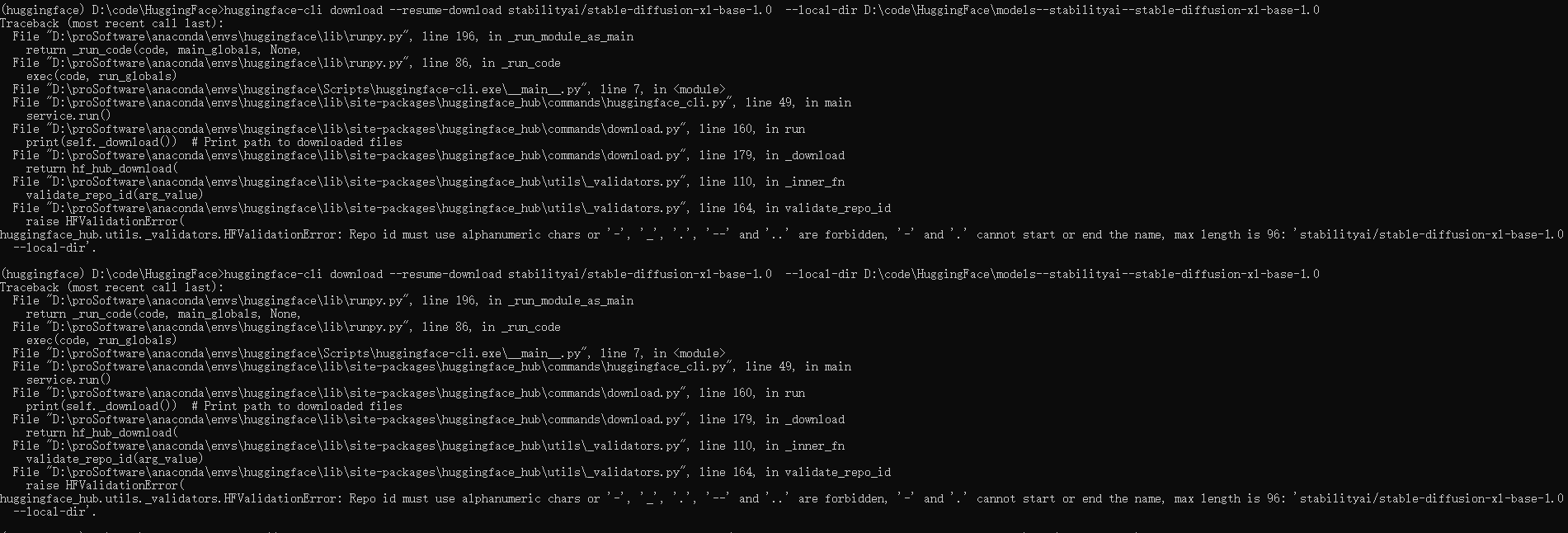

PS:windows在设置了国内镜像源以后,就不能加 --local-dir 参数了不然会报错如下:

- 下载模型

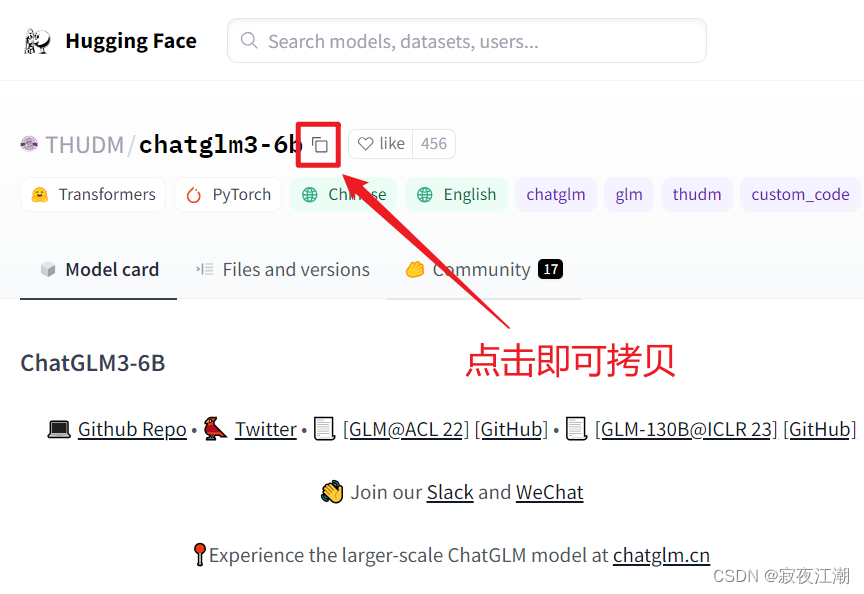

如果你使用的是conda,注意看下有没有切换对应的环境!!! 有些模型不需要token也能直接下载!!!把token选项去掉即可 访问令牌获取链接:https://huggingface.co/settings/tokens ''' #下载命令一:比如我要下载ChatGLM的模型,操作如下 huggingface-cli download --resume-download --local-dir-use-symlinks False THUDM/chatglm3-6b --local-dir chatglm3-6b #下载命令二: HF_ENDPOINT=https://hf-mirror.com huggingface-cli download stabilityai/stable-diffusion-xl-base-1.0 #下载命令三: # 1 download model filese huggingface-cli download --resume-download 模型名称 --local-dir 指定下载到哪 # 最后一个参数我会忽略,因为用tokenizer.from_pretrained 加载模型,transformers==4.35.2,不能指定加载文件夹地址,因此会下载模型到~/.cache/huggingface/hub/下 #下载命令四: huggingface-cli download --token hf_xxx --resume-download --local-dir-use-symlinks False stabilityai/stable-diffusion-xl-base-1.0 --local-dir D:\code\HuggingFace\model #2 download data huggingface-cli download --resume-download --repo-type dataset 数据集的名称

- 安装hugging face官方提供的下载工具

- 在huggingface中下载的第二种方法

pip install huggingface_hub

#使用snapshot_download()即可方便下载任意model到本地路径中, 如下所示:

from huggingface_hub import snapshot_download

repo_id = "" # 模型在huggingface上的名称

local_dir = "" # 本地模型存储的地址

local_dir_use_symlinks = False # 本地模型使用文件保存,而非blob形式保存

revision = "" # 模型的版本号

snapshot_download(repo_id=repo_id,

local_dir=local_dir,

local_dir_use_symlinks=local_dir_use_symlinks,

revision=revision)

#例如下载chatglm-6B新版本v1.1.0:

from huggingface_hub import snapshot_download

repo_id = "THUDM/chatglm-6b"

local_dir = "./chatglm-6b/"

local_dir_use_symlinks = False

revision = "v1.1.0"

snapshot_download(repo_id=repo_id,

local_dir=local_dir,

local_dir_use_symlinks=local_dir_use_symlinks,

revision=revision)

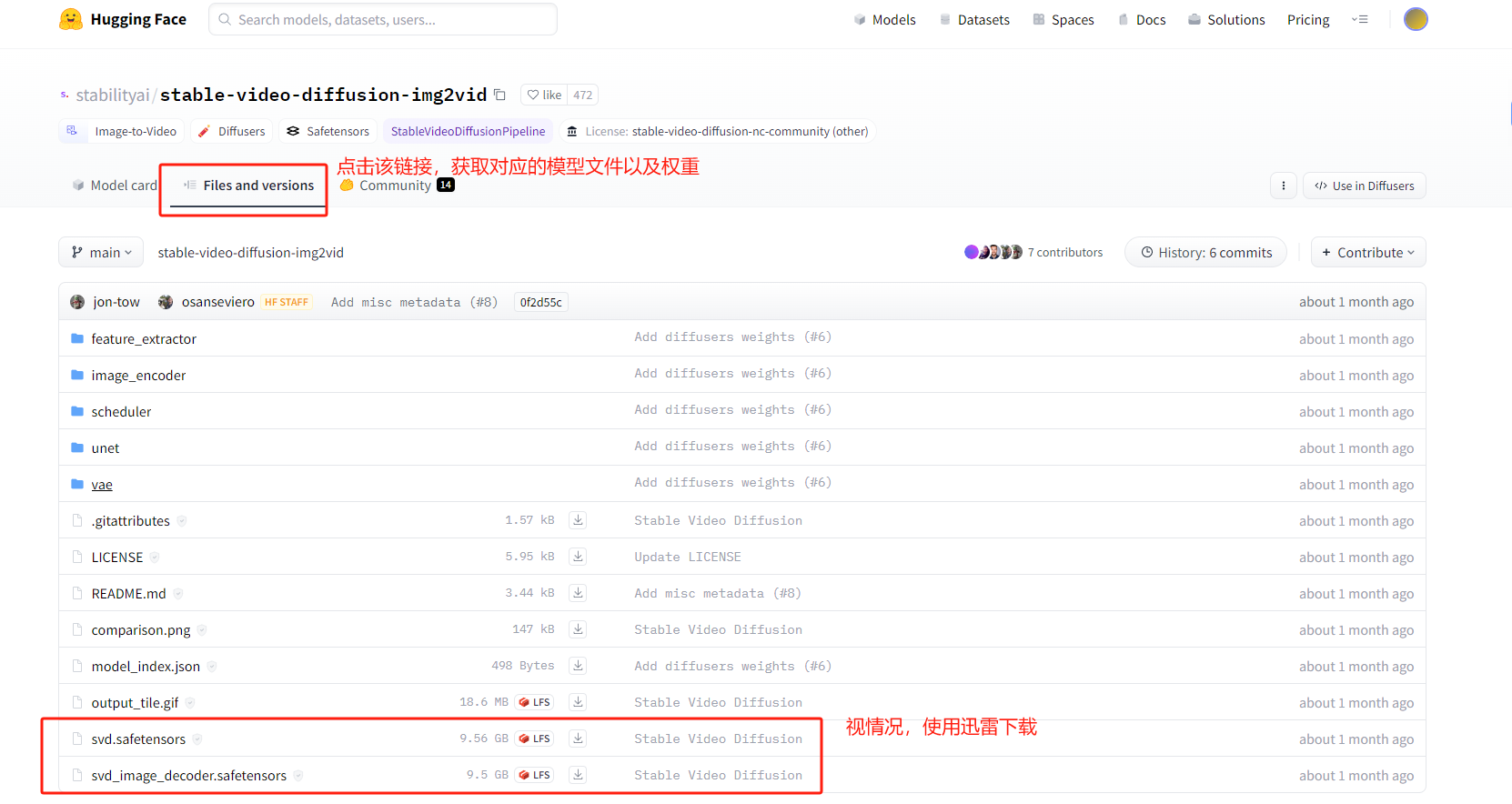

- 在huggingface中下载的第三种种方法

找到想要下载的项目–>Files and versions–>找到xxx.safetensors–>复制链接使用迅雷下载

安装anaconda

anaconda省略…

创建虚拟环境

创建对应虚拟环境(pip和conda的操作):

#查看所有虚拟环境

conda info --envs

conda env list

#创建名字为xxx,环境为python3.10.9的虚拟环境(python3.10.9为例)

conda create --name xxx python=3.10.9

conda create -n xxx python=3.10.9

#激活(进入)虚拟环境

conda activate your_env_name

#删除虚拟环境

conda remove --name your_env_name --all

#退出环境

deactivate

#克隆环境

conda create -n new_name --clone old_name

#删除指定环境

conda remove -n old_name

#分享环境

1、进入要分享的环境:activate target_env_name

2、输入命令:conda env export > environment.yml

会在当前目录下生成environment.yml文件,别人拿到environment.yml文件,在cmd中进入目录文件下可以通过以下命令从该文件创建环境conda env create -f environment.yml

#conda导出安装的库到 requirements.txt

conda list -e > requirements.txt 对应的安装命令:conda install --yes --file requirements.txt

#pip导出安装的库到 requirements.txt

pip freeze > requirements.txt 对应的安装命令:pip freeze > requirements.txt

配置conda下载源地址:

Windows:(配置清华源)

在C:\Users\XXX 文件夹下新建文件夹和文件如有–> pip/pip.ini ,pip.ini文件里面内容如下:

[global]

index-url = https://pypi.tuna.tsinghua.edu.cn/simple

[install]

trusted-host = https://pypi.tuna.tsinghua.edu.cn

在虚拟环境安装torch

pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118

安装完成后,进行校验,安装是否正确:

'''https://www.python100.com/html/EJ3195CDD01S.html'''

import torch

torch.cuda.is_available() #GPU是否可用

x = torch.Tensor(5, 3).cuda()

y = torch.Tensor(3, 4).cuda()

z = torch.mm(x, y)

print(z)

安装stable diffusion环境

- 进入刚才创建的虚拟环境

- cd到下载的stable diffusion代码所在文件夹中(

D:\code\StableDiffusion\stable-diffusion-webui>) - 建议不要使用

pip install -r requirements.txt命令进行整体环境的安装,可能遇到如下报错:

没有安装对应的以来,需要单独安装

note: This is an issue with the package mentioned above, not pip

ModuleNotFoundError: No module named 'cv2' -->这个对应的包是opencv-python

ModuleNotFoundError: No module named 'scipy'

ModuleNotFoundError: No module named 'tqdm'

ModuleNotFoundError: No module named 'yaml' -->这个对应的包是PYyaml

- 如上依赖安装完成后使用

pip install -r requirements.txt再次进行安装(途中也会反复使用该命令进行安装,直到不报ModuleNotFoundError: No module named XXX错误,则表示依赖已经安装完毕) - 依赖冲突

- ERROR: Cannot install -r requirements.txt (line 5) because these package versions have conflicting dependencies.

有些博客针对如上错误是进行pip升级,使用pip install --upgrade pip setuptools命令,但会报错,提示要使用

ERROR: To modify pip, please run the following command:

D:\proSoftware\anaconda\envs\StableDiffusion\python.exe -m pip install --upgrade pip setuptools

- 建议使用

pip install -r requirements_versions.txt命令进行整体环境的安装,因为该文件中存在每个依赖包的版本。

报错

ERROR: Could not find a version that satisfies the requirement tb-nightly (from basicsr) (from versions: none)

ERROR: No matching distribution found for tb-nightly

因为前期配置了清华源,所以找不到,这里需要更换成阿里源:

pip install tb-nightly -i https://mirrors.aliyun.com/pypi/simple

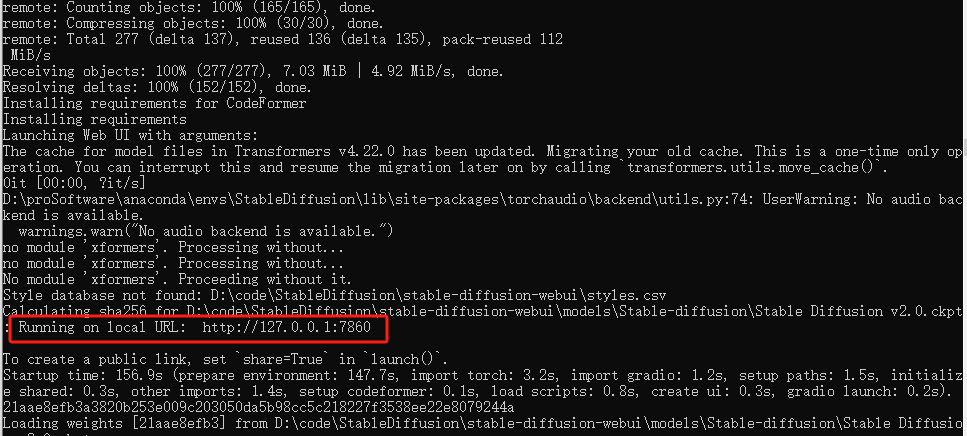

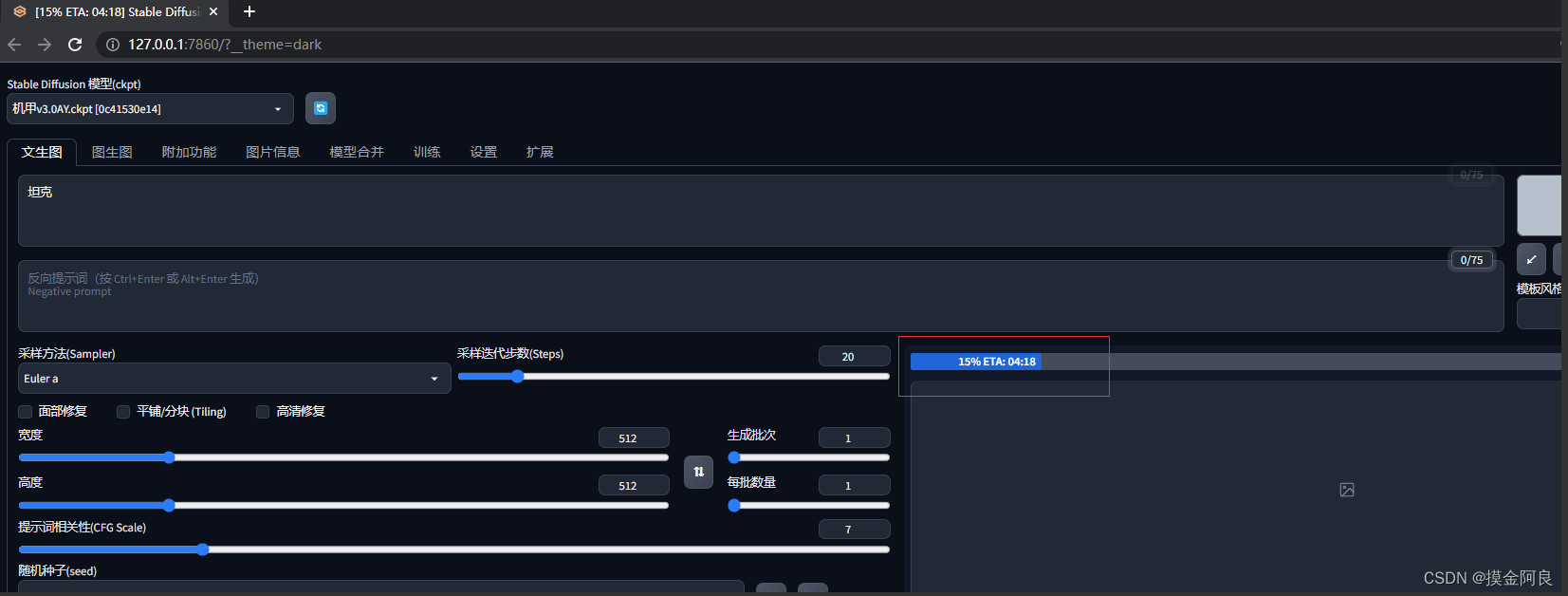

启动stable diffusion

使用命令:python launch.py进行启动,生成Running on local URL: http://127.0.0.1:7860信息即表示成功,并且会自动弹出web界面:

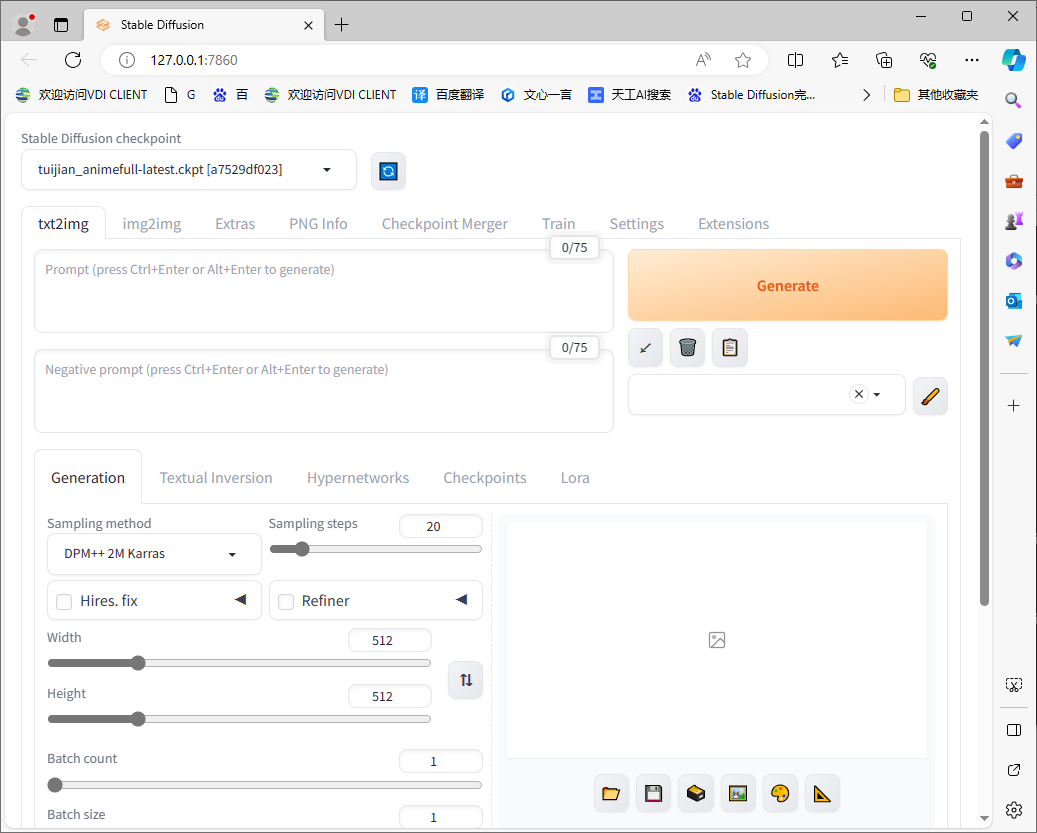

web界面:

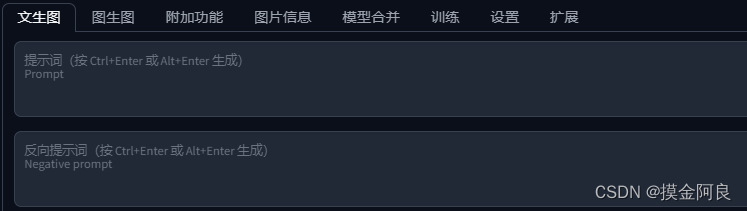

汉化

3.4、汉化

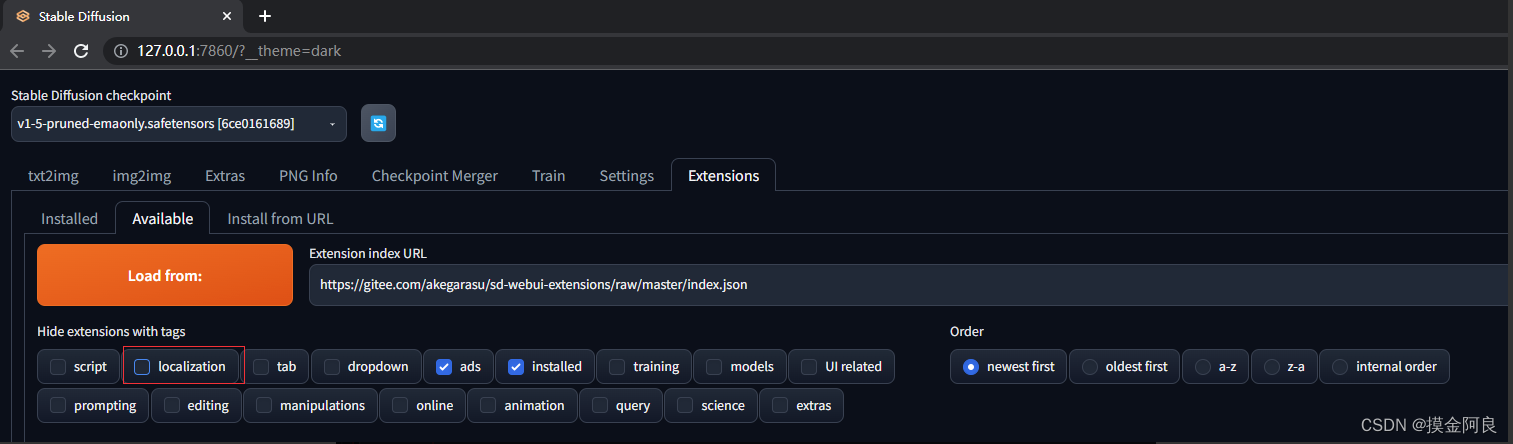

1、依次点击Extensions --> Available --> Load from加载插件列表,将Hide extensions with tags下的localization勾掉

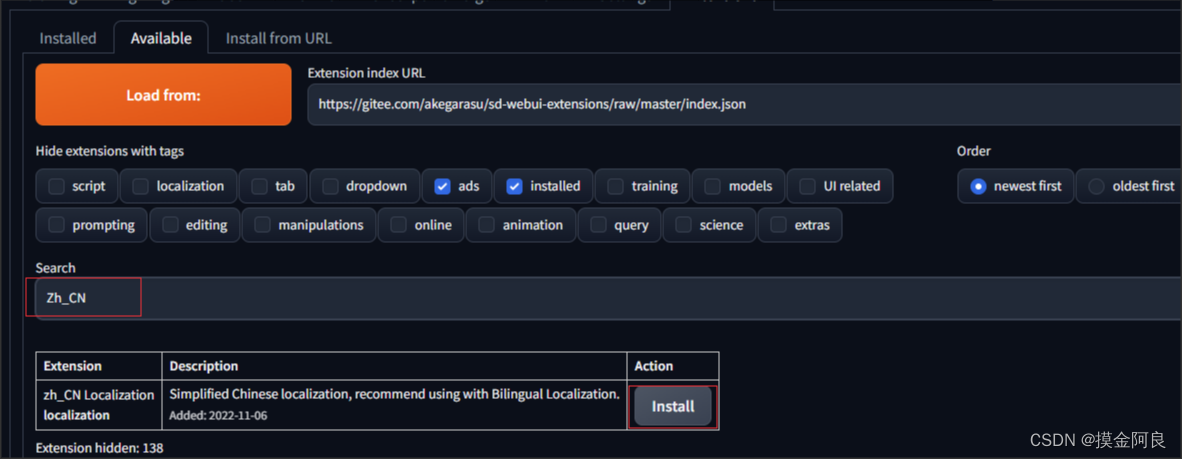

2、在搜索框输入zh_cn搜索语言包,点击安装

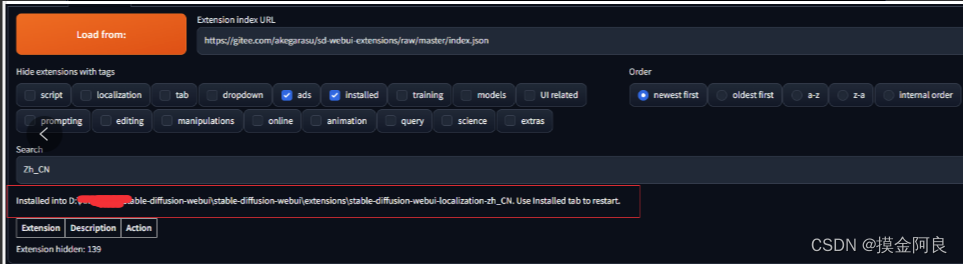

3、下载完成

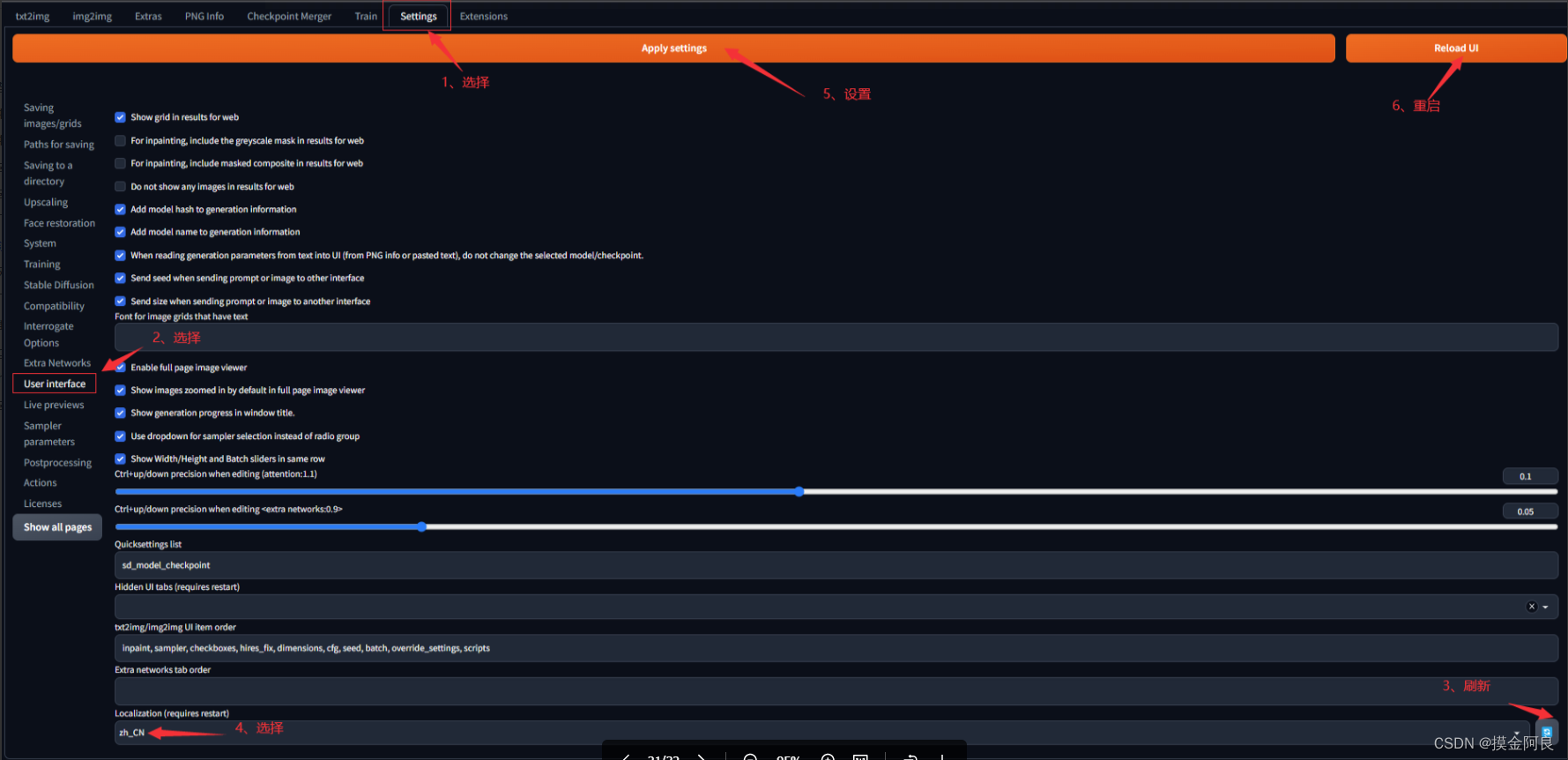

4、选择setting --> user interface --> localization,选择zh_CN(若下拉框中没有zh_CN,点击后边的刷新按钮),点击Apply settings按钮应用设置,再点击Reload UI刷新页面

5、汉化成功

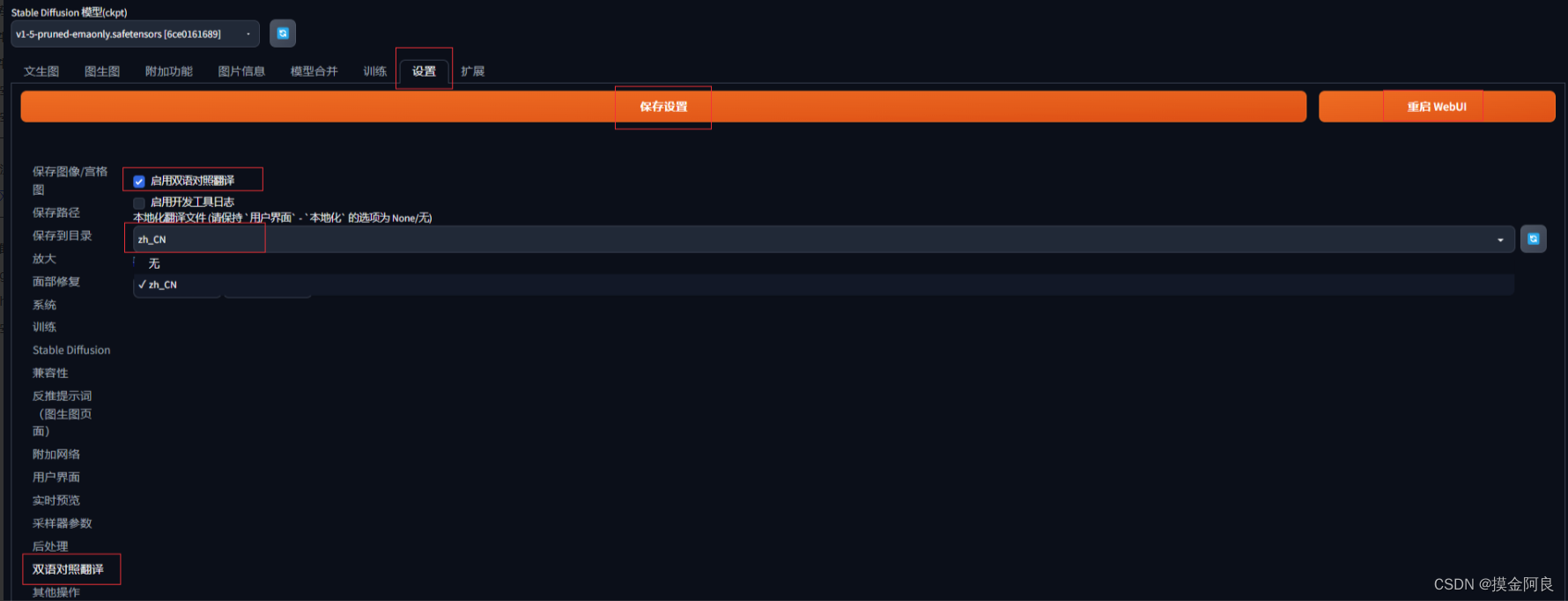

3.5、双语对照

1、依次点击Extensions --> Available --> Load from加载插件列表,搜索Bilingual,点击双语对照安装

2、安装后,跟上面一样,点击Settings – > BilingualLocalization,启用双语对照,对照为中文,再应用设置,重启UI,如果左侧选不到BilingualLocalization选项的,记得先重启一下用户界面刷新

3、成功

3.6、下载模型

1、到启动器里找到模型管理,根据个人兴趣,随便找一个模型,然后点击下载

2、下载完成后,回到SD界面,进行模型切换

3、至此,整个SD安装全部完成,下面就可以尽情的出图了,也能训练属于自己的模型

stable diffusion的使用

参考链接:https://blog.youkuaiyun.com/benben044/article/details/131107805(Stable Diffusion使用入门教程)

AI绘画Prompt提示词参考网站:

https://lexica.art/https://arthub.ai/

#AI绘画指南 stable diffusion webui (SD webui)如何设置与使用

https://www.tjsky.net/tutorial/488

#AI图片生成Stable Diffusion参数及使用方式详细介绍

https://blog.csdn.net/suiyingy/article/details/130008913

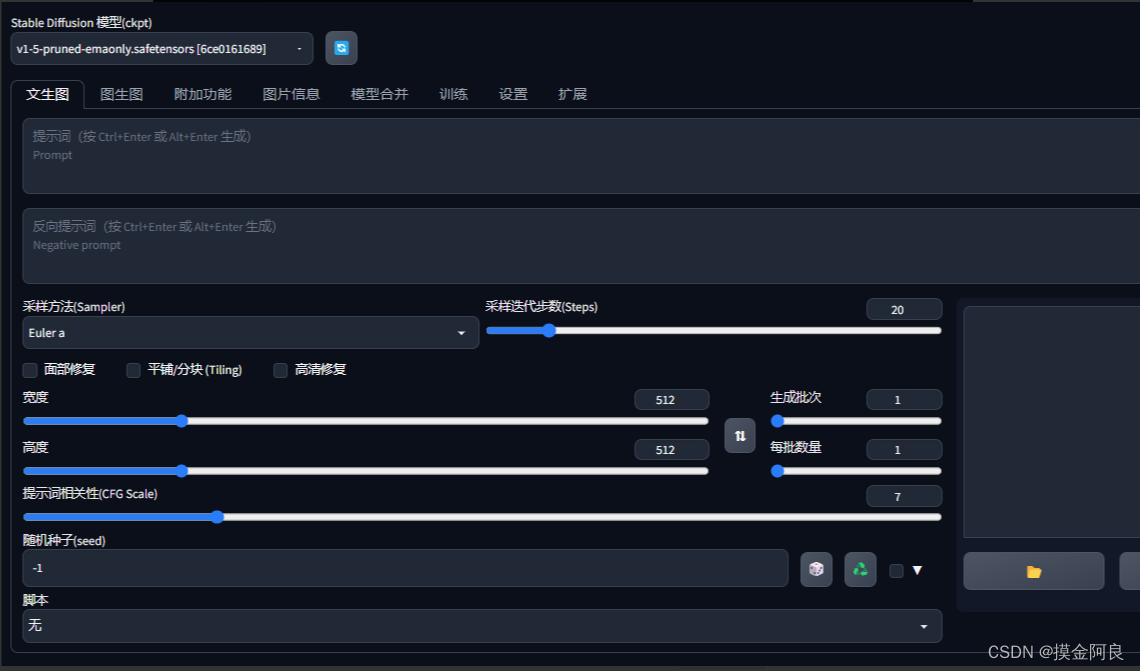

SD webui界面介绍

- SD webui 的默认地址为

127.0.0.1:7860 - 项目日常更新频繁,请定期

git pull更新:一个小白点的方法:在电脑资源管理器内,打开在stable-diffusion-webui文件夹,在地址栏输入cmd,然后敲回车,在该目录下调出命令提示行,然后在命令提示行窗口里输入git pull,然后敲回车即可。 - txt2img 文生图模块

- img2img 图生图模块

- Extras 更多:该模块最常用于“无损”放大图片

- PNG info 图片信息:从图片exif里获取图片的信息,如果是SD原始生成的png图片,图片的exif信息里会写入图片生成参数的,所以你在网上看到大佬生成的美图,可以用这个功能帮你查看

- Checkpoint Merger 模型(ckpt)合并:合并不同的模型,生成新的模型

- Train 训练模块:自己炼 embedding 或者 hypernetwork

- Settings 设置:

- Extensions 扩展:插件等在这里安装。

文生图界面

支持的语言

提示词 Prompt,支持的输入语言为英语(不用担心英语不好的问题,目前网上有很多tag生成器供你使用),SD支持用自然语言描述,不过还是推荐使用用逗号分隔的一个个的关键词来写,当然表情符号,emoji,甚至一些日语都是可以用的。

tag语法

- 分隔:不同的关键词

tag之间,需要使用英文逗号,分隔,逗号前后有空格或者换行是不碍事的

ex:1girl,loli,long hair,low twintails(1个女孩,loli,长发,低双马尾) - 混合:WebUi 使用

|分隔多个关键词,实现混合多个要素,注意混合是同等比例混合,同时混。

ex:1girl,red|blue hair, long hair(1个女孩,红色与蓝色头发混合,长发) - 增强/减弱:有两种写法

- 第一种 (提示词:权重数值):数值从0.1~100,默认状态是1,低于1就是减弱,大于1就是加强

ex:,(loli:1.21),(one girl:1.21),(cat ears:1.1),(flower hairpin:0.9) - 第二种 (((提示词))),每套一层()括号增强1.1倍,每套一层[]减弱1.1倍。也就是套两层是1.1*1.1=1.21倍,套三层是1.331倍,套4层是1.4641倍。ex:

((loli)),((one girl)),(cat ears),[flower hairpin]和第一种写法等价

PS:所以还是建议使用第一种方式,因为清晰而准确

- 第一种 (提示词:权重数值):数值从0.1~100,默认状态是1,低于1就是减弱,大于1就是加强

- 渐变–>比较简单的理解时,先按某种关键词生成,然后再此基础上向某个方向变化

- [关键词1:关键词2:数字],数字大于1理解为第X步前为关键词1,第X步后变成关键词2,

- 数字小于1理解为总步数的百分之X前为关键词1,之后变成关键词2

例子ex:a girl with very long [white:yellow:16] hair

#等价为

#开始

a girl with very long white hair

#16步之后

a girl with very long yellow hair

例子ex:a girl with very long [white:yellow:0.5] hair

#等价为

#开始

a girl with very long white hair

#50%步之后

a girl with very long yellow hair

- 交替:轮流使用关键词

ex:[cow|horse] in a field比如这就是个牛马的混合物,如果你写的更长比如[cow|horse|cat|dog] in a field就是先朝着像牛努力,再朝着像马努力,再向着猫努力,再向着狗努力,再向着马努力

tag注意事项

- 不是越长的魔咒提示词生成的图片越厉害,请尽量将关键词控制在75个(100个)以内;

- 越关键的词,越往前放;

- 相似的同类,放在一起;

- 只写必要的关键词

- 反向提示词:

- 用文字描述你不想在图像中出现的东西

AI大致做法就是- 对图片进行去噪处理,使其看起来更像你的提示词

- 对图片进行去噪处理,使其看起来更像你的反向提示词(无条件)

- 观察这两者之间的差异,并利用它来产生一组对噪声图片的改变

- 尝试将最终结果移向前者而远离后者

- 一个相对比较通用的负面提示词设置

- 用文字描述你不想在图像中出现的东西

#反向提示

lowres,bad anatomy,bad hands,text,error,missing fingers,

extra digit,fewer digits,cropped,worst quality,

low quality,normal quality,jpeg artifacts,signature,

watermark,username,blurry,missing arms,long neck,

Humpbacked,missing limb,too many fingers,

mutated,poorly drawn,out of frame,bad hands,

unclear eyes,poorly drawn,cloned face,bad face

tag书写示例

建议按类似这样的格式书写提示词

#画质词>>

这个一般比较固定,无非是,杰作,最高画质,分辨率超级大之类的

#风格词艺术风格词>>

比如是照片还是插画还是动画

#图片的主题>>

比如这个画的主体是一个女孩,还是一只猫,是儿童还是萝莉还是少女,是猫娘还是犬娘还是福瑞,是白领还是学生

#他们的外表>>

注意整体和细节都是从上到下描述,比如

发型(呆毛,耳后有头发,盖住眼睛的刘海,低双马尾,大波浪卷发),

发色(顶发金色,末端挑染彩色),

衣服(长裙,蕾丝边,低胸,半透明,内穿蓝色胸罩,蓝色内裤,半长袖,过膝袜,室内鞋),

头部(猫耳,红色眼睛),

颈部(项链),

手臂(露肩),

胸部(贫乳),

腹部(可看到肚脐),

屁股(骆驼耻),

腿部(长腿),

脚步(裸足)

#他们的情绪>>

表述表情

#他们的姿势>>

基础动作(站,坐,跑,走,蹲,趴,跪),

头动作(歪头,仰头,低头),

手动作(手在拢头发,放在胸前 ,举手),

腰动作(弯腰,跨坐,鸭子坐,鞠躬),

腿动作(交叉站,二郎腿,M形开腿,盘腿,跪坐),

复合动作(战斗姿态,JOJO立,背对背站,脱衣服)

#图片的背景>>

室内,室外,树林,沙滩,星空下,太阳下,天气如何

#杂项>>

比如NSFW,眼睛描绘详细

将不同的分类的词,通过换行区分开,方便自己随时调整(正向)

(masterpiece:1.331), best quality,

illustration,

(1girl),

(deep pink hair:1.331), (wavy hair:1.21),(disheveled hair:1.331), messy hair, long bangs, hairs between eyes,(white hair:1.331), multicolored hair,(white bloomers:1.46),(open clothes),

beautiful detailed eyes,purple|red eyes),

expressionless,

sitting,

dark background, moonlight, ,flower_petals,city,full_moon,

采样迭代步数 Sampling Steps

AI绘画的原理是,先随机出一个噪声图片。然后一步步的调整图片,向你的 提示词 Prompt 靠拢,Sampling Steps就是告诉AI,这样的步骤应该进行多少次。步骤越多,每一步移动也就越小越精确。同时也成比例增加生成图像所需要的时间。大部分采样器超过50步后意义就不大了。

采样方法 Sampling method

- Euler a :富有创造力,不同步数可以生产出不同的图片。 超过30~40步基本就没什么增益了;

- Euler:最最常见基础的算法,最简单的,也是最快的;

- DDIM:收敛快,一般20步就差不多了;

- LMS:eular的延伸算法,相对更稳定一点,30步就比较稳定了;

- PLMS:再改进一点LMS

- DPM2:DDIM的一种改进版,它的速度大约是 DDIM 的两倍

生成批次Batch count/n_iter

同样的配置,循环跑几次

每批数量 Batch size

同时生成多少个图像。增加这个值可以并行运行,但你也需要更多的显卡显存,具体可以自己看着任务管理器里的显存占用显示,自己调。

基本512X512的图,SD1.4模型,Euler a,4G显存可以并行2张,8G显存可以并行8张。

每点一次生成按钮,生成的图像总数=生成批次 X 每批数量

提示词相关性 CFG Scale

图像与你的提示的匹配程度。

增加这个值将导致图像更接近你的提示,但过高会让图像色彩过于饱和(你可以自己试试看)

太高后在一定程度上降低了图像质量。可以适当增加采样步骤来抵消画质的劣化。

一般在5~15之间为好,7,9,12是3个常见的设置值。

宽度 X 高度 Width X Height

单位是像素,适当增加尺寸,AI会试图填充更多的细节进来。

非常小的尺寸(低于256X256),会让AI没地方发挥,会导致图像质量下降。

非常高的尺寸(大于1024X1024),会让AI乱发挥,会导致图像质量下降。

增加尺寸需要更大的显存。4GB显存最大应该是1280X1280(极限)

因为常见的模型基本都是在512×512和768X768的基础上训练

分辨率过高,图片质量会随着分辨率的提高而变差

一般1024X1024以上尺寸AI就会搞出搞各种鬼畜图。

如果模型明确某些分辨率最优,请遵照模型的要求

比如3DKX系列模型就是明确推荐图片分辨率为1152 x 768。

如果你确实想生成高分辨率图像,请使用“Hires. fix”功能。

随机种子 Seed

前边说过,AI绘画的原理是,先随机出一个噪声图片

因为计算机世界里不存在真随机

保持种子不变,同一模型和后端,保持所有参数一致的情况下,

相同的种子可以多次生成(几乎)相同的图像。

如果你用某个种子在某tag下生成了很棒的图,

保持种子数不变,而稍微改一点点tag,增减一点细节,一般得到的图也会不错。

- 不同型号的显卡即使参数与模型完全一致,也可能会生成完全不同的图。

10XX和16XX系显卡基本每种型号都会是不同的结果,20XX系和30XX系基本都可以完美复现图片。 - 这里不是10XX系显卡不适合AI作画的意思,只是你可能看网友的参数图很棒,你想照搬一下结果却大不一样。

- 某些模型比如anything3.0因为模型过于混沌,图像复现性能一样很差。

- 设置中有个选项参数叫ENSD( eta 噪声种子增量)这个会改变种子,有些扩展也可以实现同seed下随机微调种子,可能会造成无法复现其他人的图。

面部修复

使用模型,对生成图片的人物面部(主要是三次元真人)进行修复,让人脸更像真人的人脸,具体设定在【设置】- 【面部修复】

\1. 基本就是2种模型 CodeFormer 和 GFPGAN ,至于那个更好,这个不好说,这个看模型的,建议都试试。

\2. CodeFormer权重参数;为0时效果最大;为1时效果最小,建议从0.5开始,左右尝试,找到自己喜欢的设置。

\3. 倒不是说二次元图就不能用面部修复了,一定程度上也能提升二次元面部的作画质量。

可平铺(Tiling)

一句话:生成可以往左右上下连续拼接的图像。(见过拼贴的瓷砖不?)

超分辨率 Hires. fix

txt2img 在高分辨率下(1024X1024)会生成非常怪异的图像。而此插件这使得AI先在较低的分辨率下部分渲染你的图片,再通过算法提高图片到高分辨率,然后在高分辨率下再添加细节。

- 放大算法:如果不知道选什么,一般无脑选“ ESRGAN_4x ”

- 重绘幅度:放大后修改细节的程度,从0到1,数值越大,AI创意就越多,也就越偏离原图。

- Upscale by :放大倍数,在原有宽度和长度上放大几倍,注意这个拉高需要更高的显存的。

炼丹

训练代码:https://github.com/bmaltais/kohya_ss

对应环境的安装参考链接:https://zhuanlan.zhihu.com/p/612317907(Stable Diffusion 本地部署 Lora 本地训练)

其他有价值的参考:

https://zhuanlan.zhihu.com/p/619721909(ControlNet 详解篇)

https://blog.youkuaiyun.com/benben044/article/details/131107805

https://www.tjsky.net/tutorial/488#i-4

https://www.tjsky.net/tutorial/457

https://www.tjsky.net/tutorial/583#Stable_Diffusion_v21

https://www.tjsky.net/tutorial/488

https://blog.youkuaiyun.com/suiyingy/article/details/130169592

https://blog.youkuaiyun.com/suiyingy/article/details/130008913

https://www.baidu.com/s?wd=stable%20diffusion%E7%9A%84%20Sampling%20method%E4%BB%8B%E7%BB%8D&rsv_spt=1&rsv_iqid=0xaa1f95240067cea6&issp=1&f=8&rsv_bp=1&rsv_idx=2&ie=utf-8&rqlang=cn&tn=baiduhome_pg&rsv_enter=1&rsv_dl=tb&rsv_t=087bPk0IQ%2FhxafWpV4AsNBFObULTJ2pYF1nOXaBPbfMkeKyxS3W83dgiLG7zP162Q3P2&oq=Sampling%2520method%25E4%25BB%258B%25E7%25BB%258D&rsv_btype=t&inputT=10368&rsv_sug3=37&rsv_sug1=18&rsv_sug7=100&rsv_pq=b931d0fb01b1108c&rsv_sug2=0&rsv_sug4=11843

https://blog.youkuaiyun.com/majjcom/article/details/131277543

591

591

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?