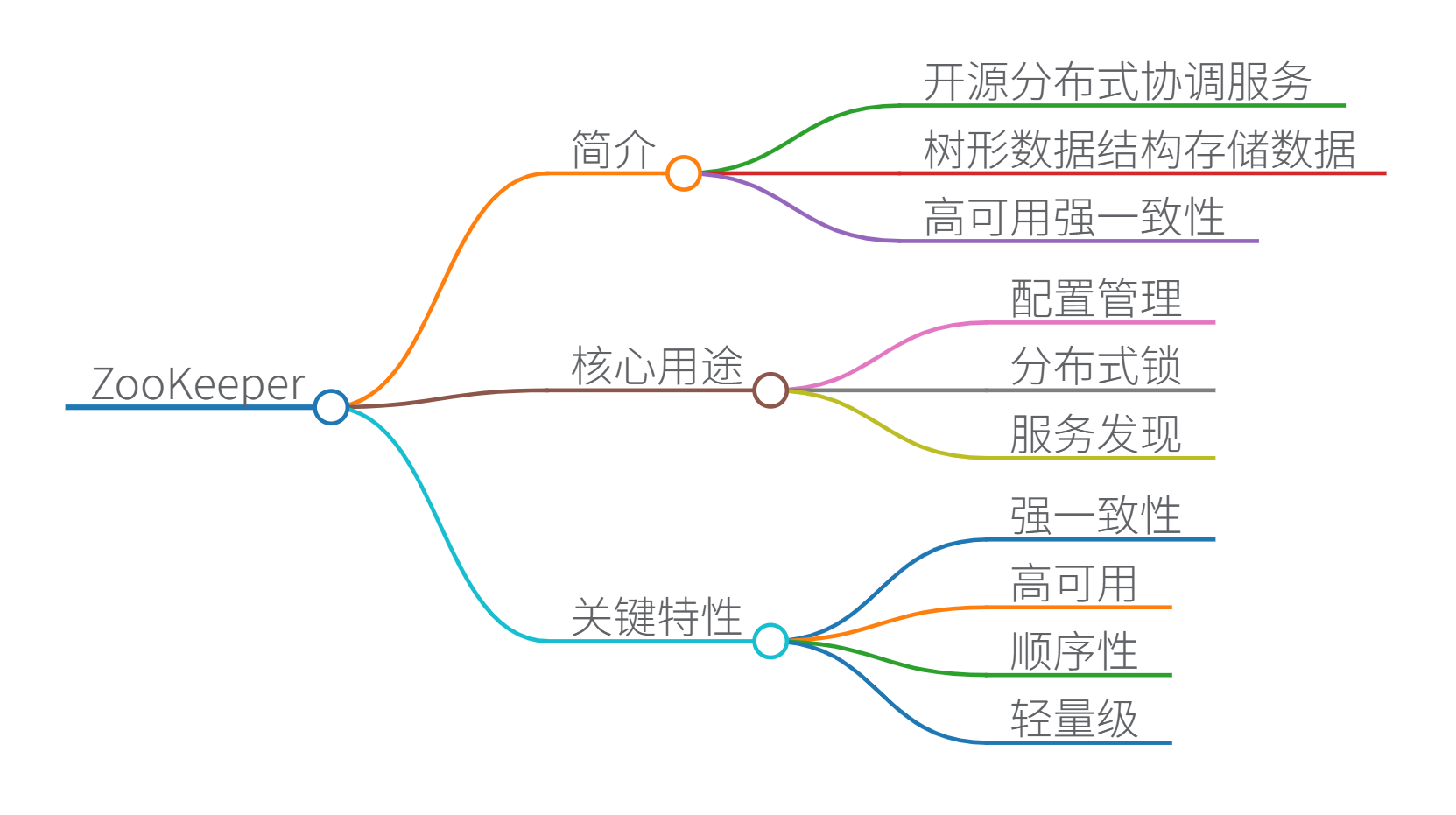

ZooKeeper 简介

ZooKeeper 是一个开源的分布式协调服务,由 Apache 基金会维护。它通过树形数据结构(ZNode 树) 存储数据,提供高可用、强一致性的分布式协调能力,是分布式系统的核心基础设施之一。

在分布式系统中的核心用途

1. 配置管理

- 作用:集中存储动态配置(如数据库地址、服务参数),支持实时更新与通知。

- 机制:客户端监听 ZNode 节点,配置变更时触发回调。

- 示例:

// 监听配置节点 /config/db_url zk.exists("/config/db_url", watcher); // 节点变化时触发 watcher

2. 分布式锁

- 原理:利用临时有序节点实现互斥锁(如

InterProcessMutex)。 - 流程:

- 客户端创建临时节点

/lock/resource_000001。 - 判断是否为最小序号节点,是则获得锁;否则监听前序节点。

- 客户端创建临时节点

- 优点:避免死锁(会话失效自动删节点),支持可重入锁。

- 局限:频繁创建/删除节点时性能低于 Redis(适用于中低并发场景)。

3. 服务发现

- 实现:服务启动时注册临时节点(如

/services/serviceA/192.168.1.1:8080)。 - 客户端:监听节点变化,动态获取可用服务列表。

4. 集群管理

- 节点监控:实时跟踪服务器状态(在线/离线)。

- 选主(Leader Election):

- 所有节点创建临时有序节点

/election/node_000001。 - 最小序号节点成为 Leader,其他节点监听前序节点。

- 所有节点创建临时有序节点

5. 分布式协调

- 屏障(Barrier):等待多个节点完成任务后再继续。

- 队列同步:通过 ZNode 顺序控制任务执行流。

关键特性总结

| 特性 | 说明 |

|---|---|

| 强一致性 | 所有客户端看到相同的数据视图(基于 ZAB 协议)。 |

| 高可用 | 集群多节点部署(通常 2n+12n+12n+1 个节点容忍 nnn 个故障)。 |

| 顺序性 | 所有写操作按全局顺序执行(通过 ZXID 保证)。 |

| 轻量级 | 数据存储在内存中,通过快照(Snapshot)持久化。 |

适用场景:分布式锁、配置中心、注册中心、选主等强一致性协调场景。

慎用场景:高频读写(如秒杀系统)——此时 Redis 更合适。

引用来源:

: Zookeeper 在分布式系统中的作用

: Zookeeper 分布式存储系统实现

: ZooKeeper 分布式锁的适用场景分析

思维导图

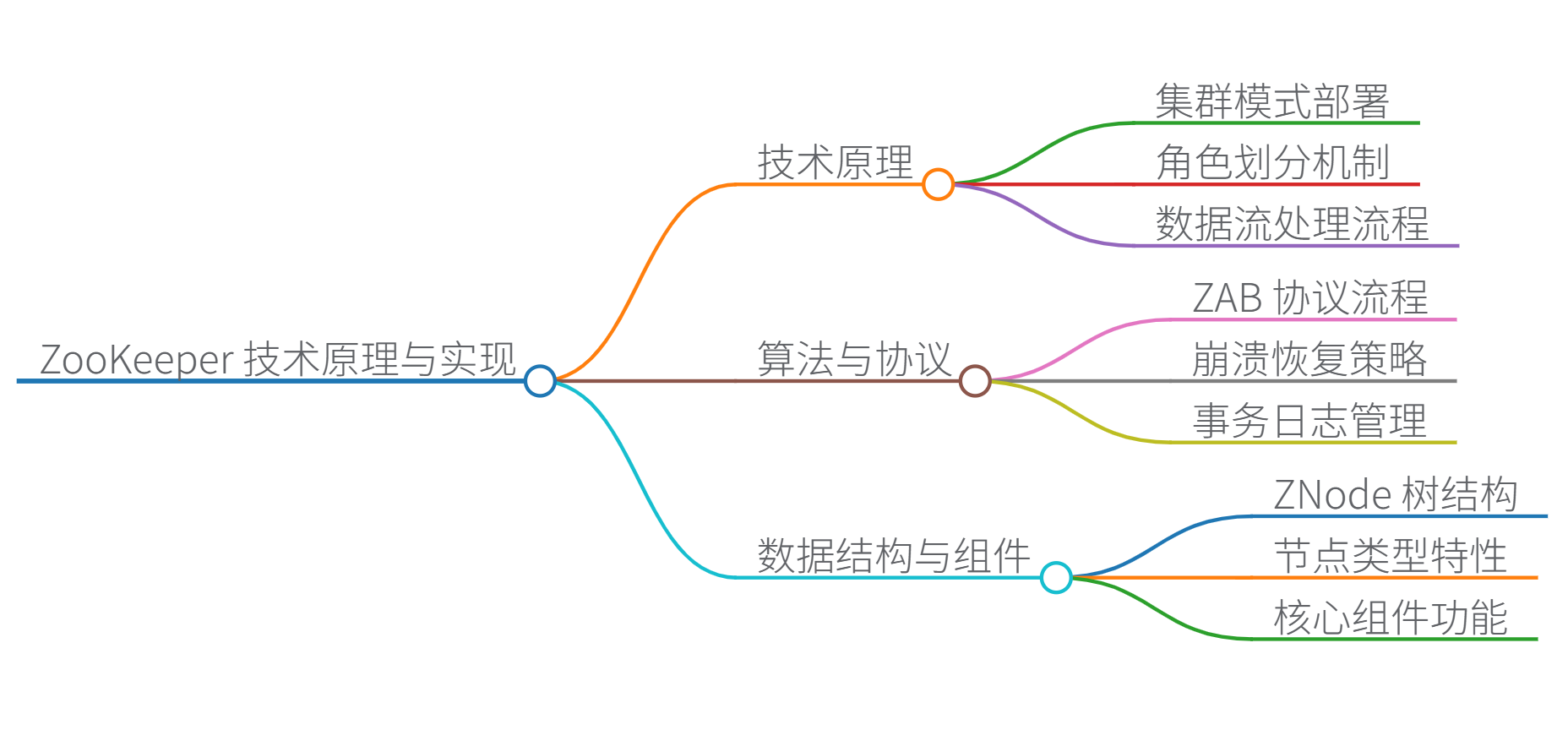

ZooKeeper 技术原理详解

1. 核心架构

- 集群模式:采用奇数节点(2n+12n+12n+1)部署,通过 ZAB 协议(ZooKeeper Atomic Broadcast)实现强一致性。

- 角色划分:

- Leader:处理写请求,发起提案(Proposal)

- Follower:处理读请求,参与投票

- Observer:扩展读能力,不参与投票

- 数据流:

Client→WriteLeader→ProposalFollower/Observer→ACKLeader→CommitAll \text{Client} \xrightarrow{\text{Write}} \text{Leader} \xrightarrow{\text{Proposal}} \text{Follower/Observer} \xrightarrow{\text{ACK}} \text{Leader} \xrightarrow{\text{Commit}} \text{All} ClientWriteLeaderProposalFollower/ObserverACKLeaderCommitAll

2. 核心算法

-

ZAB 协议(消息广播 + 崩溃恢复):

- 消息广播:Leader 生成全局单调递增的 ZXID(64位:高32位为epoch,低32位为计数器),通过两阶段提交保证一致性:

- 崩溃恢复(选主):

- 优先选择 ZXID 最大的节点

- ZXID 相同时选择 myid 最大的节点

- 基于 TCP Fast Leader Election 算法(避免活锁)

-

数据持久化:

- 事务日志:顺序写磁盘(性能关键)

- 内存快照:定期生成 Snapshot 压缩存储

3. 数据结构

-

ZNode 树(类似文件系统):

/ (根节点) ├── /service # 服务注册目录 │ ├── node1 [EPHEMERAL] # 临时节点 │ └── node2 [SEQUENTIAL] # 顺序节点(自动追加序号) └── /config # 配置节点 └── db_url [PERSISTENT] # 持久节点 -

节点类型:

类型 特性 应用场景 持久节点 会话结束仍存在 配置存储 临时节点 会话结束自动删除 服务注册 顺序节点 名称追加全局序号 分布式锁 -

元数据结构:

class ZNode { byte[] data; // 节点数据(≤1MB) Stat stat; // 元数据(版本号、时间戳等) List<String> children; // 子节点列表 }

4. 核心组件功能

| 组件 | 功能 | 实现机制 |

|---|---|---|

| Watch 机制 | 事件监听 | 客户端注册一次性监听器,服务端触发事件后删除 |

| ACL 控制 | 权限管理 | 基于 Scheme(ip/digest/world)的权限验证 |

| Session | 会话管理 | 心跳检测(tickTime),超时释放临时节点 |

| ZKDatabase | 内存数据库 | 维护 ZNode 树 + 事务日志 |

5. 优缺点分析

✅ 优点:

- 强一致性(线性写)

- 高可用(n+1n+1n+1 容错)

- 轻量级协调(内存操作)

- 丰富的原语(锁/队列/屏障)

❌ 局限:

- 数据量限制(全内存存储)

- 写性能瓶颈(需半数以上节点ACK)

- Watch 丢失风险(一次性触发)

- 无内置负载均衡

适用场景:配置中心、分布式锁、选主(强一致性优先)

慎用场景:高频写操作(>10K QPS)、大数据存储(>GB级)

Java 示例代码(带中文注释)

1. 基础操作(节点创建/读取)

import org.apache.zookeeper.*;

public class ZKBasicDemo {

private static final String ZK_ADDRESS = "localhost:2181";

private static final int SESSION_TIMEOUT = 3000;

private ZooKeeper zk;

// 连接 ZooKeeper

public void connect() throws Exception {

zk = new ZooKeeper(ZK_ADDRESS, SESSION_TIMEOUT, watchedEvent -> {

// Watch 回调函数(此处简化处理)

System.out.println("Watch 触发: " + watchedEvent.getType());

});

System.out.println("连接状态: " + zk.getState());

}

// 创建持久节点

public void createNode(String path, byte[] data) throws Exception {

String createdPath = zk.create(

path,

data,

ZooDefs.Ids.OPEN_ACL_UNSAFE, // ACL 权限(完全开放)

CreateMode.PERSISTENT // 节点类型(持久节点)

);

System.out.println("已创建节点: " + createdPath);

}

// 读取节点数据

public byte[] readNode(String path) throws Exception {

return zk.getData(path, false, null); // 不注册 Watch

}

public static void main(String[] args) throws Exception {

ZKBasicDemo demo = new ZKBasicDemo();

demo.connect();

demo.createNode("/test-node", "Hello ZK".getBytes());

System.out.println("节点数据: " + new String(demo.readNode("/test-node")));

}

}

2. 分布式锁实现

import org.apache.curator.framework.CuratorFramework;

import org.apache.curator.framework.recipes.locks.InterProcessMutex;

public class DistributedLock {

private final InterProcessMutex lock;

private final String lockPath = "/locks/resource";

public DistributedLock(CuratorFramework client) {

this.lock = new InterProcessMutex(client, lockPath);

}

public void doWithLock() {

try {

// 获取锁(阻塞等待)

lock.acquire();

System.out.println("获得锁,执行临界区操作");

Thread.sleep(1000); // 模拟业务操作

} catch (Exception e) {

e.printStackTrace();

} finally {

try {

// 释放锁

lock.release();

} catch (Exception e) {

e.printStackTrace();

}

}

}

}

3. 服务注册(临时节点)

public class ServiceRegistry {

private ZooKeeper zk;

public void registerService(String serviceName, String uri) throws Exception {

String servicePath = "/services/" + serviceName;

// 创建临时节点(会话结束自动删除)

zk.create(

servicePath + "/node",

uri.getBytes(),

ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.EPHEMERAL_SEQUENTIAL // 临时顺序节点

);

System.out.println("服务已注册: " + servicePath);

}

// 服务发现(监听节点变化)

public void discoverServices(String serviceName) throws Exception {

String servicePath = "/services/" + serviceName;

// 注册 Watch 监听子节点变化

List<String> services = zk.getChildren(servicePath, event -> {

if (event.getType() == Event.EventType.NodeChildrenChanged) {

updateServiceList(servicePath); // 更新服务列表

}

});

updateServiceList(servicePath);

}

private void updateServiceList(String path) {

// 获取最新服务节点列表

// 通常从节点数据中解析服务地址(如 IP:Port)

}

}

引用来源:

- ZooKeeper 的 ZAB 协议原理分析

- ZooKeeper 内部数据结构设计

- 分布式系统协调服务对比研究

思维导图

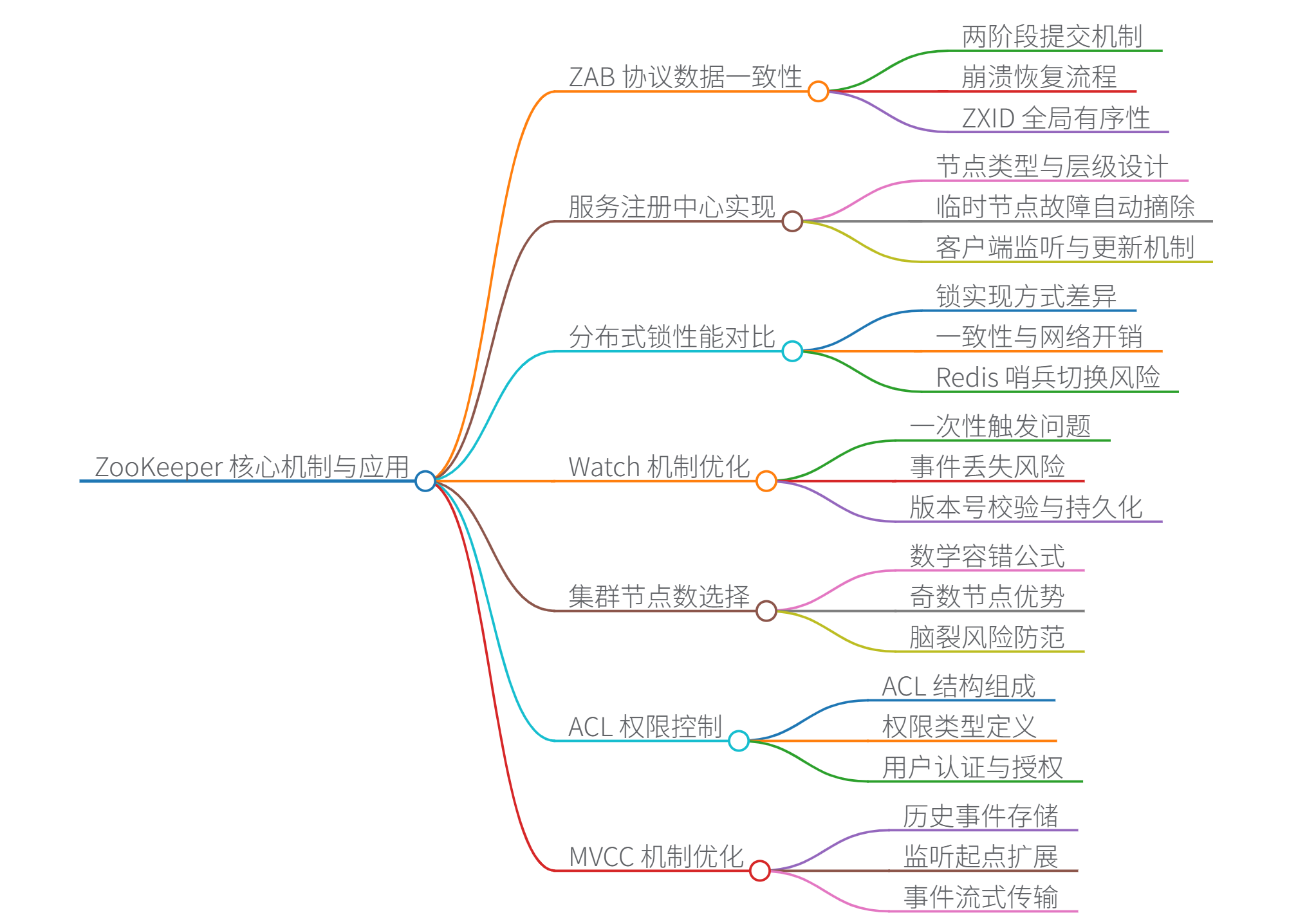

一、ZAB 协议如何保证数据一致性?

ZAB(ZooKeeper Atomic Broadcast)协议通过以下机制保证数据一致性:

- 两阶段提交(2PC):

- Proposal 阶段:Leader 将写请求广播为 Proposal(含 ZXID)

- Commit 阶段:收到 ⌊n2⌋+1\lfloor \frac{n}{2} \rfloor +1⌊2n⌋+1 个 ACK 后广播 Commit

- 崩溃恢复机制:

- 选举 ZXID 最大的节点为新 Leader

- 新 Leader 用 epoch 值(单调递增)标记新周期,拒绝旧 epoch 的请求

- 数据同步:新 Leader 强制 Follower 同步最新数据

- ZXID 全局有序:

- ZXID = ⟨epoch,counter⟩\langle epoch, counter \rangle⟨epoch,counter⟩(高32位epoch,低32位事务计数器)

- 所有事务严格按 ZXID 顺序执行

数学保证:

设集群节点数为 nnn,写操作需满足 n−f>n2n - f > \frac{n}{2}n−f>2n(fff 为故障节点数)

二、服务注册中心实现与节点设计

节点设计

| 节点层级 | 路径示例 | 类型 | 作用 |

|---|---|---|---|

| 服务根节点 | /services | 持久节点(PERSISTENT) | 服务分类容器 |

| 服务类节点 | /services/order | 持久节点(PERSISTENT) | 存储同类型服务实例 |

| 服务实例节点 | /services/order/host1:8080 | 临时节点(EPHEMERAL) | 存储实例IP+端口(自动删除) |

故障自动摘除实现

// 服务注册(临时节点)

zk.create("/services/order/host1:8080",

"192.168.1.1:8080".getBytes(),

ZooDefs.Ids.OPEN_ACL_UNSAFE,

CreateMode.EPHEMERAL); // 会话结束自动删除

// 服务发现(监听节点变化)

List<String> instances = zk.getChildren("/services/order", event -> {

if (event.getType() == Event.EventType.NodeChildrenChanged) {

updateInstances(); // 重新获取实例列表

}

});

原理:临时节点随会话终止自动删除,客户端通过 Watch 实时感知变化

三、ZooKeeper vs Redis 分布式锁性能差异

性能对比根源

| 维度 | ZooKeeper | Redis |

|---|---|---|

| 锁实现 | 临时顺序节点+Watch | SETNX+EXPIRE+Lua脚本 |

| 一致性 | 强一致性(ZAB协议) | 最终一致性(主从异步复制) |

| 网络开销 | 每次操作需集群交互(高延迟) | 单节点内存操作(低延迟) |

| 吞吐量 | 3K-5K QPS(受限于集群协调) | 100K+ QPS(内存操作) |

| 锁释放 | 会话结束自动释放(可靠) | 依赖超时机制(可能误删) |

Redis 哨兵切换失效场景:

- 客户端A在主节点加锁成功

- 主节点宕机,锁未同步到从节点

- 哨兵提升从节点为新主

- 客户端B在新主节点加锁成功 → 锁冲突

解决方案:使用 Redlock 算法(多实例多数派确认)

四、Watch 机制局限性及优化

原生局限性

- 一次性触发:事件触发后 Watch 自动失效

- 丢失风险:

- 客户端与服务器断连时事件丢失

- 事件触发到重新注册的间隙状态变化不可见

- 无历史事件:新监听者无法获取注册前的变更

优化方案

- Curator 持久化 Watcher

// 使用Curator NodeCache持续监听

NodeCache cache = new NodeCache(client, "/config");

cache.getListenable().addListener(() -> {

byte[] data = cache.getCurrentData().getData();

System.out.println("配置更新: " + new String(data));

});

cache.start(true); // 首次启动触发初始化事件

- 版本号校验

Stat stat = zk.exists("/data", false);

int localVer = stat.getVersion(); // 记录当前版本

// 当事件触发时

Stat newStat = zk.exists("/data", true);

if(newStat.getVersion() > localVer) {

// 处理更新

}

- 事件队列中继:通过 Kafka 中转 Watch 事件,确保可靠传递

五、集群节点数为奇数的数学原理

设集群节点数 nnn,故障节点数 fff,需满足:

n−f>n2⇒f<n2 n - f > \frac{n}{2} \quad \Rightarrow \quad f < \frac{n}{2} n−f>2n⇒f<2n

| 节点数 | 最大容错 fff | 最小存活节点 | 存活节点是否过半 |

|---|---|---|---|

| 3 | 1 | 2 | 2>1.52 > 1.52>1.5 ✓ |

| 4 | 1 | 3 | 3>23 > 23>2 ✓ |

| 5 | 2 | 3 | 3>2.53 > 2.53>2.5 ✓ |

关键结论:

- 3节点和4节点容错能力相同(f=1f=1f=1)

- 奇数节点更节省资源(5节点容错能力优于4节点)

- 偶数节点可能脑裂风险(如4节点分裂为2+2时无法形成多数派)

六、ZAB 协议如何解决脑裂问题

脑裂场景:网络分区导致多个 Leader 同时存在

Epoch 机制防御步骤:

- 新 Leader 选举时递增 epoch 值(全局单调递增)

- 所有 Proposal 携带 ⟨epoch,ZXID⟩\langle epoch, ZXID \rangle⟨epoch,ZXID⟩

- Follower 只接受最新 epoch 的 Leader 指令

- 旧 Leader 恢复后,其 epoch 值过期的 Proposal 被拒绝

示例:

- 分区1:Leader epoch=3 提交 Proposal

- 分区2:新 Leader epoch=4 生效

- 网络恢复后,epoch=3 的 Proposal 被丢弃

七、etcd 的 MVCC 机制优化 Watch

与 ZooKeeper 对比:

| 维度 | ZooKeeper Watch | etcd Watch(MVCC 优化) |

|---|---|---|

| 事件存储 | 仅最新状态 | 保存历史事件(可配置保留版本数) |

| 监听起点 | 只能从当前状态开始 | 支持指定 revision 监听历史事件 |

| 事件类型 | 仅通知节点变化 | 提供键值对的完整变更记录(PUT/DEL) |

| 压缩机制 | 无 | 周期性压缩旧版本,减少存储开销 |

MVCC 监听示例:

# 监听从 revision 1000 开始的所有 key 变化

etcdctl watch --prefix / --rev=1000

优势:

- 新客户端可获取注册前的历史变更

- 事件丢失后可通过 revision 重新追赶

- 支持事件流式传输(gRPC 长连接)

八、ZooKeeper ACL 细粒度控制

ACL 结构:scheme:id:permissions

权限设计示例:

// 创建用户认证

zk.addAuthInfo("digest", "admin:password".getBytes());

// 定义ACL规则(用户级权限)

List<ACL> acls = new ArrayList<>();

acls.add(new ACL(ZooDefs.Perms.READ, new Id("auth", "user1:") ); // 用户1只读

acls.add(new ACL(ZooDefs.Perms.ALL, new Id("auth", "admin:") ); // 管理员全权

// 应用ACL创建节点

zk.create("/config",

"data".getBytes(),

acls,

CreateMode.PERSISTENT);

权限类型:

- CREATE:创建子节点

- READ:读取数据

- WRITE:写入数据

- DELETE:删除节点

- ADMIN:设置 ACL

九、ZXID 溢出问题与预防

风险分析

- ZXID 低32位为事务计数器(最大值 232−1=4,294,967,2952^{32}-1=4,294,967,295232−1=4,294,967,295)

- 按 1万 QPS 计算,约 5年 后溢出

- 溢出后旧事务 ZXID > 新事务,导致数据错乱

解决方案

- 定期清理快照

# 清理7天前的快照和日志

zkCleanup.sh -n mycluster -d 7

- 监控预警

// 检查ZXID增长率

long currentZxid = zk.getSessionId();

long daysToOverflow = (4294967295L - currentZxid) / (qps * 86400);

if(daysToOverflow < 365) {

alert("ZXID将在" + daysToOverflow + "天后溢出!");

}

- 升级64位ZXID:使用社区补丁扩展计数器至64位

引用来源:

- ZAB协议原理与容错分析

- 分布式锁在哨兵模式下的失效场景

- etcd MVCC机制设计文档

思维导图

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?