第一性原理方法的核心定义与本质

“第一性原理”(First Principles)源于哲学与物理学,指从最基本的不可再分的原理出发,通过逻辑推演构建整个知识体系,而不依赖经验或类比。其核心思想是:将复杂问题拆解到最底层的基本单元,从源头出发进行推理,而非基于现有经验或表象规律进行归纳。

1小时跟着谷歌大佬使用第一性原理方法理解深度学习!深度学习神经网络原理:卷积神经网络! 物理学、数学、Google DeepMind

例如,在物理学中,牛顿力学的第一性原理是三大运动定律,所有宏观力学现象均可从这些基本定律推导而来;在化学中,第一性原理计算基于量子力学方程,直接从电子和原子核的相互作用出发预测物质性质。

第一性原理在深度学习中的应用逻辑

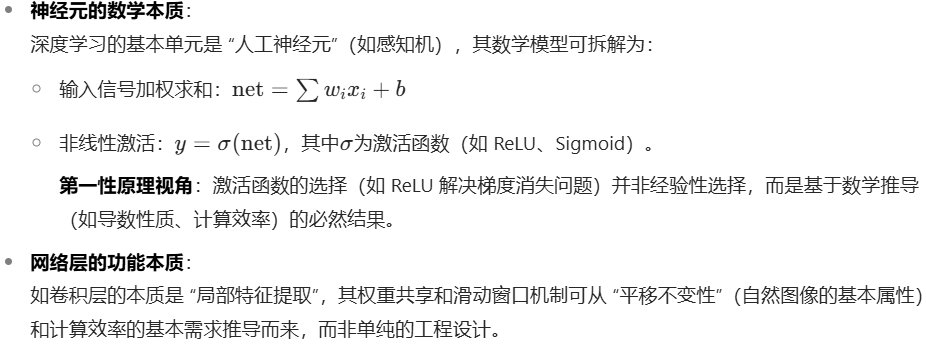

将第一性原理方法应用于理解深度学习,本质是从神经网络的基础构成、数学原理和优化目标出发,推导其工作机制,而非仅停留在 “模型架构记忆” 或 “经验调参” 层面。具体可从以下维度展开:

1. 拆解深度学习的 “基本单元”:从神经元到网络架构

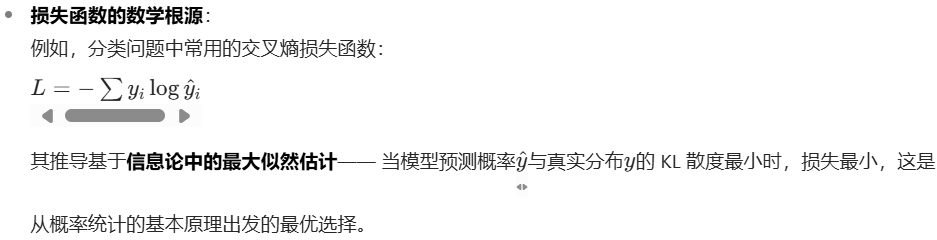

2. 从优化目标出发推导算法:反向传播与损失函数

2. 从优化目标出发推导算法:反向传播与损失函数

-

反向传播的逻辑链条:

反向传播算法的核心是链式法则求导,其推导过程不依赖 “试错” 或 “经验”,而是从 “优化损失函数” 这一根本目标出发,通过微积分基本定理(梯度下降方向为损失函数导数的反方向)严格推导而来。

3. 从数据与任务本质构建模型:超越 “黑箱” 的逻辑推演

-

任务本质的数学建模:

例如,自然语言处理中的序列建模任务,Transformer 架构的自注意力机制(Self-Attention)可从 “捕捉长距离依赖关系” 的需求出发,通过矩阵运算和相似度度量(如点积计算)的基本原理构建,而非凭空设计。 -

归纳偏置的显性化:

第一性原理要求将模型的 “假设”(如 CNN 的局部性、RNN 的时序依赖)转化为可解释的数学约束,而非隐含在架构中。例如,图神经网络(GNN)的消息传递机制,本质是对图结构数据中 “节点依赖关系” 的数学建模。

深度学习学习干货+AI学习路线可以上图扫码获取

资料包:一、 人工智能学习路线及大纲

二、计算机视觉OpenCV【视频+书籍】

三、AI基础+ 深度学习 + 机器学习 +NLP+ 机器视觉 教程

四、李飞飞+吴恩达+李宏毅合集

五、自动驾驶+知识图谱等资料

六、人工智能电子书合集【西瓜书、花书等】

七、各阶段AI论文攻略合集【论文带读/代码指导/本硕博/SCI/EI/中文核心】

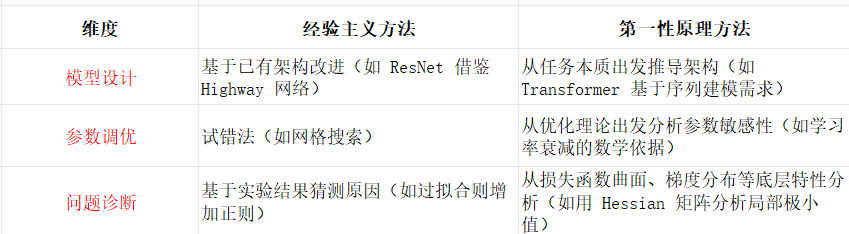

4. 与经验主义的对比:从 “知其然” 到 “知其所以然”

第一性原理视角下的深度学习案例:以线性回归为例

第一性原理方法的价值与挑战

- 价值:

- 帮助理解深度学习的本质逻辑,而非机械记忆模型结构;

- 推动创新:从底层原理出发设计新模型(如神经符号系统结合);

- 提升问题解决能力:面对新任务时可从基本原理构建解决方案。

- 挑战:

- 深度学习的复杂性(如非凸优化、高维空间动力学)导致底层推导困难;

- 理论与实践的鸿沟:部分工程优化(如 Batch Normalization)的严格数学证明尚未完善,仍需经验辅助。

总结:第一性原理如何重塑深度学习理解?

用第一性原理理解深度学习,本质是将其从 “工程经验驱动” 的黑箱转化为 “数学原理驱动” 的白箱 —— 从神经元的数学模型、优化理论的基本定理、任务的本质需求出发,层层推演,最终构建对模型工作机制的系统性认知。这一方法不仅能加深理解,更能为模型创新和问题解决提供底层逻辑支撑。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?