一、神经网络的本质:模拟生物智能的计算模型

神经网络(Neural Network)的灵感源于生物大脑的神经元结构,是一种通过多层节点(神经元)相互连接实现信息处理的计算模型。其核心目标是通过 “学习” 从数据中提取模式,解决分类、回归、生成等复杂问题。

神经网络资料+AI学习路线可以上图扫码获取

资料包:一、 人工智能学习路线及大纲

二、计算机视觉OpenCV【视频+书籍】

三、AI基础+ 深度学习 + 机器学习 +NLP+ 机器视觉 教程

四、李飞飞+吴恩达+李宏毅合集

五、自动驾驶+知识图谱等资料

六、人工智能电子书合集【西瓜书、花书等】

七、各阶段AI论文攻略合集【论文带读/代码指导/本硕博/SCI/EI/中文核心】

- 生物神经元 vs. 人工神经元

生物神经元通过树突接收信号,经细胞体处理后由轴突传出;人工神经元则接收输入信号,通过权重加权求和,再经激活函数处理后输出。

示例:一个识别 “是否为猫” 的神经元,输入可能是 “是否有胡须”“是否有爪子” 等特征,权重决定每个特征的重要性,激活函数(如 Sigmoid)判断输出是否为猫(0 或 1)。

二、神经网络的基本结构:从层到连接

1. 核心组件

- 输入层(Input Layer):接收原始数据,节点数取决于特征数量(如图片像素数)。

- 隐藏层(Hidden Layers):处理数据的中间层,可包含多层,是神经网络 “学习” 的核心。

- 输出层(Output Layer):产生最终结果,节点数取决于任务(如二分类问题输出 1 个节点,多分类输出 n 个节点)。

2. 神经元连接:权重与偏置

- 权重(Weight):表示输入信号的重要程度,通过训练调整。

- 偏置(Bias):类似截距,使模型更灵活,允许神经元在非零输入时激活。

3. 激活函数:赋予网络非线性能力

若没有激活函数,多层神经网络等价于单层线性模型。常见激活函数:

- Sigmoid:将输入映射到 (0,1),常用于二分类输出层。

- ReLU(修正线性单元):x>0 时输出 x,否则输出 0,解决梯度消失问题,是隐藏层的主流选择。

- Softmax:将输入转化为概率分布,用于多分类问题。

三、神经网络的工作原理:从训练到预测

1. 前向传播(Forward Propagation)

输入数据经各层计算后得到输出的过程。

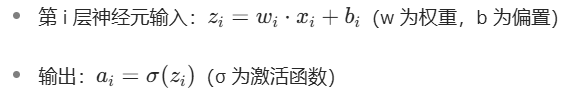

数学表达:

2. 损失函数(Loss Function)

衡量预测值与真实值的差距,用于指导模型优化。

- 均方误差(MSE):适用于回归任务,如预测房价。

- 交叉熵(Cross-Entropy):适用于分类任务,如识别手写数字。

3. 反向传播(Backpropagation)

通过链式法则计算损失函数对各层权重的梯度,从输出层反向更新权重,降低损失。

核心思想:梯度下降(Gradient Descent)—— 沿损失函数下降最快的方向调整参数。

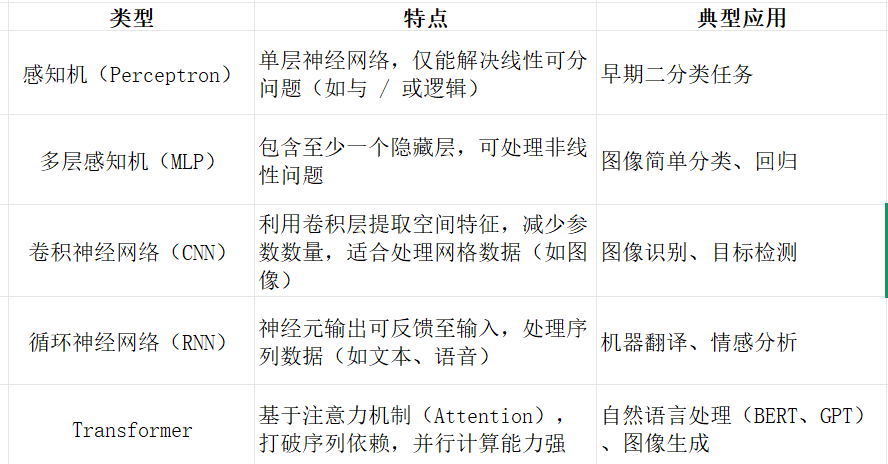

四、神经网络的类型:从简单到复杂

五、入门实践:从工具到项目

1. 常用深度学习框架

- TensorFlow:谷歌开发,生态完善,适合生产环境。

- PyTorch:动态图机制灵活,适合研究和教学(推荐入门)。

- Keras:高层 API,可基于 TensorFlow/CNTK 运行,上手快。

2. 经典入门项目

- MNIST 手写数字识别:用 MLP 或 CNN 识别 0-9 数字,框架自带数据集。

- CIFAR-10 图像分类:识别 10 类常见物体(飞机、汽车等),挑战稍高。

- IMDB 影评情感分析:用 RNN 判断影评是正面还是负面情绪。

3. 学习资源推荐

- 书籍:《深度学习入门:基于 Python 的理论与实现》(适合零基础)、《深度学习》(花书,进阶参考)。

- 课程:吴恩达《机器学习》(Coursera)、Andrew Ng《深度学习专项课程》(Coursera)。

- 实战平台:Kaggle(数据集 + 竞赛)、Colab(免费 GPU 运行代码)。

六、神经网络的挑战与发展

- 挑战:需要大量标注数据、计算资源消耗大、可解释性差(“黑箱” 问题)。

- 前沿方向:无监督学习、神经符号系统(结合逻辑推理)、轻量化网络(如 MobileNet,用于手机端)。

七、快速入门步骤(建议)

- 掌握线性代数基础(矩阵运算、梯度)和概率统计(损失函数原理)。

- 用 PyTorch/TensorFlow 实现一个简单的 MLP,理解前向传播和反向传播代码逻辑。

- 完成 MNIST 项目,调试参数(学习率、隐藏层大小)观察效果变化。

- 学习 CNN/RNN 的核心概念,尝试复现经典模型(如 LeNet、LSTM)。

通过理论与实践结合,逐步深入理解神经网络的本质,后续可根据兴趣(图像、NLP、强化学习)选择细分方向拓展。

14万+

14万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?