引言

本片博客是对ResNet 网络模型的微调,论文链接,讲解链接。原始的ResNet结构在细节之处还有微调优化的空间,在论文《Bag of Tricks for Image Classification with Convolutional Neural Networks》中,作者从高效训练、模型微调、训练技巧三个方面给出了一些实践技巧。本文只讲模型微调部分,感兴趣可以继续阅读论文或阅读讲解链接的文章。

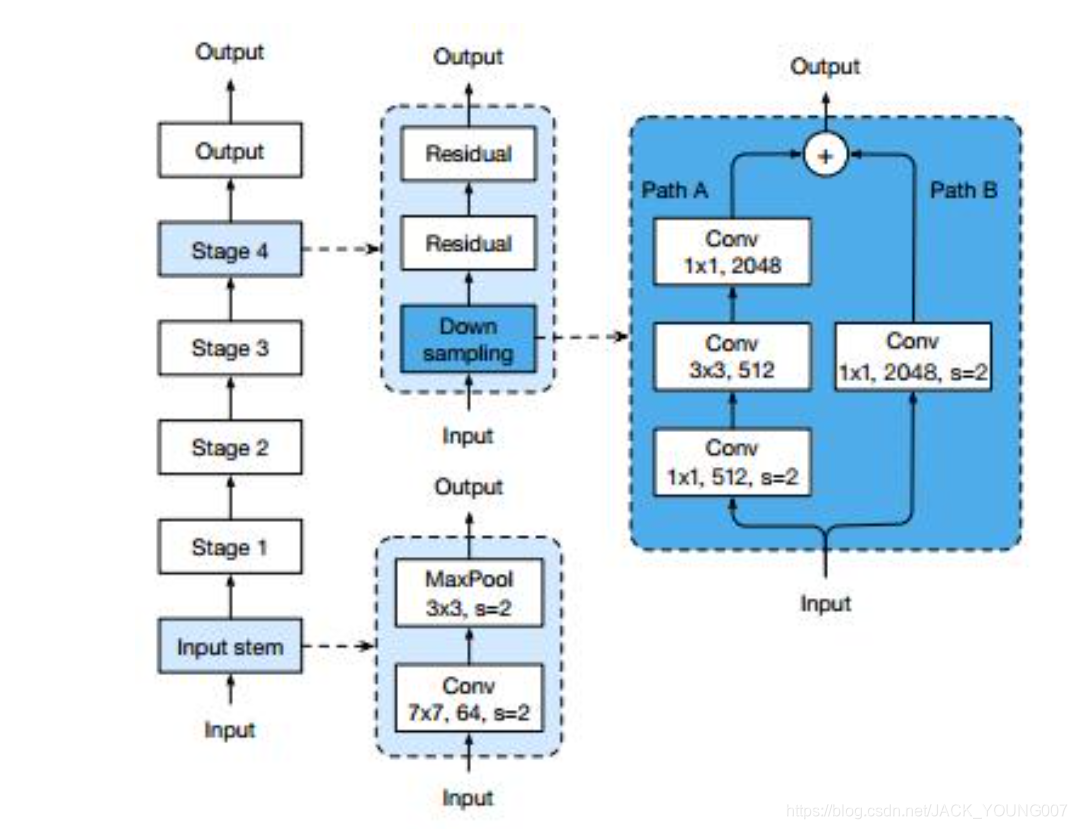

ResNet 网络结构的核心在于运用了 shortcut (原文称为 skip connection) 技术使得深层网络也能够被有效训练,具体细节可以参看上一篇博客 神经网络:ResNet 论文学习总结(一)

改进一:推迟下采样

该改进方法最初是在 Torch 上提出的,目前这一改进已经被广泛地应用。首先观察原始模型的下采样模块:

本文探讨了ResNet网络的模型微调,包括推迟下采样、拆解大核卷积以及用平均池化替代1x1卷积做下采样的改进。这些改进提高了ResNet-50-D的准确率,尽管运算量增加了13%,但实测速度仅下降3%,这得益于1x1卷积的高效计算。

本文探讨了ResNet网络的模型微调,包括推迟下采样、拆解大核卷积以及用平均池化替代1x1卷积做下采样的改进。这些改进提高了ResNet-50-D的准确率,尽管运算量增加了13%,但实测速度仅下降3%,这得益于1x1卷积的高效计算。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1084

1084

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?