论文完整翻译详见:https://blog.youkuaiyun.com/wspba/article/details/57074389

重要参考:

https://blog.youkuaiyun.com/wspba/article/details/56019373

https://blog.youkuaiyun.com/lanran2/article/details/79057994

https://blog.youkuaiyun.com/abcjennifer/article/details/50514124

https://blog.youkuaiyun.com/yj3254/article/details/52244402

ResNet——MSRA何凯明团队的Residual Networks(残差网络),是2015年ImageNet中classification、detection、localization以及COCO数据集上的detection和segmentation的冠军,而且Deep Residual Learning for Image Recognition也获得了CVPR2016的best paper。

1 Introduction

对于新的问题:训练一个更好的网络是否和堆叠更多的层一样简单呢?解决这一问题的障碍便是梯度消失/梯度爆炸,从一开始便阻碍了模型的收敛。归一初始化(normalized initialization)和中间归一化(intermediate normalization)在很大程度上解决了这一问题,它使得数十层的网络在反向传播的随机梯度下降(SGD)上能够收敛。

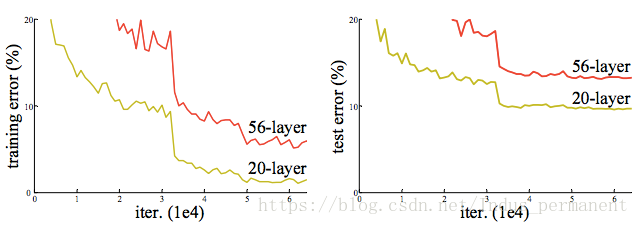

当深层网络能够收敛时,一个退化问题又出现了:随着网络深度的增加,准确率达到饱和然后迅速退化。这种退化并不是由过拟合造成的。ResNet最根本的动机就是所谓的“退化”问题,即当网络深度越深时,它在训练集上训练网络的效率会有所减弱,导致错误率提高。如下图:

但是模型的深度加深,学习能力增强,因此更深的模型不应当产生比它更浅的模型更高的错误率。而这个“退化”问题产生的原因归结于优化难题,当模型变复杂时,SGD的优化变得更加困难,导致了模型达不到好的学习效果。

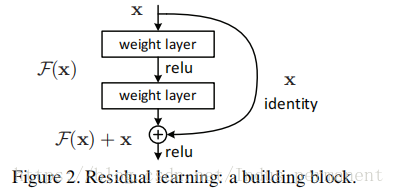

为解决这个退化问题,本文介绍一种deep Residual learning 的框架:

对于更深的模型,通过构建解决方案:恒等映射(identity mapping)(x)来构建增加的层,而其它层直接从浅层模型中复制而来。让这些层来拟合残差映射(residual mapping)(F(x)),而不是让每一个堆叠的层直接来拟合所需的底层映射(desired underlying mapping)。假设所需的底层映射为 (x) ,让堆叠的非线性层来拟合另一个映射: (x):=(x)−x。因此原来的映射转化为:F(x)+x 。我们推断残差映射比原始未参考的映射(unreferenced mapping)更容易优化。

ResNet,由MSRA何凯明团队提出,是2015年ImageNet等多个竞赛的冠军。该文介绍了深度残差学习框架,为了解决深度网络训练中的退化问题,通过构建恒等映射和shortcut连接来优化模型,使得更深的网络能够有效学习,提高了训练速度和准确性。实验表明,ResNet模型的深度增加并不会导致错误率上升,反而能提升性能。

ResNet,由MSRA何凯明团队提出,是2015年ImageNet等多个竞赛的冠军。该文介绍了深度残差学习框架,为了解决深度网络训练中的退化问题,通过构建恒等映射和shortcut连接来优化模型,使得更深的网络能够有效学习,提高了训练速度和准确性。实验表明,ResNet模型的深度增加并不会导致错误率上升,反而能提升性能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1843

1843

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?