文章目录

Kafka消息队列

1、kafka企业级消息系统

1、了解为什么要使用消息系统

在没有使用消息系统以前,我们对于传统许多业务,以及跨服务器传递消息的时候,会采用串行方式或者并行方法;

串行方式:

用户注册实例:将注册信息写入数据库成功后,发送注册邮件,在发送注册短信。

并行方式:

将注册信息写入数据库成功后,发送注册邮件的同时,发送注册短信。以上三个任务完成之后,响应给客户端,与串行的差别是并行的方式可以缩短程序整体处理的时间。

消息系统:

消息系统负责将数据从一个应用程序传送到另一个应用程序,因此应用程序可以专注于数据,但是不必担心 如何共享它。分布式消息系统基于可靠的消息队列的概念。消息在客户端应用程序和消息传递系统之间的异步排队。

有两种类型的消息模式可用-点对点;发布-订阅消息系统

点对点消息系统中,消息被保留在队列中,一个或者多个消费者可以消费队列中的消息,但是特定的消 息只能有最多的一个消费者消费。一旦消费者读取队列中的消息,他就从该队列中消失。该系统的典型应用就是订单处理系统,其中每个订单将有一个订单处理器处理,但多个订单处理器可以同时工作。

大多数的消息系统是基于发布-订阅消息系统

2、了解消息系统的分类

2.1、点对点

主要采用的队列的方式,如A->B 当B消费的队列中的数据,那么队列的数据就会被删除掉【如果B不消费那么就会存在队列中有很多的脏数据】

2.2、发布-订阅

发布与订阅主要三大组件

主题:一个消息的分类

发布者:将消息通过主动推送的方式推送给消息系统;

订阅者:可以采用拉、推的方式从消息系统中获取数据

3、消息系统的应用场景

3.1、应用解耦

将一个大型的任务系统分成若干个小模块,将所有的消息进行统一的管理和存储,因此为了解耦,就会涉及到kafka企业级消息平台

3.2、流量控制

秒杀活动当中,一般会因为流量过大,应用服务器挂掉,为了解决这个问题,一般需要在应用前端加上消息队列以控制访问流量。

1、 可以控制活动的人数 可以缓解短时间内流量大使得服务器崩掉

2、 可以通过队列进行数据缓存,后续再进行消费处理

3.3、日志处理

日志处理指将消息队列用在日志处理中,比如kafka的应用中,解决大量的日志传输问题;

日志采集工具采集 数据写入kafka中;kafka消息队列负责日志数据的接收,存储,转发功能;

日志处理应用程序:订阅并消费 kafka队列中的数据,进行数据分析。

3.4、消息通讯

消息队列一般都内置了高效的通信机制,因此也可以用在纯的消息通讯,比如点对点的消息队列,或者聊天室等。

4、kafka简介

4.1、简介

kafka是最初由linkedin公司开发的,使用scala语言编写,kafka是一个分布式,分区的,多副本的,多订阅者的日志系统(分布式MQ系统),可以用于搜索日志,监控日志,访问日志等。

4.2、支持的语言

kafka目前支持多种客户端的语言:java、python、c++、php等

4.3、apache kafka是一个分布式发布-订阅消息系统

apache kafka是一个分布式发布-订阅消息系统和一个强大的队列,可以处理大量的数据,并使能够将消息从一个端点传递到另一个端点,kafka适合离线和在线消息消费。kafka消息保留在磁盘上,并在集群内复制以防止数据丢失。kafka构建在zookeeper同步服务之上。它与apache和spark非常好的集成,应用于实时流式数据分析。

4.4、其他的消息队列

RabbitMQ

Redis

ZeroMQ

ActiveMQ

4.5、kafka的好处

可靠性:分布式的,分区,复制和容错的。

可扩展性:kafka消息传递系统轻松缩放,无需停机。

耐用性:kafka使用分布式提交日志,这意味着消息会尽可能快速的保存在磁盘上,因此它是持久的。

性能:kafka对于发布和定于消息都具有高吞吐量。即使存储了许多TB的消息,他也爆出稳定的性能。

kafka非常快:保证零停机和零数据丢失。

5、kafka应用场景

5.1、指标分析

kafka 通常用于操作监控数据。这设计聚合来自分布式应用程序的统计信息, 以产生操作的数据集中反馈

5.2、日志聚合解决方法

kafka可用于跨组织从多个服务器收集日志,并使他们以标准的合适提供给多个服务器。

5.3、流式处理

流式处理框架(spark,storm,flink)重主题中读取数据,对齐进行处理,并将处理后的数据写入新的主题,供 用户和应用程序使用,kafka的强耐久性在流处理的上下文中也非常的有用。

6、kafka架构

6.1、kafka的架构图

6.1.1、官方文档架构图:

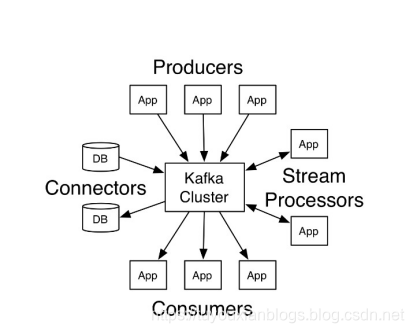

6.1.1.1、kafka四大核心

6.1.1.1.1、生产者API

允许应用程序发布记录流至一个或者多个kafka的主题(topics)。

6.1.1.1.2、消费者API

允许应用程序订阅一个或者多个主题,并处理这些主题接收到的记录流。

6.1.1.1.3、StreamsAPI

允许应用程序充当流处理器(stream processor),从一个或者多个主题获取输入流,并生产一个输出流到一个或 者多个主题,能够有效的变化输入流为输出流。

6.1.1.1.4、ConnectorAPI

允许构建和运行可重用的生产者或者消费者,能够把kafka主题连接到现有的应用程序或数据系统。例如:一个连 接到关系数据库的连接器可能会获取每个表的变化。

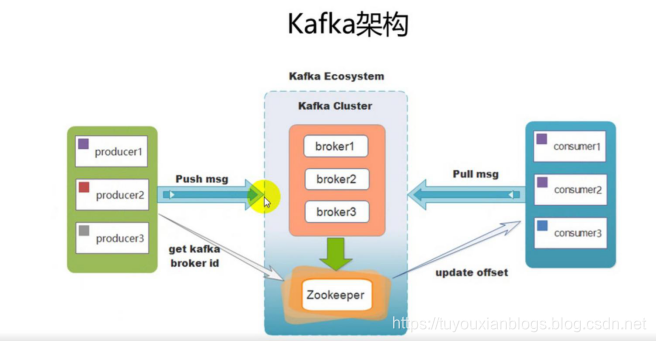

6.1.2、架构关系图:

说明:kafka支持消息持久化,消费端为拉模型来拉取数据,消费状态和订阅关系有消费客户端负责维护,消息消费完 后,不会立即删除,会保留历史消息。因此支持多订阅时,消息只会存储一份就可以了。

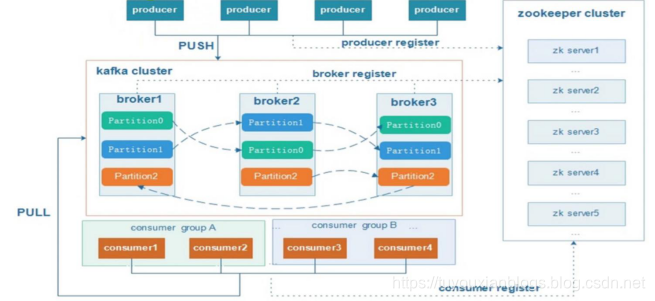

6.1.3、kafka整体架构图

- 各个broker向zk进行注册,产生一个临时文件夹,保持心跳连接客户端;断开连接,临时文件夹就会被删除,broker就不在集群中了。

- 分片:partition

- 一台服务器可能存放不下,如果所有的数据都会存放到一个文件中,数据的删除操作没法做

- 备份:replication-factor

- 容灾

- group:消费者组

- 一个组消费一套完整的消息数量,一个组中有多个消费者,每个消费者消费的消息不重复

6.1.4、kafka架构说明

一个典型的kafka集群中包含若干个Producer,若干个Broker,若干个Consumer,以及一个zookeeper集群; kafka通过zookeeper管理集群配置,选举leader,以及在Consumer Group发生变化时进行Rebalance(负载均 衡);Producer使用push模式将消息发布到Broker;Consumer使用pull模式从Broker中订阅并消费消息。

7、kafka术语

7.1、kafka中术语介绍

Broker:kafka集群中包含一个或者多个服务实例,这种服务实例被称为Broker

Topic:每条发布到kafka集群的消息都有一个类别,这个类别就叫做Topic

Partition:Partition是一个物理上的概念,每个Topic包含一个或者多个Partition

Producer:负责发布消息到kafka的Broker中。

Consumer:消息消费者,向kafka的broker中读取消息的客户端

Consumer Group:每一个Consumer属于一个特定的Consumer Group(可以为每个Consumer指定 groupName)

本文详细介绍了Kafka企业级消息系统,包括消息系统的作用、分类、应用场景,重点讲解了Kafka的特性、支持的语言、与其他消息队列的对比。此外,还深入探讨了Kafka的架构,包括生产者API、消费者API、StreamsAPI和ConnectorAPI。接着,介绍了如何搭建Kafka集群,包括环境准备、安装配置、启动集群的步骤。最后,提到了Kafka监控工具Kafka-eagle的环境要求、安装步骤和主界面操作,以实现Kafka集群的高效运维。

本文详细介绍了Kafka企业级消息系统,包括消息系统的作用、分类、应用场景,重点讲解了Kafka的特性、支持的语言、与其他消息队列的对比。此外,还深入探讨了Kafka的架构,包括生产者API、消费者API、StreamsAPI和ConnectorAPI。接着,介绍了如何搭建Kafka集群,包括环境准备、安装配置、启动集群的步骤。最后,提到了Kafka监控工具Kafka-eagle的环境要求、安装步骤和主界面操作,以实现Kafka集群的高效运维。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1485

1485

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?