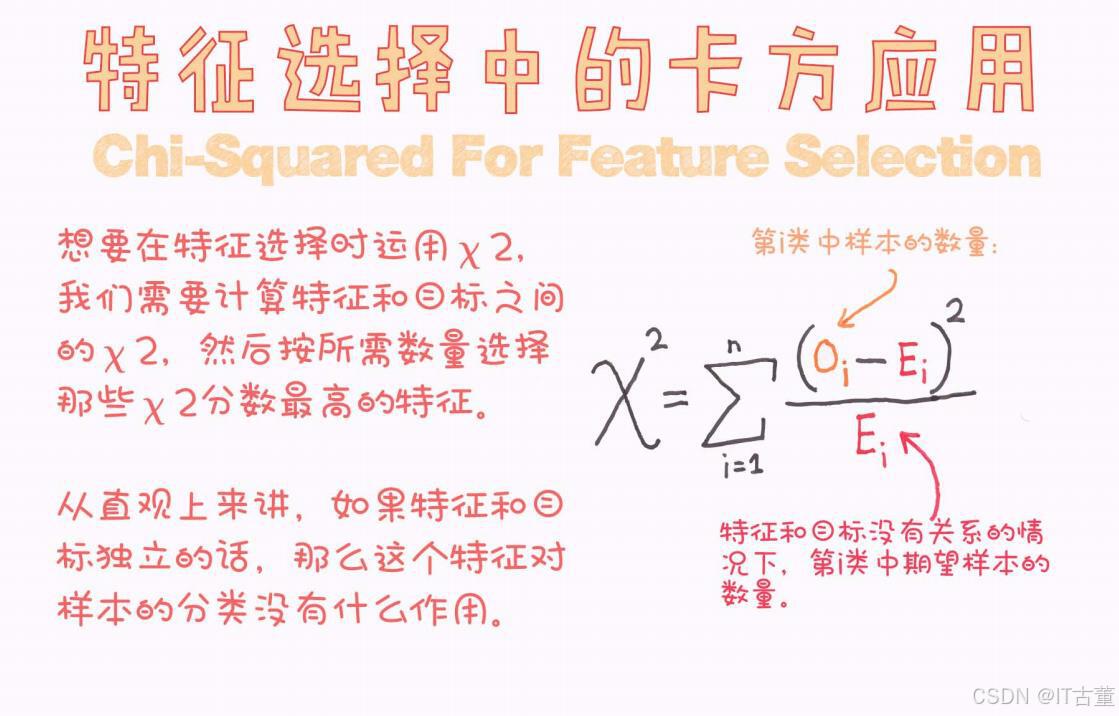

特征选择中的卡方检验(Chi-Squared for Feature Selection)

卡方检验(Chi-Squared Test)是一种用于特征选择的统计方法,特别适合离散型数据。通过评估特征与目标变量之间的依赖性,它可以帮助识别对目标变量最有影响力的特征。

1. 卡方检验的核心思想

卡方检验衡量的是实际观测值和期望值之间的偏差程度,判断两个变量之间是否独立。

- 假设:特征 X 和目标 Y 之间是否独立。

- 统计量:

其中:- O:实际观测值(Observed frequency)。

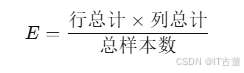

- E:期望值(Expected frequency),计算公式为:

- 结果:

值越大,说明 X 和 Y 的关系越强。

2. 应用场景

卡方检验适用于以下情况:

- 数据是离散型变量,例如分类数据。

- 特征与目标变量之间的关系可以通过频率表表示。

3. 卡方检验在特征选择中的步骤

-

准备数据:

- 数据包含一个目标变量(离散型)和多个特征(离散型)。

- 连续特征需要先离散化处理(例如分箱)。

-

构建列联表(Contingency Table):

- 列联表显示特征的每个类别与目标变量类别的观测频率。

-

计算卡方统计量:

- 根据列联表,计算每个特征的

值。

- 根据列联表,计算每个特征的

-

特征筛选:

- 按

值从大到小排序,选择最重要的特征。

- 按

4. 示例代码

数据准备

假设我们有如下数据集:

import pandas as pd

from sklearn.feature_selection import SelectKBest, chi2

# 示例数据

data = {'Feature1': [1, 0, 1, 0, 1],

'Feature2': [0, 1, 0, 1, 0],

'Feature3': [1, 1, 1, 0, 0],

'Target': [1, 0, 1, 0, 1]}

df = pd.DataFrame(data)

X = df[['Feature1', 'Feature2', 'Feature3']]

y = df['Target']

计算卡方统计量并选择特征

# 使用卡方检验进行特征选择

chi2_scores, p_values = chi2(X, y)

# 打印结果

for feature, chi2_score, p_value in zip(X.columns, chi2_scores, p_values):

print(f"Feature: {feature}, Chi2 Score: {chi2_score}, P-Value: {p_value}")

# 按卡方值选择前2个重要特征

selector = SelectKBest(chi2, k=2)

X_selected = selector.fit_transform(X, y)

print("Selected Features:\n", X.columns[selector.get_support()])

输出结果

Feature: Feature1, Chi2 Score: 2.0000000000000004, P-Value: 0.15729920705028103

Feature: Feature2, Chi2 Score: 3.0, P-Value: 0.08326451666355042

Feature: Feature3, Chi2 Score: 0.05555555555555565, P-Value: 0.8136637157667916

Selected Features:

Index(['Feature1', 'Feature2'], dtype='object')

5. 优点和局限性

优点

- 简单易用:卡方检验的计算逻辑简单,结果易于解释。

- 速度快:适合大规模数据的快速筛选。

- 适用性强:适用于离散型特征,尤其是分类任务。

局限性

- 特征独立性假设:假设特征与目标变量独立,这在某些复杂关系中可能不成立。

- 无法处理连续变量:需要先离散化连续变量,可能导致信息丢失。

- 不适用于回归任务:卡方检验仅适用于离散型目标变量(如分类任务)。

6. 实际应用场景

文本分类

在自然语言处理任务中,卡方检验常用于选择最重要的单词或短语(特征)以提高分类模型的性能。

生物信息学

选择关键基因特征以预测某种疾病是否发生。

市场分析

从大量人口统计数据中选择与购买行为最相关的特征。

7. 总结

卡方检验是一种简单高效的特征选择方法,适合离散型数据的分类任务。通过衡量特征与目标变量的依赖性,能够帮助快速筛选出对模型效果最有影响的特征。结合其他特征选择方法(如互信息、信息增益等),可以进一步提升特征工程的效果。

1353

1353

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?